소개:

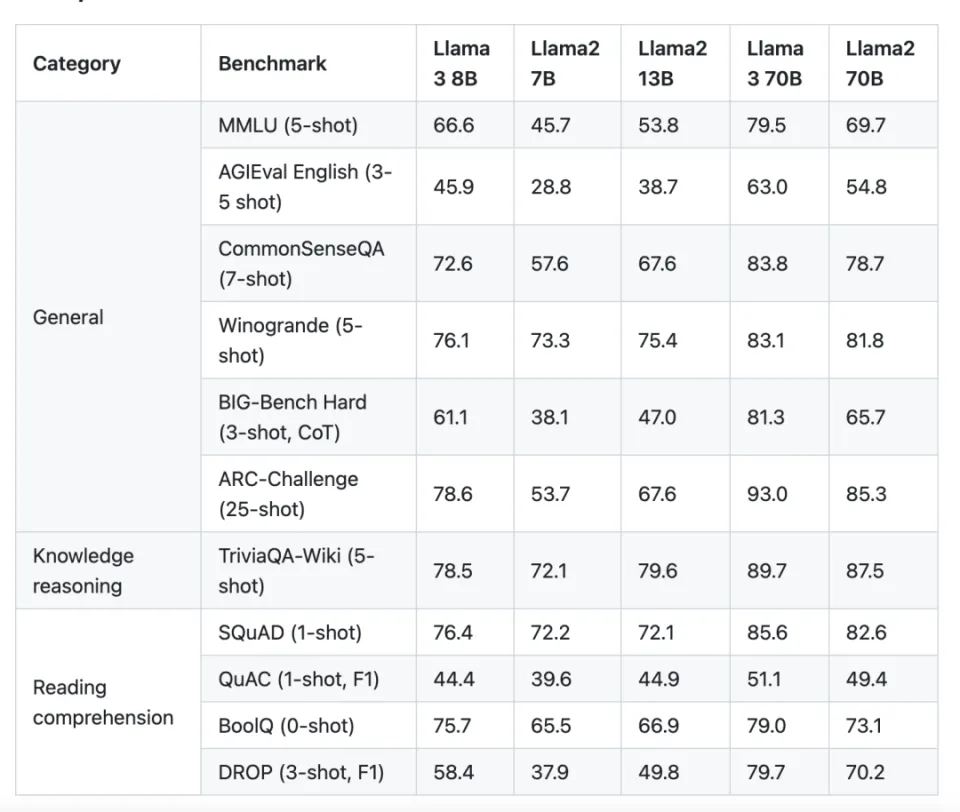

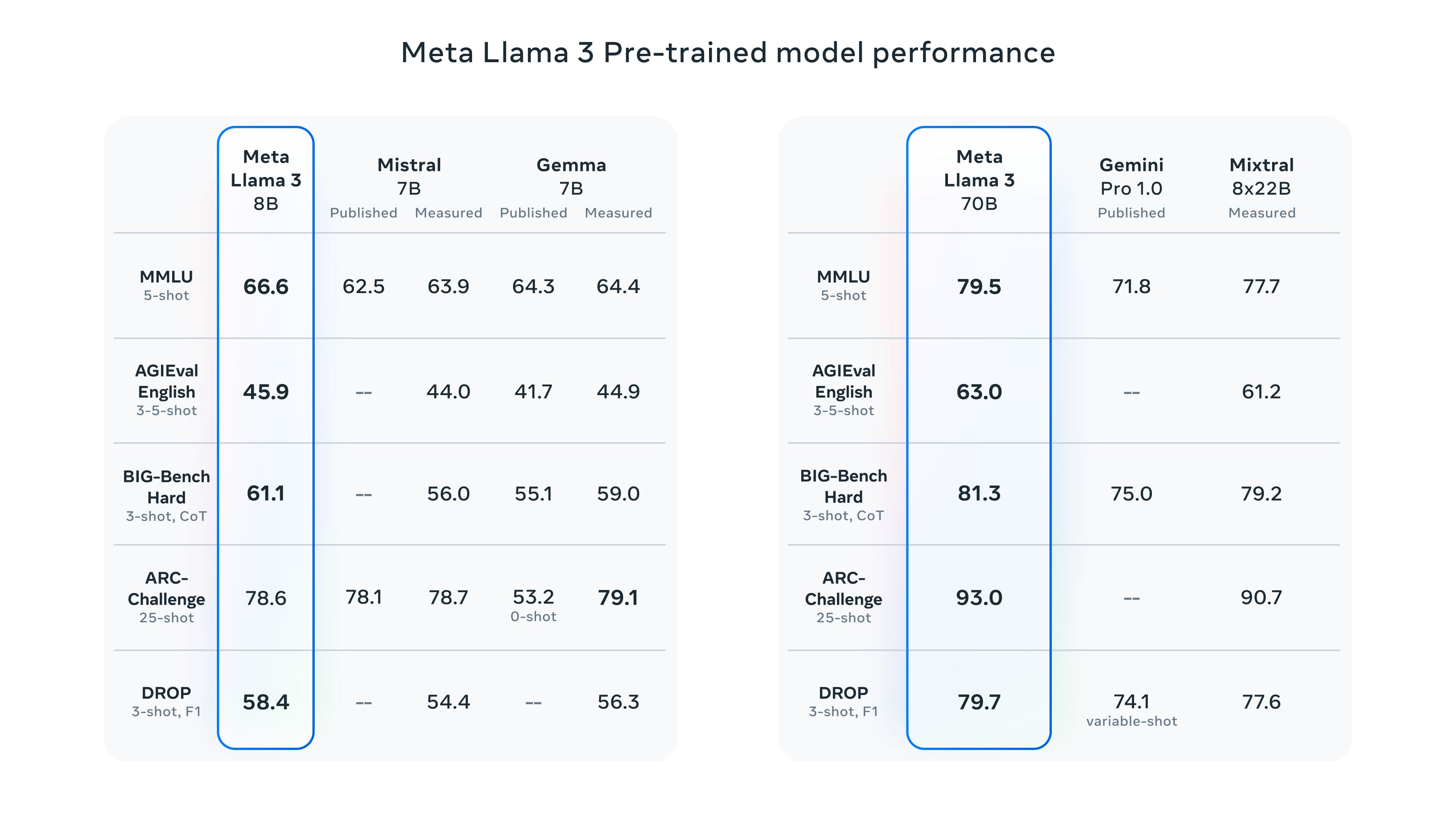

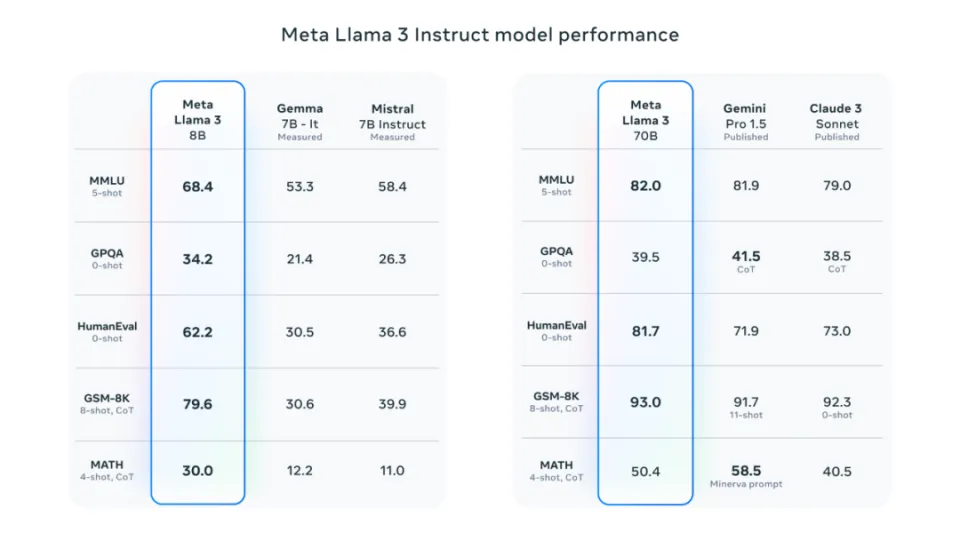

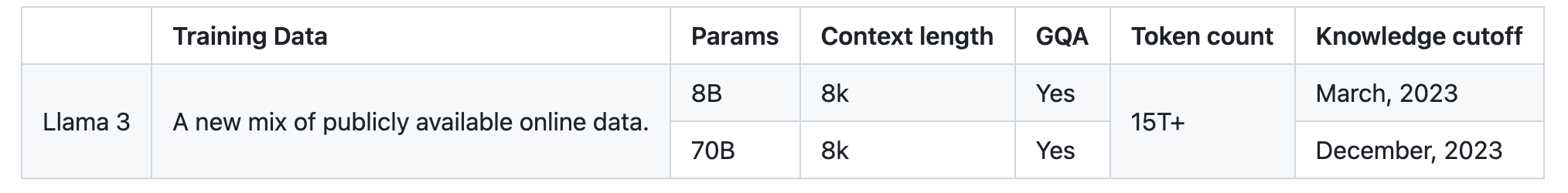

라마(Llama)는 메타(구 페이스북)의 인공지능 연구팀이 개발하고 오픈소스로 공개한 대형 언어 모델(LLM)로, 상업용으로 공개되어 인공지능 전 분야에 지대한 영향을 미쳤습니다. Meta는 이전에 출시된 4096개의 컨텍스트를 지원하는 Llama 2 모델에 이어 8B(80억 매개변수) 모델과 70B(700억 매개변수) 모델을 포함하여 더 나은 성능을 갖춘 Meta Llama 3 시리즈 언어 모델을 추가로 출시했습니다. Llama 3 70B의 성능은 Gemini 1.5 Pro 와 비슷 하며 모든 면에서 Claude Big Cup을 능가하는 반면, 400B+ 모델은 Claude Extra Large Cup 및 신형 GPT-4 Turbo 와 경쟁 할 것으로 예상됩니다.

다양한 테스트 벤치마크에서 Llama 3 시리즈 모델은 실용성 및 안전성 평가 측면에서 시중의 다른 인기 비공개 소스 모델과 비교할 수 있으며 일부 측면에서는 이를 능가하는 우수한 성능을 입증했습니다. Meta Llama 3 시리즈의 출시는 대규모 언어 모델 분야에서 경쟁적 위치를 공고히 할 뿐만 아니라 연구자, 개발자 및 기업에 언어 이해 및 생성 기술의 추가 개발을 촉진할 수 있는 강력한 도구를 제공합니다.

프로젝트 주소:

https://github.com/meta-llama/llama3

라마2와 라마3의 차이점

라마3과 GPT4의 차이점

| 색인 | 전화 3 | GPT-4 |

|---|---|---|

| 모델 크기 | 70B、400B+ | 100B、175B、500B |

| 매개변수 유형 | 변신 로봇 | 변신 로봇 |

| 훈련 목표 | 마스크된 언어 모델링、Perplexity | 마스크된 언어 모델링、Perplexity |

| 훈련 데이터 | 서적、웹텍스트 | 서적、웹텍스트 |

| 성능 | SOTA(질문과 답변, 텍스트 요약, 기계 번역 등) | SOTA(질문과 답변, 텍스트 요약, 기계 번역 등) |

| 오픈 소스 | 예 | 아니요 |

라마 3의 하이라이트

-

모두에게 개방: Meta는 Llama 3의 경량 버전을 오픈 소스로 제공하여 최첨단 AI 기술에 접근할 수 있도록 합니다. AI 기술에 관심이 있는 개발자, 연구자, 친구라면 누구나 자유롭게 탐색하고 만들고 실험할 수 있습니다. Llama 3는 연구원과 개발자를 위해 사용하기 쉬운 API를 제공합니다.

-

대형 모델 규모: Llama 3 400B+ 모델의 매개변수 규모가 4,000억에 도달했는데, 이는 대형 언어 모델입니다.

-

곧 다양한 애플리케이션에 통합될 예정입니다. Llama 3에는 현재 Meta AI가 탑재되어 있으며 Meta AI 경험 주소는 https://www.meta.ai/입니다 .

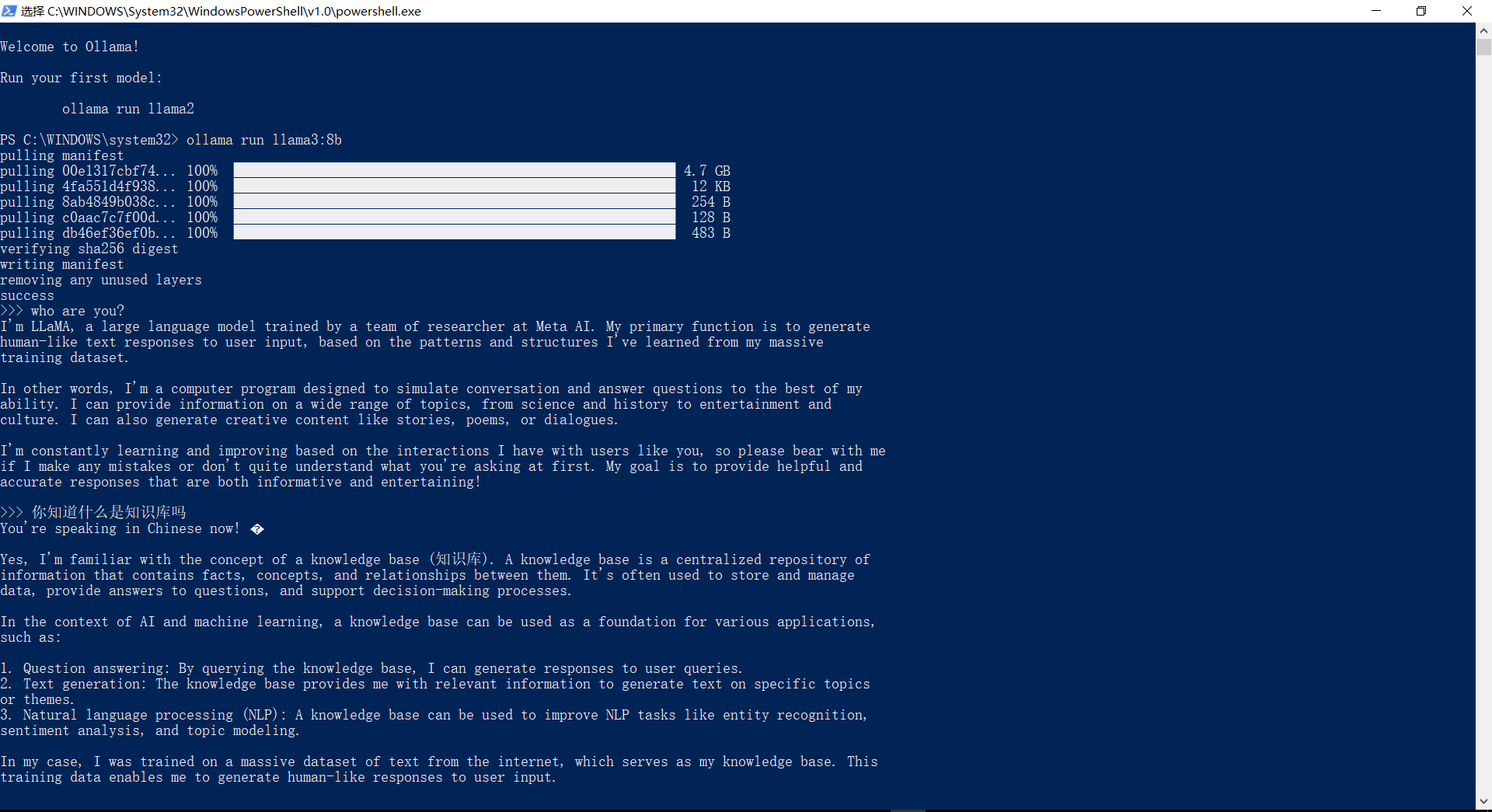

Windows에서 Ollama 사용, Llama3 모델 실행

설치 프로그램을 다운로드하려면 https://ollama.com/download/windows 페이지를 방문하세요 .OllamaSetup.exe

설치 후 컴퓨터 구성에 따라 설치할 해당 모델 매개변수를 선택하십시오(7B를 실행하려면 최소 8GB 메모리가 필요하고 13B를 실행하려면 최소 16GB 메모리가 필요함).

여기서 실행 중인 것은 Llama3:8b입니다. 중국어에는 여전히 문제가 있는 것을 볼 수 있습니다.

| 모델 | 매개변수 | 크기 | 다운로드 |

|---|---|---|---|

| 전화 3 | 8B | 4.7GB | ollama run llama3 |

| 전화 3 | 70B | 40GB | ollama run llama3:70b |

| 미스트랄 | 7B | 4.1GB | ollama run mistral |

| 돌고래 피 | 2.7B | 1.6GB | ollama run dolphin-phi |

| 파이-2 | 2.7B | 1.7GB | ollama run phi |

| 신경 채팅 | 7B | 4.1GB | ollama run neural-chat |

| 찌르레기 | 7B | 4.1GB | ollama run starling-lm |

| 코드 라마 | 7B | 3.8GB | ollama run codellama |

| 라마 2 무수정 | 7B | 3.8GB | ollama run llama2-uncensored |

| 2 13B에 전화 | 13B | 7.3GB | ollama run llama2:13b |

| 2 70B에 전화 | 70B | 39GB | ollama run llama2:70b |

| 오르카 미니 | 3B | 1.9GB | ollama run orca-mini |

| 용암 | 7B | 4.5GB | ollama run llava |

| 아체 | 2B | 1.4GB | ollama run gemma:2b |

| 아체 | 7B | 4.8GB | ollama run gemma:7b |

| 태양광 | 10.7B | 6.1GB | ollama run solar |

Hugging Face 사용

방문: https://huggingface.co/chat/ 및 전환Models

복제 사용

8B 모델: https://replicate.com/meta/meta-llama-3-8b

70B 모델: https://replicate.com/meta/meta-llama-3-70b

Linus는 커널 개발자가 탭을 공백으로 대체하는 것을 막기 위해 문제를 직접 해결했습니다. 그의 아버지는 코드를 작성할 수 있는 몇 안 되는 리더 중 한 명이고, 둘째 아들은 오픈 소스 기술 부서의 책임자이며, 막내 아들은 핵심입니다. Huawei: 일반적으로 사용되는 모바일 애플리케이션 5,000개를 변환하는 데 1년이 걸렸습니다. Hongmeng으로의 포괄적인 마이그레이션 Java는 타사 취약점에 가장 취약한 언어입니다. Hongmeng의 아버지인 Wang Chenglu: 오픈 소스 Hongmeng은 유일한 아키텍처 혁신입니다. 중국 기초 소프트웨어 분야의 마화텅(Ma Huateng)과 저우홍이(Zhou Hongyi)가 악수를 하며 "원한을 풀다" 전 마이크로소프트 개발자: 윈도우 11 성능은 "터무니없을 정도로 나쁘다" 라오샹지가 오픈소스인 것은 코드는 아니지만 그 이유는 다음과 같다. Google이 대규모 구조 조정을 발표 했습니다 .이 글은 Heng Xiaopai 글을 재인쇄한 글 이며, 저작권은 원저자에게 있습니다. 이 기사를 다시 인쇄하려면 원문을 방문하는 것이 좋습니다.