인공지능 기술이 급속히 발전하면서 OpenAI는 이 분야의 선두주자 중 하나로 떠올랐습니다. 기계 번역, 텍스트 분류, 텍스트 생성을 포함한 다양한 언어 처리 작업에서 탁월한 성능을 발휘합니다. OpenAI의 등장으로 Llama, ChatGLM, Qwen 등과 같은 다른 많은 고품질 오픈 소스 대규모 언어 모델이 등장했습니다. 또한 이러한 우수한 오픈 소스 모델은 팀이 우수한 LLM 애플리케이션을 신속하게 구축하는 데 도움이 될 수 있습니다.

하지만 선택의 여지가 너무 많은 상황에서 개발 비용을 줄이면서 OpenAI 인터페이스를 균일하게 사용할 수 있는 방법은 무엇일까요? 개발 복잡성을 추가하지 않고도 LLM 애플리케이션의 실행 성능을 효율적이고 지속적으로 모니터링하는 방법은 무엇입니까? GreptimeAI와 Xinference는 이러한 문제에 대한 실용적인 솔루션을 제공합니다.

GreptimeAI란 무엇인가요?

GreptimeAI는 오픈 소스 시계열 데이터베이스인 GreptimeDB를 기반으로 구축되었으며, 현재 LangChain 및 OpenAI 생태계를 지원하는 LLM(대형 언어 모델) 애플리케이션을 위한 관찰 솔루션 세트입니다. GreptimeAI를 사용하면 비용, 성능, 트래픽 및 보안에 대한 포괄적인 이해를 실시간으로 얻을 수 있어 팀이 LLM 애플리케이션의 안정성을 향상하는 데 도움이 됩니다.

Xinference 란 무엇입니까?

Xinference 는 LLM(대형 언어 모델), 음성 인식 모델 및 다중 모드 모델을 위해 설계된 오픈 소스 모델 추론 플랫폼이며 민영화된 배포를 지원합니다. Xinference는 OpenAI API와 호환되는 RESTful API를 제공하고 LangChain, LlamaIndex 및 Dify.AI 와 같은 타사 개발자 도구를 통합하여 모델 통합 및 개발을 용이하게 합니다. Xinference는 여러 LLM 추론 엔진(예: Transformers, vLLM 및 GGML)을 통합하고 다양한 하드웨어 환경에 적합하며 분산된 다중 시스템 배포를 지원하여 다중 장치 또는 시스템 간에 모델 추론 작업을 효율적으로 할당하여 다중 요구 사항을 충족할 수 있습니다. 모델 및 고속 컴퓨팅이 가능합니다.

GreptimeAI + Xinference LLM 애플리케이션 배포/모니터링

다음으로 Qwen-14B 모델을 예로 들어 Xinference를 사용하여 모델을 로컬로 배포하고 실행하는 방법을 자세히 소개하겠습니다. 여기에는 OpenAI 함수 호출(Function Calling)과 유사한 방법을 사용하여 날씨 쿼리를 수행하고 GreptimeAI를 사용하여 LLM 애플리케이션의 사용을 모니터링하는 방법을 보여주는 예가 나와 있습니다.

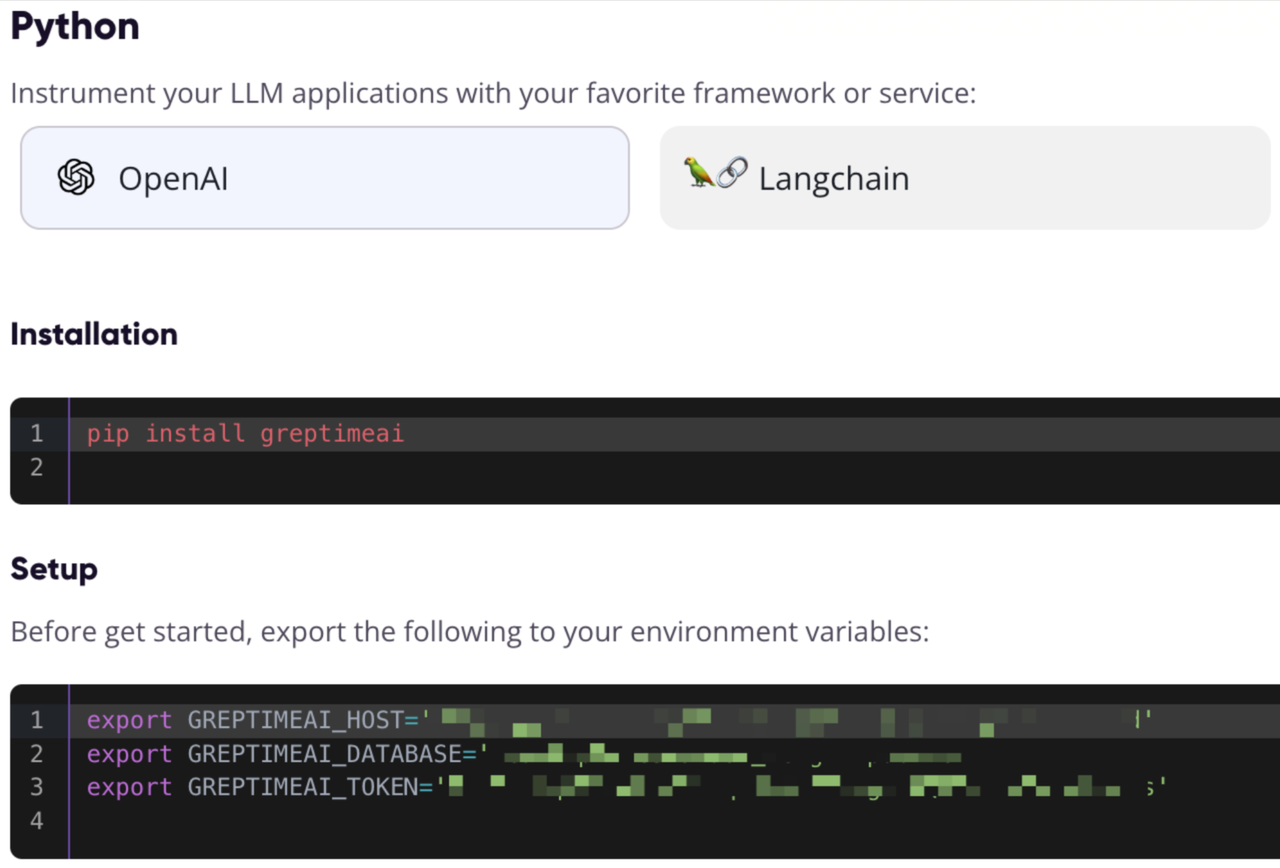

GreptimeAI 구성 정보 등록 및 가져오기

https://console.greptime.cloud를 방문 하여 서비스를 등록하고 AI 서비스를 생성합니다. AI 대시보드로 이동한 후 설정 페이지를 클릭하여 OpenAI 구성 정보를 얻습니다.

Xinference 모델 서비스 시작

Xinference 모델 서비스를 로컬에서 시작하는 것은 매우 간단합니다. 다음 명령만 입력하면 됩니다.

xinference-local -H 0.0.0.0

Xinference는 기본적으로 서비스를 로컬로 시작하며 기본 포트는 9997입니다. 여기서는 Xinference를 로컬로 설치하는 과정을 생략합니다. 설치하려면 이 문서 를 참조하세요 .

웹 UI를 통해 모델 시작

Xinference가 시작된 후 브라우저에 http://localhost:9997을 입력하여 웹 UI에 액세스합니다.

명령줄에서 모델 시작

Xinference의 명령줄 도구를 사용하여 모델을 시작할 수도 있습니다. 기본 모델 UID는 qwen-chat입니다(모델은 나중에 이 ID를 통해 액세스됩니다).

xinference launch -n qwen-chat -s 14 -f pytorch

OpenAI 스타일 인터페이스를 통해 날씨 정보 얻기

매개변수 및 를 get_current_weather사용하여 함수를 호출하여 특정 도시에 대한 날씨 정보를 얻을 수 있다고 가정해 보겠습니다 .locationformat

OpenAI 및 통화 인터페이스 구성

OpenAI의 Python SDK를 통해 Xinference 로컬 포트에 액세스하고, GreptimeAI를 사용하여 데이터를 수집하고, chat.completions인터페이스를 사용하여 대화를 만들고, tools방금 정의한 함수 목록을 지정하는 데 사용합니다.

from greptimeai import openai_patcher

from openai improt OpenAI

client = OpenAI(

base_url="http://127.0.0.1:9997/v1",

)

openai_patcher.setup(client=client)

messages = [

{"role": "system", "content": "你是一个有用的助手。不要对要函数调用的值做出假设。"},

{"role": "user", "content": "上海现在的天气怎么样?"}

]

chat_completion = client.chat.completions.create(

model="qwen-chat",

messages=messages,

tools=tools,

temperature=0.7

)

print('func_name', chat_completion.choices[0].message.tool_calls[0].function.name)

print('func_args', chat_completion.choices[0].message.tool_calls[0].function.arguments)

도구 세부정보

함수 호출 함수(도구) 목록은 필수 필드가 지정된 아래에 정의되어 있습니다.

tools = [

{

"type": "function",

"function": {

"name": "get_current_weather",

"description": "获取当前天气",

"parameters": {

"type": "object",

"properties": {

"location": {

"type": "string",

"description": "城市,例如北京",

},

"format": {

"type": "string",

"enum": ["celsius", "fahrenheit"],

"description": "使用的温度单位。从所在的城市进行推断。",

},

},

"required": ["location", "format"],

},

},

}

]

출력은 다음과 같습니다. chat_completionQwen 모델에서 생성된 함수 호출을 다음을 통해 얻었음을 확인할 수 있습니다.

func_name: get_current_weather

func_args: {"location": "上海", "format": "celsius"}

함수 호출 결과를 얻고 인터페이스를 다시 호출하십시오.

get_current_weather여기서는 주어진 매개변수를 사용하여 함수를 호출 하고 결과를 얻었으며 결과와 컨텍스트를 Qwen 모델에 다시 보낸다고 가정합니다 .

messages.append(chat_completion.choices[0].message.model_dump())

messages.append({

"role": "tool",

"tool_call_id": messages[-1]["tool_calls"][0]["id"],

"name": messages[-1]["tool_calls"][0]["function"]["name"],

"content": str({"temperature": "10", "temperature_unit": "celsius"})

})

chat_completion = client.chat.completions.create(

model="qwen-chat",

messages=messages,

tools=tools,

temperature=0.7

)

print(chat_completion.choices[0].message.content)

최종 결과

Qwen 모델은 결국 다음과 같은 응답을 출력합니다.

上海现在的温度是 10 摄氏度。

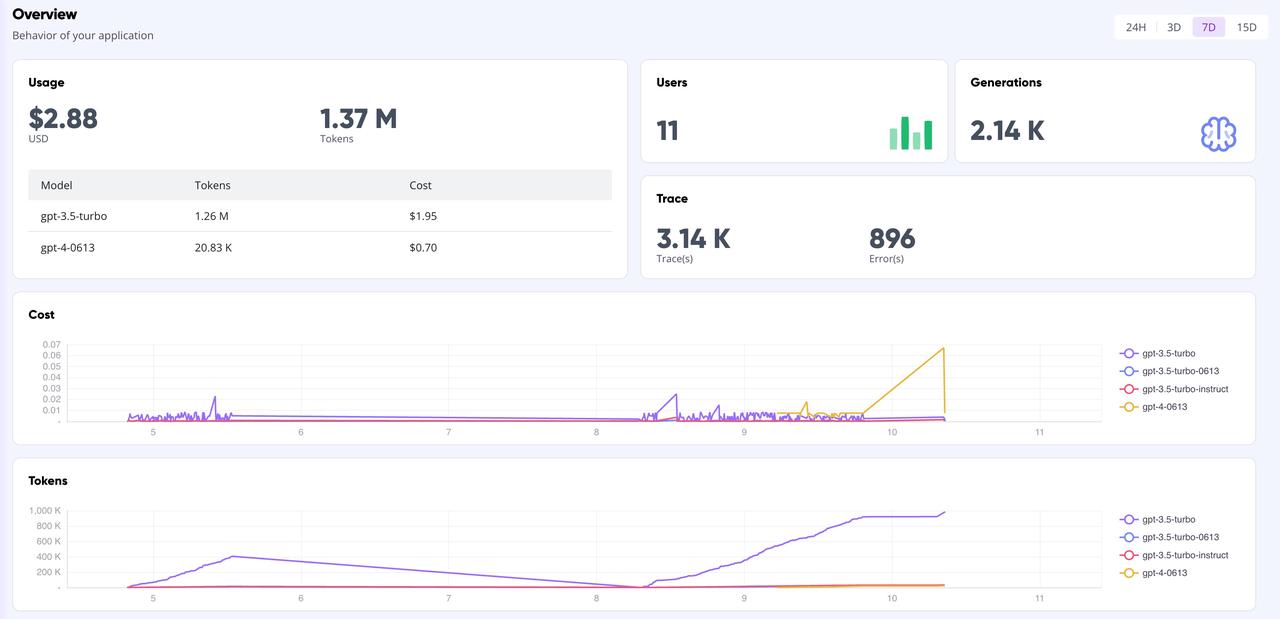

GreptimeAI 간판

GreptimeAI 대시보드 페이지에서는 토큰, 비용, 지연 시간, 추적 등의 주요 지표를 포함하여 OpenAI 인터페이스를 기반으로 모든 통화 데이터를 종합적으로 실시간 모니터링할 수 있습니다. 아래는 대시보드의 개요 페이지입니다.

요약하다

오픈 소스 모델을 사용하여 LLM 애플리케이션을 구축하고 OpenAI 스타일을 사용하여 API 호출을 수행하려는 경우 Xinference를 사용하여 추론 모델을 관리하고 GreptimeAI를 사용하여 모델 작업을 모니터링하는 것이 좋은 선택입니다. 복잡한 데이터 분석을 수행하든 간단한 일일 쿼리를 수행하든 Xinference는 강력하고 유연한 모델 관리 기능을 제공할 수 있습니다. 동시에 GreptimeAI의 모니터링 기능과 결합하면 모델의 성능과 리소스 소비를 보다 효율적으로 이해하고 최적화할 수 있습니다.

GreptimeAI 및 Xinference를 사용한 귀하의 시도와 경험 및 통찰력 공유를 환영합니다. 인공지능의 무한한 가능성을 함께 탐험해 보세요!

Greptime에 대한 지식이 거의 없습니다.

Greptime Greptime Technology는 2022년에 설립되었으며 현재 시계열 데이터베이스 GreptimeDB, GreptimeCloud 및 관찰 도구 GreptimeAI의 세 가지 제품을 개선 및 구축하고 있습니다.

GreptimeDB는 Rust 언어로 작성된 시계열 데이터베이스로, 분산형, 오픈 소스, 클라우드 기반으로, 기업이 실시간으로 시계열 데이터를 읽고, 쓰고, 처리하고 분석하는 데 도움이 되며, GreptimeCloud는 이를 통해 장기적인 스토리지 비용을 절감할 수 있습니다. 관찰 가능성, 사물 인터넷 및 기타 분야와 고도로 통합될 수 있는 완전 관리형 DBaaS 서비스를 사용자에게 제공합니다. GreptimeAI는 LLM에 맞게 맞춤 제작되어 비용, 성능 및 생성 프로세스에 대한 전체 링크 모니터링을 제공합니다.

GreptimeCloud 및 GreptimeAI는 공식적으로 테스트되었습니다. 최신 개발 소식을 보려면 공식 계정이나 공식 웹사이트를 팔로우하세요!

공식 홈페이지: https://greptime.cn/

GitHub: https://github.com/GreptimeTeam/greptimedb

트위터: https://twitter.com/Greptime

슬랙: https://greptime.com/slack

링크드인: https://www.linkedin.com/company/greptime/

1990년대에 태어난 프로그래머가 비디오 포팅 소프트웨어를 개발하여 1년도 안 되어 700만 개 이상의 수익을 올렸습니다. 결말은 매우 처참했습니다! 고등학생들이 성인식으로 자신만의 오픈소스 프로그래밍 언어 만든다 - 네티즌 날카로운 지적: 만연한 사기로 러스트데스크 의존, 가사 서비스 타오바오(taobao.com)가 가사 서비스를 중단하고 웹 버전 최적화 작업 재개 자바 17은 가장 일반적으로 사용되는 Java LTS 버전입니다. Windows 10 시장 점유율 70%에 도달, Windows 11은 계속해서 Open Source Daily를 지원합니다. Google은 Docker가 지원하는 오픈 소스 Rabbit R1을 지원합니다. Electric, 개방형 플랫폼 종료 Apple, M4 칩 출시 Google, Android 범용 커널(ACK) 삭제 RISC-V 아키텍처 지원 Yunfeng은 Alibaba에서 사임하고 향후 Windows 플랫폼용 독립 게임을 제작할 계획