1. Exibição do efeito

Reconhecimento facial:

Efeito de presença:

2. Introdução do projeto

A seguir, aprenderemos como realizar o reconhecimento facial com alta precisão, começando com uma breve introdução à teoria e aprendendo a implementação básica. Em seguida, criaremos um projeto de atendimento que usará webcam para detectar rostos e registrar atendimento em tempo real em uma planilha de excel.

3. Teoria básica do projeto

(1) Construção do pacote do projeto

Antes disso, você deve ter lido este artigo e concluído a construção do pacote do projeto (37 mensagens) A maneira mais fácil do Python 3.7 resolver o problema de baixar dlib e face_recognition

Além disso, também precisamos instalar um pacote, basta seguir os passos:

pip install face_recognition_models(2) Construção do arquivo

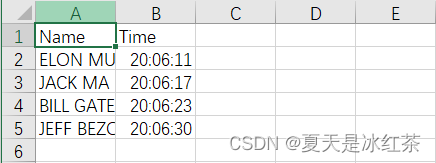

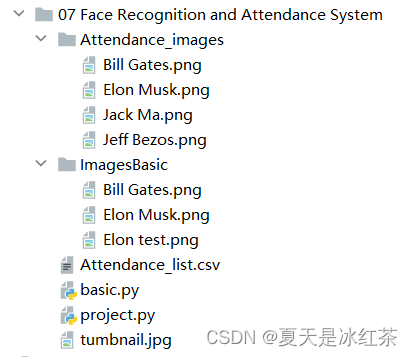

De acordo com a configuração mostrada na figura, o conteúdo do arquivo Attendance.csv é apenas (Name, Time). No arquivo Attendance_images, você pode adicionar imagens que deseja adicionar, preferencialmente imagens de caracteres individuais, e nomear as imagens com seus nomes ingleses.

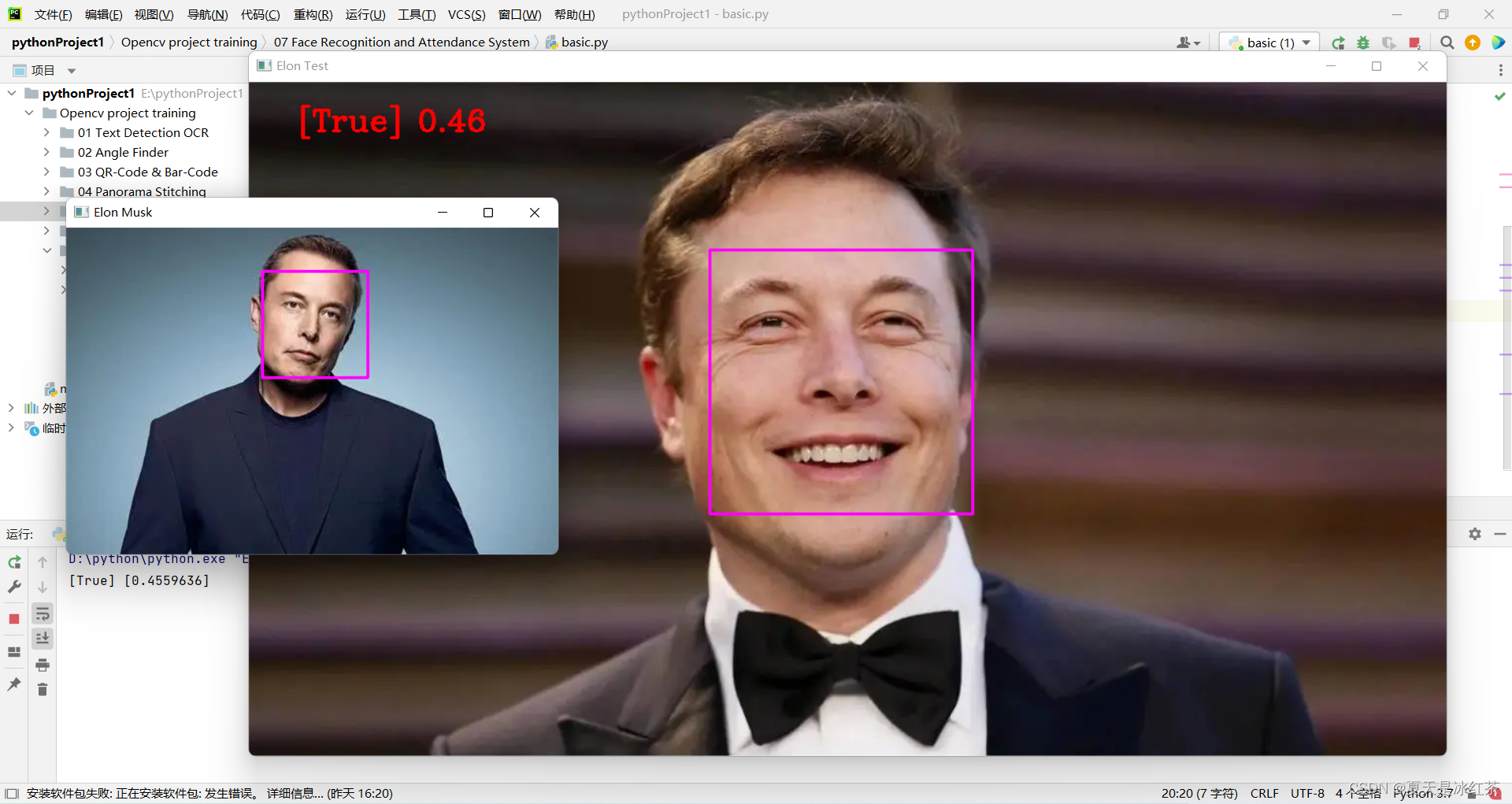

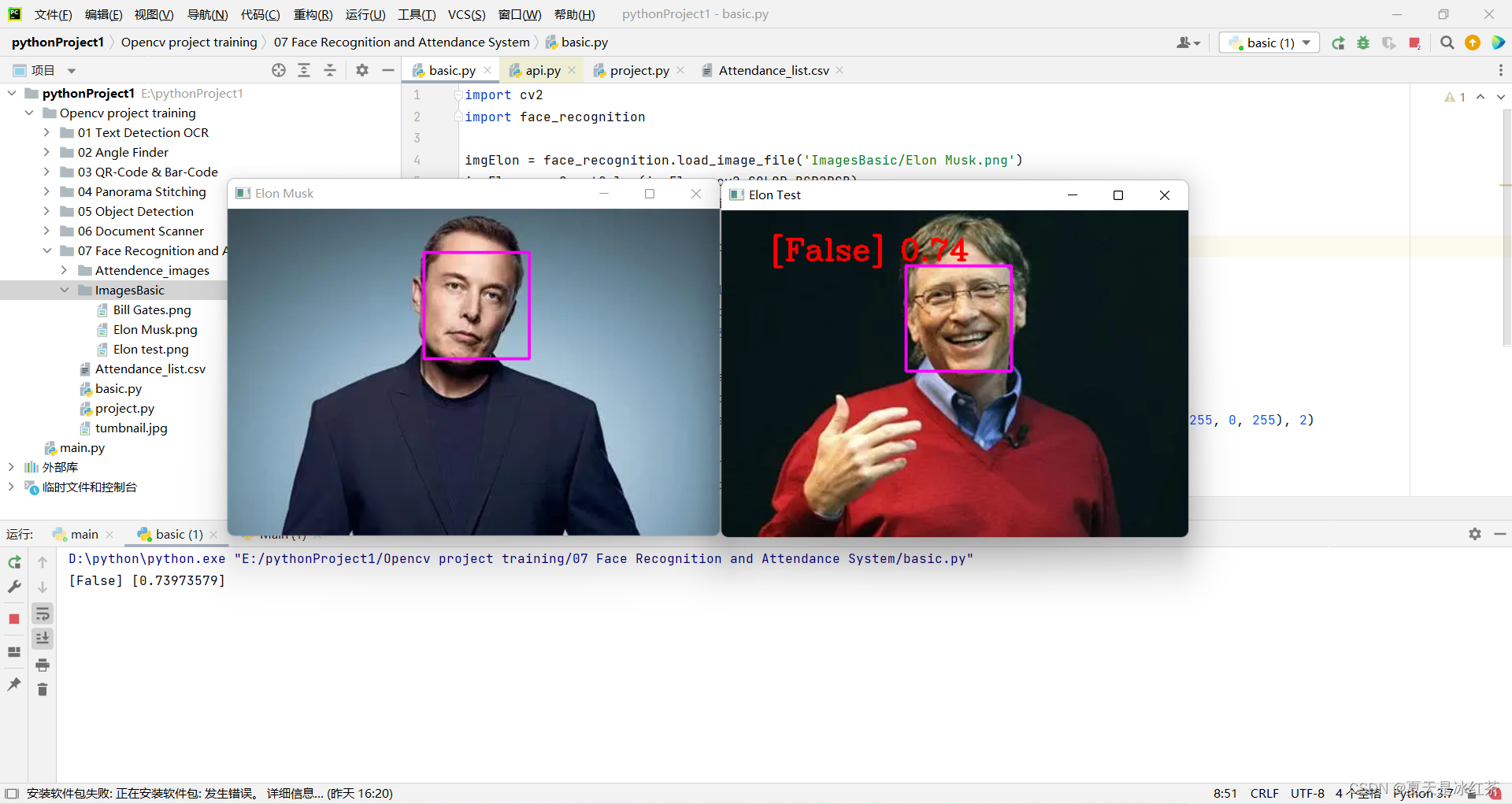

(3) exibição e explicação do código basic.py

import cv2

import face_recognition

imgElon = face_recognition.load_image_file('ImagesBasic/Elon Musk.png')

imgElon = cv2.cvtColor(imgElon, cv2.COLOR_BGR2RGB)

imgTest = face_recognition.load_image_file('ImagesBasic/Elon test.png')

imgTest = cv2.cvtColor(imgTest, cv2.COLOR_BGR2RGB)

faceLoc = face_recognition.face_locations(imgElon)[0]

encodeElon = face_recognition.face_encodings(imgElon)[0]

cv2.rectangle(imgElon, (faceLoc[3], faceLoc[0]), (faceLoc[1], faceLoc[2]), (255, 0, 255), 2)

faceLocTest = face_recognition.face_locations(imgTest)[0]

encodeTest = face_recognition.face_encodings(imgTest)[0]

cv2.rectangle(imgTest, (faceLocTest[3], faceLocTest[0]), (faceLocTest[1], faceLocTest[2]), (255, 0, 255), 2)

results = face_recognition.compare_faces([encodeElon], encodeTest)

faceDis = face_recognition.face_distance([encodeElon], encodeTest)

print(results, faceDis)

cv2.putText(imgTest, f'{results} {round(faceDis[0], 2)}', (50, 50), cv2.FONT_HERSHEY_COMPLEX, 1, (0, 0, 255), 2)

cv2.imshow('Elon Musk', imgElon)

cv2.imshow('Elon Test', imgTest)

cv2.waitKey(0)

Usaremos a foto do Sr. Musk como teste padrão, 'Elon Musk.png'. As outras duas fotos são do Sr. Bill Gates e do Sr. Musk.

A explicação de hoje será dividida em duas partes, essa é a parte básica da explicação.

- Primeiro, importe as imagens nestes dois códigos. Usamos a função load_image_file em face_recognition, que irá carregar o arquivo de imagem (.jpg, .png, etc.) em um array numpy, e o formato default='RGB', então há uma transformação aqui.

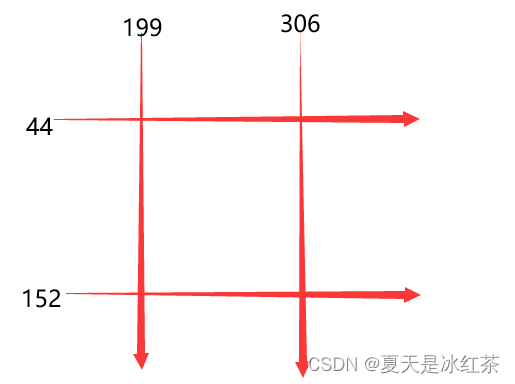

- Em segundo lugar, faceLoc aceita o array de caixa delimitadora do rosto na imagem retornada pela função face_locations(), veja a Nota 1, pegue o primeiro número, ele aguardará até uma tupla, temos que pressionar css (cima, direita, baixo , left ) lista de tuplas de posições de face encontradas sequencialmente. A função encodeElon() retorna uma lista de codificação de face de 128 dimensões (uma para cada face na imagem), por que é de 128 dimensões? Veja Nota 2. Depois disso, é a operação de quadro novamente. Acredito que quem leu meus artigos anteriores deve estar muito familiarizado com isso. Insira as coordenadas conforme a Nota 3.

- Depois disso, compare_faces() compara a lista de codificações de face com as codificações candidatas para ver se elas correspondem, lembre-se, apenas a primeira é uma lista, que retornará uma lista de valores verdadeiro/falso; face_distance() requer uma determinada codificação de face list, compare-a com codificações de face conhecidas e obtenha a distância euclidiana para cada face comparada. A distância lhe dirá quão semelhantes são os rostos. Novamente, apenas o primeiro é uma lista. Veja a Nota 4 acima.

- Por fim, coloque as informações enquadradas em um local adequado para exibir a imagem.

Nota 1: [(44, 306, 152, 199)]

Nota 2: O aprendizado de máquina é divertido! Parte 4: Reconhecimento de Face Moderno e Aprendizado Profundo - Ranking Fintech (fintechranking.com) por Adam Geitgey .

Nota 3: Diagrama de coordenadas

Nota 4: [Verdadeiro] [0,4559636]

(5) Exibição do efeito

Ao modificar o código aqui, implementamos inicialmente o reconhecimento facial.

imgTest = face_recognition.load_image_file('ImagesBasic/Bill Gates.png')

imgTest = cv2.cvtColor(imgTest, cv2.COLOR_BGR2RGB)

4. Exibição e explicação do código do projeto

import cv2

import numpy as np

import face_recognition

import os

from datetime import datetime

# from PIL import ImageGrab

path = 'Attendance_images'

images = []

classNames = []

myList = os.listdir(path)

print(myList)

for cl in myList:

curImg = cv2.imread(f'{path}/{cl}')

images.append(curImg)

classNames.append(os.path.splitext(cl)[0])

print(classNames)

def findEncodings(images):

encodeList = []

for img in images:

img = cv2.cvtColor(img, cv2.COLOR_BGR2RGB)

encode = face_recognition.face_encodings(img)[0]

encodeList.append(encode)

return encodeList

def markAttendance(name):

with open('Attendance_lists.csv', 'r+') as f:

myDataList = f.readlines()

nameList = []

for line in myDataList:

entry = line.split(',')

nameList.append(entry[0])

if name not in nameList:

now = datetime.now()

dtString = now.strftime('%H:%M:%S')

f.writelines(f'\n{name},{dtString}')

#### FOR CAPTURING SCREEN RATHER THAN WEBCAM

# def captureScreen(bbox=(300,300,690+300,530+300)):

# capScr = np.array(ImageGrab.grab(bbox))

# capScr = cv2.cvtColor(capScr, cv2.COLOR_RGB2BGR)

# return capScr

encodeListKnown = findEncodings(images)

print('Encoding Complete')

cap = cv2.VideoCapture(1)

while True:

success, img = cap.read()

# img = captureScreen()

imgS = cv2.resize(img, (0, 0), None, 0.25, 0.25)

imgS = cv2.cvtColor(imgS, cv2.COLOR_BGR2RGB)

facesCurFrame = face_recognition.face_locations(imgS)

encodesCurFrame = face_recognition.face_encodings(imgS, facesCurFrame)

for encodeFace, faceLoc in zip(encodesCurFrame, facesCurFrame):

matches = face_recognition.compare_faces(encodeListKnown, encodeFace)

faceDis = face_recognition.face_distance(encodeListKnown, encodeFace)

# print(faceDis)

matchIndex = np.argmin(faceDis)

if matches[matchIndex]:

name = classNames[matchIndex].upper()

# print(name)

y1, x2, y2, x1 = faceLoc

y1, x2, y2, x1 = y1 * 4, x2 * 4, y2 * 4, x1 * 4

cv2.rectangle(img, (x1, y1), (x2, y2), (0, 255, 0), 2)

cv2.rectangle(img, (x1, y2 - 35), (x2, y2), (0, 255, 0), cv2.FILLED)

cv2.putText(img, name, (x1 + 6, y2 - 6), cv2.FONT_HERSHEY_COMPLEX, 1, (255, 255, 255), 2)

markAttendance(name)

cv2.imshow('Webcam', img)

cv2.waitKey(1)Algumas das operações aqui foram mencionadas no meu blog anterior, e eu expliquei muito claramente, então vou falar brevemente sobre isso.

- Primeiro, leia o nome da imagem no arquivo Attendance_images, observe que ela tem .png, e nossa nomenclatura não exige isso, então pegue um [0].

- Segundo, escreva findEncodings() para armazenar as codificações de imagens padrão, na forma de uma lista. A função markAttendance() é usada para ler as informações do arquivo Attendance_lists.csv e gravá-las no Excel, onde também pode ser gravada a hora.

- Então, quanto ao resto, acredito que não deve haver problema em se referir à explicação acima. Vamos falar sobre y1, x2, y2, x1 = y1 * 4, x2 * 4, y2 * 4, x1 * 4, por que multiplicar por 4, lembre-se do redimensionamento acima, não requer alterações de pixel, mas encolhe A proporção é exatamente 0,25.

5. Materiais do projeto

6. Resumo do projeto

O projeto de hoje ainda é mais difícil do que a detecção de objetos anterior. Para mim, a eficiência atual não é muito alta. O download dos pacotes dlib e face_recognition ontem realmente não foi feito. Mudei um projeto temporariamente, e fiz isso hoje há muito tempo .

Então, espero que você se divirta com este projeto! !