introdução

Recentemente, no Sequoia AI Summit, nos Estados Unidos, o professor Andrew Ng, uma autoridade de alto nível no campo da inteligência artificial, publicou tendências de ponta e insights profundos sobre agentes de IA. Ele destacou que, em comparação com aplicativos convencionais de modelo de linguagem em larga escala (LLM), o fluxo de trabalho do Agente apresenta características mais iterativas e conversacionais, abrindo novas ideias para nós no campo do desenvolvimento de aplicativos de IA.

Nesta cimeira, o Professor Ng Enda discutiu profundamente as perspectivas de desenvolvimento do Agente de IA, que é um tema interessante para todos os programadores e investigadores de IA. Ele explicou as principais características do fluxo de trabalho do Agente: em vez de buscar feedback imediato, ele defende a entrega de tarefas por meio de comunicação contínua e processos iterativos para alcançar melhores resultados.

Características do fluxo de trabalho do agente

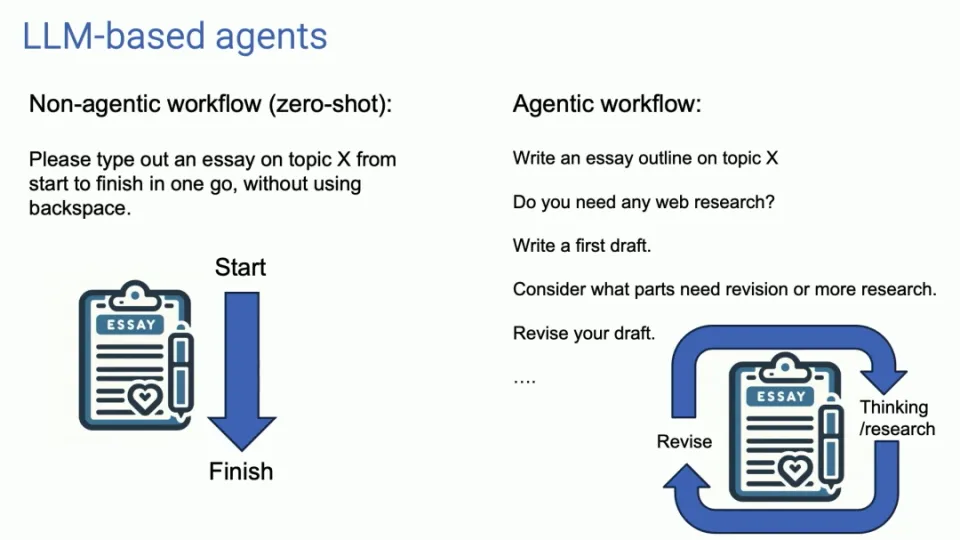

O uso tradicional do LLM é semelhante à entrada e saída únicas, enquanto o fluxo de trabalho do Agente é como um diálogo contínuo, otimizando os resultados de saída por meio de múltiplas iterações. Essa abordagem exige que mudemos a forma como interagimos com a IA, deleguemos mais tarefas ao agente e esperemos pacientemente pelos resultados que ela fornece.

Quatro padrões principais de design de agentes

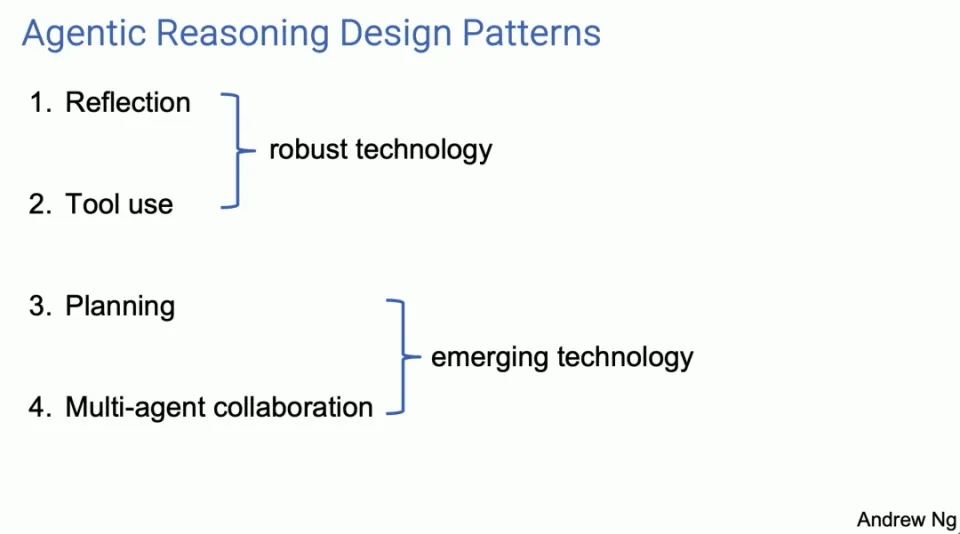

O professor Ng Enda introduziu quatro padrões principais de design de agentes, cada um dos quais mostra o potencial para melhorar as capacidades de IA.

-

Reflexão

- O Agent melhora a qualidade dos resultados revisando e corrigindo os resultados. Por exemplo, na escrita de código, o Agente pode refletir e corrigir erros, gerando assim um código melhor.

Agent Reflection é uma ferramenta que muitos de nós usamos e é a ferramenta que funciona. Acho que é mais amplamente reconhecido e realmente funciona muito bem. Acho que essas são técnicas bastante robustas. Quando os uso, quase sempre consigo que funcionem bem com planejamento e colaboração multiagente.

Acho que este é um campo mais emergente e às vezes fico surpreso com o desempenho deles quando os uso, mas pelo menos no momento sinto que nem sempre consigo fazer com que funcionem de maneira confiável. Deixe-me explicar esses quatro padrões de design através de vários aspectos. Se alguns de vocês voltarem e tentarem fazer isso sozinhos, ou pedirem que seus engenheiros os usem, acho que obterão um aumento de produtividade muito rapidamente.

Em relação à Reflexão, aqui está um exemplo. Digamos que eu peça a um sistema que escreva um código para eu concluir uma determinada tarefa. E então temos um agente de codificação, que é apenas um LLM que você solicita para escrever código, como, "Ei, defina doTask, escreva uma função como esta."

Um exemplo de autorreflexão pode ser se você solicitar ao LLM algo como: "Aqui está um trecho de código destinado a realizar uma tarefa, apenas forneça exatamente o mesmo código que eles acabaram de gerar e diga: verifique novamente. O código está correto, eficiente, bem construído? Basta escrever uma dica como esta.

Pode acontecer que o mesmo LLM que você solicitou para escrever o código consiga encontrar um erro como este na linha 5 e corrigi-lo de alguma forma. Se você der seu próprio feedback e solicitá-lo novamente, poderá surgir uma segunda versão do código que funcionará melhor que a primeira versão.

Não há garantias, mas muitas vezes funciona bem o suficiente para valer a pena tentar em muitos aplicativos, e é um bom presságio se você deixá-lo executar os testes de unidade e, se falhar nos testes de unidade, por que falha nos testes de unidade? Ter essa conversa pode esclarecer por que os testes de unidade estão falhando. Então tente mudar algumas coisas e talvez obter a versão 3.

Aliás, para vocês que querem aprender mais sobre essas tecnologias, estou muito entusiasmado com elas, para cada uma das quatro partes, tenho uma seção de Leitura Recomendada na parte inferior, onde estão incluídos mais referências de material.

Novamente, com sistemas multiagentes, estou descrevendo um único agente de código que você solicita que fale consigo mesmo. Uma evolução natural desta ideia é que em vez de um único agente de código, você poderia ter dois agentes, um dos quais é o agente de código e o outro um agente de crítica. Estes podem ser o mesmo LLM subjacente, mas solicitados de maneiras diferentes. Digamos, por exemplo, que você seja um especialista em código, certo? escreva o código. Outro disse, você é um revisor de código especialista, revise este código.

Este fluxo de trabalho é realmente fácil de implementar. Acho que esta é uma técnica muito versátil para muitos fluxos de trabalho. Isto irá melhorar significativamente o desempenho do LLM.

-

Uso de ferramentas

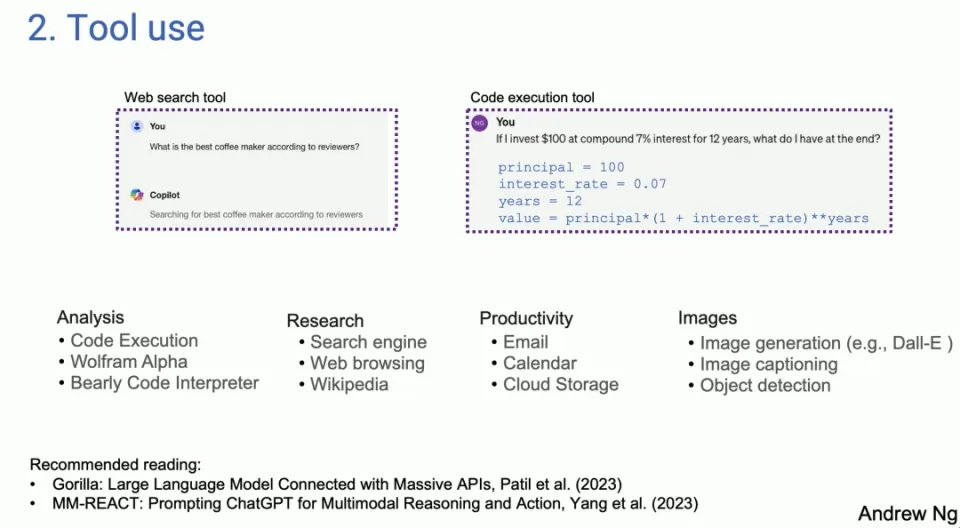

- O LLM é capaz de gerar código e chamar APIs para realizar operações práticas, ampliando assim seu escopo de aplicação. Neste modo, o LLM pode não apenas gerar texto, mas também interagir com ferramentas e interfaces externas.

O segundo padrão de design é aquele que muitas pessoas viram usado em sistemas baseados em LLM. À esquerda está uma captura de tela do Copilot. À direita está algo que retirei do GPT-4, mas o LLM de hoje, se você perguntar qual é a melhor máquina de café em uma pesquisa online, para certas dúvidas o LLM irá gerar o código e executá-lo. Acontece que existem muitas ferramentas diferentes usadas por muitas pessoas diferentes para análise, aquisição de informações, ação e produtividade pessoal.

Os primeiros trabalhos passaram a ser usados, originalmente na comunidade de visão computacional. Porque antes do LLM eles não conseguiam processar imagens. Portanto, a única opção é gerar uma chamada de função que possa manipular a imagem, como gerar uma imagem ou detectar objetos, etc. Se você realmente olhar a literatura, é interessante que muito do trabalho sobre uso parece ter se originado no domínio da visão, porque antes do GPT-4 e assim por diante, o LLM era cego para imagens, e é isso que o uso e a extensão do LLM Coisas que podem ser feitas.

-

Planejamento

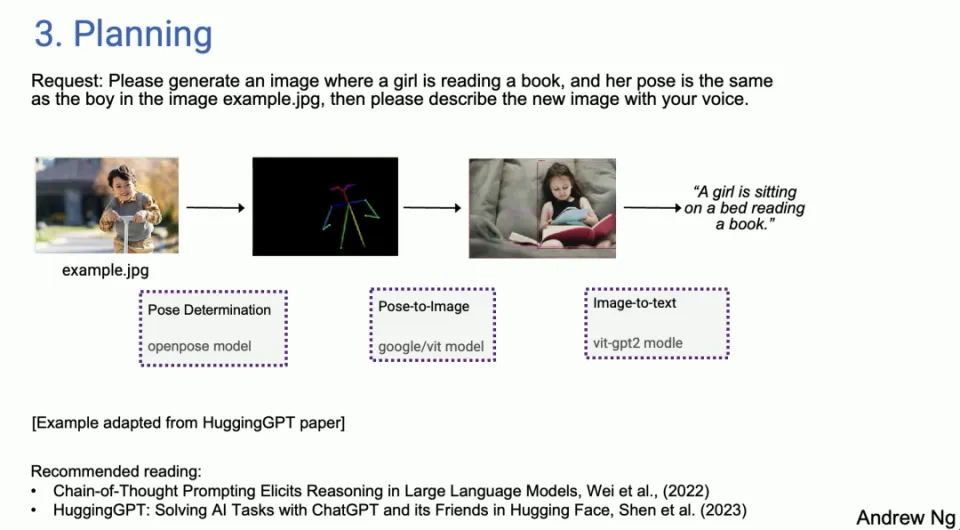

- O agente pode dividir tarefas complexas e executá-las conforme planejado, demonstrando a capacidade da IA de lidar com problemas complexos. Os algoritmos de planejamento permitem que os Agentes gerenciem e concluam tarefas com mais eficiência.

E então planejamento, para quem ainda não brincou muito com algoritmos de planejamento, sinto que muita gente fala sobre momentos do ChatGPT em que você fica tipo, uau, você nunca viu nada assim. Não acho que você esteja usando um algoritmo de planejamento ainda. Muitas pessoas ficarão surpresas com o AI Agent.

Não consigo imaginar um agente de IA fazendo isso bem. Já fiz demonstrações ao vivo e algumas delas falharam e o Agente AI contornou essas falhas. Na verdade, me deparei com algumas situações em que, sim, não conseguia acreditar que meu sistema de IA fazia isso de forma autônoma.

Mas um exemplo adaptado do artigo HuggingGPT, você disse, por favor, gere uma imagem de uma menina lendo um livro na mesma postura que o menino no exemplo de imagem ponto jpeg, descreva a nova imagem com voz. Então, para dar um exemplo, hoje existe um Agente de IA, e você pode decidir que a primeira coisa que precisa fazer é determinar a postura do menino. Em seguida, encontre o modelo correto e possivelmente extraia a pose no HuggingFace. Em seguida, você precisa encontrar um modelo de imagem de pose para sintetizar a imagem de uma garota e seguir as instruções. Em seguida, use a detecção de imagem e, finalmente, a conversão de texto em fala.

Na verdade, temos Agentes hoje, não quero dizer que eles trabalham de maneira confiável, eles são um pouco meticulosos. Eles nem sempre funcionam, mas quando funcionam, é realmente incrível, mas com Agent Sex Loops, às vezes você também pode se recuperar de falhas iniciais. Então descobri que já estava usando o Research Agent. Então, parte do meu trabalho, parte da minha pesquisa, mas não estou com vontade, vou eu mesmo ao Google e fico muito tempo. Devo enviar para o agente de pesquisa e voltar alguns minutos depois para ver o que ele encontra, às vezes funciona, às vezes não, mas já faz parte do meu fluxo de trabalho pessoal.

-

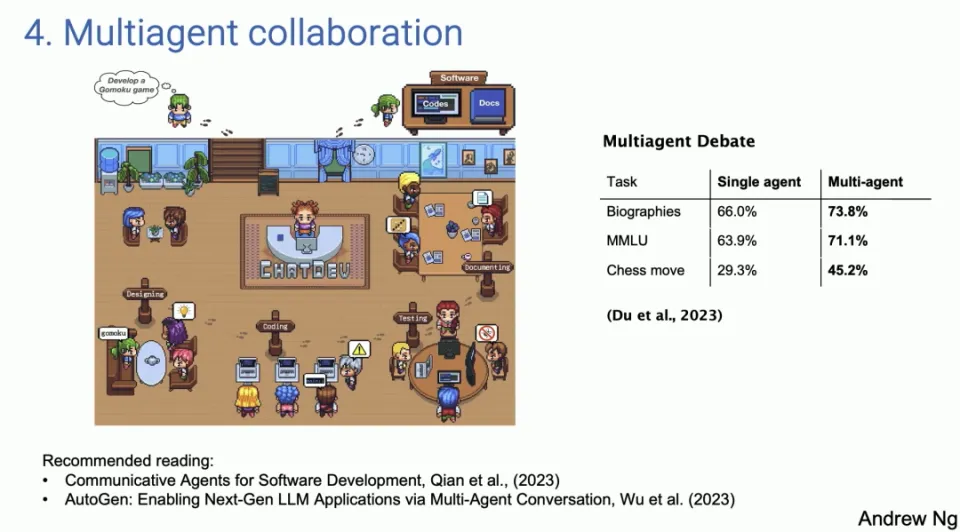

Colaboração multiagente

- Vários agentes desempenham diferentes funções e cooperam para concluir tarefas, simulando a colaboração num ambiente de trabalho real. O poder desta abordagem é que ela permite que o LLM se torne mais do que apenas uma ferramenta que executa uma única tarefa, mas sim um sistema colaborativo capaz de lidar com problemas e fluxos de trabalho complexos.

O último padrão de design, cooperação multiagente, parece interessante, mas funciona muito melhor do que você imagina. À esquerda está uma captura de tela de um artigo chamado ChatDev, que é totalmente de código aberto, na verdade, de código aberto. Como muitos de vocês viram, Shining Social

A demonstração divulgada pela mídia, ChatDev, é de código aberto e roda no meu laptop. ChatDev é um exemplo de sistema multiagente onde você pode solicitar que um LLM atue às vezes como o CEO de uma empresa de engenharia de software, às vezes como um designer, às vezes como um gerente de produto e às vezes como um testador.

Ao solicitar ao LLM que diga que agora você é o CEO, agora você é o engenheiro de software, eles colaboram e têm uma conversa extensa a ponto de, se você contar, por favor, desenvolva um jogo, desenvolva um jogo multijogador, eles ' na verdade, gaste alguns minutos escrevendo código, teste-o, repita-o e termine com um programa surpreendentemente complexo.

Esse tipo de colaboração multiagente pode parecer um pouco fantasioso, mas na verdade funciona melhor do que você imagina. Isso não ocorre apenas porque a cooperação entre esses agentes pode trazer insumos mais ricos e diversificados, mas também porque pode simular um cenário mais próximo de um ambiente de trabalho real, no qual pessoas com diferentes funções e expertises trabalham em prol de um objetivo comum. O poder desta abordagem é que ela permite que o LLM se torne mais do que apenas uma ferramenta que executa uma única tarefa, mas sim um sistema colaborativo capaz de lidar com problemas e fluxos de trabalho complexos.

O valor potencial desta abordagem é enorme, pois abre novas possibilidades para automatizar e tornar os fluxos de trabalho mais eficientes. Por exemplo, ao simular as diferentes funções de uma equipe de desenvolvimento de software, uma empresa pode automatizar determinadas tarefas de desenvolvimento, acelerando assim os projetos e reduzindo erros. Da mesma forma, este método de cooperação multiagente também pode ser aplicado a outras áreas, como criação de conteúdos, educação e formação, e planeamento estratégico, alargando ainda mais o âmbito de aplicação do LLM em diversas indústrias.

Potencial e desafios do fluxo de trabalho do agente

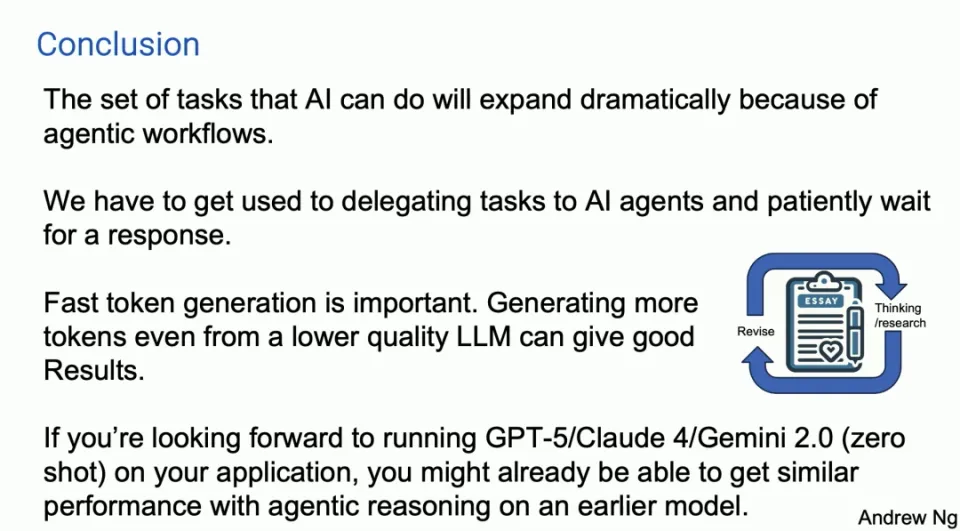

Embora esses fluxos de trabalho de agentes sejam cheios de potencial, embora se desenvolvam rapidamente, também existem alguns desafios. Alguns padrões de projeto são relativamente maduros e confiáveis, enquanto outros ainda são incertos. Além disso, a importância da geração rápida de tokens não pode ser ignorada, pois permite obter bons resultados mesmo que seja baseado em um LLM de qualidade inferior e gera novos tokens por meio de iteração rápida.

Estudos de caso e aplicações práticas

O Professor Ng Enda explicou ainda a eficácia do fluxo de trabalho do Agente através de estudos de caso e aplicações práticas. Por exemplo, a análise de codificação usando o Human Eval Benchmark e a comparação de desempenho entre GPT-3.5 e GPT-4 mostram a superioridade do fluxo de trabalho do Agente. Especialmente na área de desenvolvimento de software, exemplos de aplicação de sistemas multiagentes mostram como melhorar a eficiência do desenvolvimento e reduzir erros simulando diferentes funções em um ambiente de trabalho real.

perspectiva futura

O professor Ng Enda acredita que as capacidades dos Agentes de IA serão bastante expandidas e precisamos aprender novas maneiras de trabalhar com Agentes de IA. O potencial de iteração rápida e de modelos iniciais indica que a IA será aplicada de forma mais ampla e profunda em vários campos.

Resumir

Através de padrões de design como Agent Reflection, planejamento e cooperação multiagente, podemos não apenas melhorar o desempenho dos LLMs, mas também expandir suas áreas de aplicação e torná-los ferramentas mais poderosas e flexíveis. À medida que estas tecnologias continuam a desenvolver-se e a melhorar, esperamos que os Agentes de IA desempenhem um papel fundamental em mais cenários no futuro, trazendo soluções mais inteligentes e eficientes para as pessoas.

Nem sempre funciona. Eu usei isso. Às vezes não funciona, às vezes é surpreendente, mas a tecnologia está definitivamente cada vez melhor. Há também um padrão de design, e acontece que o debate multiagente, ou seja, o debate entre diferentes agentes, por exemplo, você pode fazer com que ChatGPT e Gemini debatam entre si, o que na verdade leva a um melhor desempenho.

Portanto, ter vários agentes aéreos simulados trabalhando juntos também é um padrão de projeto poderoso. Para resumir, acho que esses são os padrões que vi. Penso que se pudéssemos utilizar estes padrões, muitos de nós poderíamos alcançar melhorias práticas muito rapidamente. Acho que o padrão de design de raciocínio do Agente será importante.

Aqui está meu breve slide de resumo. Prevejo que, devido ao fluxo de trabalho do Agente, as tarefas que a IA pode realizar se expandirão significativamente este ano. Uma coisa com a qual é realmente difícil se acostumar é que, quando enviamos um prompt ao LLM, esperamos uma resposta imediata. Na verdade, há dez anos, quando eu estava no Google falando sobre o que chamamos de pesquisa em caixa grande, uma das razões para solicitações longas, uma das razões pelas quais não consegui insistir foi porque quando você faz uma pesquisa na web, você deseja pesquisar na metade do tempo. Obtenha uma resposta em segundos, certo? Esta é a natureza humana, captura instantânea, feedback instantâneo.

Para muitos fluxos de trabalho de agentes, acho que precisamos aprender a delegar tarefas a agentes de IA e esperar pacientemente minutos ou até horas por uma resposta, mas como já vi muitos gerentes novatos delegarem tarefas a alguém e depois cinco minutos após a inspeção é a mesma coisa, certo? Isso não é produtivo.

Acho que precisamos aprender a fazer isso também com alguns dos nossos agentes de IA, embora seja difícil. Pensei ter ouvido alguma perda. Então, uma tendência importante é que os geradores rápidos de tokens são importantes porque, nesses fluxos de trabalho do Agente, estamos constantemente iterando. Portanto, o LLM gera tokens para o LLM, e é ótimo poder gerar tokens muito mais rápido do que qualquer um pode ler.

Acredito que gerar mais tokens rapidamente, mesmo a partir de um LLM de qualidade um pouco inferior, pode dar bons resultados em comparação com tokens mais lentos de um LLM melhor. Isso pode ser um pouco controverso porque pode fazer você dar mais voltas no círculo, mais ou menos como mostrei no primeiro slide com GPDC e os resultados de uma arquitetura de agente.

Francamente, estou realmente ansioso por Claude5 e Claude4, GPT-5 e Gemini 2.0 e todos esses modelos maravilhosos que vocês estão construindo. Parte de mim sente que se você deseja executar suas coisas no GPT-5, tiro zero, você pode realmente chegar mais perto desse nível de desempenho em alguns aplicativos do que pensa com a inferência do agente, mas em um modelo inicial, Acho que essa é uma tendência importante.

Honestamente, o caminho para a AGI parece mais uma jornada do que um destino, mas acho que esse fluxo de trabalho do Agente pode nos ajudar a dar um pequeno passo nessa longa jornada.

Linus resolveu resolver o problema por conta própria para evitar que os desenvolvedores do kernel substituíssem tabulações por espaços. Seu pai é um dos poucos líderes que sabe escrever código, seu segundo filho é o diretor do departamento de tecnologia de código aberto e seu filho mais novo é um núcleo. contribuidor de código aberto Huawei: Demorou 1 ano para converter 5.000 aplicativos móveis comumente usados A migração abrangente para Hongmeng Java é a linguagem mais propensa a vulnerabilidades de terceiros Wang Chenglu, o pai de Hongmeng: Hongmeng de código aberto é a única inovação arquitetônica. no campo de software básico na China. Ma Huateng e Zhou Hongyi apertam as mãos para "remover rancores". Ex-desenvolvedor da Microsoft: o desempenho do Windows 11 é "ridiculamente ruim" " Embora o que Laoxiangji seja de código aberto não seja o código, as razões por trás disso são muito emocionantes. Meta Llama 3 é lançado oficialmente. Google anuncia uma reestruturação em grande escala.Este artigo é uma reimpressão do artigo Heng Xiaopai e os direitos autorais pertencem ao autor original. Recomenda-se visitar o texto original. Para reimprimir este artigo, entre em contato com o autor original.