1. Подготовьте несколько виртуальных машин

У меня есть четыре виртуальных машин: Псевдонимы node1, node2, node3, node4

2. подготовка

Установка 1.jdk

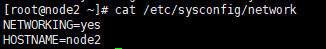

2. Проверьте виртуальный псевдоним машины правильно, просмотреть следующую команду

кошки / и т.д. / sysconfig / сети ,

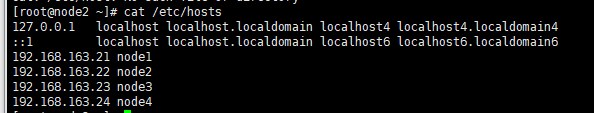

чтобы увидеть , если же хосты файл виртуальной машины , чтобы гарантировать , что может свистеть

CAT / и т.д. / Hosts

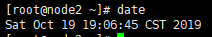

3. Проверьте время одинаковы, команда следующие

даты ,

если время не соответствует, вы можете установить синхронизацию времени через следующую команду: dtae -s «год - месяц - день час - минута - секунды», и установка в режиме реального времени не обязательно точно то же самое время, но время до четырех виртуальных машин соответствует

4 в целях безопасности, используйте следующую команду

кошки / и т.д. / sysconfig / SELinux

3. Полностью распределенная схема конфигурации

узел2 , как NomeNode

node1 как SNN (SecondaryNameNode) и DN (DataNode)

node3 как DataNode

Node4 как DataNode

4. Ключ распределения

Закрытые ключи генерируются файл по моему поручению строить псевдо-распределенных были достигнуты на виртуальной машине , созданной Hadoop 1.x версии псевдо-распределенных

первым , чтобы проверить , можно ли найти в следующем домашнем каталоге .shh скрытые файлы ,

если нет, введите SSH Localhost (или псевдоним).

Тогда из node2 в node1 / node3 / node4 распространить открытый ключ (открытый ключ для изменения названия), перейдите к следующему каталогу .ssh

введите команду

scp id_dsa.pub node1:`pwd`/node2.pub #改命令将文件分发给node1节点,然后自己再将文件通过改命令分发给其他节点

Каждый узел для node1 сертифицированного открытого ключа добавляется в файл

кошке ~ / node2.pub >> ~ / .ssh / authorized_keys

5 конфигурации Hadoop и распространяются на другие узлы

Etc в файл в Hadoop-2.6.5 под node2 под реализовать на виртуальной машине настроить Hadoop 1.x версии псевдо-распределенной , мы настроили псевдо-распределенной, полностью распределенной конфигурации в Hadoop части конфигурация , в которой была настроена, мы изменяем части конфигурации , в которой линии. Так резервное копирование Hadoop

cp -r hadoop/ hadoop_copy(备份的名字可以自己取)

Hadoop среда JAVA_HOME переменная вторичная конфигурация построен в псевдо-распределенных статьях описаны здесь не говорит.

Затем

настроить ядро-site.xml

vi core-site.xml

在<configuration></configuration>中加入以下配置

<property>

<name>fs.defaultFS</name>

<value>hdfs://node2:9000</value> #指定主节点是哪个节点

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/var/sxt/hadoop/full</value> #指定数据上传的目录

</property>

Настройка HDFS-site.xml

vi mapred-env.sh

在<configuration></configuration>中,加入以下内容

<property>

<name>dfs.replication</name>

<value>2</value> #配置副本数,可以改变

</property>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>node1:50090</value>#配置SecondaryNameNode

</property>

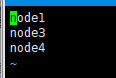

От узла файл используется для настройки рабов

vi slaves

#将从节点加入到文件中

#如下图所示

Hadoop, распределенный каждый узел

scp -r hadoop-2.6.5/ node1:`pwd`#将hadoop分发给node1节点

6. Настройка среды

В другой статье на моем блоге «реализованная на виртуальной машине для сборки версии 1.x из Hadoop псевдо-распределенных» описывает переменную конфигурации и переменные среды окружения Java конфигурации Hadoop. node2 здесь, потому что они настроены, так что вы можете профиль файлы в / и т.д., распределенные для каждого узла. Конечно, другие узлы в Hadoop и JDK версии, чтобы быть последовательными

scp /etc/profile node1:/etc/ #分发给node1节点

Перечитайте конфигурационный файл источника / и т.д. / профиль

на тестовой среде JPS Java, испытание HDFS среды Hadoop является создание успеха

7. Формат и запустить кластер Hadoop

Формат кластера: NameNode -format HDFS

запустить кластер: start-dfs.sh

JPS вид каждого процесса узла начинает обстоятельства ,

вид пользовательского интерфейса Hadoop- IP через сеть: 50070

Стоп:

узел2: stop-dfs.sh

обратить внимание

Статья в конфигурации Hadoop и конфигурация JAVA_HOME вторичного колонкового site.xml, конфигурация HDFS-site.xml, настроить раб и бесплатный ключ, Java переменных окружения и настроить переменные среды Hadoop, которые настроены на меня «в виртуальной машине добиться сборки 1.x версии Hadoop псевдо-распределенных «блог был объяснен. Эта статья не объясняет, как настроить решения.