[Зарезервировано] AdaBoost алгоритм

Оригинал: https://blog.csdn.net/v_july_v/article/details/40718799

Здесь не воспроизводится, первоначальный вид. Но есть можно отметить несколько пунктов ниже:

- На базовом классификаторе обученных веса начальные веса под основным классификатором. И сортируют после каждого обновления, сочетание прогнозирования классифицируются и передней части классификатора, например, оригинал

f3(x)=0.4236G1(x) + 0.6496G2(x)+0.7514G3(x) - Базовая классификация обновляется только один раз весов

- Строительство основного классификатора останавливается, когда требуемая точность

- AdaBoost ошибки верхней границы уравнение показывает, что: композитный классификатор ошибок уменьшается с минимальным индексом ошибки по существу классификаторов

Обратите внимание, что существует формула для исходных неправильно:

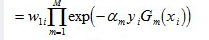

Когда получена оценка погрешности AdaBoost:

Вт фронт должен плюс сумма, может относиться к конкретной формуле формулы