一、关闭防火墙

(1)关闭防火墙:systemctl stop firewalld.service

(2)禁用防火墙:systemctl disable firewalld.service

(3)查看防火墙:systemctl status firewalld.service

(4)关闭Selinux:vi /etc/selinux /config

将SELINUX=enforcing改为SELINUX=disabled

二、修改IP

vim /etc/sysconfig/network-scripts/eno16777736

注:(“eno16777736”根据自己的网卡设置)BOOTPROTO=static

ONBOOT=yes

IPADDR=192.168.X.51

GATEWAY=192.168.X.2

DNS1=8.8.8.8

DNS2=8.8.4.4

NETMASK=255.255.255.0

vi /etc/resolv.confnameserver 8.8.8.8

nameserver 8.8.4.4

重启网卡:

servie network restart三、修改主机名

vim /etc/hostname

bigdata111四、IP和主机名关系映射

vim /etc/hosts192.168.1.121 bigdata111

在windows的C:\Windows\System32\drivers\etc路径下找到hosts并添加:

192.168.1.121 bigdata111

五、创建hadoop用户

打开终端窗口,输入如下命令创建新用户 :

sudo useradd -m hadoop -s /bin/bash接着使用如下命令设置密码,可简单设置为 hadoop,按提示输入两次密码:

sudo passwd hadoop可为 hadoop 用户增加管理员权限,方便部署,避免一些对新手来说比较棘手的权限问题:

sudo adduser hadoop sudo六、SSH无密码登录

(1)使用如下命令登陆本机:

ssh localhost此时会有如下提示(SSH首次登陆提示),输入 yes 。然后按提示输入密码 hadoop,这样就登陆到本机了。

(2)生成公钥和私钥:

exit # 退出刚才的 ssh localhost

cd ~/.ssh/

ssh-keygen -t rsa #会有提示,都按回车就可以

cat ./id_rsa.pub >> ./authorized_keys # 加入授权然后就会生成两个文件id_rsa(私钥)、id_rsa.pub(公钥)

七、安装jdk

(1)查询是否安装java软件,如有先卸载

rpm -qa|grep java #查询是否安装

rpm -e 软件包名字 #卸载(2)在/opt目录下创建两个子文件

mkdir /opt/module /opt/soft(3)解压jdk到/opt/module目录下

tar -zxvf jdk-8u144-linux-x64.tar.gz

-C /opt/module/(4)配置jdk环境变量

vi /etc/profileexport JAVA_HOME=/opt/mod/jdk1.8.0_144

export PATH= JAVA_HOME/bin

source一下使其生效:(否则配置的环境无效)

source /etc/profile(5)测试jdk安装成功

java -version能出现版本号就证明安装成功了。

八、安装hadoop

(1)将hadoop安装至/opt/mudole中:

tsr -zxvf ~/opt/soft/hadoop-2.6.0.tar.gz -C /opt/module #解压到/opt/module中

cd /opt/module/

mv ./hadoop-2.6.0/ ./hadoop # 将文件夹名改为hadoop

chown -R hadoop ./hadoop # 修改文件权限(2)Hadoop 解压后即可使用。输入如下命令来检查 Hadoop 是否可用,成功则会显示 Hadoop 版本信息:

cd /opt/module/hadoop

./bin/hadoop version(3)配置hadoop环境变量

vi /etc/profileexport HADOOP_HOME=/opt/module/hadoop-2.6.0

export PATH= HADOOP_HOME/bin

source一下使其生效:source /etc/profile

(4)修改hadoop配置文件

cd /opt/module/hadoop/etc/hadoop #进入这个目录修改配置文件:vim core-site.xml

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/opt/module/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>修改配置文件: hdfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/opt/module/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/opt/module/hadoop/tmp/dfs/data</value>

</property>

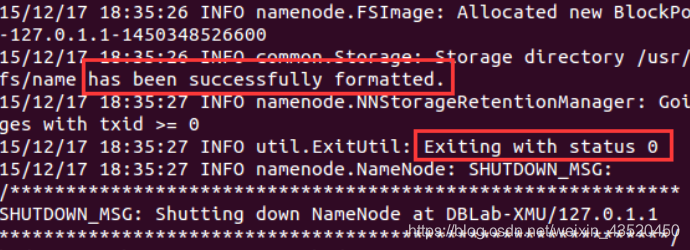

</configuration>(5)配置完成后,执行 NameNode 的格式化:

cd /opt/module/hadoop

hdfs namenode -format #格式化命令成功的话,会看到 “successfully formatted” 和 “Exitting with status 0” 的提示,若为 “Exitting with status 1” 则是出错。

(6)启动hadoop

cd /opt/module/hadoop

start-all.sh #启动命令若出现如下SSH提示,输入yes即可。

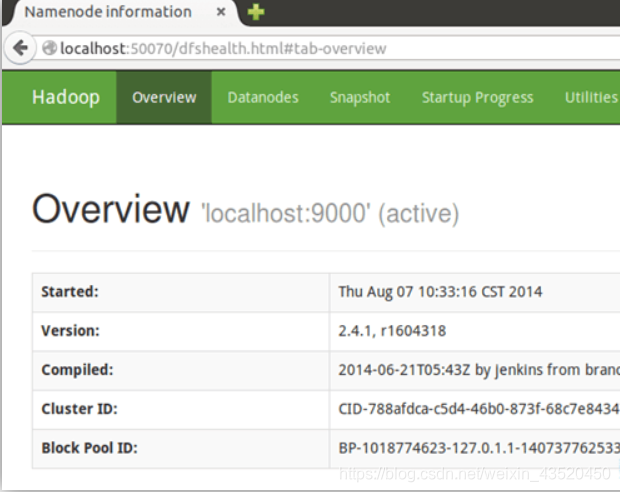

成功启动后,可以访问 Web 界面 http://localhost:50070 查看 NameNode 和 Datanode 信息,还可以在线查看 HDFS 中的文件。