创建CM用的数据库

CDH jar包提取

百度网盘链接:https://pan.baidu.com/s/1xCBIGAwJ6nw8zjDveNqCXw

提取码:sxhf

在MySQL中依次创建监控数据库、Hive数据库、Oozie数据库、Hue数据库

1)启动数据库

[root@hadoop102 ~]# mysql -uroot -p000000

2)集群监控数据库

mysql> create database amon DEFAULT CHARSET utf8 COLLATE utf8_general_ci;

3)Hive数据库

mysql> create database hive DEFAULT CHARSET utf8 COLLATE utf8_general_ci;

4)Oozie数据库

mysql> create database oozie DEFAULT CHARSET utf8 COLLATE utf8_general_ci;

5)Hue数据库

mysql> create database hue DEFAULT CHARSET utf8 COLLATE utf8_general_ci;

6)关闭数据库

mysql> quit;

下载第三方依赖

依次在三台节点(所有Agent的节点)上执行下载第三方依赖(注意:需要联网)

[root@hadoop102 ~]# yum -y install chkconfig python bind-utils psmisc libxslt zlib sqlite cyrus-sasl-plain cyrus-sasl-gssapi fuse fuse-libs redhat-lsb

[root@hadoop103 ~]# yum -y install chkconfig python bind-utils psmisc libxslt zlib sqlite cyrus-sasl-plain cyrus-sasl-gssapi fuse fuse-libs redhat-lsb

[root@hadoop104 ~]# yum -y install chkconfig python bind-utils psmisc libxslt zlib sqlite cyrus-sasl-plain cyrus-sasl-gssapi fuse fuse-libs redhat-lsb

关闭SELINUX

安全增强型Linux(Security-Enhanced Linux)简称SELinux,它是一个 Linux

内核模块,也是Linux的一个安全子系统。为了避免安装过程出现各种错误,建议关闭,有如下两种关闭方法:

1)临时关闭(不建议使用)

[root@hadoop102 ~]# setenforce 0

但是这种方式只对当次启动有效,重启机器后会失效。

2)永久关闭(建议使用)

修改配置文件/etc/selinux/config

[root@hadoop102 ~]# vim /etc/selinux/config

将SELINUX=enforcing 改为SELINUX=disabled

SELINUX=disabled

3)同步/etc/selinux/config配置文件

[root@hadoop102 ~]# xsync /etc/selinux/config

vi /boot/grub/menu.lst

kernel /vmlinuz-2.6.32-431.el6.x86_64 ro root=UUID=f6cf5f2e-c216-4dbf-88dd-ea8169bbc2b1 rd_NO_LUKS rd_NO_LVM LANG=en_US.UTF-8 rd_NO_MD SYSFONT=latarcyrheb-sun16 crashkernel=auto KEYBOARDTYPE=pc KEYTABLE=us rd_NO_DM rhgb quiet enforcing=0

4)重启hadoop102、hadoop103、hadoop104主机

[root@hadoop102 ~]# reboot

[root@hadoop103 ~]# reboot

[root@hadoop104 ~]# reboot

CM安装部署

-

CM下载地址

1)CM下载地址:http://archive.cloudera.com/cm5/cm/5/

2)离线库下载地址:http://archive.cloudera.com/cdh5/parcels -

CM安装

-

启动CM服务

1)启动服务节点:hadoop102

[root@hadoop102 cm]#

/opt/module/cm/cm-5.12.1/etc/init.d/cloudera-scm-server start Starting

cloudera-scm-server: [确定]

2)启动工作节点:hadoop102、hadoop103、hadoop104

[root@hadoop102 cm]#

/opt/module/cm/cm-5.12.1/etc/init.d/cloudera-scm-agent start[root@hadoop103 cm]#

/opt/module/cm/cm-5.12.1/etc/init.d/cloudera-scm-agent start[root@hadoop104 cm]#

/opt/module/cm/cm-5.12.1/etc/init.d/cloudera-scm-agent start

注意:启动过程非常慢,Manager启动成功需要等待5分钟左右,过程中会在数据库中创建对应的表需要耗费一些时间。

3)查看被占用则表示安装成功了!!!

[root@hadoop102 cm]# netstat -anp | grep 7180 tcp 0 0

0.0.0.0:7180 0.0.0.0:* LISTEN 5498/java

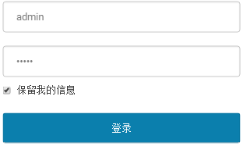

4)访问http://hadoop102:7180,(用户名、密码:admin)

关闭CM服务

1)关闭工作节点:hadoop102、hadoop103、hadoop104

[root@hadoop102 cm]#

/opt/module/cm/cm-5.12.1/etc/init.d/cloudera-scm-agent stop Stopping

cloudera-scm-agent: [确定] [root@hadoop103

cm]# /opt/module/cm/cm-5.12.1/etc/init.d/cloudera-scm-agent stop

Stopping cloudera-scm-agent: [确定]

[root@hadoop104 cm]#

/opt/module/cm/cm-5.12.1/etc/init.d/cloudera-scm-agent stop Stopping

cloudera-scm-agent: [确定]

2)关闭服务节点:hadoop102

[root@hadoop102 cm]#

/opt/module/cm/cm-5.12.1/etc/init.d/cloudera-scm-server stop 停止

cloudera-scm-server: [确定]

CM的集群部署

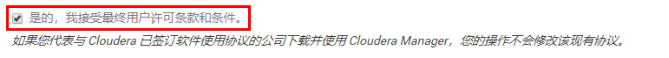

接受条款和协议

选择免费

指定主机

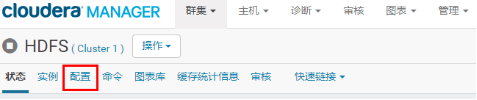

配置Hadoop支持LZO

找到远程Parcel存储库URL,点击最后一栏的加号,增加一栏,输入http://archive.cloudera.com/gplextras/parcels/latest/,之后点击保存更改

返回Parcel列表,可以看到多出了LZO,选择下载,下载完成后选择分配,分配完成后选择激活。

安装完LZO后,打开HDFS配置,找到“压缩编码解码器”一栏,点击加号,添加com.hadoop.compression.lzo.LzopCodec后保存更改

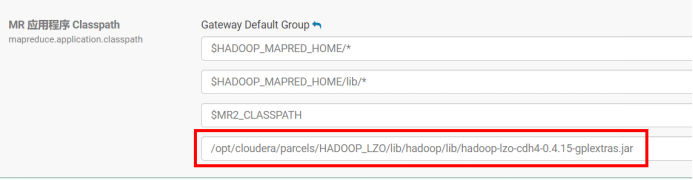

打开YARN配置,找到MR 应用程序 Classpath,添加/opt/cloudera/parcels/HADOOP_LZO/lib/hadoop/lib/hadoop-lzo-cdh4-0.4.15-gplextras.jar

更新过期配置,重启进程

Flume安装

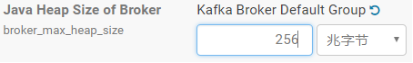

Kafka安装

1)在hadoop102上创建/opt/cloudera/csd目录

[root@hadoop102 parcel-repo]# mkdir -p /opt/cloudera/csd

2)上传KAFKA-1.2.0.jar到/opt/cloudera/csd目录,并修改所有者和所有者的组

[root@hadoop102 cloudera]# chown cloudera-scm:cloudera-scm

/opt/cloudera/csd/ -R

3)上传KAFKA-4.0.0-1.4.0.0.p0.1-el6.parcel、KAFKA-4.0.0-1.4.0.0.p0.1-el6.parcel.sha1到/opt/cloudera/parcel-repo目录,并修改KAFKA-4.0.0-1.4.0.0.p0.1-el6.parcel.sha1名称为KAFKA-4.0.0-1.4.0.0.p0.1-el6.parcel.sha

[root@hadoop102 parcel-repo]# mv

/opt/cloudera/parcel-repo/KAFKA-4.0.0-1.4.0.0.p0.1-el6.parcel.sha1

/opt/cloudera/parcel-repo/KAFKA-4.0.0-1.4.0.0.p0.1-el6.parcel.sha

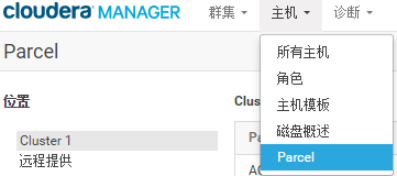

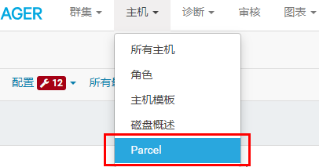

4)ClouderManager中选择Parcel->检查Parcel->Kafka点击分配->激活

5)ClouderManager中选择Parcel->检查Parcel->Kafka点击分配->激活

找到Kafka点击下载,下载完成后点击分配进行分配,然后点击激活,出现已分配,已激活则证明分配激活成功