一般由于多次格式化NameNode导致。在配置文件中保存的是第一次格式化时保存的NameNode的ID,因此就会造成NataNode与NameNode之间的id不一致

如果启动Hadoop后用jps命令发现DataNode节点未启动则有可能是多次格式化的问题

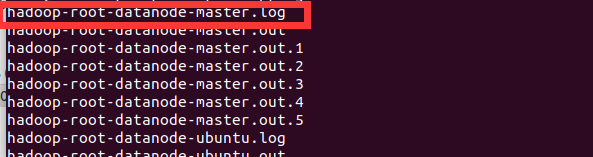

首先查看DataNode节点的日志

路径如下(其中hadoop为自己hadoop的安装路径)

hadoop/logs/hadoop-root-datanode-master.log

如果有clusterIDs不匹配的记录则就是这个问题,这个时候要记下namenode clusterID

然后找到自己配置的hadoop中DataNode节点信息存放的位置(如果不记得了建议直接查找该文件find / -name VERSION)

我的是在

hadoop/tmp/dfs/data/current

然后编辑该目录下的VERSION文件

将clusterID换成刚刚在日志中复制的,重启Hadoop,然后DataNode节点就可以正常启动了