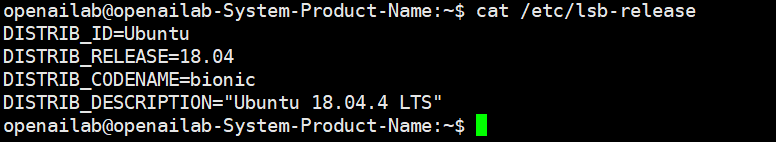

Ubuntu版本信息:

cat /etc/lsb-release

1、创建部署用户

创建一个用户,非root用户即可,创建用户示例:

# 创建用户

sudo useradd -d /home/yeqinfang -m yeqinfang

sudo passwd yeqinfang

# 赋予免密sudo权限,可以不执⾏

echo "yeqinfang ALL = (root) NOPASSWD:ALL" | sudo tee /etc/sudoers.d/yeqinfang

sudo chmod 0440 /etc/sudoers.d/yeqinfang

# ⽤户使⽤bash shell,否则⽤户没有代码补全功能

sudo chmod 0440 /etc/sudoers.d/yeqinfang

sudo chsh -s /bin/bash yeqinfang

# 切换⽤户到部署⽤户

su openailab

cd ~

2、安装 python 和 pip3

后⾯安装的rknn指定了python版本,必须使⽤python3.6的版本

sudo apt-get update && sudo apt-get install python3.6 python3-pip

sudo ln -s /usr/bin/python3.6 /usr/bin/python3

sudo ln -s /usr/bin/pip3 /usr/bin/pip

# 如果不能安装,再安装apt源

# sudo add-apt-repository ppa:jonathonf/python-3.6

# sudo apt-get update

# 验证,确认

python3

# 指定国内安装源,可以加速依赖库安装

mkdir ~/.pip

vim ~/.pip/pip.conf

# 增加内容

[global]

index-url = http://mirrors.aliyun.com/pypi/simple/

[install]

trusted-host=mirrors.aliyun.com

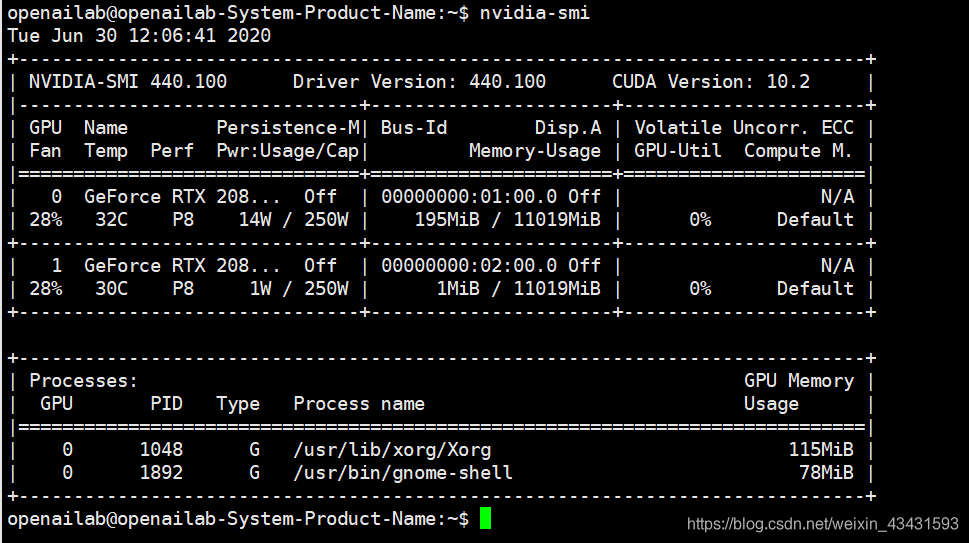

3、安装nvidia 驱动、cuda、cudnn

1、安装nvidia驱动:

官方下载:https://www.nvidia.cn/Download/index.aspx?lang=cn

# 添加PPA

sudo add-apt-repository ppa:graphics-drivers/ppa

sudo apt-get update

# ⾃动安装

sudo ubuntu-drivers devices

sudo ubuntu-drivers autoinstall

# 如果需要安装指定版本,可以使⽤下⾯的⽅法

# 通过<Tab>查找Y新的 驱动!我的显卡是2080Ti ,需要到官方查看,安装哪个驱动

# sudo apt-get install nvidia-driver-<Tab>

# 安装你需要的驱动

# $ sudo apt-get install nvidia-driver-435 nvidia-settings

# 重启

reboot

# 输⼊指令查看是否有信息输出,确保是否正确安装

nvidia-smi

安装完成之后,需要禁止系统更新,确保后续驱动不会自动更新。

2、安装cuda和cudnn:

CUDA官方下载地址:https://developer.nvidia.com/cuda-downloads?target_os=Linux&target_arch=x86_64&target_distro=Ubuntu&target_version=1604&target_type=runfilelocal

CUDNN官方下载地址:https://developer.nvidia.com/rdp/cudnn-download

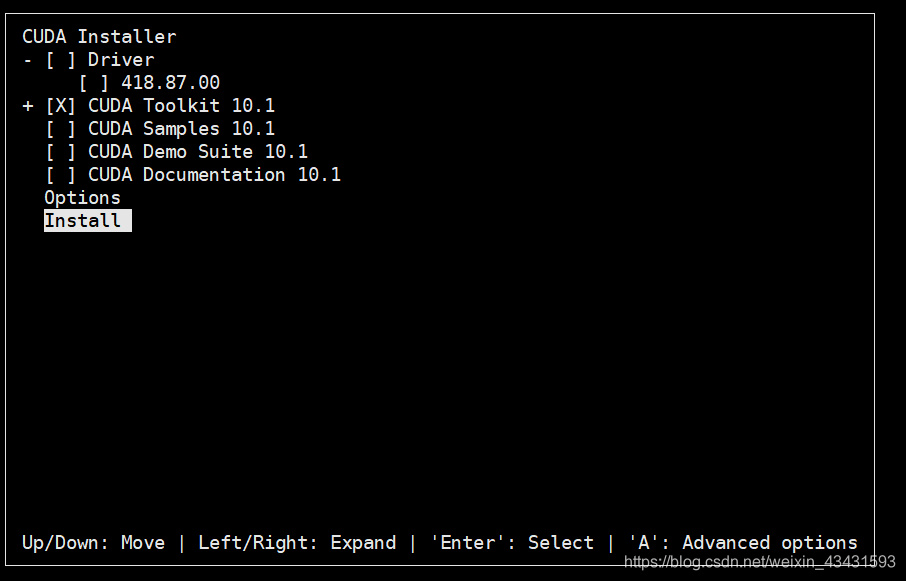

(1)安装CUDA

# 下载安装包

wget http://developer.download.nvidia.com/compute/cuda/10.1/Prod/local_installers/cuda_10.1.243_418.87.00_linux.run

# 给⽂件赋予执⾏权限:

chmod +x cuda_10.1.243_418.87.00_linux.run

# 执行安装包:

sudo ./cuda_10.0.130_410.48_linux.run

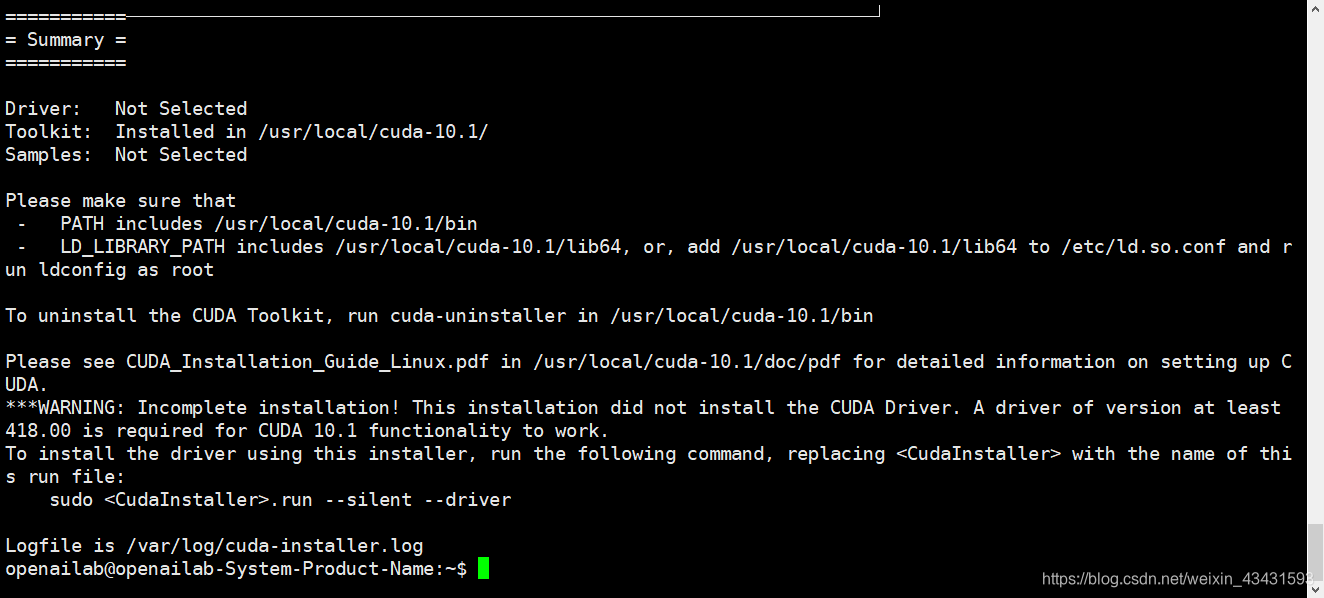

运行之后,安装只选中Tool,如下图:

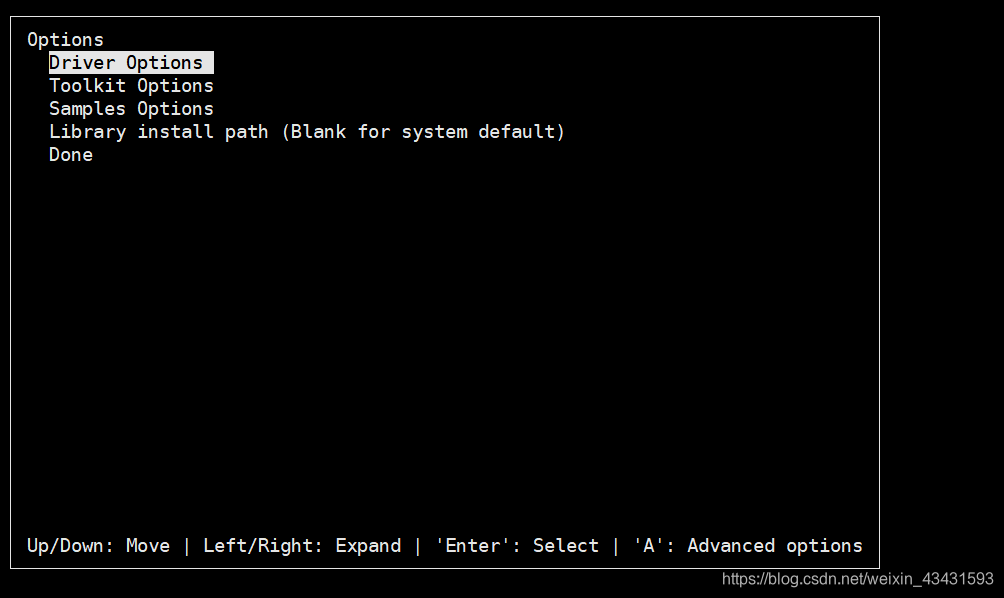

安装前可以查看一下选项,查看选项如图:

安装前可以查看一下选项,查看选项如图:

Done回车之后,就可以安装了,如下:

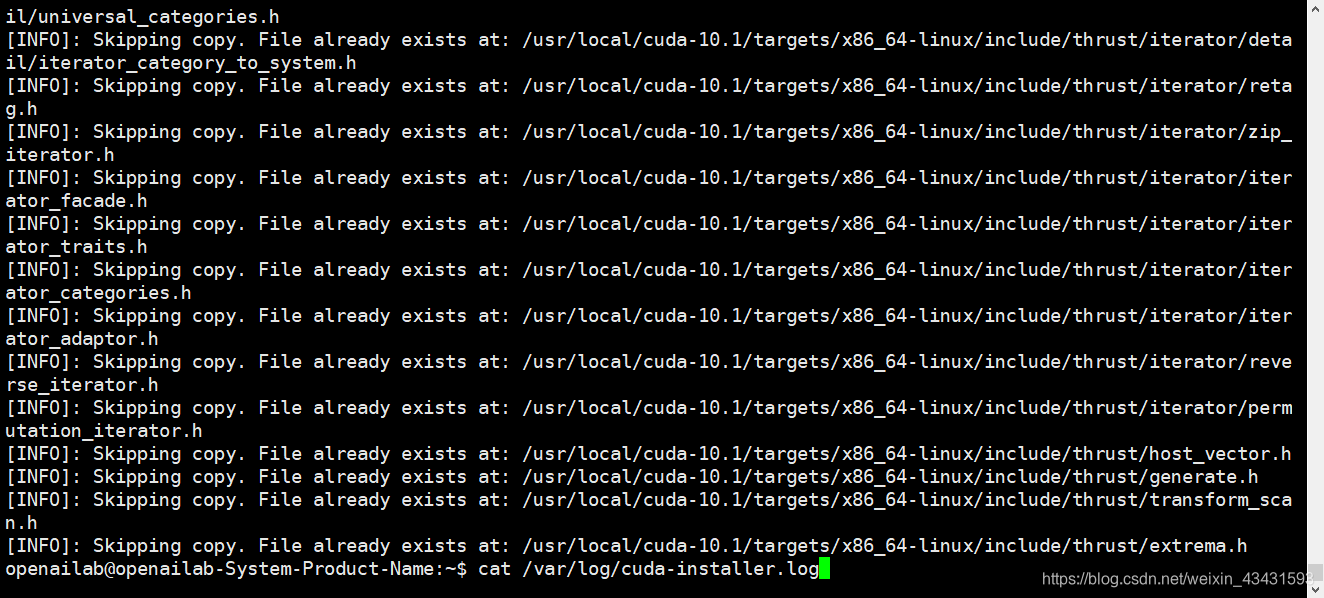

根据提示查看日志:

上面的报错说的是文件存在,所以跳过,所以现在继续吧,没有问题!

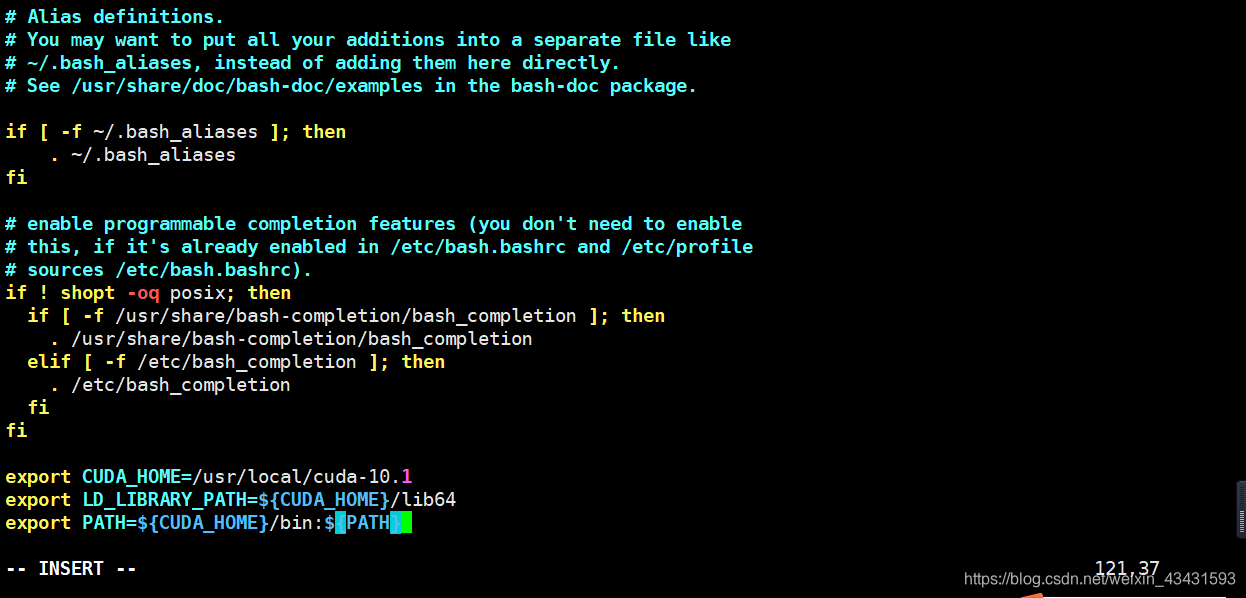

# 安装完成之后,可以配置他们的环境变量,在vim ~/.bashrc的最后加上以下配置信息(路径根据实际情况配置):

export CUDA_HOME=/usr/local/cuda-10.1

export LD_LIBRARY_PATH=${CUDA_HOME}/lib64

export PATH=${CUDA_HOME}/bin:${PATH}

# 最后使⽤命令source ~/.bashrc使它⽣效。

source ~/.bashrc

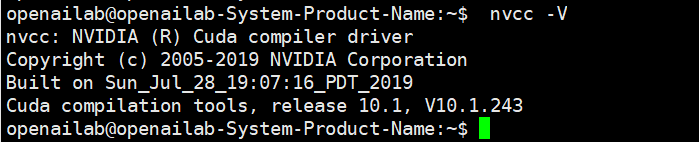

查看版本信息:

查看版本信息:

nvcc -V

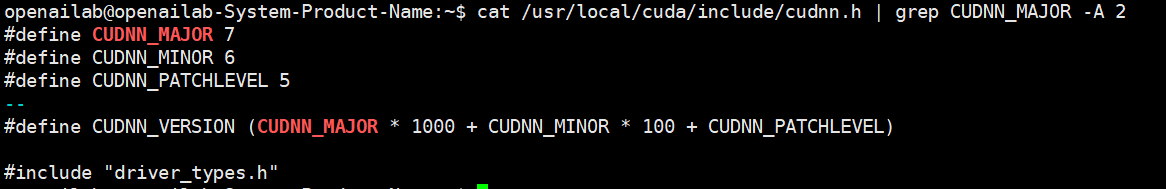

如上,cuda安装成功。

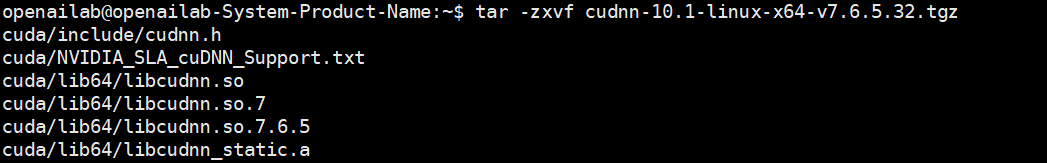

(2)安装CUDNN

# 安装cudnn

# 先它进⾏解压,命令如下

tar -zxvf cudnn-10.1-linux-x64-v7.6.5.32.tgz

# 使⽤以下两条命令复制这些⽂件到CUDA⽬录下:

sudo cp cuda/lib64/* /usr/local/cuda-10.1/lib64/

sudo cp cuda/include/* /usr/local/cuda-10.1/include/

# 拷⻉完成之后,可以使⽤以下命令查看CUDNN的版本信息:

cat /usr/local/cuda/include/cudnn.h | grep CUDNN_MAJOR -A 2

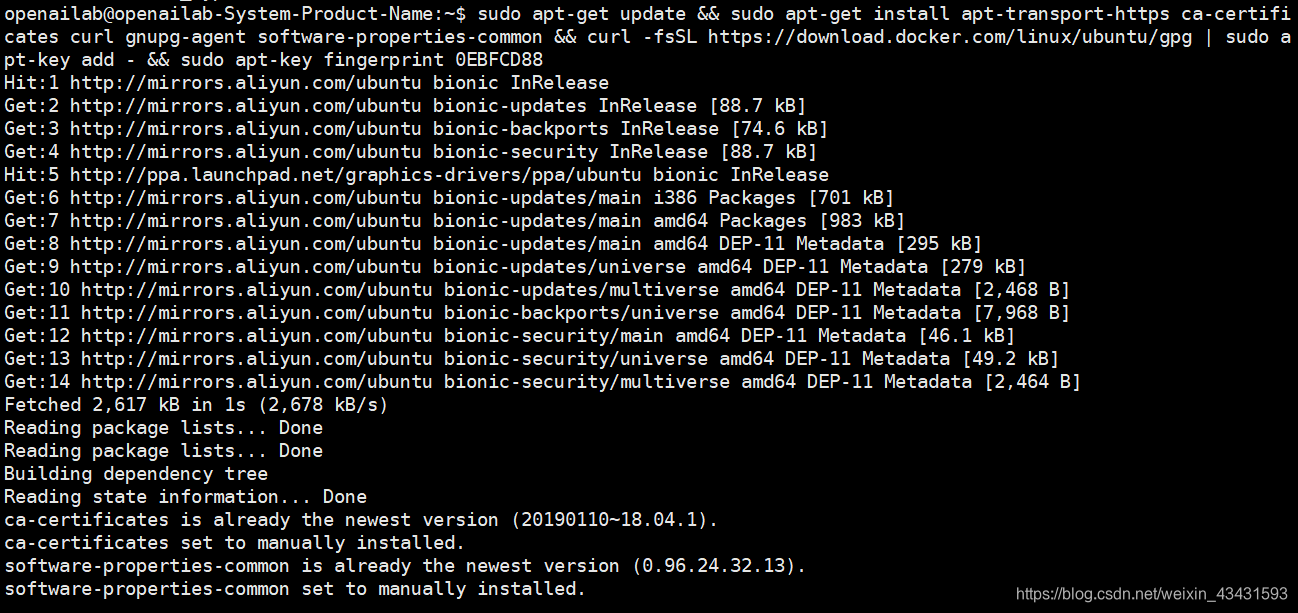

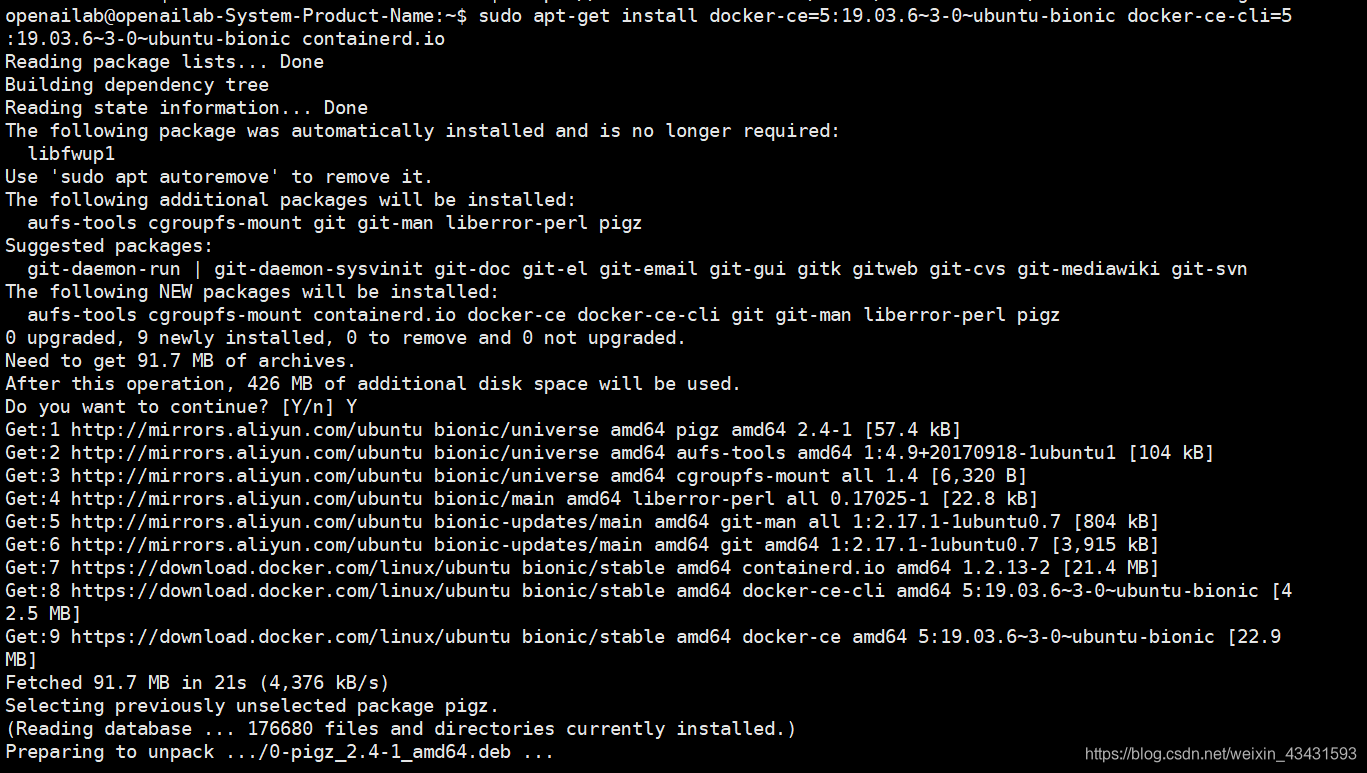

4、安装Docker

需要安装指定的docker版本 19.03.6:

sudo apt-get update && sudo apt-get install apt-transport-https ca-certificates curl gnupg-agent software-properties-common && curl -fsSL https://download.docker.com/linux/ubuntu/gpg | sudo apt-key add - && sudo apt-key fingerprint 0EBFCD88

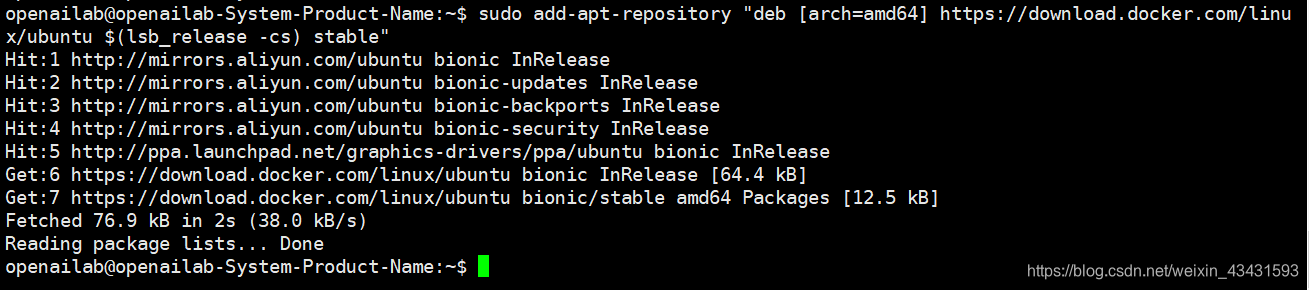

sudo add-apt-repository "deb [arch=amd64] https://download.docker.com/linux/ubuntu $(lsb_release -cs) stable"

# 查询指定可安装的docker版本

apt-cache madison docker-ce

apt-cache madison docker-ce-cli

# 如果系统是ubuntu18.04可直接使⽤以下命令安装,

# ubuntu其他版本可以⽤上⾯的命令先查看可安装的命令

sudo apt-get install docker-ce=5:19.03.6~3-0~ubuntu-bionic docker-ce-cli=5:19.03.6~3-0~ubuntu-bionic containerd.io

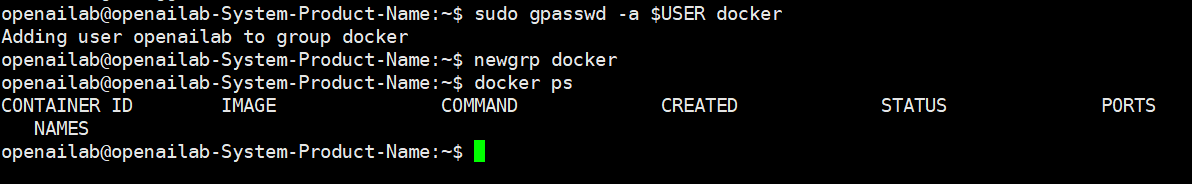

# 将当前⽤户加⼊docker⽤户组

sudo gpasswd -a $USER docker

# 更新⽤户组

newgrp docker

#有成功输出则说明安装成功

docker ps

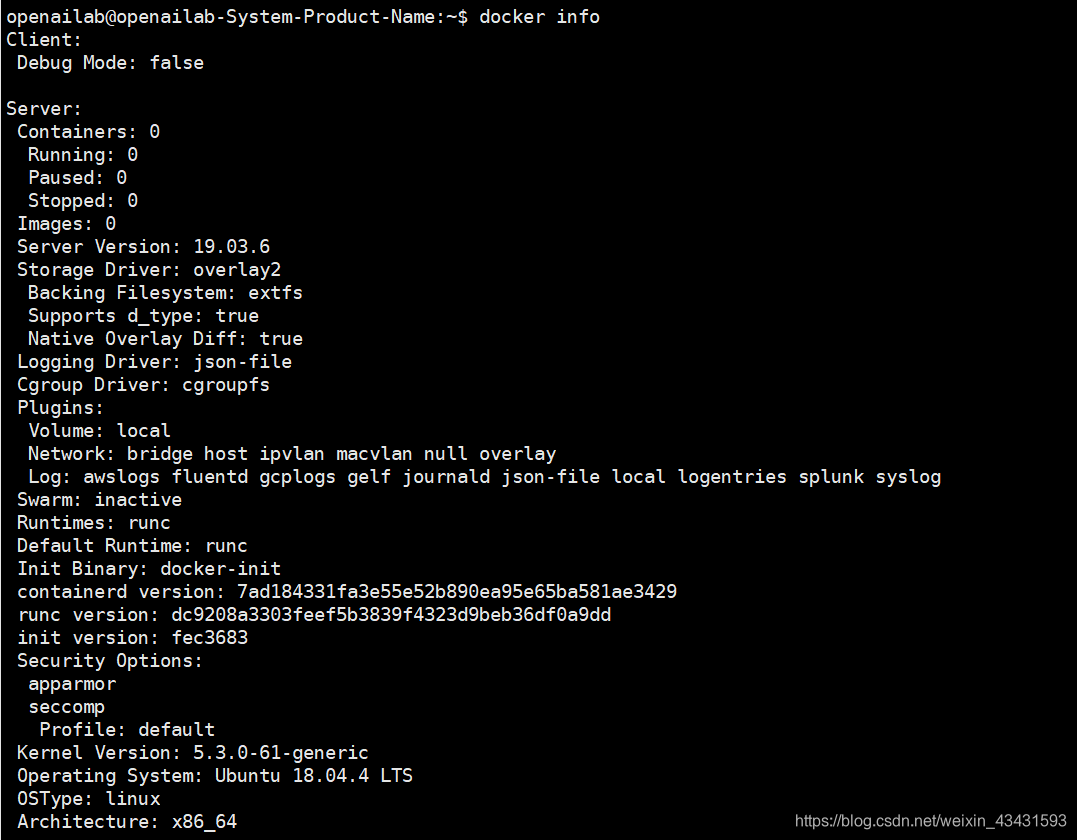

# 注意以下内容⼀般是不⽤操作

# 查看docker info

docker info

# 如果默认的docker⽬录存储⼤⼩不够,想重新指定docker存储⽬录,则修改⽂件:

vim /lib/systemd/system/docker.service

# From:

ExecStart=/usr/bin/dockerd -H fd://

# To: Add --data-root parameter

ExecStart=/usr/bin/dockerd -H fd:// --data-root="/data/docker-files"

# 重启Docker Servicer

systemctl daemon-reload

systemctl restart docker

# 确认是否修改成功

docker info

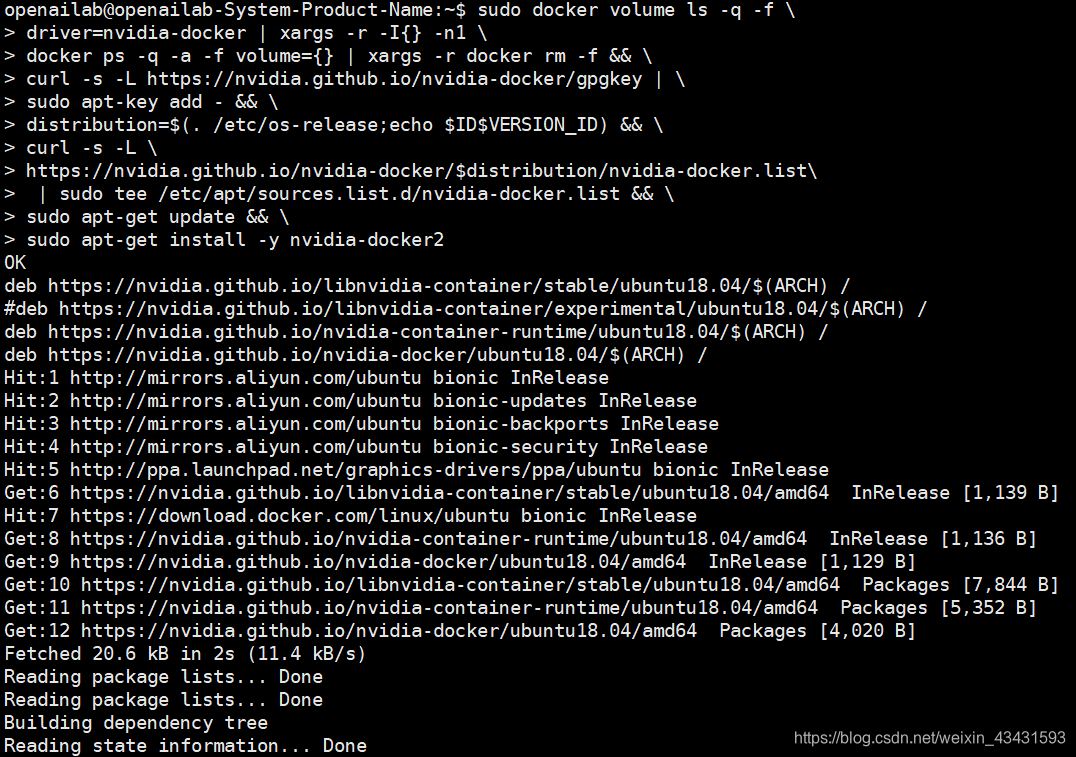

5、安装nvidia-docker

sudo docker volume ls -q -f \

driver=nvidia-docker | xargs -r -I{} -n1 \

docker ps -q -a -f volume={} | xargs -r docker rm -f && \

curl -s -L https://nvidia.github.io/nvidia-docker/gpgkey | \

sudo apt-key add - && \

distribution=$(. /etc/os-release;echo $ID$VERSION_ID) && \

curl -s -L \

https://nvidia.github.io/nvidia-docker/$distribution/nvidia-docker.list\

| sudo tee /etc/apt/sources.list.d/nvidia-docker.list && \

sudo apt-get update && \

sudo apt-get install -y nvidia-docker2

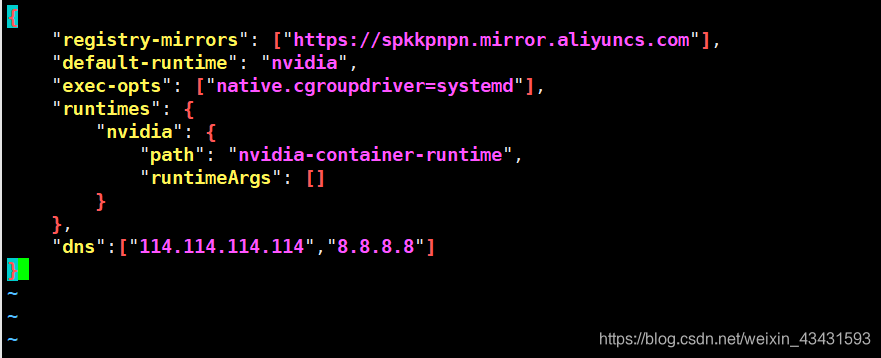

修改配置文件:

sudo vi /etc/docker/daemon.json

# 内容如下:

{

"registry-mirrors": ["https://spkkpnpn.mirror.aliyuncs.com"],

"default-runtime": "nvidia",

"exec-opts": ["native.cgroupdriver=systemd"],

"runtimes": {

"nvidia": {

"path": "nvidia-container-runtime",

"runtimeArgs": []

}

},

"dns": ["114.114.114.114", "8.8.8.8"]

}

# 保存后重新加载docker daemon

sudo systemctl daemon-reload

sudo systemctl restart docker

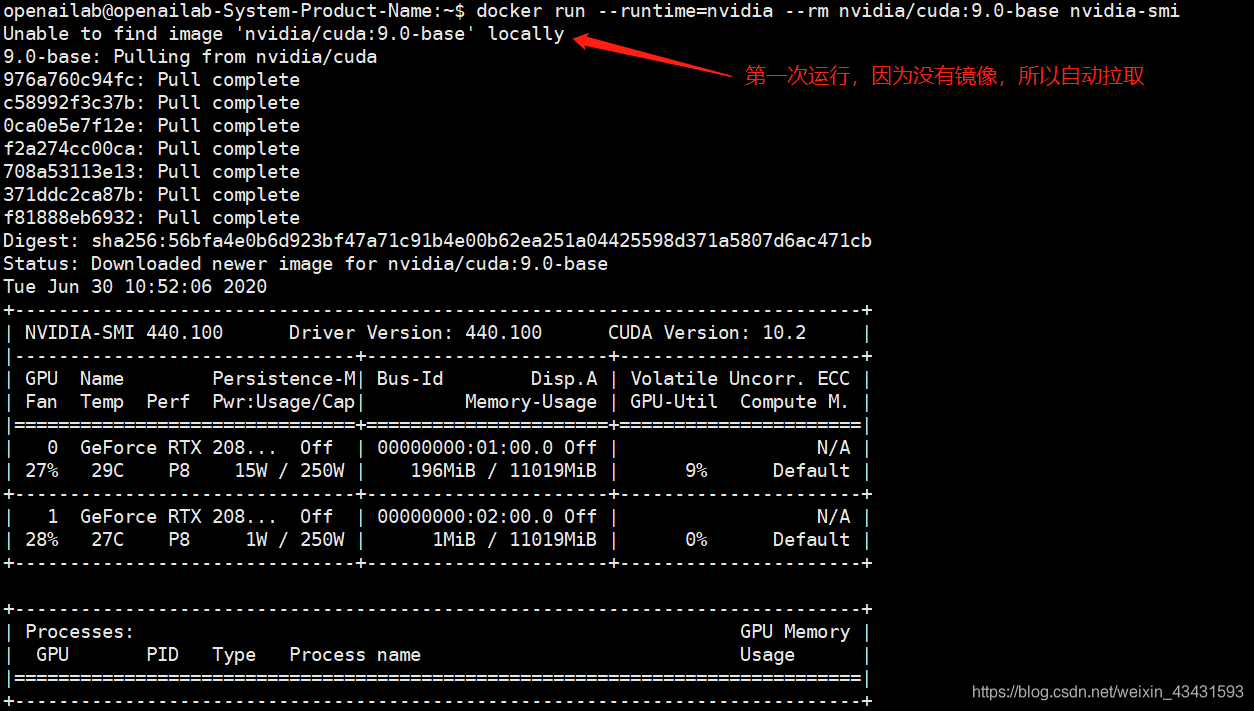

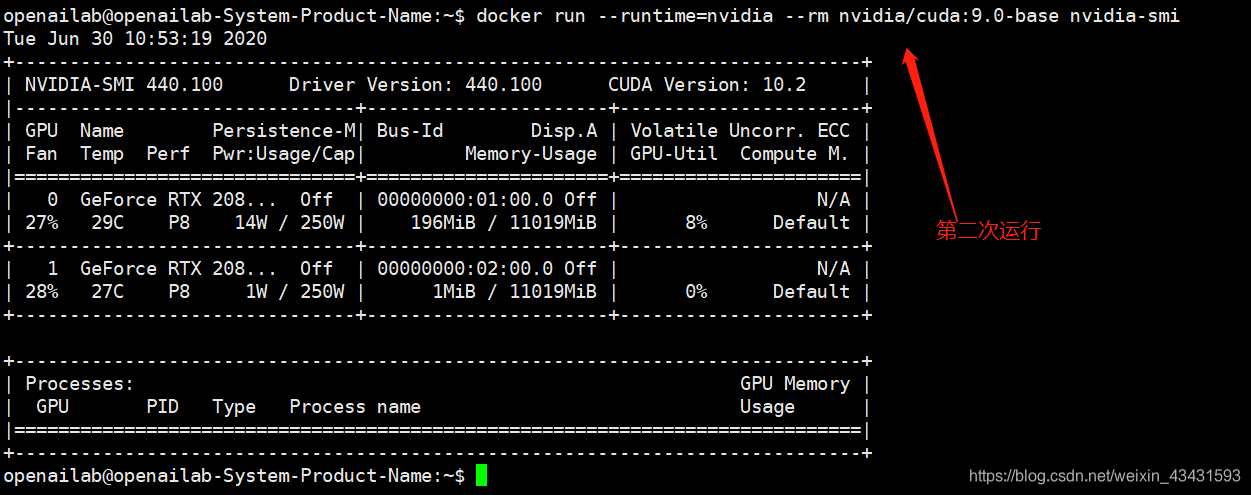

# 验证从docker中可以调⽤nvidia,在有gpu环境的机器下验证

docker run --runtime=nvidia --rm nvidia/cuda:9.0-base nvidia-smi

如上,出现这个结果,说明docker可以调⽤GPU了。可喜可贺。

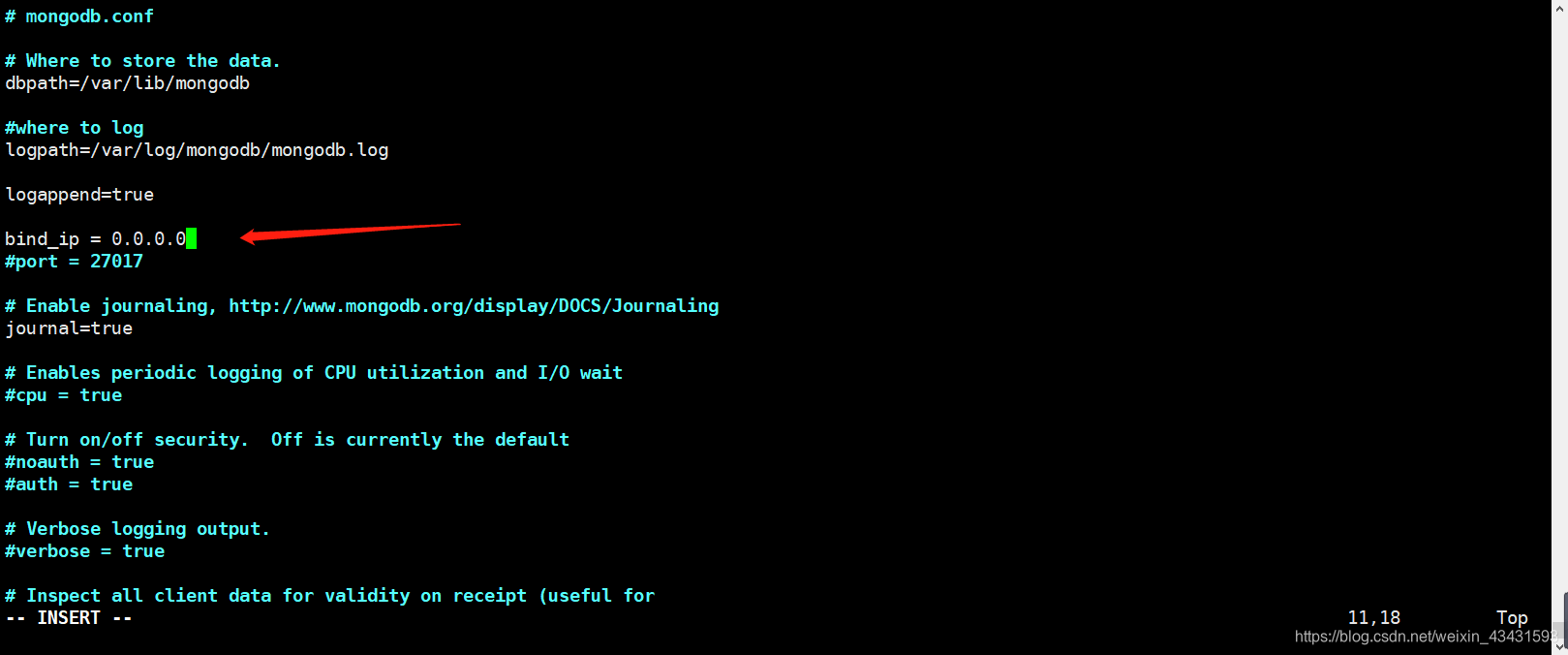

6、安装 Mongodb、unrar、nfs-common、g++aarch64-linux-gnu

sudo apt-get install mongodb unrar nfs-common g++-aarch64-linux-gnu sox

# 修改mongodb的访问权限

sudo vi /etc/mongodb.conf

# 输入内容

bind_ip=0.0.0.0

# 重启mongodb

sudo systemctl restart mongodb.service

7、安装Tvm

# 下载tvm源码

git clone --recursive https://github.com/apache/incubator-tvm tvm

# 安装相关⼯具

sudo apt-get update && sudo apt-get install -y python3 python3-dev python3-setuptools gcc libtinfo-dev zlib1g-dev build-essential cmake libedit-dev libxml2-dev

# 安装LLVM

sudo bash -c "$(wget -O - https://apt.llvm.org/llvm.sh)"

# 复制配置并修改

cd tvm

mkdir build

cp cmake/config.cmake build

# 修改配置,Change set(USE_LLVM OFF) to set(USE_LLVM ON)

sudo vi ./build/config.cmake

# 修改内容

set(USE_LLVM ON)

# build tvm and related libraries.

cd build

cmake ..

make -j4

# 安装编译出来的tvm python库,安装到python3

cd tvm

cd python; sudo python3 setup.py install; cd ..

cd topi/python; sudo python3 setup.py install; cd ..

# 安装python依赖库

sudo apt install antlr4

sudo pip3 install numpy decorator attrs tornado mypy orderedset antlr4-python3-runtime

# 验证

python3

# 进⼊交互模式,输⼊⼀下内容导⼊tvm

import tvm

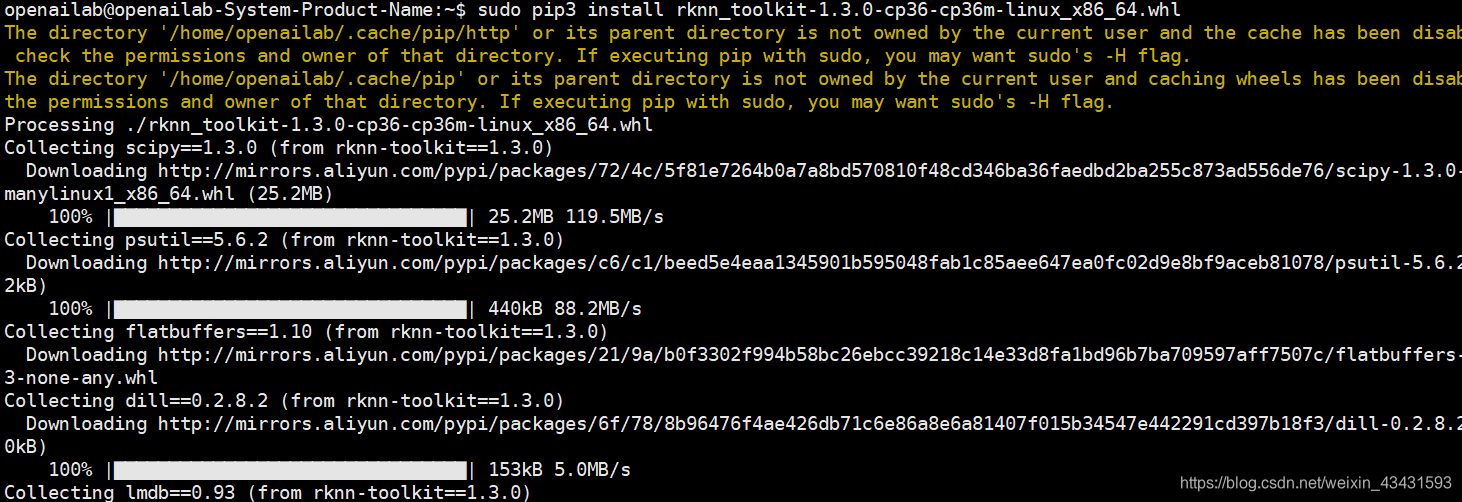

8、安装 rknn python库

下载地址:https://gitee.com/david12/rknn-toolkit

# ⽂件rknn_toolkit-1.3.0-cp36-cp36m-linux_x86_64.whl

sudo pip3 install rknn_toolkit-1.3.0-cp36-cp36m-linux_x86_64.whl

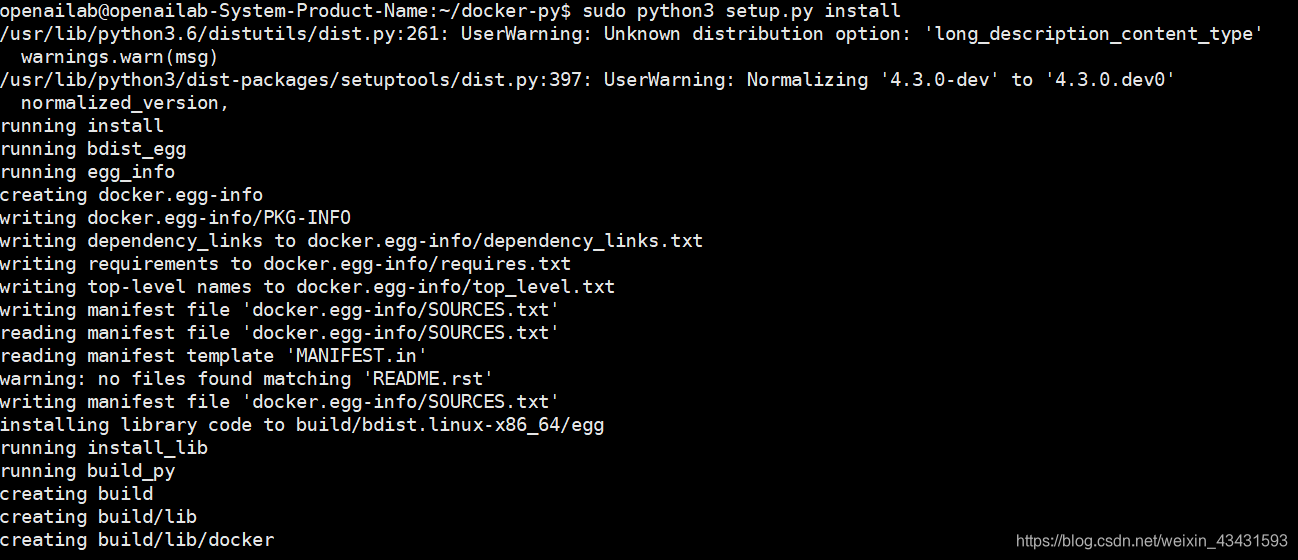

9、安装 docker-py python 库

git clone https://github.com/teklia/docker-py.git

cd docker-py

# 切换到device-device分⽀

git checkout device-requests

sudo python3 setup.py install

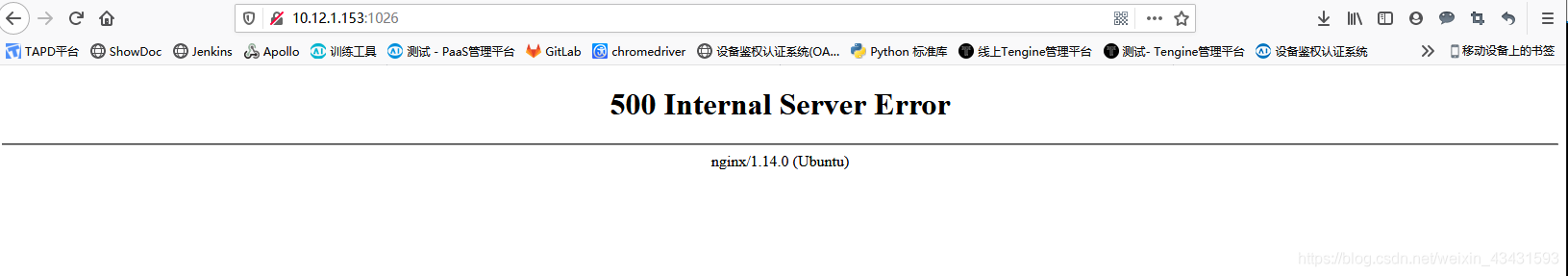

10、安装 Nginx,并复制前端代码

# 将提供的dist.zip(我司前端文件)放到⽬录/home/openailab

# 解压dist.zip

unzip dist.zip -x

# 可以看到多出来⼀个/home/openailab/dist⽬录

# 安装nginx

sudo apt-get install nginx

# 修改配置,设置前端⻚⾯

sudo vi /etc/nginx/sites-enabled/default

# 修改内容

# (根据实际需求进行修改即可)

sudo service nginx restart

# 访问配置的端口,如:http://xx.xx.xx.xx:1026

11、拉取相关 Docker镜像

docker login --username=[email protected] registry.xxxxxxxxxx.aliyuncs.com

docker pull xxxxxxxxx

docker tag xxxxxxxxx