一. 朴素贝叶斯的学习与分类

1.1 贝叶斯定理

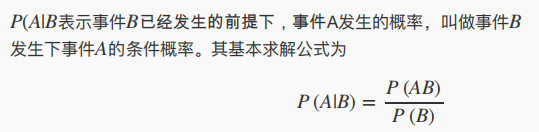

1.条件概率

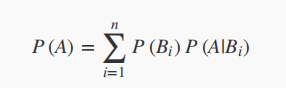

2.全概率公式:若对事件A进行一个划分,可以将其划分成若干个Bi子集,且直到A在各个子集出现的条件概率和每个子集本身出现的概率:

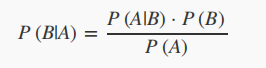

3.贝叶斯定理:通过结论来推知条件,可以使用条件概率的定义式推导得到。

分母处的P(A)往往会代换成全概率公式

1.2 特征条件独立假设

特征条件独立假设是一个较强的假设,所以这样得到的贝叶斯定理称为朴素贝叶斯定理。

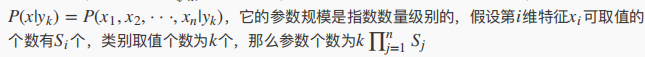

特征条件独立假设主要是为了解决参数成指数增长过多的问题。

1.朴素贝叶斯的问题描述:(多分类举例)

给定训练数据集(X,Y),其中每个样本X都包括n维样本,即x=(x1,x2,…,xn),类型标记含有k种类别,及y=(y1,y2…,yk)

现在需要对给定的一个新样本向量x进行分类,从概率的角度,我们需要找到x在哪个类别下计算出来的概率值是最大的。

问题转化:

arg max(yk) P(yk|x)

2.问题求解:

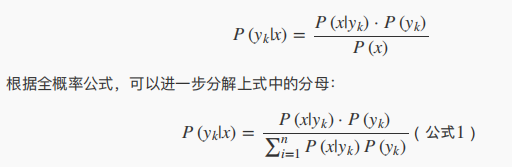

关键在于求解各个类别yj对应的条件概率,即使用贝叶斯公式

先不考虑分母,因为分母是使用的全概率公式,每个p(yk|x)的分母值都是一样的,在最大化求解过程中可以省去对分母的考虑。

分子部分的P(yk)是先验概率,根据训练集可以统计计算。

3.特征条件独立假设

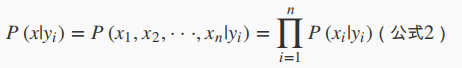

朴素贝叶斯算法对条件概率做了独立性的假设,通俗来说就是假设各个维度的特征x1,x2,…xn互相独立,由此条件概率的求解可以转化为:

4.朴素贝叶斯模型的最终数学表示

二.朴素贝叶斯法的参数估计

2.1 极大似然估计

0. 背景:

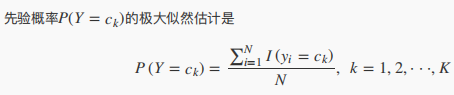

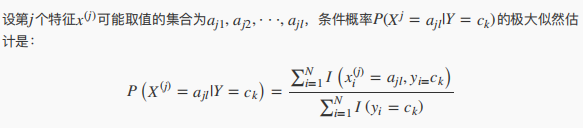

由上面给出的朴素贝叶斯分类器的数学表达式可知,要想用贝叶斯的思想进行分类,关键是要把先验概率P(Y=ck)和P(Xj=ajl|Y=ck)。应用极大似然估计得到上述的概率值,就是参数估计的一种方法。所谓参数估计,就是用样本来推断模型的参数,或者通过计算求解使得似然函数最大的参数值。

1.结论

扫描二维码关注公众号,回复: 11596625 查看本文章

2.直观理解

根据得到的数据集,利用频率值来估计概率值。

3.推导

2.2 贝叶斯估计

背景:

最大似然估计有一个隐患,假设训练数据中没有出现某种参数和类别,那么在利用最大似然估计的时候很有可能导致某种类别出现的先验概率逼近或等于0,但实际上真实数据中是可能出现这样的参数组合的。

此时影响后验概率的计算结果,使分类产生偏差。

写在后面

贝叶斯进行一些基本的分类还是很好用的,等把代码实现了会补在博客里。

参考文档:

《统计学习方法》 李航

某不知名pdf文档