文章目录

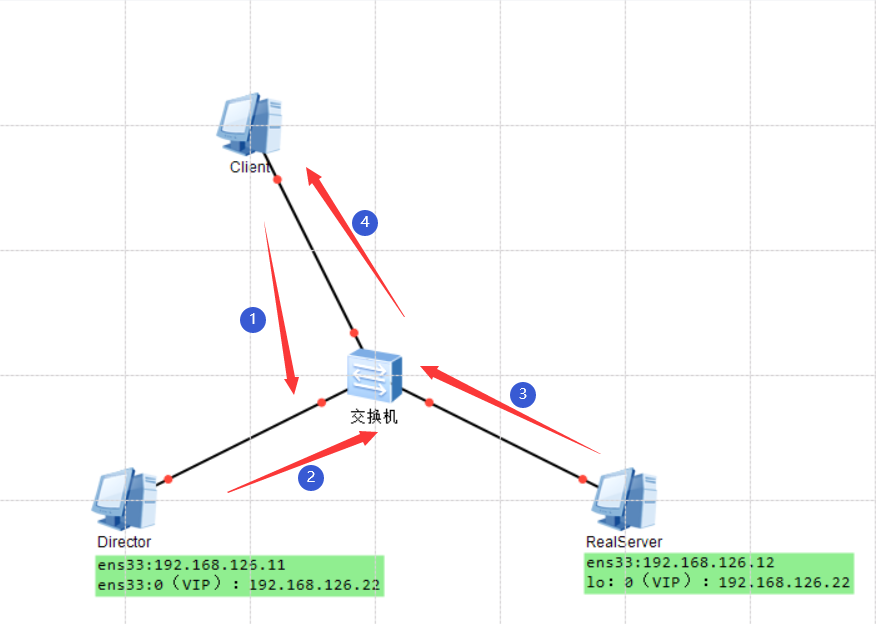

一、LVS-DR 数据包流向分析

为方便进行原理分析,将 Client 与群集机器放在同一网络中,数据包流经的路线为 1-2-3-4

- Client 向目标 VIP 发出请求,Director(负载均衡器)接收

- 此时源 MAC 地址为 Client 的 MAC 地址

- 目标 MAC 地址为调度器 Director 的 MAC 地址

- Director 根据负载均衡算法选择 RealServer

- 不修改也不封装 IP 报文,而是将数据帧的 MAC 地址改为 RealServer 的 MAC 地址,然后在局域网上发送

- 此时源 MAC 地址为 Director 的 MAC 地址,目的 MAC 地址为 RealServer 的 MAC 地址

- RealServer 收到这个帧

- 解封装后发现目标 IP 与本机匹配(RealServer 事先绑定了 VIP),于是处理这个报文

- 随后重新封装报文,将响应报文通过 lo 接口传送给物理网卡然后向外发出

- 此时源 MAC 地址为 RealServer 的 MAC 地址,目的 MAC 地址为 Client 的 MAC 地址

- Client 将收到回复的报文

- Client 认为得到正常的服务,而不会知道是哪一台服务器处理的

- 注意:如果跨网段,则报文通过路由器会经由 Internet 返回给用户

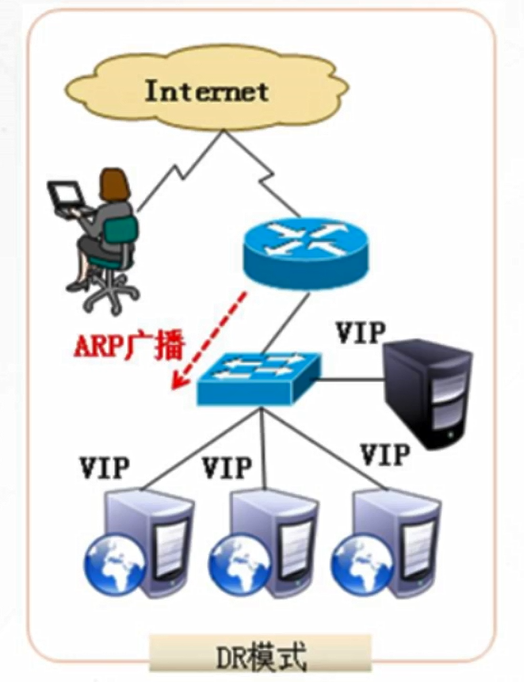

二、LVS-DR 中的 ARP 问题

在LVS-DR负载均衡集群中,负载均衡与节点服务器都要配置相同的VIP地址

- 但在局域网中具有相同的 IP 地址,势必会造成各服务器 ARP 通信的紊乱:

- 当 ARP 广播发送到 LVS-DR 集群时,因为负载均衡器和节点服务器都是连接到相同网络上,它们都会接收到 ARP 广播

- 只有前端的负载均衡器进行响应,其他节点服务器不应该响应 ARP 广播

- 这时,我们可以对节点服务器进行处理,使其不响应针对 VIP 的 ARP 请求:

- 使用虚接口 lo:0 承载 VIP 地址

- 设置内核参数 arp_ignore=1(系统只响应目的 IP 为本地 IP 的 ARP 请求)

- RealServer 返回报文(源 IP 是 VIP)经路由器转发,重新封装报文时,需要先获取路由器的 MAC 地址

- 且发送 ARP 请求时,Linux 默认使用 IP 包的源 IP 地址(即 VIP)作为 ARP 请求包中的源 IP 地址,而不使用发送接口的 IP 地址

- 路由器收到 ARP 请求后,将更新 ARP 表项

- 原有的 VIP 对应 Director 的 MAC 地址会被更新为 VIP 对应 RealServer 的 MAC 地址

而路由器根据 ARP 表项,会将新来的请求报文转发给 RealServer,导致 Director 的 VIP 失效上述问题的解决方法:

对节点服务器进行处理,设置内核参数 arp_announce=2(系统不使用 IP 包的源地址来设置 ARP 请求的源地址,而选择发送接口的 IP 地址)

- 解决ARP的两个问题的方法

#修改 /etc/sysctl.conf 文件

net.ipv4.conf.lo.arp_ignore=1

net.ipv4.conf.lo.arp_announce=2

net.ipv4.conf.all.arp_ignore=1

net.ipv4.conf.all.arp_announce=2

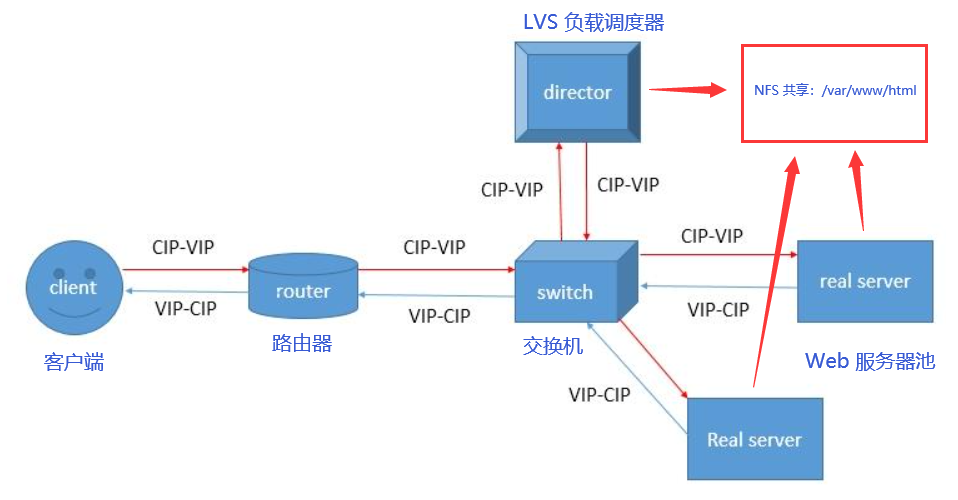

三、LVS 负载均衡群集-DR模式

1.数据包流量分析

- 客户端发送请求到 Director Server (负载均衡器),请求的数据报文(源 IP 是 CIP, 目标IP是 VIP)到达内核空间

- Director Server 和 Real Server 在同一个网络中,数据通过二层数据链路层来传输

- 内核空间判断数据包的目标 IP 是本机 VIP,此时 IPVS (IP 虚拟服务器)比对数据包请求的服务是否是集群服务,是集群服务就重新封装数据包。修改源 MAC 地址为 Director Server 的 MAC 地址,修改目标 MAC 地址为 Real Server 的 MAC 地址,源 IP 地址与目标 IP 地址没有改变,然后将数据包发送给 Real Server

- 到达 Real Server 的请求报文的 MAC 地址是自身的 MAC 地址,就接收此报文;数据包重新封装报文(源 IP 地址为 VIP,目标 IP 为 CIP),将响应报文通过 lo 接口传送给物理网卡然后向外发出

- Real Server 直接将响应报文传送到客户端

2.DR 模式的特点

- Director Server 和 Real Server 必须在同一个物理网络中

- Real Server 可以使用私有地址,也可以使用公网地址;如果使用公网地址,可以通过互联网对 RIP 进行直接访问

- Director Server 作为群集的访问入口,但不作为网关使用

- 所有的请求报文经由 Director Server,但回复响应报文不能经过 Director Server

- Real Server 的网关不允许指向 Director Server IP,即 Real Server 发送的数据包不允许经过 Director Server

- Real Server 上的 lo 接口配置 VIP 的 IP 地址

四、部署 LVS-DR 负载均衡集群

1.概述

- 在 DR 模式的群集中,LVS 负载调度器作为群集的访问入口,但不作为网关使用

- 服务器池中的所有节点都各自接入 Internet,发送给客户机的 Web 响应数据包不需要经过 LVS 负载调度器

- 这种方式入站、出站访问数据被分别处理,因此 LVS 负载调度器和所有节点服务器都需要配置有 VIP 地址,以便响应应对整个群集的访问

- 考虑到数据存储的安全性,共享存储设备会放在内部的专用网络内

2.环境

- 宿主机:Win10 专业工作站版本

- VMware:16 Pro(16.1.0)

- CentOS 7

- 网络适配器:均为 NAT 模式

- 网卡配置:均为静态获取 IP

- YUM 源:本地

- Win客户端:192.168.126.10

- DR 服务器(负载调度器)(CentOS 7-1):192.168.126.11

- Web 服务器 1(CentOS 7-2):192.168.126.12

- Web 服务器 2(CentOS 7-3):192.168.126.13

- NFS 服务器(CentOS 7-4):192.168.126.14

- VIP:192.168.126.166

3.配置负载调度器

CentOS 7-1(192.168.126.11)

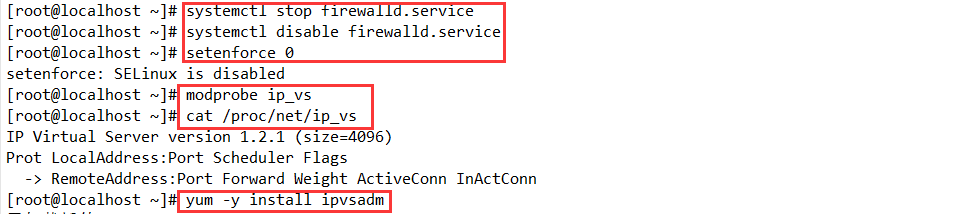

- 准备

systemctl stop firewalld.service

systemctl disable firewalld.service

setenforce 0

modprobe ip_vs

#加载ip_vs模块

cat /proc/net/ip_vs

#查看ip_vs版本信息

yum install -y ipvsadm

#安装软件包

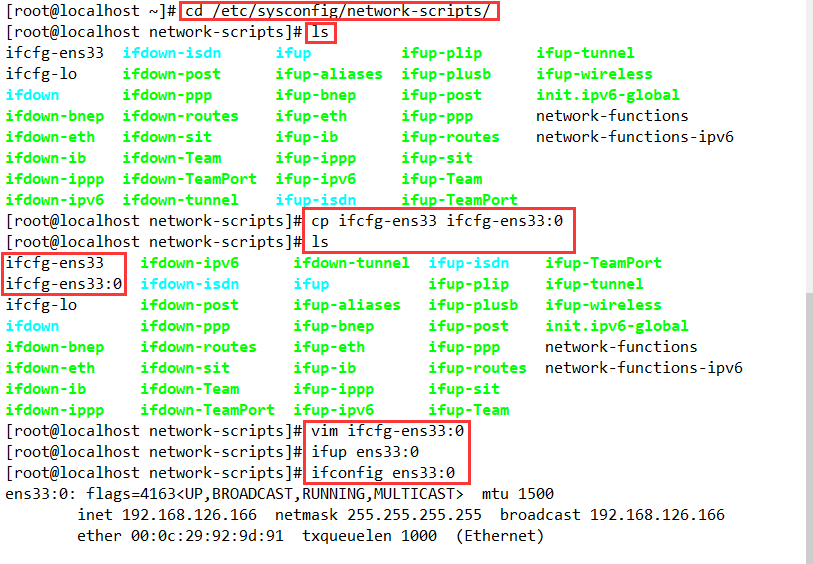

- 配置虚拟 IP 地址)(VIP)

采用虚接口的方式为网卡绑定 VIP 地址,以便响应群集访问

cd /etc/sysconfig/network-scripts/

cp ifcfg-ens33 ifcfg-ens33:0

vim ifcfg-ens33:0

#清空原有配置,添加以下内容

DEVICE=ens33:0

ONBOOT=yes

IPADDR=192.168.126.88

NETMASK=255.255.255.255

ifup ens33:0

#开启虚拟 ip

ifconfig ens33:0

#查看虚拟 ip

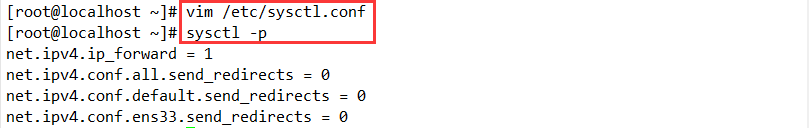

- 调整 proc 响应参数

对于 DR 集群来说,由于由于 LVS 负载调度器和各节点需要共用 VIP 地址,应该关闭 Linux 内核的重定向参数响应

vim /etc/sysctl.conf

#添加以下内容

net.ipv4.ip_forward = 1

net.ipv4.conf.all.send_redirects = 0

net.ipv4.conf.default.send_redirects = 0

net.ipv4.conf.ens33.send_redirects = 0

sysctl -p

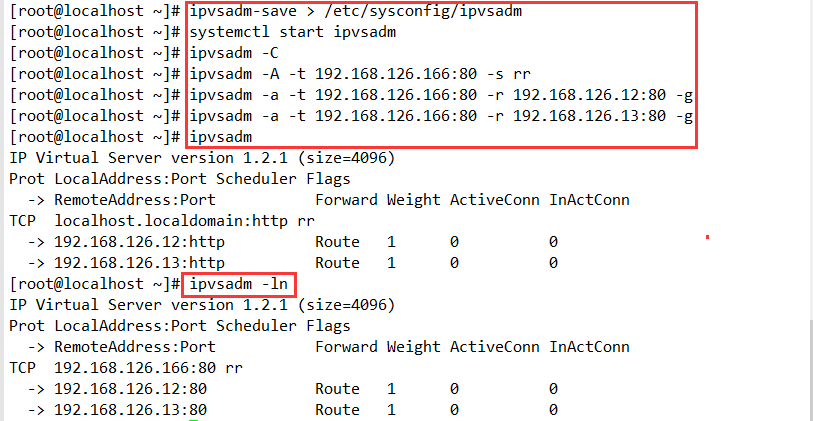

- 配置负载分配策略

ipvsadm-save > /etc/sysconfig/ipvsadm

systemctl start ipvsadm

ipvsadm -C

#清除原有策略

ipvsadm -A -t 192.168.126.166:80 -s rr

ipvsadm -a -t 192.168.126.166:80 -r 192.168.126.12:80 -g

ipvsadm -a -t 192.168.126.166:80 -r 192.168.126.13:80 -g

#若使用隧道模式,则结尾处 -g 替换为 -i

ipvsadm

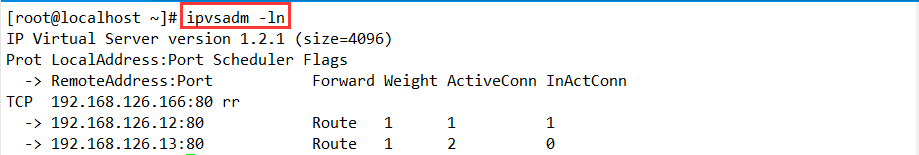

ipvsadm -ln

#查看节点状态,Route代表 DR模式

4.部署 NFS 共享挂载

CentOS 7-4(192.168.126.14)

systemctl stop firewalld.service

systemctl disable firewalld.service

setenforce 0

yum install -y nfs-utils rpcbind

systemctl start nfs.service

systemctl start rpcbind.service

systemctl enable nfs.service

systemctl enable rpcbind.service

mkdir /opt/xcf /opt/zxc

chmod 777 /opt/xcf/ /opt/zxc/

vim /etc/exports

/usr/share *(ro,sync)

/opt/xcf 192.168.126.0/24(rw,sync)

/opt/zxc 192.168.126.0/24(rw,sync)

exportfs -rv

showmount -e

5.配置节点服务器

CentOS 7-2(192.168.126.12)与 CentOS 7-3(192.168.126.13)

- 使用 DR 模式时,节点服务器也需要配置 VIP 地址,并调整内核的 ARP 响应参数以组织更新 VIP 的 MAC 地址,避免发生冲突

- 除此之外,Web 服务的配置与 NAT 方式类似

- 准备

systemctl stop firewalld.service

systemctl disable firewalld.service

setenforce 0

#将两个节点服务器的网关和DNS注释掉后重启网卡

#如果有网关服务器则指向网关服务器

- 配置虚拟 IP 地址

#此地址仅用做发送 Web 响应数据包的源地址,并不需要监听客户机的访问请求(改由调度器监听并分发)

#因此使用虚接口 lo:0 来承载 VIP 地址,并为本机添加一条路有记录,将访问 VIP 的数据限制在本地,以避免通信紊乱

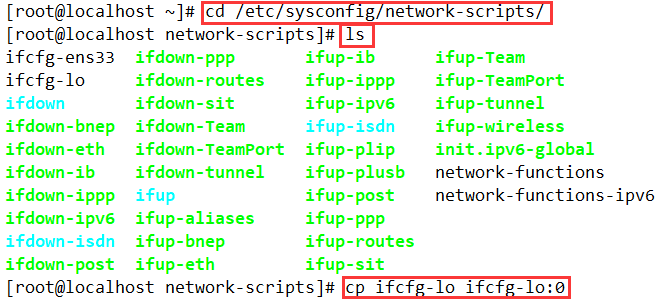

cd /etc/sysconfig/network-scripts/

cp ifcfg-lo ifcfg-lo:0

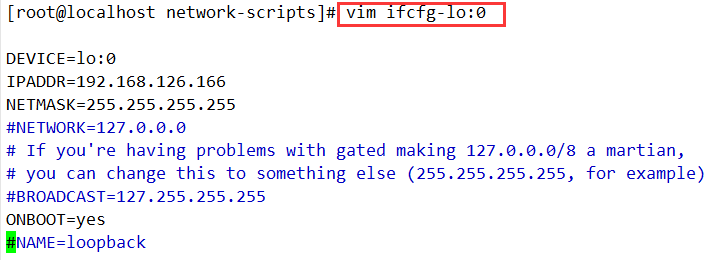

vim ifcfg-lo:0

DEVICE=lo:0

IPADDR=192.168.126.166

NETMASK=255.255.255.255

#注意,此处子网掩码必须全为1

#NETWORK=127.0.0.0

# If you're having problems with gated making 127.0.0.0/8 a martian,

# you can change this to something else (255.255.255.255, for example)

#BROADCAST=127.255.255.255

ONBOOT=yes

#NAME=loopback

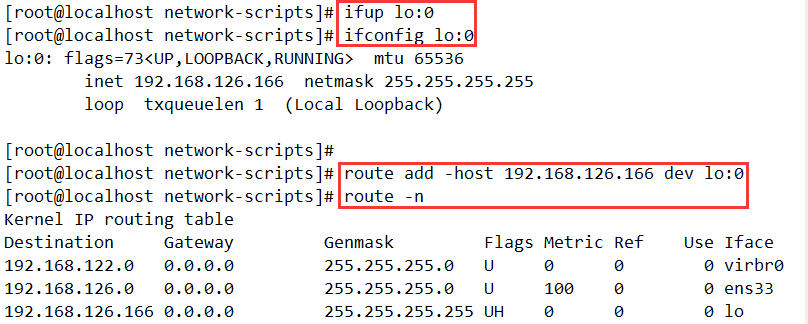

ifup lo:0

ifconfig lo:0

route add -host 192.168.126.166 dev lo:0

#禁锢路由

route -n

#查看路由

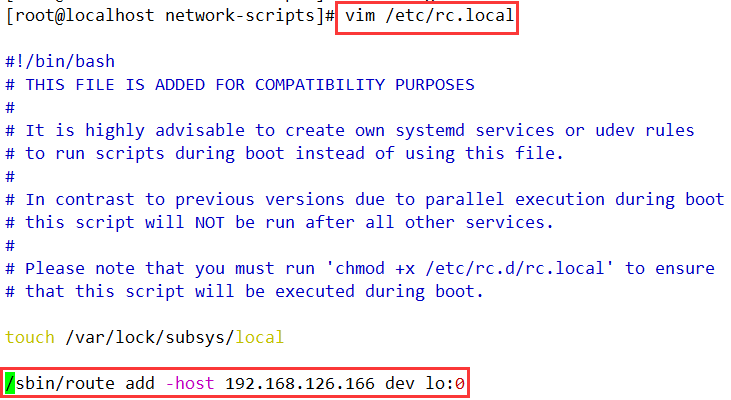

vim /etc/rc.local

#添加VIP本地访问路由

/sbin/route add -host 192.168.126.166 dev lo:0

chmod +x /etc/rc.d/rc.local

- 调整内核的 ARP 响应参数,以阻止更新 VIP 的 MAC 地址,避免发生冲突

调整 /proc 响应参数

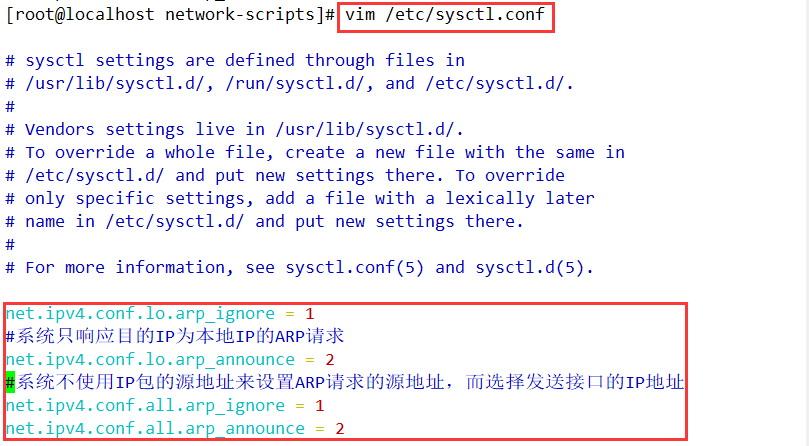

vim /etc/sysctl.conf

......

net.ipv4.conf.lo.arp_ignore = 1

#系统只响应目的IP为本地IP的ARP请求

net.ipv4.conf.lo.arp_announce = 2

#系统不使用IP包的源地址来设置ARP请求的源地址,而选择发送接口的IP地址

net.ipv4.conf.all.arp_ignore = 1

net.ipv4.conf.all.arp_announce = 2

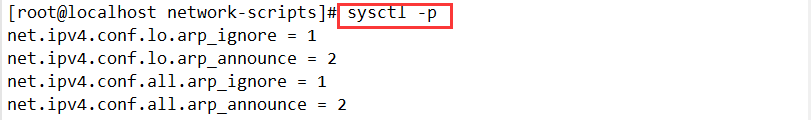

sysctl -p

或

echo "1" >/proc/sys/net/ipv4/conf/lo/arp_ignore

echo "2" >/proc/sys/net/ipv4/conf/lo/arp_announce

echo "1" >/proc/sys/net/ipv4/conf/all/arp_ignore

echo "2" >/proc/sys/net/ipv4/conf/all/arp_announce

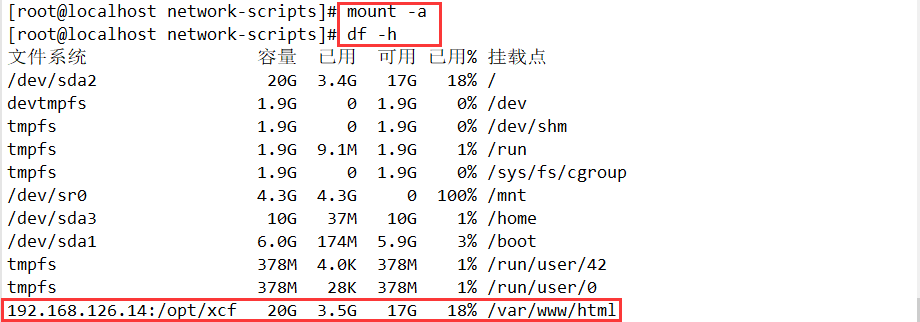

- 挂载共享目录

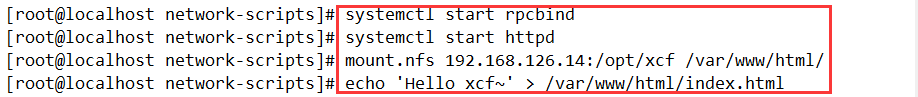

yum install -y nfs-utils rpcbind httpd

systemctl start rpcbind

systemctl start httpd

mount.nfs 192.168.126.14:/opt/xcf /var/www/html/

echo 'Hello xcf~' > /var/www/html/index.html

#设为自动挂载

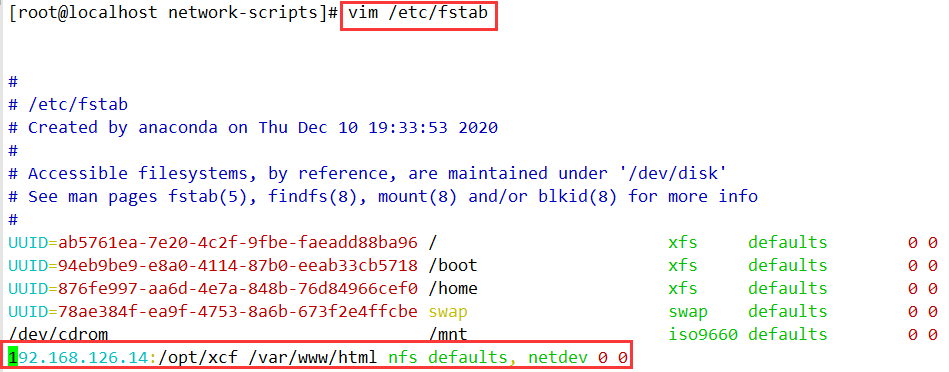

vim /etc/fstab

192.168.126.14:/opt/xcf /var/www/html nfs defaults,_netdev 0 0

mount -a

- 另一台 Web2 节点服务器同理操作,只用更改共享目录的参数即可

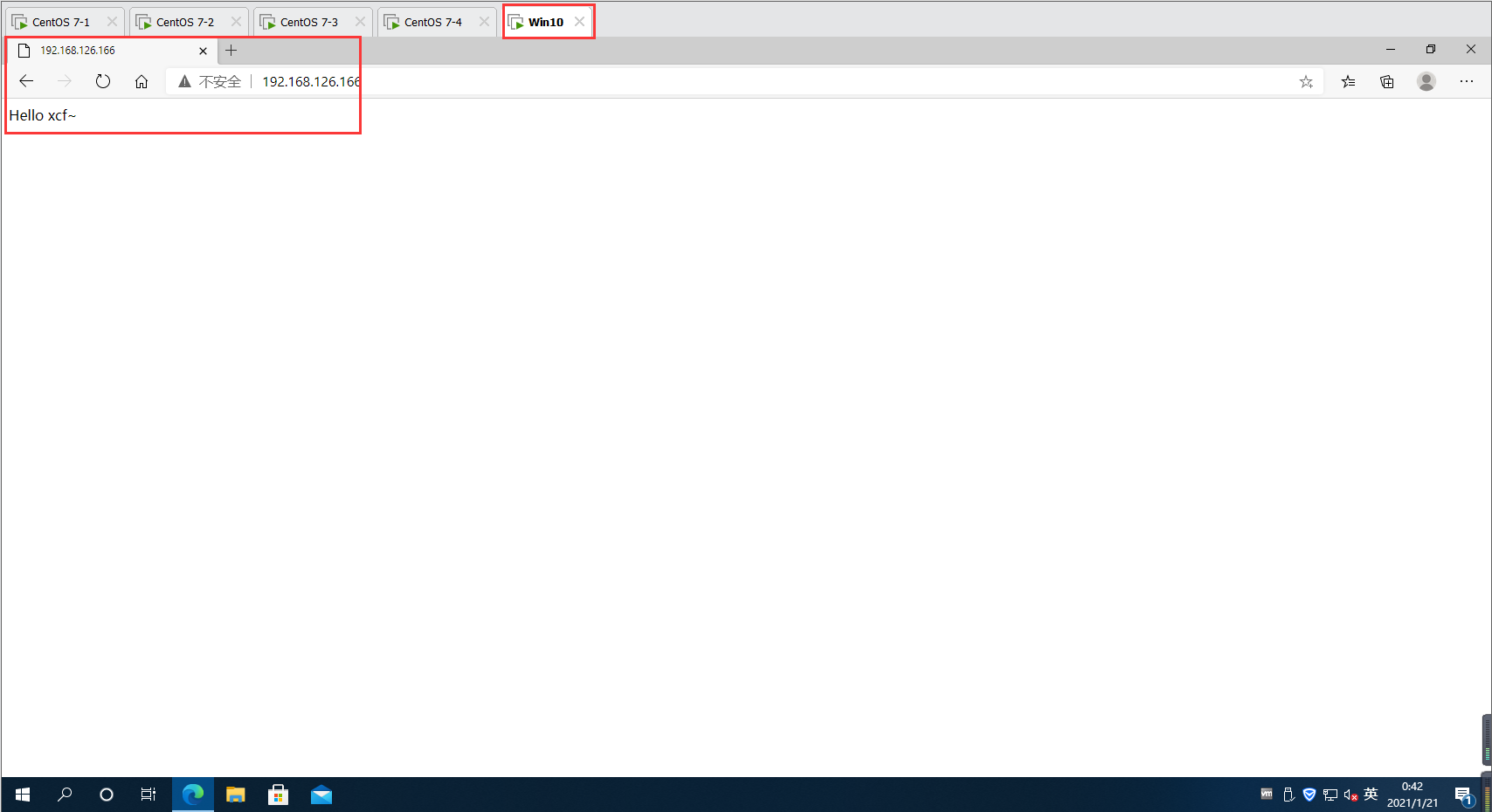

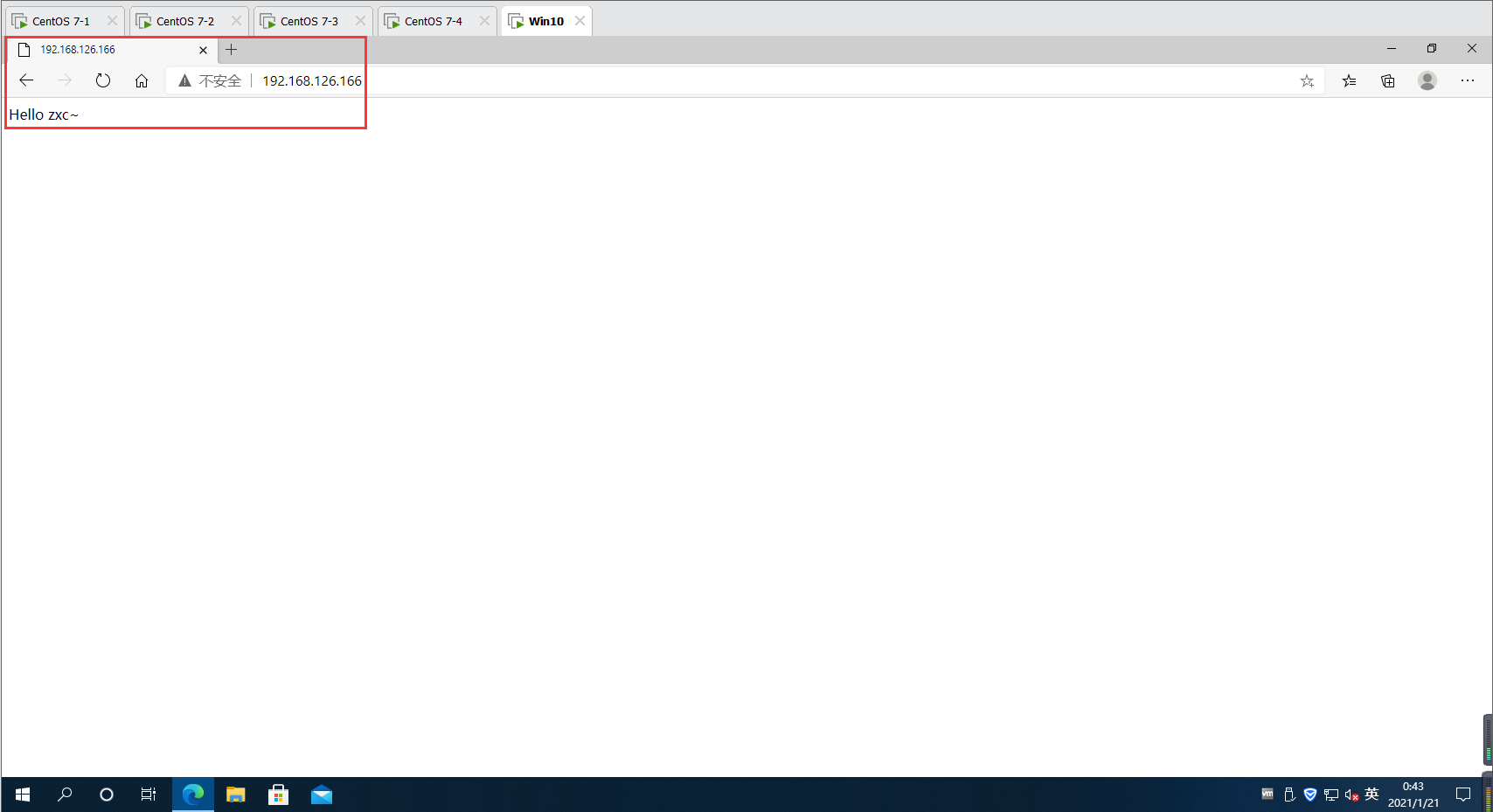

6.测试 LVS 群集

-

使用 Win10作为测试客户端(默认网关指向 192.168.126.166),从 Internet 中直接访问 http://192.168.126.166

-

能够看到由真实服务器提供的网页内容——如果各节点的网页不同,则不同客户机看到的网页也不一样(需多刷新几次,等待一会儿)

-

在 LVS 负载调度器中,通过查看节状态可以观察到当前的负载分配情况,对于轮询算法来说,每个节点所获得的连接负载应大致相当