激活函数

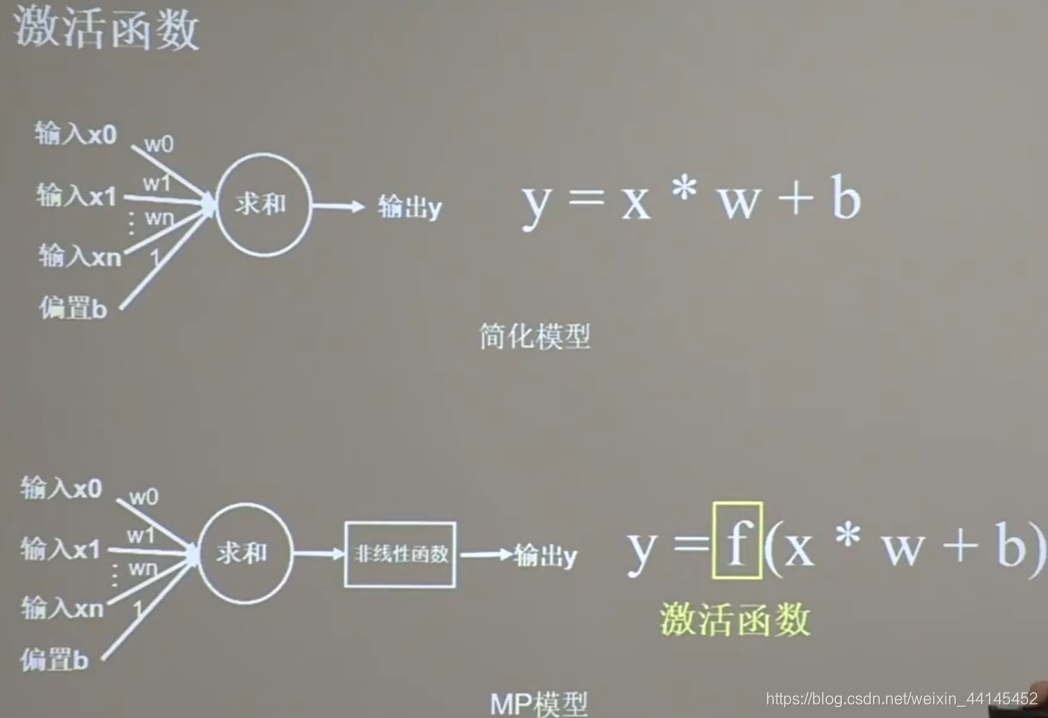

这一张图是我们上一讲实现鸢尾花分类时,用到的神经元模型 和它对应的前向传播公式

从公式可以看出,即使有多层神经元首尾相连,构成深层神经网络,依旧是线性组合,模型的表达力不够

这张图是1943年提出的MP模型

这张图是1943年提出的MP模型

比上面的简化模型多了一个非线性函数,这个非线性函数,叫做激活函数。神经网络可以随层数的增加提升表达能力

常用的激活函数

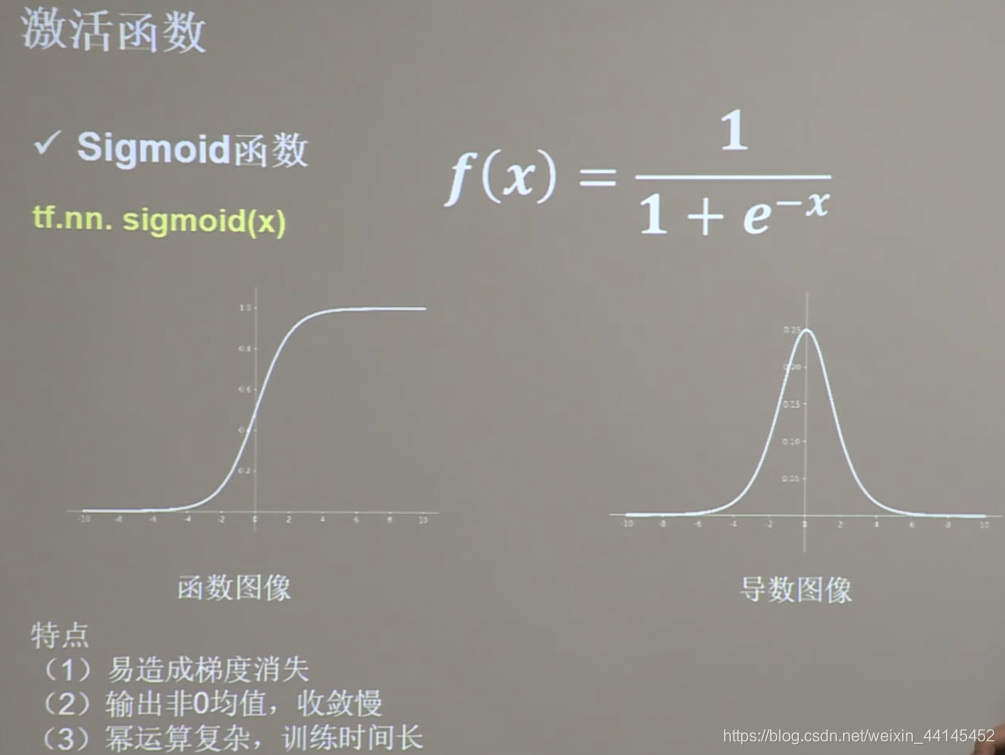

Sigmoid()函数

sigmoid函数也叫Logistic函数,用于隐层神经元输出,取值范围为(0,1),它可以将一个实数映射到(0,1)的区间,可以用来做二分类。在特征相差比较复杂或是相差不是特别大时效果比较好。

Sigmoid作为激活函数有以下优缺点:

优点:平滑、易于求导。

缺点:激活函数计算量大,反向传播求误差梯度时,求导涉及除法;反向传播时,很容易就会出现梯度消失的情况,从而无法完成深层网络的训练。

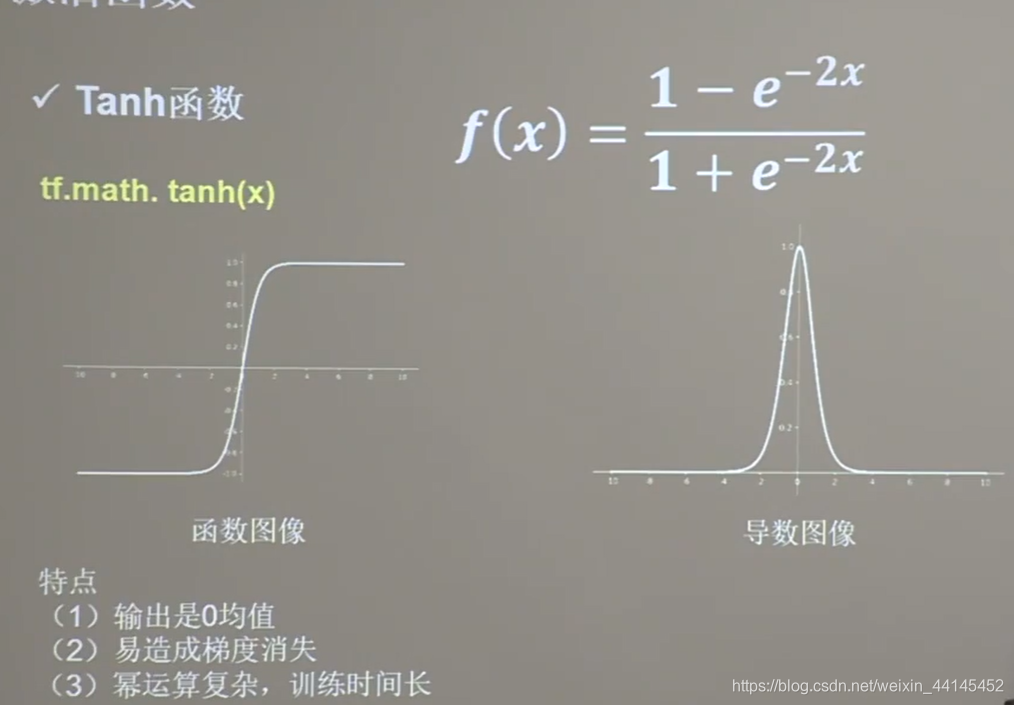

Tanh()函数

Tanh()函数

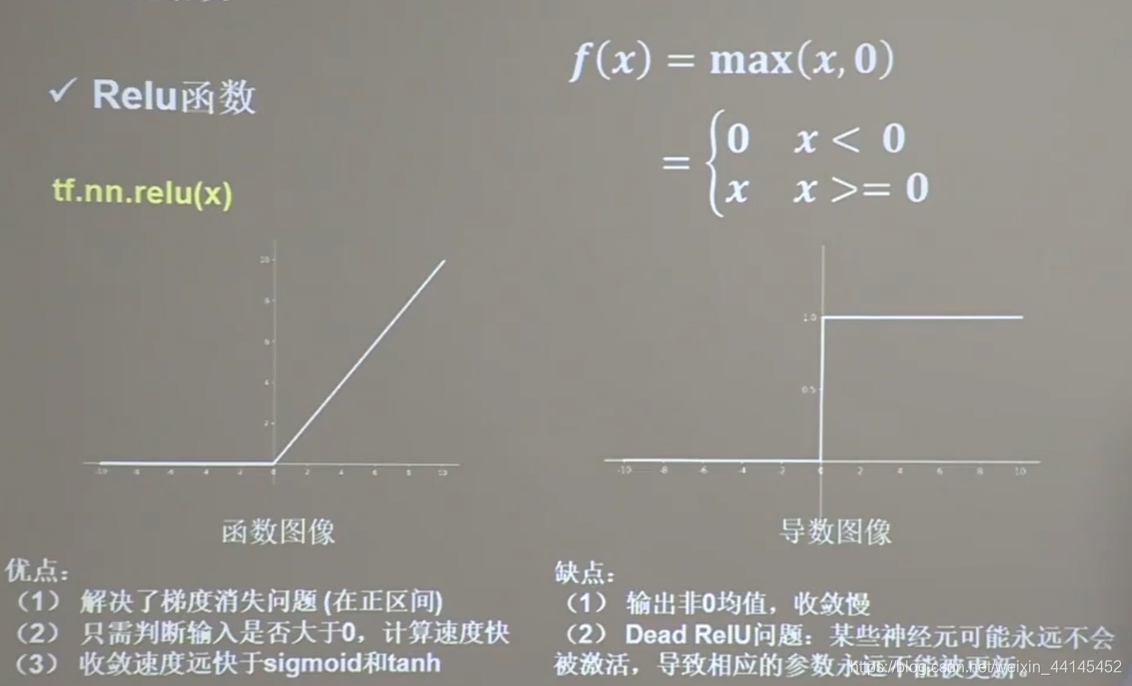

Relu()函数

Relu()函数

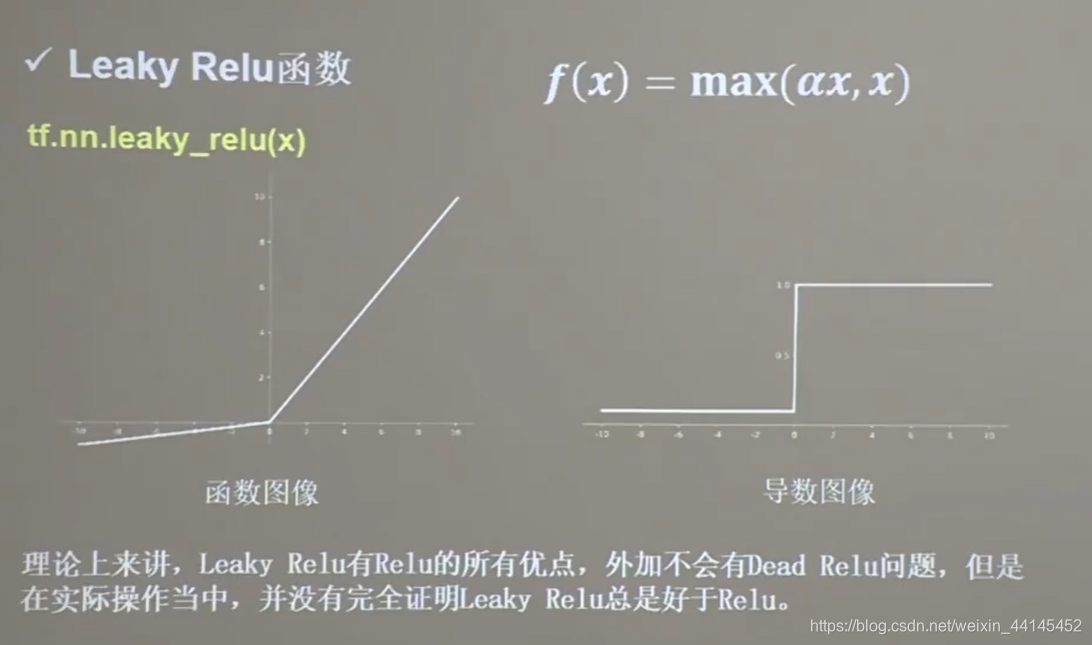

Leaky Relu()函数