数据分析-学术前沿趋势分析三

简介

该博客将继续对论文进行分析,这次是论文代码统计,统计所有论文出现代码的相关统计,使用正则表达式统计代码连接、⻚数和图表数据。

数据处理

正则表达式

在进行数据处理之前,先对正则表达式进行介绍:

正则表达式(regular expression)描述了一种字符串匹配的模式(pattern),可以用来检查一个串是否含有某种子串、将匹配的子串替换或者从某个串中取出符合某个条件的子串等。

- 普通字符:大写和小写字母、所有数字、所有标点符号和一些其他符号

- 特殊字符:有特殊含义的字符

- 限定符

在原始arxiv数据集中作者经常会在论文的comments或abstract字段中给出具体的代码链接,所以我们需要从这些字段里面找出代码的链接。

- 确定数据出现的位置;

- 使用用正则表达式完成匹配;

- 完成相关的统计;

具体代码实现以及讲解

首先我们来统计论文页数,也就是在comments字段中抽取pages和figures和个数,首先完成字段读取。

data = [] #初始化

#使用with语句优势:1.自动关闭文件句柄;2.自动显示(处理)文件读取数据异常

with open("arxiv-metadata-oai-snapshot.json", 'r') as f:

for idx, line in enumerate(f):

d = json.loads(line)

d = {

'abstract': d['abstract'], 'categories': d['categories'], 'comments': d['comments']}

data.append(d)

data = pd.DataFrame(data) #将list变为dataframe格式,方便使用pandas进行分析

对pages进行抽取:

# 使用正则表达式匹配,XX pages

data['pages'] = data['comments'].apply(lambda x: re.findall('[1-9][0-9]* pages', str(x)))

# 筛选出有pages的论文

data = data[data['pages'].apply(len) > 0]

# 由于匹配得到的是一个list,如['19 pages'],需要进行转换

data['pages'] = data['pages'].apply(lambda x: float(x[0].replace(' pages', '')))

对pages进行统计:

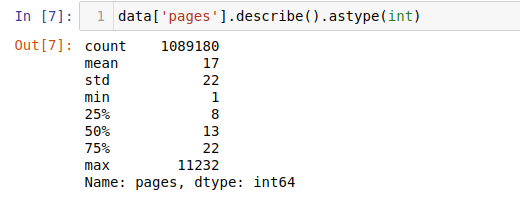

data['pages'].describe().astype(int)

统计结果如下:论文平均的页数为17页,75%的论文在22页以内,最长的论文有11232页。

接下来按照分类统计论文页数,选取了论文的第一个类别的主要类别:

# 选择主要类别

data['categories'] = data['categories'].apply(lambda x: x.split(' ')[0])

data['categories'] = data['categories'].apply(lambda x: x.split('.')[0])

# 每类论文的平均页数

plt.figure(figsize=(12, 6))

data.groupby(['categories'])['pages'].mean().plot(kind='bar')

接下来对论文图表个数进行抽取:

data['figures'] = data['comments'].apply(lambda x: re.findall('[1-9][0-9]* figures', str(x)))

data = data[data['figures'].apply(len) > 0]

data['figures'] = data['figures'].apply(lambda x: float(x[0].replace(' figures', '')))

最后我们对论文的代码链接进行提取,为了简化任务我们只抽取github链接:

# 筛选包含github的论文

data_with_code = data[

(data.comments.str.contains('github')==True)|

(data.abstract.str.contains('github')==True)

]

data_with_code['text'] = data_with_code['abstract'].fillna('') + data_with_code['comments'].fillna('')

# 使用正则表达式匹配论文

pattern = '[a-zA-z]+://github[^\s]*'

data_with_code['code_flag'] = data_with_code['text'].str.findall(pattern).apply(lambda x: 0 if len(x) < 1 else 1)

并对论文按照类别进行绘图:

data_with_code = data_with_code[data_with_code['code_flag'] == 1]

plt.figure(figsize=(12, 6))

data_with_code.groupby(['categories'])['code_flag'].count().plot(kind='bar')