公号众陆小马获取更多资料

1.1 搜索可见的内容

一般情况下,手动浏览就可以确定应用程序的大部分内容和功能。浏览应用程序的基本方法是从初始页面开始,依次浏览每一个链接和所有的多阶段功能。但是为了仔细检查枚举的内容,全面记录每一项确定的功能,简单的浏览就不再能满足我们的需求,有必要使用更加先进的工具。

(1)首先配置浏览器,使用代理工具,可以使用BurpSuite等工具监控和解析由代理服务器处理的Web内容,对站点实行被动抓取。

首先开启代理,然后打开Burpsuite并找到Target下的Site map

访问目标网站,对其进行自动爬取,由于完全自动化的方法在内容枚举方面还有一定的限制,例如身份验证时爬虫的一些操作会让通过验证的会话中断;向某个敏感内容提交无效输入,应用程序可能会自我防御,终止会话;多阶段功能往往会严格的执行输入确认检查,可能不会接受自动工具提交的值;爬虫可能会发现并使用敏感功能,造成重大损失等等。

所以更多的时候我们选择进行指定爬取,即用户通过常规方式浏览应用程序,来枚举应用程序的所有功能,生成的流量穿过一个组合拦截代理服务器与爬虫的工具,监控所有请求和响应,并且像一个正常的应用程序感知爬虫那样来分析应用程序的响应,BurpSuite中的爬虫就有这种用途。

(2)检查生成的站点地图,确定任何尚未使用浏览器访问到的内容和功能,根据抓取结果,确定发现每一项内容的位置,使用浏览器访问以上内容,以爬虫解析服务器的响应,确定其他任何内容。重复以上步骤,直到无法确定其他内容或功能。

(3)接下来进行指定爬取

以常规方式浏览整个应用程序,访问发现的每一个url,提交每一个表单并执行全部多阶段功能,尝试在JavaScript激活与禁用、cookie激活与禁用的情况下浏览。

如何禁用cookie

打开设置,找到Privacy,点击Firefox will右边的下拉菜单,选择use custom settings for history,然后将Accept cookies from sites前面的√去掉

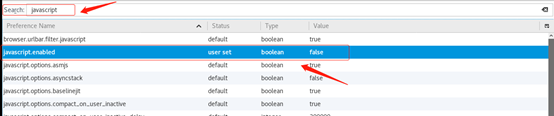

如何禁用JavaScript

在地址栏输入about:config,点击 I accept the risk!

搜索javascript,找到javascript.enable,双击关闭

4)完成手动浏览和被动抓取以后,可以用一组发现的url作为种子,使用爬虫抓取应用程序。有时候这样可以发现其他在手动浏览时忽略的内容。在进行自动抓取前,首先应确定任何危险的或可能会中断应用程序会话的url,并配置爬虫,将它们排除在抓取范围之外。

在这一节有一点要注意的就是许多Web服务器的根目录下有一个名为robots.txt的文件,其中列出了站点不希望Web爬虫访问或搜索引擎列入索引的url。有时候这个文件中可能会包含一些敏感信息,这些信息很可能会危机Web程序的安全。