我们知道,在传递给机器学习模型的数据中,我们需要对数据进行归一化(normalization)处理。

在数据归一化之后,数据被「拍扁」到统一的区间内,输出范围被缩小至 0 到 1 之间。人们通常认为经过如此的操作,最优解的寻找过程明显会变得平缓,模型更容易正确的收敛到最佳水平。

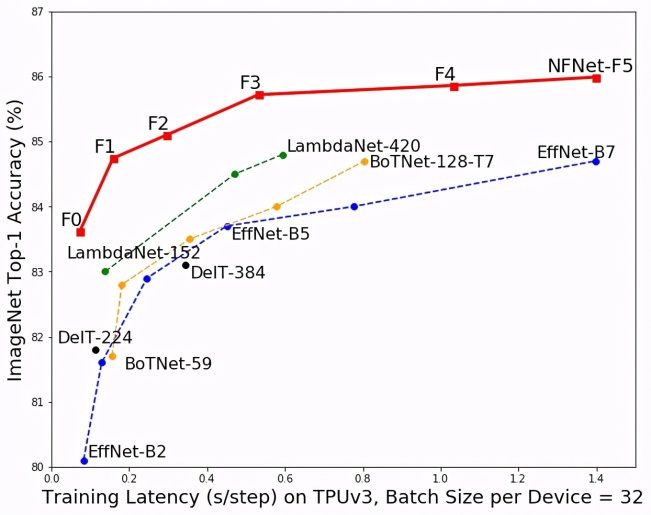

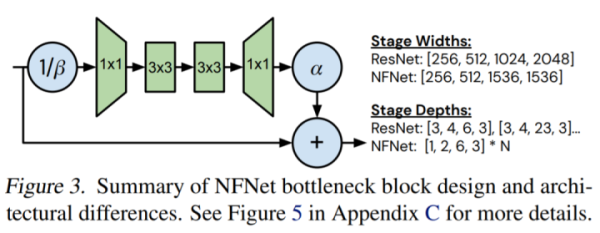

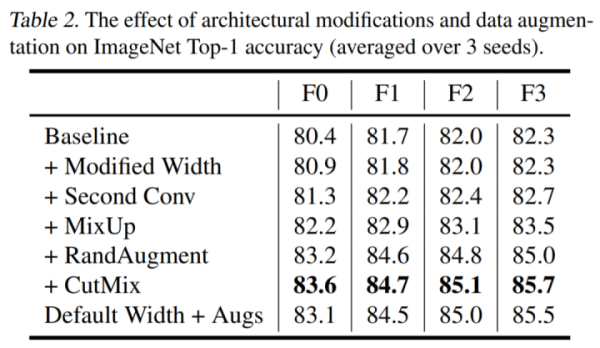

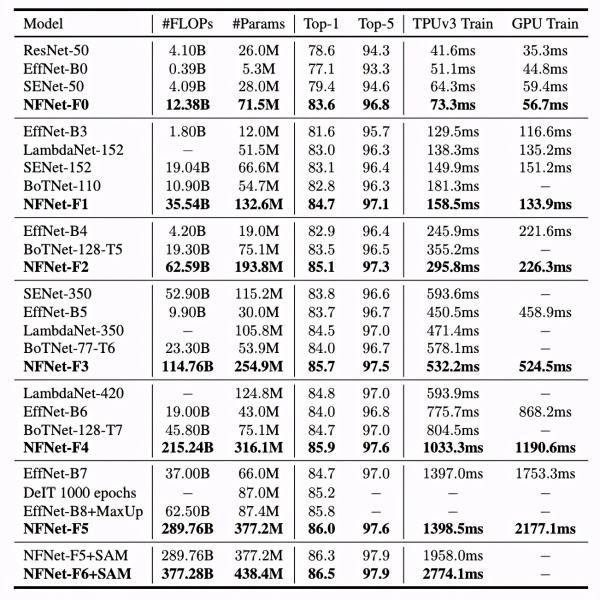

然而这样的「刻板印象」最近受到了挑战,DeepMind 的研究人员提出了一种不需要归一化的深度学习模型 NFNet,其在大型图像分类任务上却又实现了业内最佳水平(SOTA)。

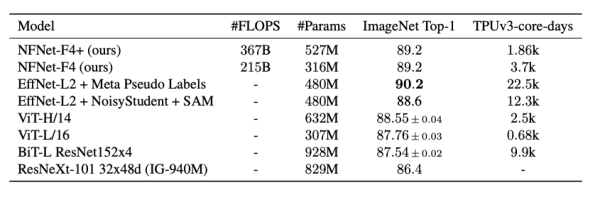

表 5:使用额外数据进行大规模预训练后,ImageNet 模型迁移性能对比。

表 5:使用额外数据进行大规模预训练后,ImageNet 模型迁移性能对比。

Andrew Brock 表示,虽然我们对于神经网络信号传递、训练规律的理解还有很多需要探索的方向,但无归一化的方法已经为人们提供了一个强有力的参考,并证明了发展这种深度理解能力可以有效地在生产环境中提升效率。