1. 概述

Stacking 就是当用初始训练数据学习出若干个基学习器后,将这几个学习器的预测结果作为新的训练集,来学习一个新的学习器。Stacking 的基础层通常包括不同的学习算法,因此stacking ensemble往往是异构的。

2. 算法流程

1)过程1-3是训练出来个体学习器,也就是初级学习器。过程5-9是使用训练出来的个体学习器来得预测的结果,这个预测的结果当做次级学习器的训练集。

2)过程5-9是使用训练出来的个体学习器来得到预测的结果,这个预测的结果当做次级学习器的训练集。

3)过程11是用初级学习器预测的结果训练出次级学习器,得到我们最后训练的模型。

如果想要预测一个数据的输出,只需要吧这条数据用初级学习器预测,然后将预测后的结果用次级学习器预测便可。

3. 示例

1、首先我们会得到两组数据:训练集和测试集。将训练集分成5份:train1,train2,train3,train4,train5。

2、选定基模型。这里假定我们选择了xgboost, lightgbm 和 randomforest 这三种作为基模型。比如xgboost模型部分:依次用trian1、train2、train3、train4、train5作为验证集,其余4份作为训练集,进行5折交叉验证进行模型训练;再在测试集上进行预测。这样会得到在训练集上由xgboost模型训练出来的5份predictions,和在测试集上的1份预测值B1。将这五份纵向重叠合并起来得到A1。lightgbm和randomforest模型部分同理。

3、三个基模型训练完毕后,将三个模型在训练集上的预测值作为分别作为3个"特征"A1,A2,A3,使用LR模型进行训练,建立LR模型。

4、使用训练好的LR模型,在三个基模型之前在测试集上的预测值所构建的三个"特征"的值(B1,B2,B3)上,进行预测,得出最终的预测类别或概率。

4. 代码实现

from sklearn import datasets

from sklearn import model_selection

from sklearn.linear_model import LogisticRegression

from sklearn.neighbors import KNeighborsClassifier

from sklearn.tree import DecisionTreeClassifier

from mlxtend.classifier import StackingClassifier # pip install mlxtend

import numpy as np

# 载入数据集

iris = datasets.load_iris()

# 只要第1,2列的特征

x_data, y_data = iris.data[:, 1:3], iris.target

# 定义三个不同的分类器

clf1 = KNeighborsClassifier(n_neighbors=1)

clf2 = DecisionTreeClassifier()

clf3 = LogisticRegression()

# 定义一个次级分类器

lr = LogisticRegression()

sclf = StackingClassifier(classifiers=[clf1, clf2, clf3],

meta_classifier=lr)

for clf,label in zip([clf1, clf2, clf3, sclf],

['KNN','Decision Tree','LogisticRegression','StackingClassifier']):

scores = model_selection.cross_val_score(clf, x_data, y_data, cv=3, scoring='accuracy')

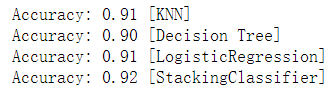

print("Accuracy: %0.2f [%s]" % (scores.mean(), label))

输出: