这里写目录标题

一、ELK日分析系统简介

ELK其实就是Elasticsearch+Logstash+Kibana

1.1 Elasticsearch(索引数据库)

提供了一个分布式多用户能力的全文搜索引擎

1.1.1 Elasticserarch核心概念

1.接近实时(NRT)

lasticsearch是一个接近实时的搜索平台,这意味着,从索引一个文档直到这个文档能够被搜索到有一个轻微的延迟 (通常是1秒)

2.集群(cluster)集群化管理

一个集群就是由一个或多个节点组织在一起,它们共同持有你整个的数据,并一起提供索引和搜索功能。其中一个节点为主节点,这个主节点是可以通过选举产生的,并提供跨节点的联合索弓|和搜索的功能。集群有一个唯一性标示的名字,默认是elasticsearch,集群名字很重要,每个节点是基于集群名字加入到其集群中的。因此,确保在不同环境中使用不同的集群名字。

一个集群可以只有一个节点。强烈建议在配置elasticsearch时, 配置成集群模式。

es具有就集群机制,节点通过集群名称加入到集群中,同时在集群中的节点会有一个自己的唯一身份标识(自己的名称)

3.节点(node)

节点就是一台单一的服务器, 是集群的一部分,存储数据并参与集群的索引和搜索功能。像集群一样,节点也是通过名字来标识,默认是在节点启动时随机分配的字符名。当然,你可以自己定义。该名字也很重要,在集群中用于识别服务器对应的节点。

节点可以通过指定集群名字来加入到集群中。默认情况,每个节点被设置成加入到elasticsearch集群。如果启动了多个节点,假设能自动发现对方,他们将会自动组建一个名为elasticsearch的集群。

4.索引(index)

一个索引就是一个拥有几分相似特征的文档的集合。比如说,你可以有一个客户数据的索引,另一个产品目录的索引,还有一个订单数据的索引。一个索引由一个名字来标识(必须全部是小写字母的),并当我们要对对应于这个索引中的文档进行索引、搜索、更新和删除的时候,都要使用到这个名字。在一个集群中, 如果你想,可以定义任意多的索引。

索引相对于关系型数据库的库。

5.类型(type)

在一个索引中,你可以定义一种或多种类型。一个类型是你的索引的一个逻辑上的分类/分区,其语义完全由你来定。通常,会为具有一组共同字段的文档定义一个类型。比如说,我们假设你运营一个博客平台并且将你所有的数据存储到一个索引中。在这个索引中,你可以为用户数据定义一个类型,为博客数据定义另一个类型,当然,也可以为评论数据定义另一个类型。

类型相对于关系型数据库的表

6、文档(document)

一个文档是一个可被索引的基础信息单元。比如,你可以拥有某一个客户的文档, 某一个产品的一个文档,当然,也可以拥有某个订单的一个文档。文档以JSON (Javascript Object Notation)格式来表示,而JSON是一个到处存在的互联网数据交互格式。在一个index/type里面,只要你想,你可以存储任意多的文档。注意,虽然一个文档在物理上位于一个索引中,实际上一个文档必须在一个索引内被索引和分配一个类型。文档相对于关系型数据库的列。

1.1.2 分片和副本(shards & replicas)

1.2.1分片的最主要原因

① 水平分割扩展,增大存储量

② 分布式并跨分片操作,提高性能和吞吐量

1.2.2 副本的主要原因

① 高可用性,以应对分片或者节点故障,分片副本要在不同节点上

② 提高性能和增大吞吐量

1.2 Logstash(收集,输出,存储日志)

1.2.1 Logstash简介

①一款强大的数据处理工具

②可实现数据传输,格式处理,格式化输出

数据输入,数据加工(如过滤,改写等)以及数据输出

③ Logstash由JRuby语言编写,基于消息(message based)的简单架构,并运行在Java虚拟机(JVM) 上。不同于分离的代理端(agent)或主机端(server) ,LogStash可配置单一的代理端(agent) 与其它开源软件结合,以实现不同的功能。

1.2.2 LogStrash主要组件

Shipper

Indexer

Broker

Search and Storage

Web Interface

1.2.3 Logstash工作原理

Collect:数据输入

Enrich:数据加工,如过滤,改写等

Transport:数据输出(被其他模块进行调用)

1.3 Kibana(展示显示数据)

1.3.1 Kibana介绍(从ES拿取数据)

一个针对Elasticsearch的开源分析及可视化平台搜索,查看存储在Elasticsearch索引中的数据,通过各种图表进行高级数据分析及展示

1.3.2 Kibana主要功能

Elasticsearch无缝之集成

整合数据,复杂数据分析

让更多团队成员受益

接口灵活,分享更容易

配置灵活,可视化多数据源

简单数据导出

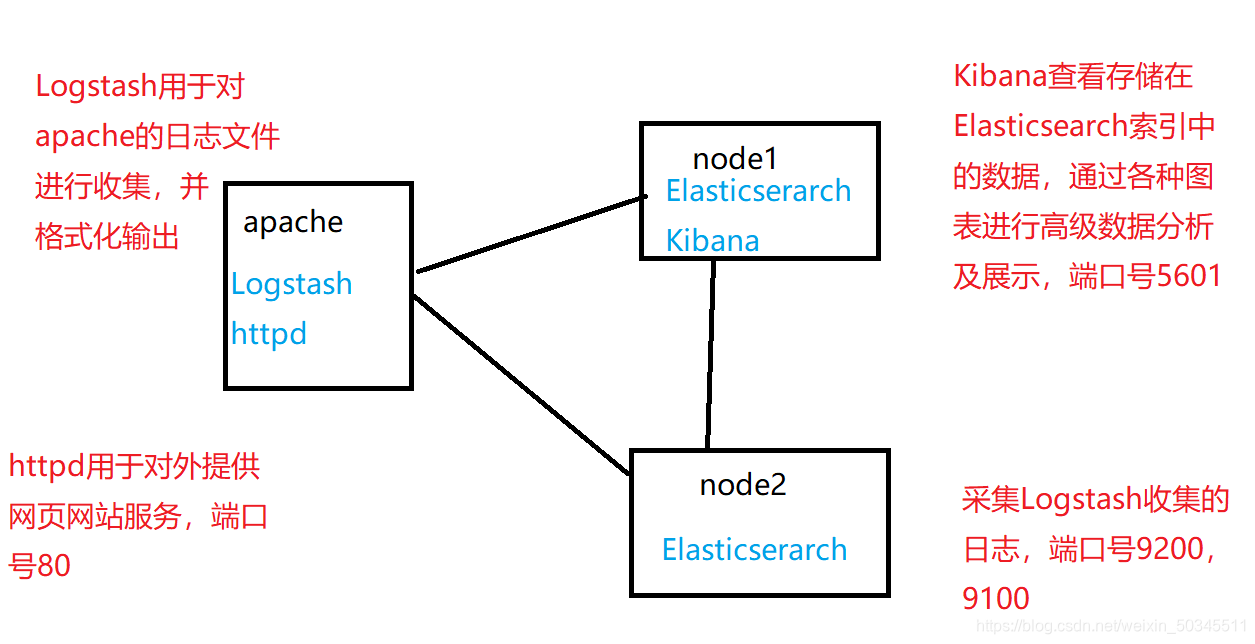

二、ELK部署

2.1 系统环境

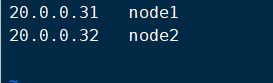

2.1.1 网络环境

| 设备 | IP地址 | 安装软件 |

|---|---|---|

| node1 | 20.0.0.31 | Kibana、Elasticserarch |

| node2 | 20.0.0.32 | Elasticserarch |

| apache | 20.0.0.33 | Logstash、httpd |

关闭防火墙(所有设备)

systemctl stop firewalld

setenforce 0

地址映射(node1、node2)

vi /etc/hosts

2.1.2 拓扑图

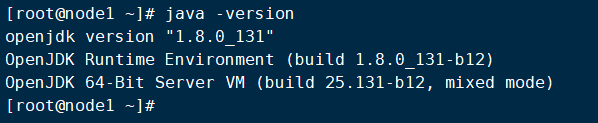

2.1.3 java环境变量

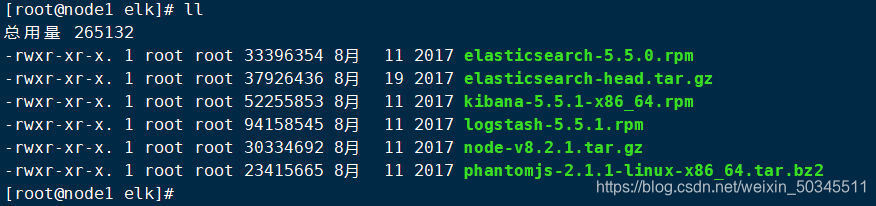

2.1.4 安全所需要的软件包

2.2 Elasticserarch部署

2.2.1 elasticsearch安装

1.切到含有elasticsearch-5.5.0.rpm包的目录下面,进行rpm安装

rpm -ivh elasticsearch-5.5.0.rpm

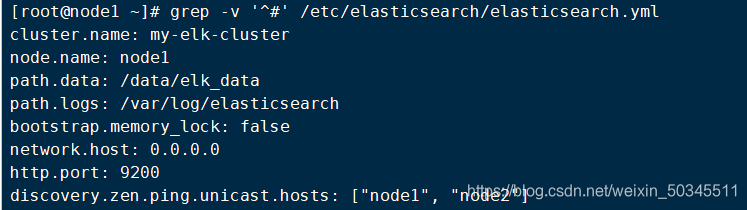

2.对配置文件进行备份并修改

cp /etc/elasticsearch/elasticsearch.yml /etc/elasticsearch/elasticsearch.yml.bak

vi /etc/elasticsearch/elasticsearch.yml

对下面的进行修改

cluster.name: my-elk-cluster #集群名字

node.name: node1 #节点名字

path.data: /data/elk_data #数据存放路径(需要创建)

path.logs: /var/log/elasticsearch #日志存放路径

bootstrap.memory_lock: false #不启动的时候锁定内存(前端缓存,与Iops--性能测试方式,每秒读写次数有关)

network.host: 0.0.0.0 #提供服务绑定的IP地址,0.0.0.0代表所有地址

http.port: 9200 #侦听端口为9200

discovery.zen.ping.unicast.hosts: ["node1", "node2"] # 集群发现通过单播实现

3.创建数据存放的文件、并授权

mkdir -p /data/elk_data

chown elasticsearch:elasticsearch /data/elk_data/

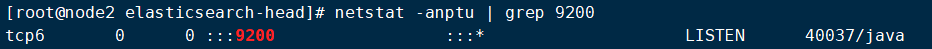

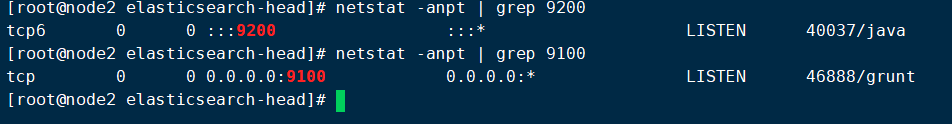

4.启动服务、并检查

systemctl start elasticsearch

netstat -anpt | grep 9200

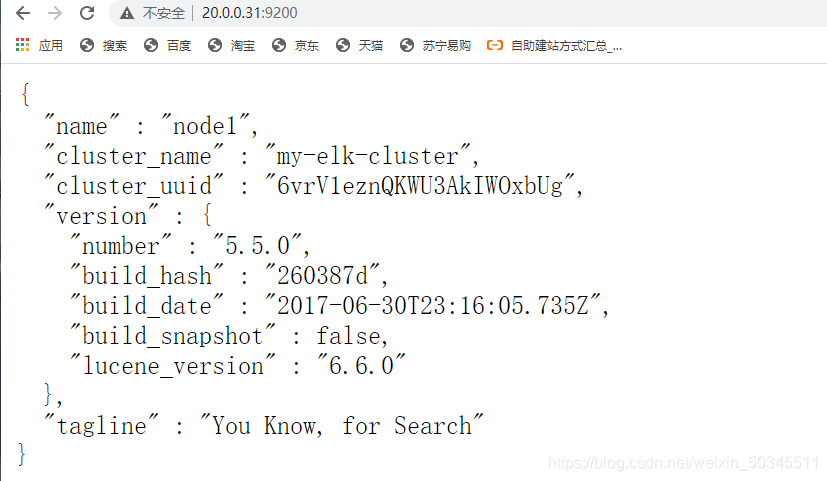

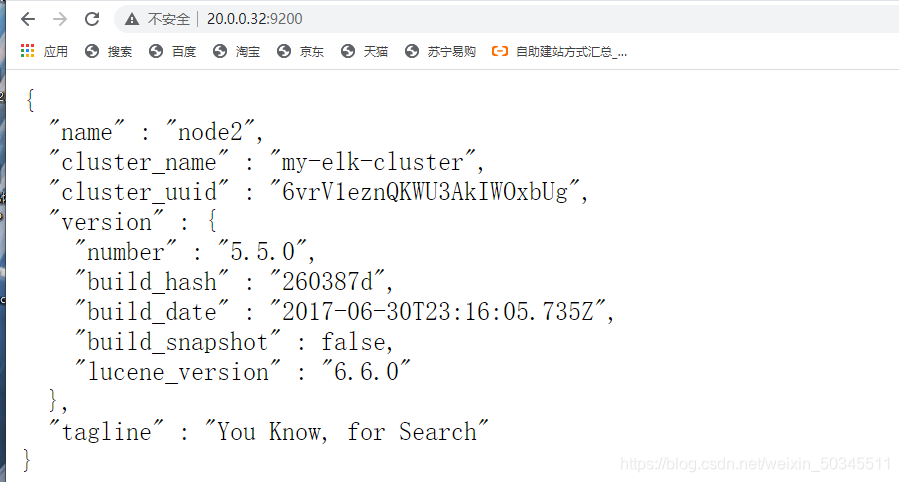

5.浏览器访问测试

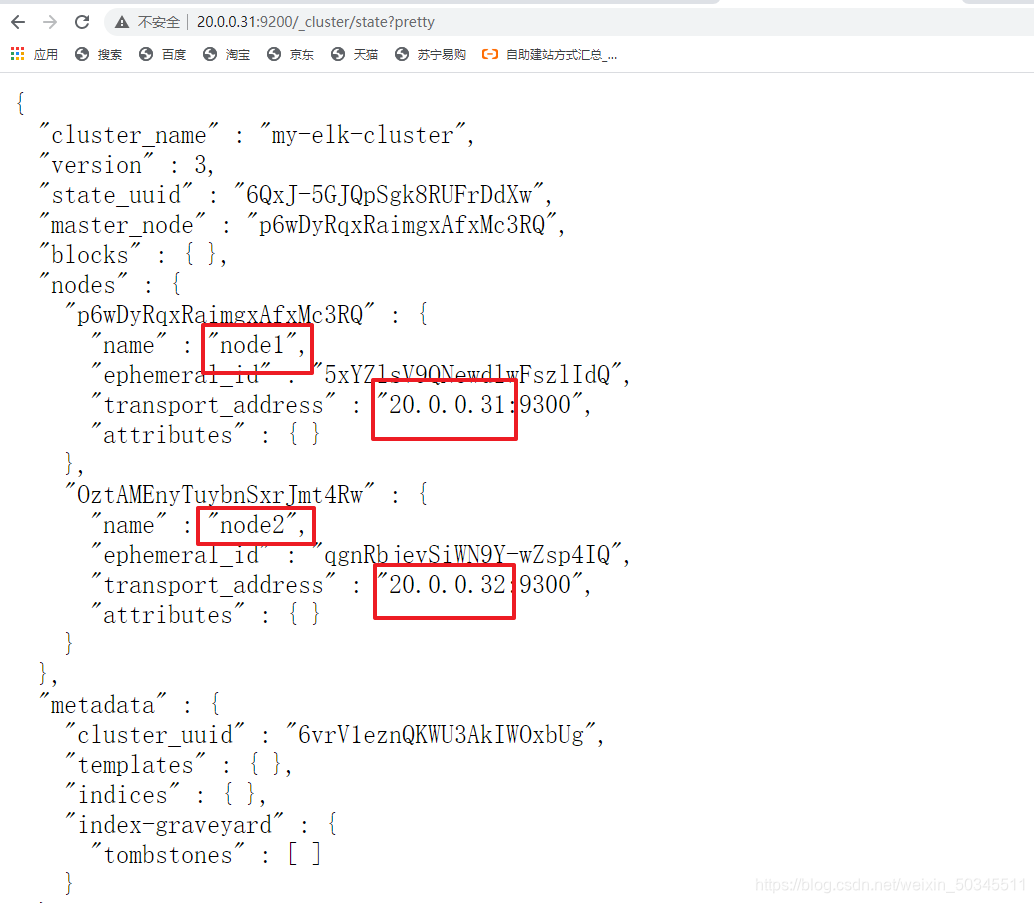

6.集群检查健康和状态

http://20.0.0.31:9200/_cluster/state?pretty

2.2.2 安装node组件

1.安装依赖包

yum -y install gcc gcc-c++ make

2.切到 node-v8.2.1.tar.gz所在目录进行操作

安装时间大概47分钟

tar xf node-v8.2.1.tar.gz -C /opt/

cd /opt/node-v8.2.1/

./configure

make && make install

2.2.3 安装phantomjs 前端框架

tar xf phantomjs-2.1.1-linux-x86_64.tar.bz2 -C /usr/local/src/

cd /usr/local/src/phantomjs-2.1.1-linux-x86_64/bin/

cp phantomjs /usr/local/bin/

2.2.4 安装elasticsearch-head 前端框架

切到 elasticsearch-head所在目录进行操作

tar xf elasticsearch-head.tar.gz -C /usr/local/src/

cd /usr/local/src/elasticsearch-head/

npm install

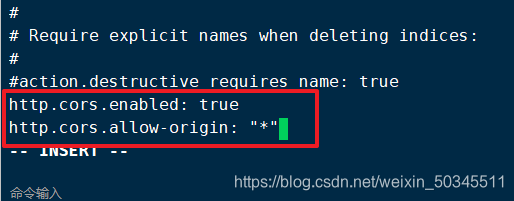

2.2.5 编辑主配置文件

vi /etc/elasticsearch/elasticsearch.yml

末尾添加

http.cors.enabled: true 开启跨域访问支持,默认为false

http.cors.allow-origin: "*" 跨域访问允许所有域名地址

重启服务

systemctl restart elasticsearch

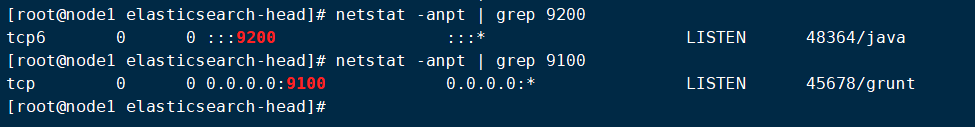

查看端口状态

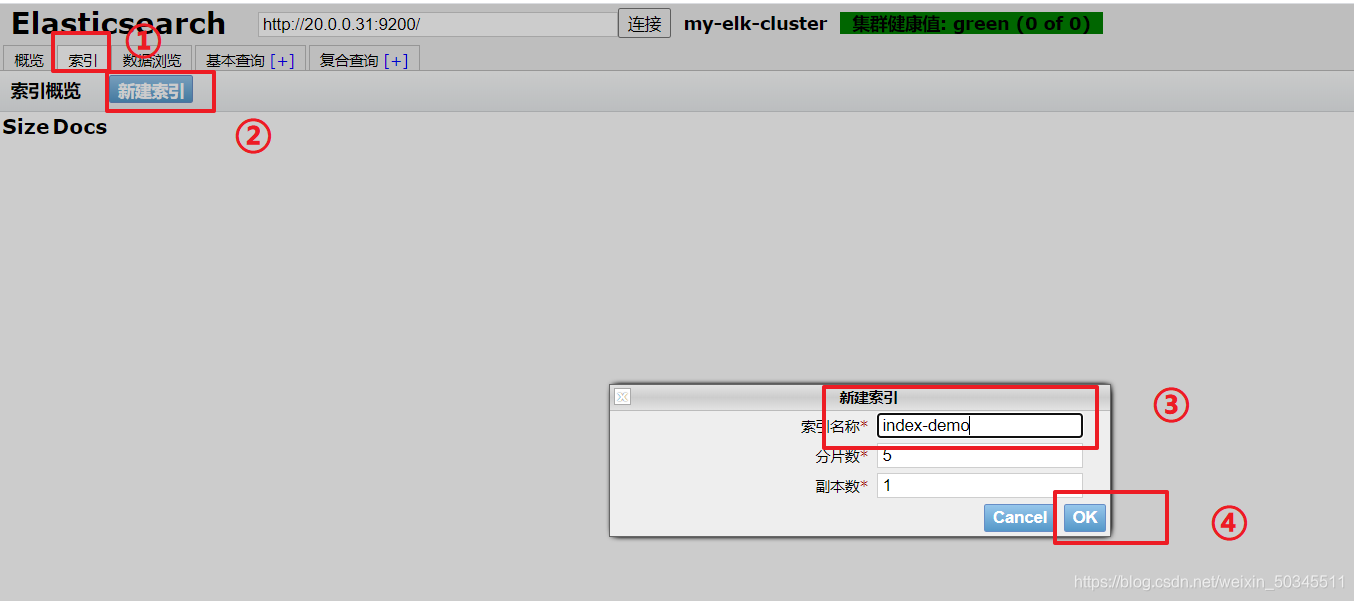

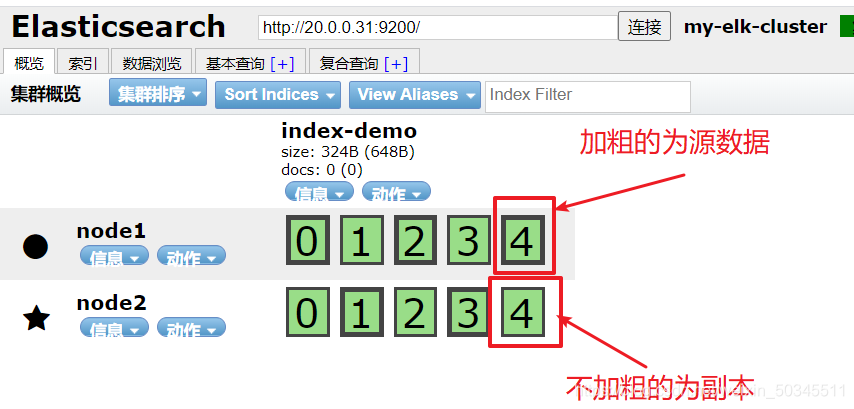

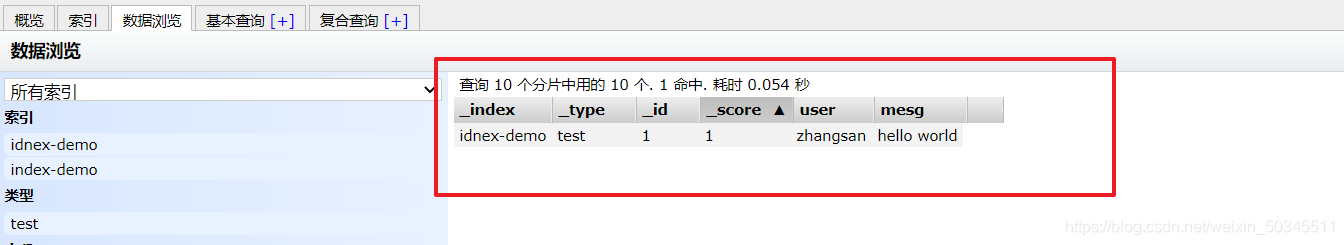

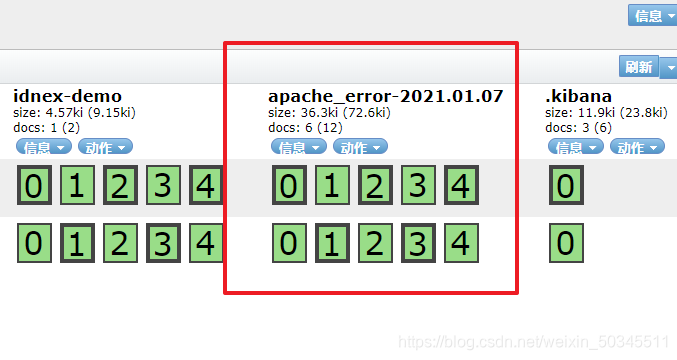

2.2.6 es的前端索引展示模拟

在node1上

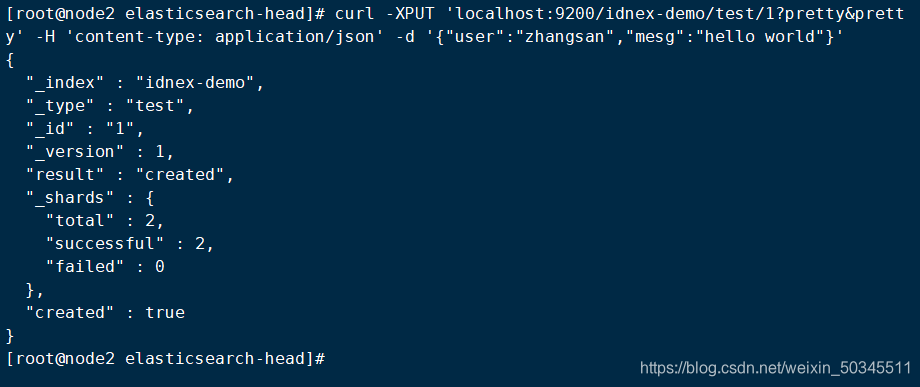

创建索引

curl -XPUT 'localhost:9200/idnex-demo/test/1?pretty&pretty' -H 'content-type: application/json' -d '{"user":"zhangsan","mesg":"hello world"}'

在浏览器刷新一下可以通过浏览器查看信息

2.3部署logstash

2.3.1 安装apache

使用yum安装apache

yum -y install httpd

开启并查看状态

systemctl start httpd

netstat -anpt | grep 80

2.3.2 安装logstash

rpm -ivh logstash-5.5.1.rpm

systemctl start logstash.service

systemctl enable logstash.service

ln -s /usr/share/logstash/bin/logstash /usr/local/bin/

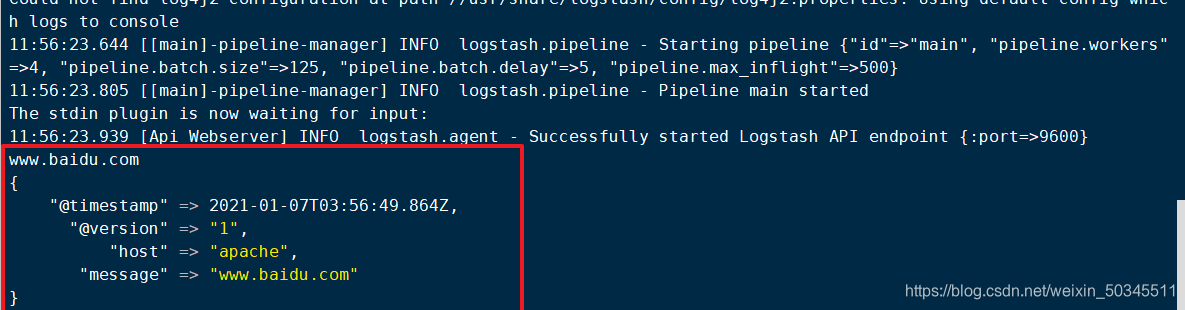

Logstash命令测试

logstash -e 'input { stdin{} } output { stdout{} }'

字段描述解释

-f 通过这个选项可以指定logstash的配置文件,根据配置文件配置logstash

-e 后面跟 着字符串该字符串可以被当做logstash的配置(如果是” ”,则默认使用stdin做为输入、stdout 作为输出)

-t 测试配置文件是否 正确,然后退出

使用rubydebug显示详细输出,codec为一种编码器

logstash -e 'input { stdin{} } output { stdout{} }'

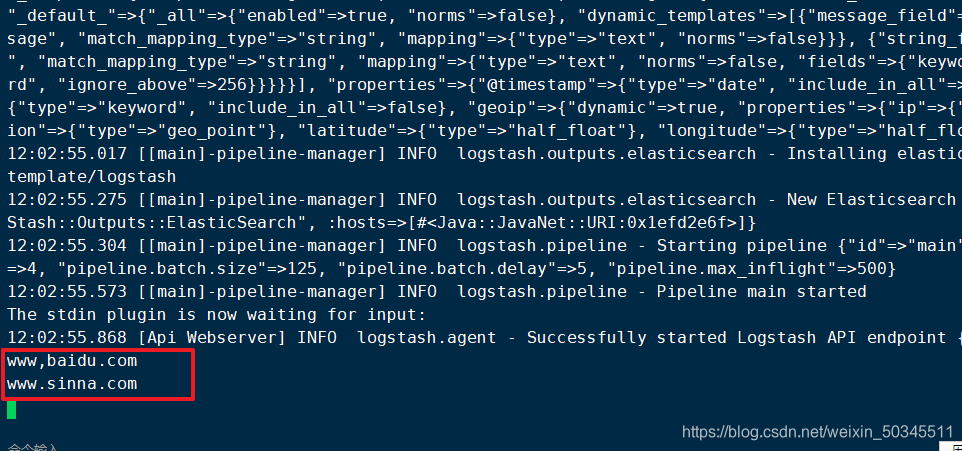

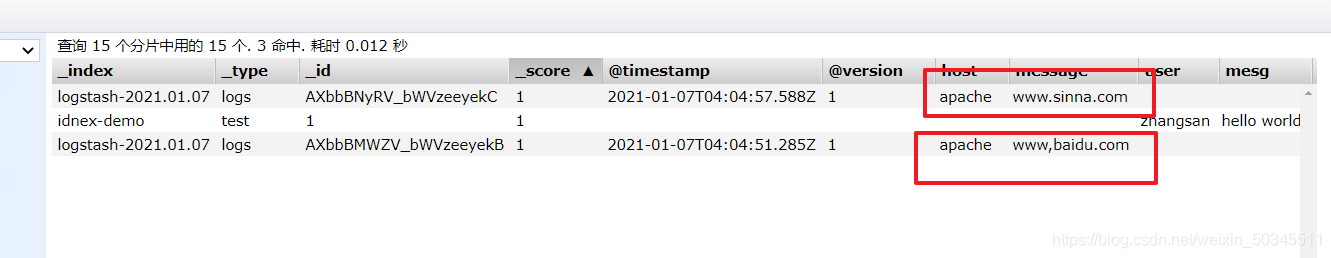

使用logstash将信息写入elasticsearch

logstash -e 'input { stdin{} } output { elasticsearch { hosts=>["20.0.0.31:9200"] } }'

去浏览器查看

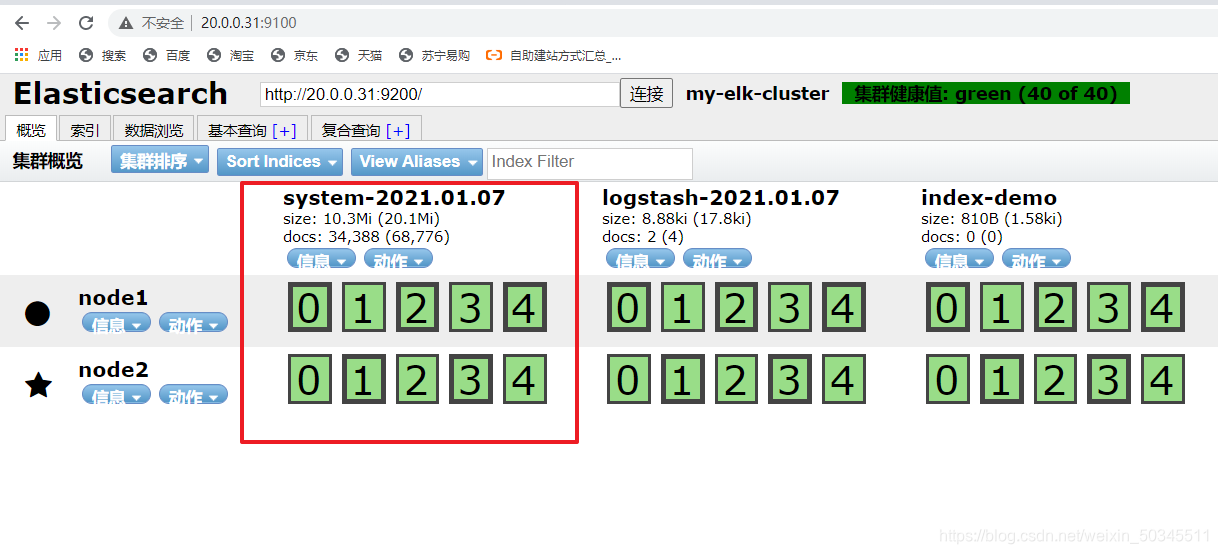

2.3.3 通过logstash收集系统日志

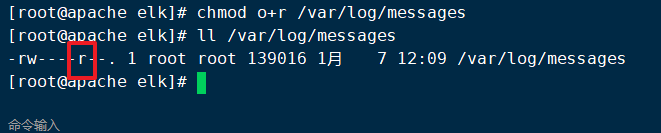

日志信息给其它用户加读的权限

chmod o+r /var/log/messages

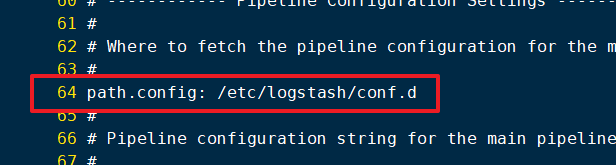

vi /etc/logstash/conf.d/system.conf

input {

file{

path => "/var/log/messages"

type => "system"

start_position => "beginning"

}

}

output {

elasticsearch {

hosts => ["20.0.0.31:9200"]

index => "system-%{+YYYY.MM.dd}"

}

}

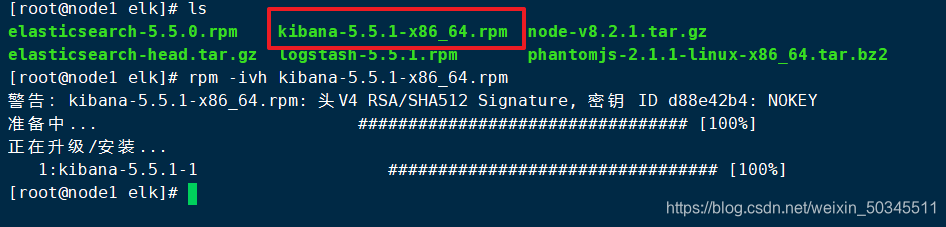

2.3 安装kibana

rpm -ivh kibana-5.5.1-x86_64.rpm

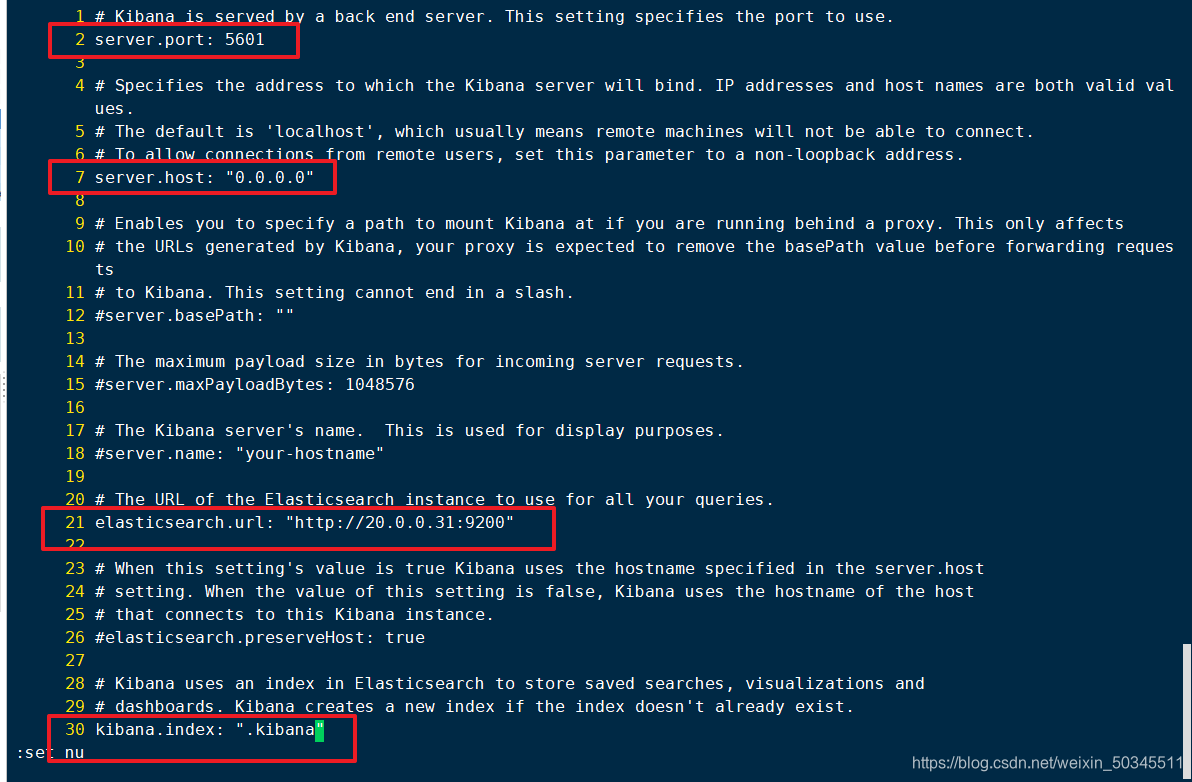

cp /etc/kibana/kibana.yml kibana.yml.bak

vi /etc/kibana/kibana.yml

2 server.port: 5601 kibana打开的端口

7 server.host: "0.0.0.0" kibana侦听所有网段地址

21 elasticsearch.url: "http://20.0.0.11:9200" 和elasticsearch建立联系

30 kibana.index: ".kibana" 在elasticsearch中添加.kibana索引

启动kibana

systemctl start kibana.service

systemctl enable kibana.service

三 、测试ELK

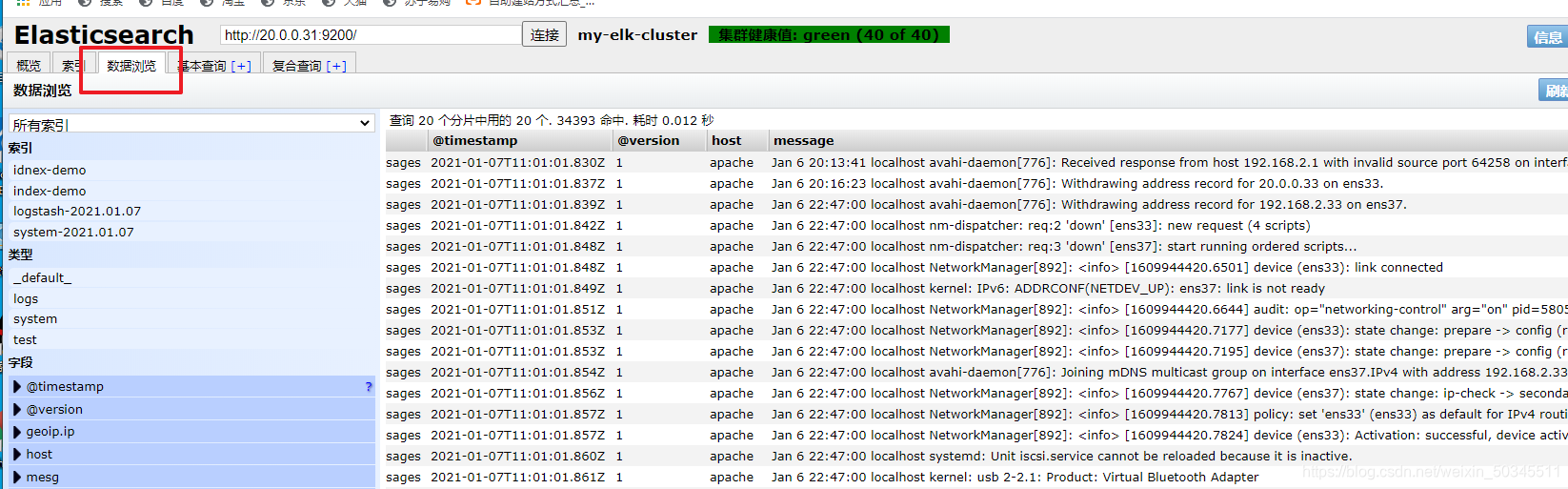

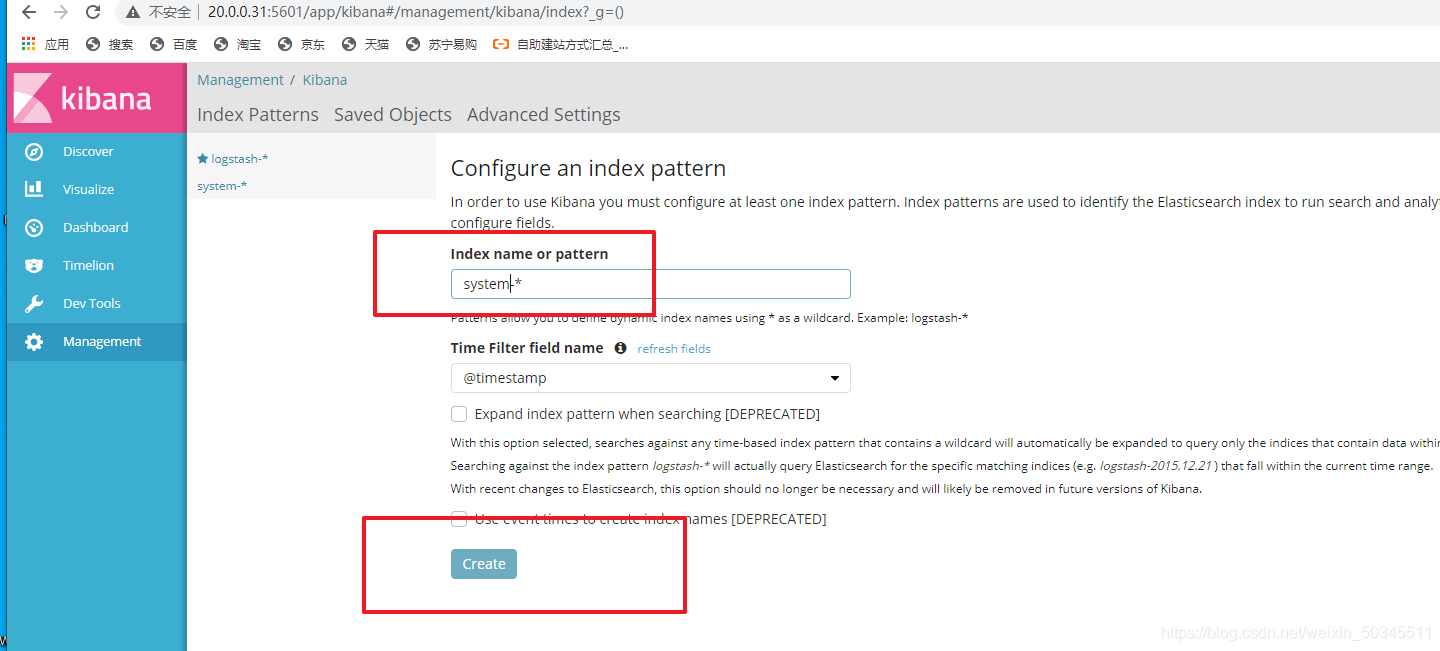

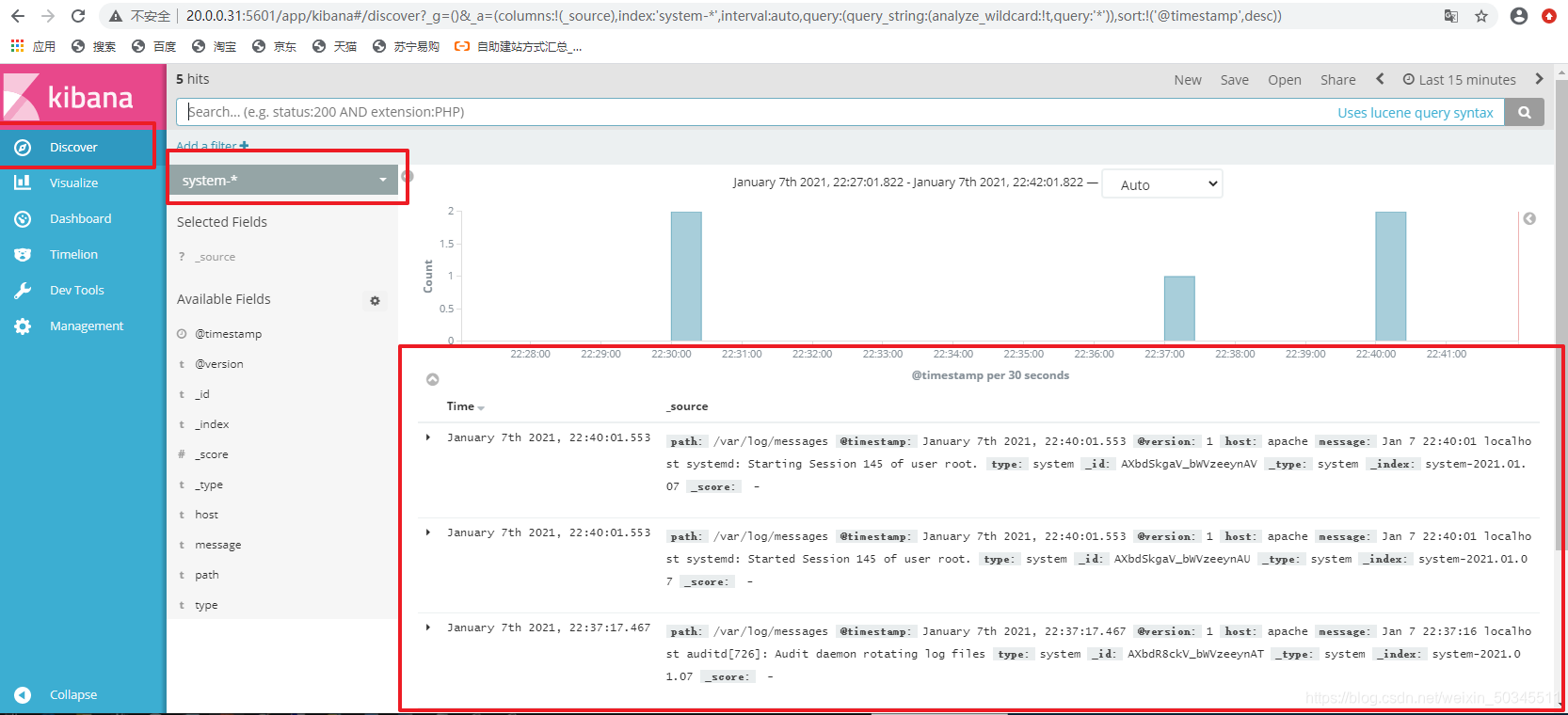

3.1 测试kibana对系统日志文件分析

在浏览器输入node1IP地址并带上端口号(20.0.0.31:5601)

对接系统日志,并点击下面的Create(创建)

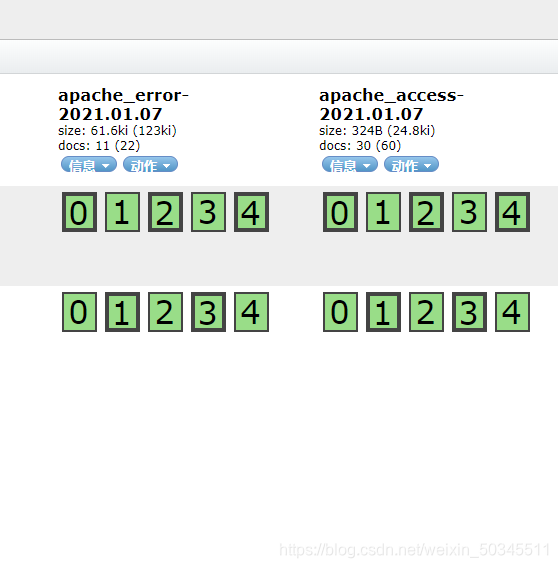

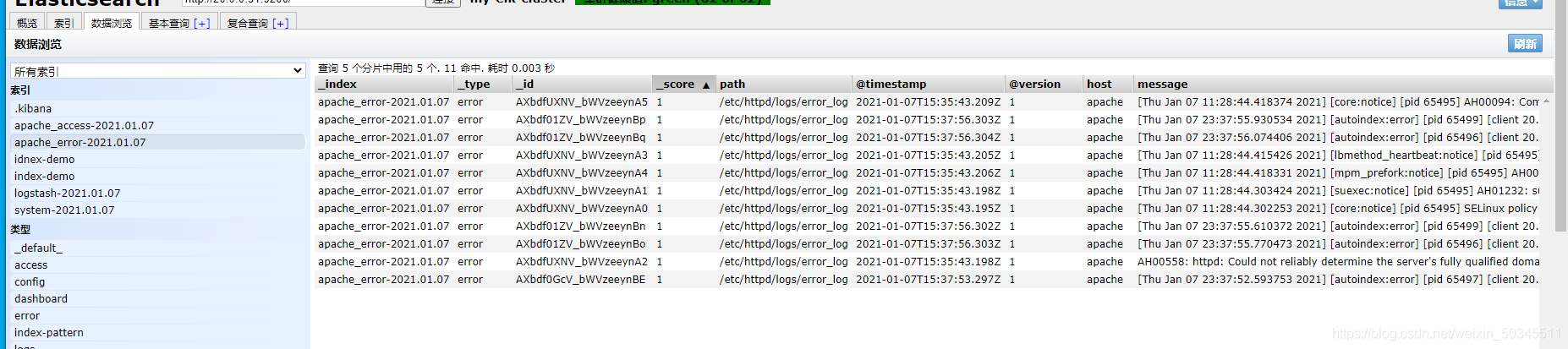

3.2 对接apache主机上的apache日志文件

vi /etc/logstash/conf.d/apache_log.conf

input {

file{

path => "/etc/httpd/logs/access_log"

type => "access"

start_position => "beginning"

}

file{

path => "/etc/httpd/logs/error_log"

type => "error"

start_position => "beginning"

}

}

output {

if [type] == "access" {

elasticsearch {

hosts => ["20.0.0.31:9200"]

index => "apache_access-%{+YYYY.MM.dd}"

}

}

if [type] == "error" {

elasticsearch {

hosts => ["20.0.0.31:9200"]

index => "apache_error-%{+YYYY.MM.dd}"

}

}

}

cd /etc/logstash/conf.d/

logstash -f apache_log.conf

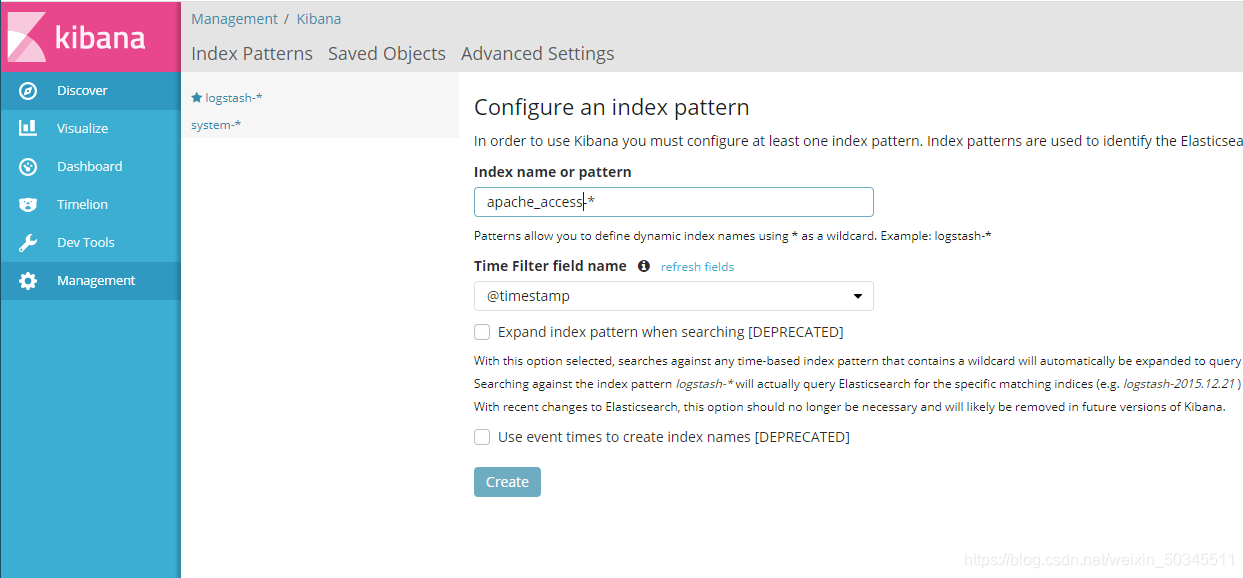

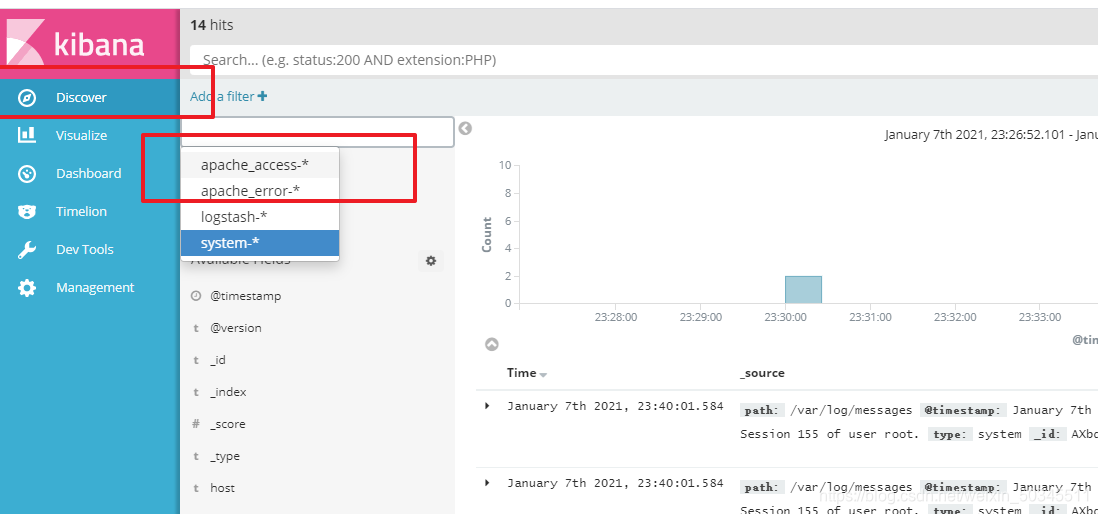

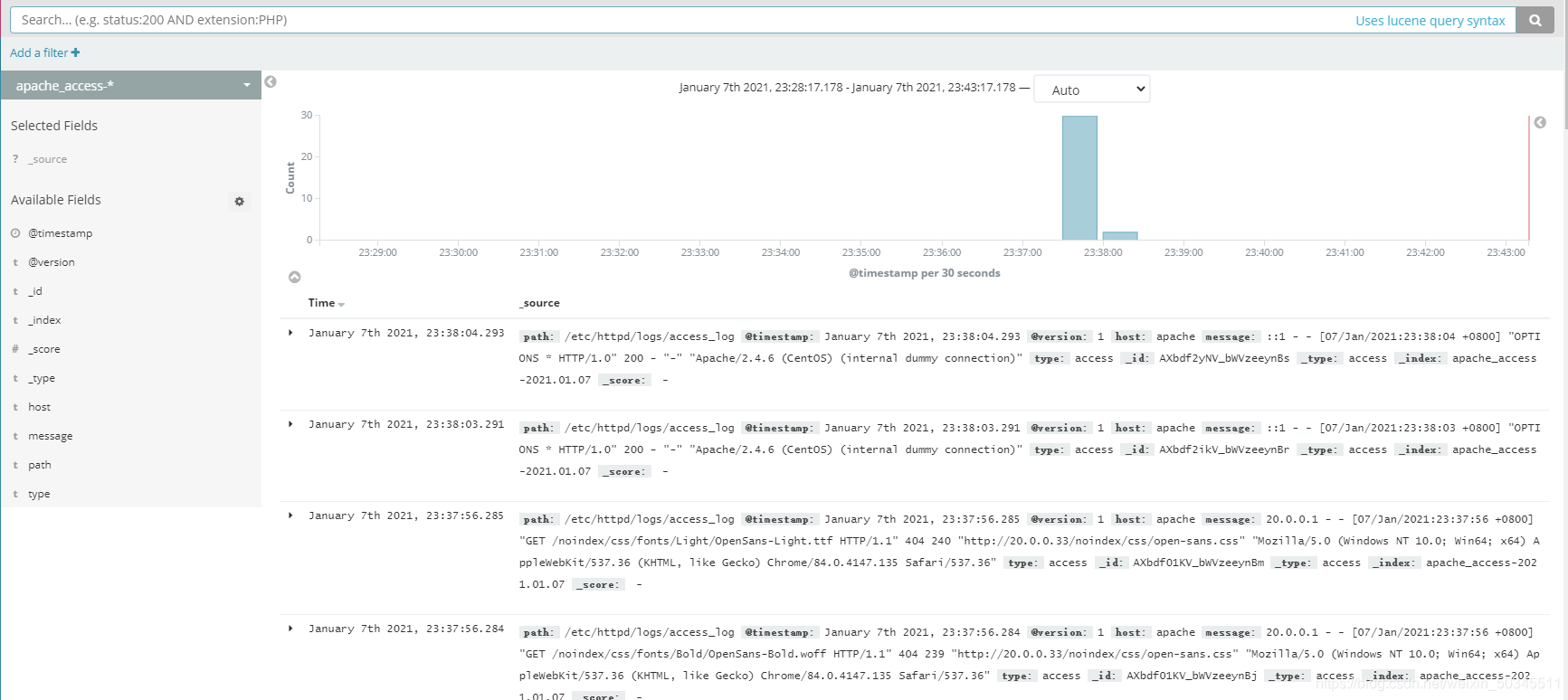

3.1 测试kibana对apache日志文件分析