Hive是什么?

由facebook开源的用于解决海量结构化日志的数据统计,后称Apache Hive 的开源项目。

Hive是基于Hadoop文件系统上的数据仓库架构。存储用HDFS,计算用MR。它为数据仓库管理提供大量功能,如数据ETL(详细看前文)工具,数据存储管理与大型数据查询和分析能力。

同时Hive还定义了类SQL语言–Hive QL,允许用户进行和SQL相似的操作。他可以将结构化数据的数据文件转化为一张数据表,并提供简单的查询功能。可以将SQL转化为MapReduce语句。

Hive可以理解成为一个工具,不存在主从结构,不用安装到每台机器上,只需要安装几台就行了。

默认数据库:derby,后期转换成关系型数据库mysql。

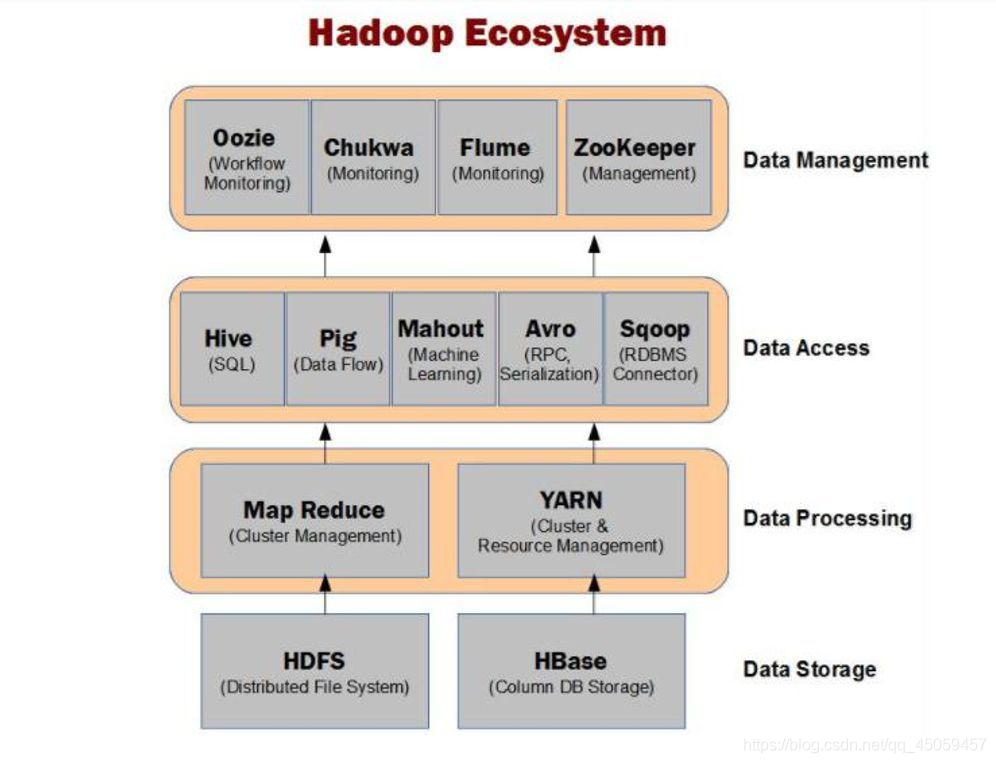

看看下图hive在Hadoop生态系统中的位置。

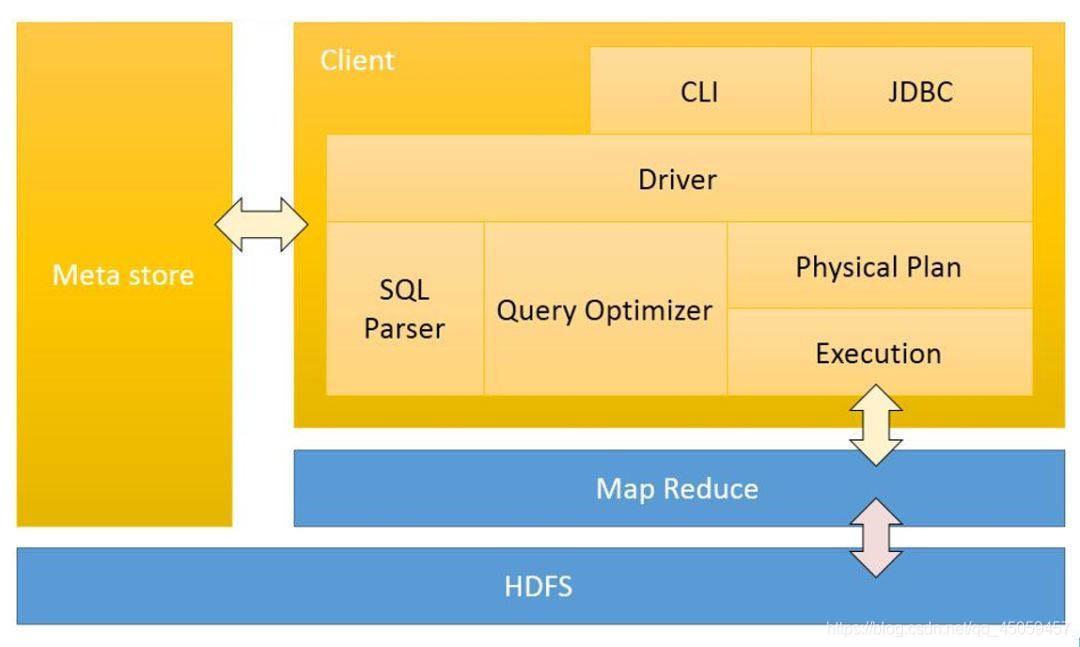

接着看下Hive体系结构。

Meta store引进元数据。

HDFS和MapReduce。最原始的数据其实还是在HDFS上,并且在跑一些SQL语句的时候,内部实际上是跑MapReduce。

Client客户端。可通过JDBC或者CLI提交任务到Driver上面运行,SQL Parser将数据变化成抽象语法树,然后解析成Physical Plan放到Execution上执行(其实也是在MR中执行)。

这边注意,meta store并不是数据库,而是数据!存放元数据的具体信息。

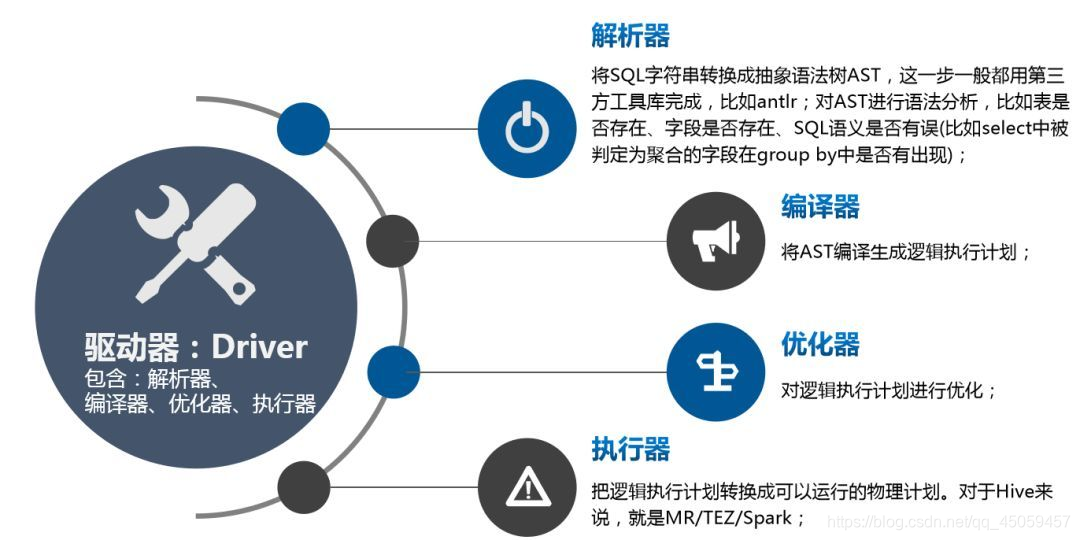

下面就是对Driver的详细拆解。

这里可以结合上面的图进行理解。

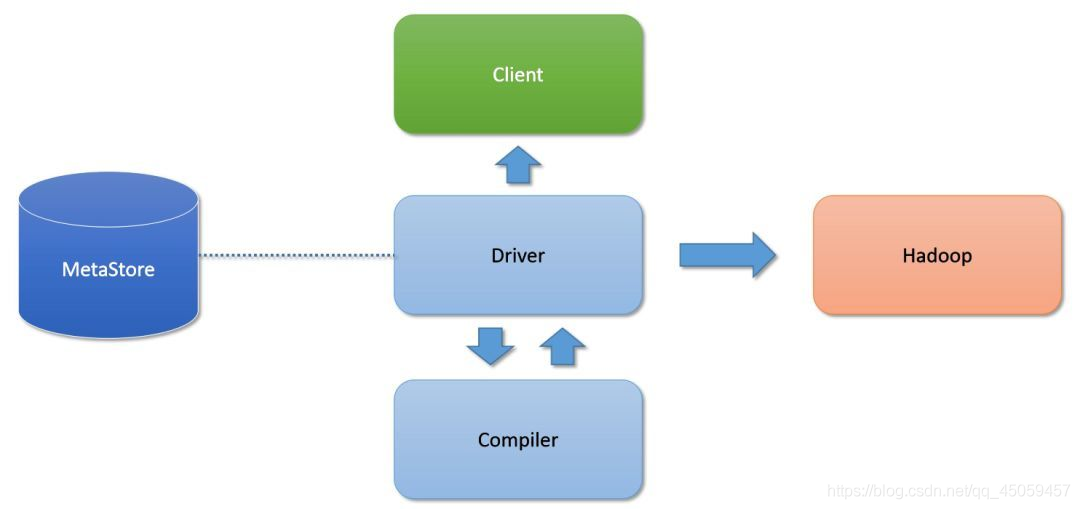

下面的话是整体流程。

这里再客户端提交了任务,先读取meta data找到元数据信息,包括存放位置,大小等,然后再放到Driver进行解析,然后放到map reduce上跑。

出处:

参考文献

总结:Hive必须在Hadoop环境下安装

1 hive2.3.6数据仓库安装

1.1 Master 节点安装 MySQL 软件

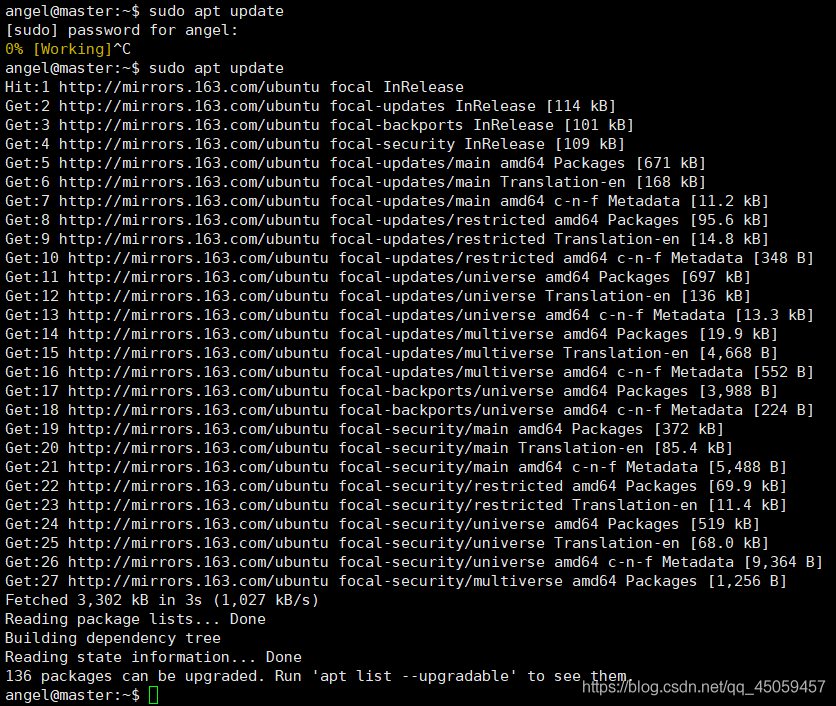

sudo apt update

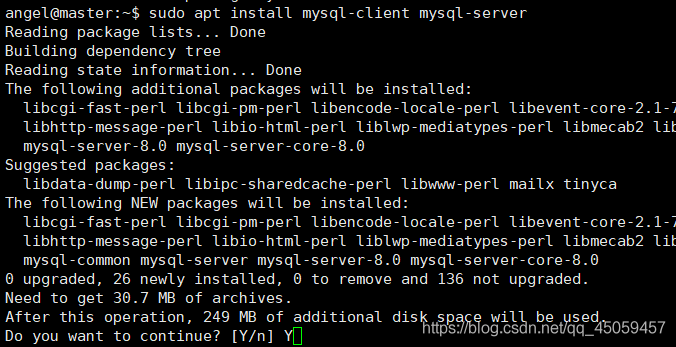

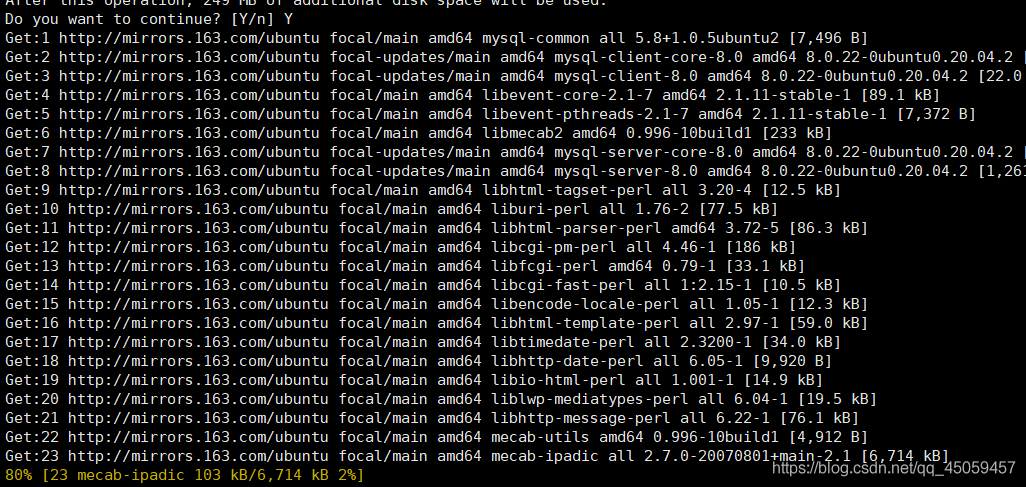

1.1.1 安装 MySQL

注:apt为在线更新,有时候更新不了。

原因:电脑连接wifi和连接网线的dns不同

解决办法:查看dns,若你需要连接网线,就换网线的dns;若你需要连接wifi,就换wifi的dns。

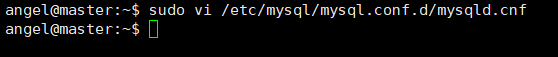

1.1.2 设置 MySQL 参数

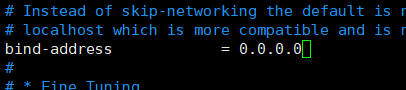

sudo vi /etc/mysql/mysql.conf.d/mysqld.cnf

bind-address = 127.0.0.1 改为 0.0.0.0

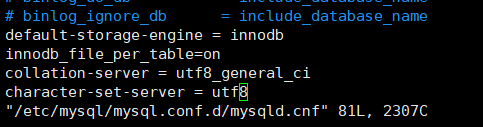

最后添加:

default-storage-engine = innodb

innodb_file_per_table=on

collation-server = utf8_general_ci

character-set-server = utf8

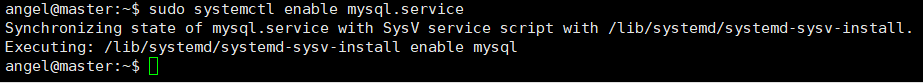

1.1.3 设置开机自动启动

sudo systemctl enable mysql.service

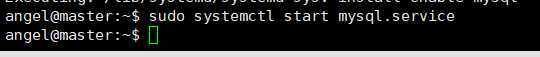

1.1.4 启动 MySQL 服务

sudo systemctl start mysql.service

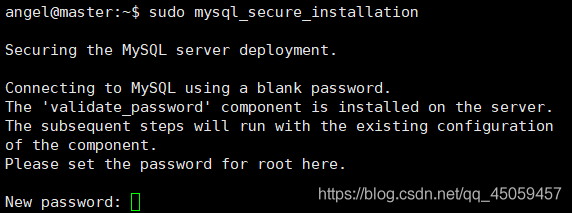

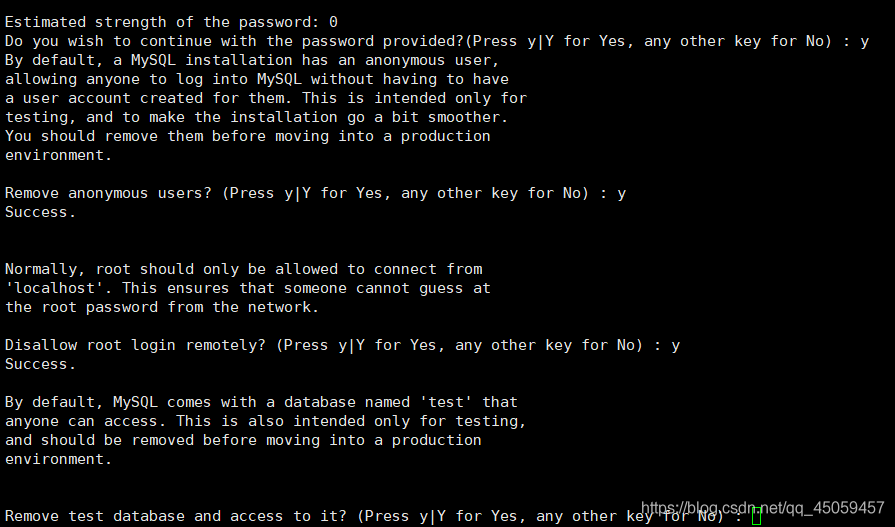

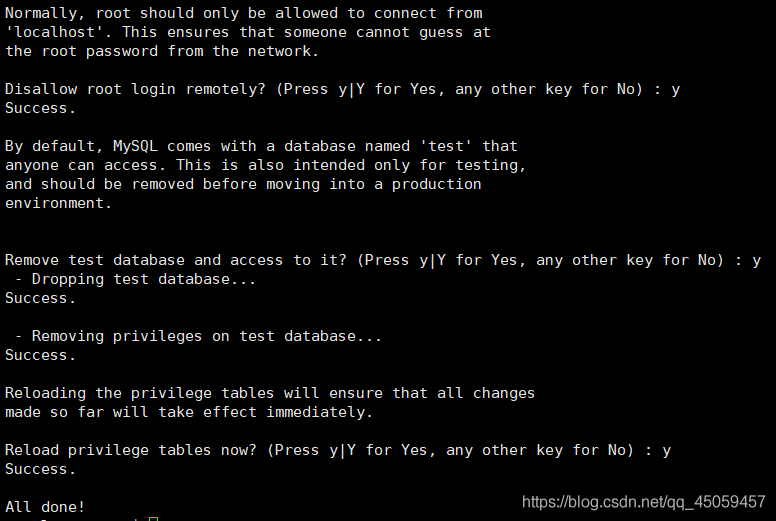

1.1.5 初始化 MySQL

sudo mysql_secure_installation

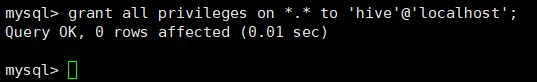

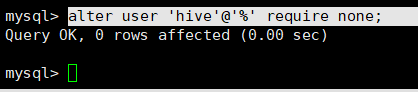

1.1.6 给 MySQL 用户 hive 授权

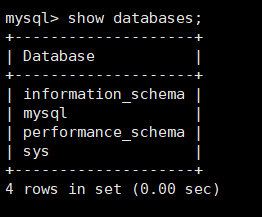

sudo mysql -uroot -p123456

show databases;

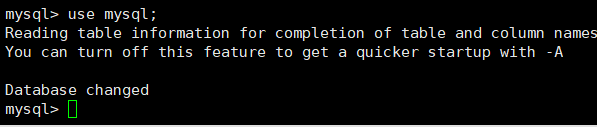

use mysql;

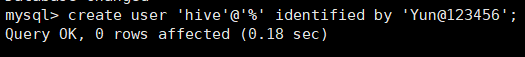

create user ‘hive’@’%’ identified by ‘Yun@123456’;

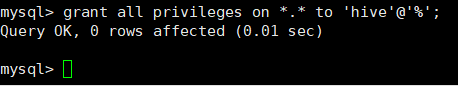

grant all privileges on *.* to 'hive'@'%';

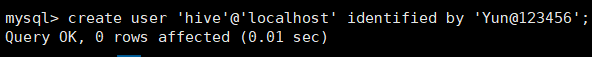

create user ‘hive’@‘localhost’ identified by ‘Yun@123456’;

grant all privileges on *.* to 'hive'@'localhost';

alter user ‘hive’@’%’ require none;

1.1.7 重启 MySQL 服务

sudo systemctl restart mysql.service

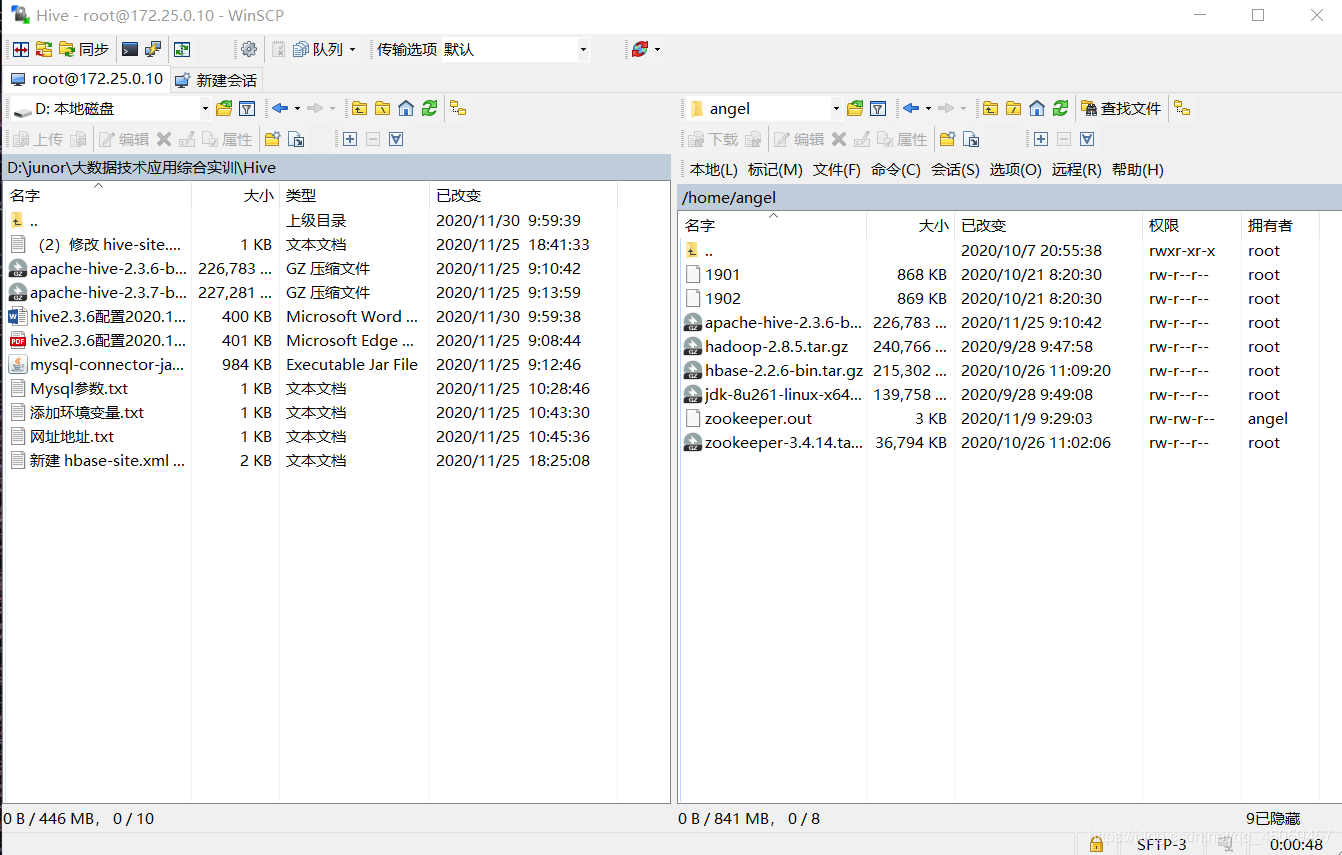

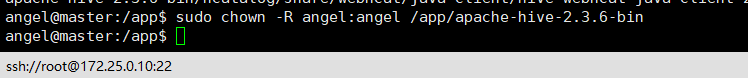

2 Master 节点安装 Hive 软件

2.1 以用户 angel 登录 Master 节点,安装 Hive 软件

通过winscp将Hive上传到节点机

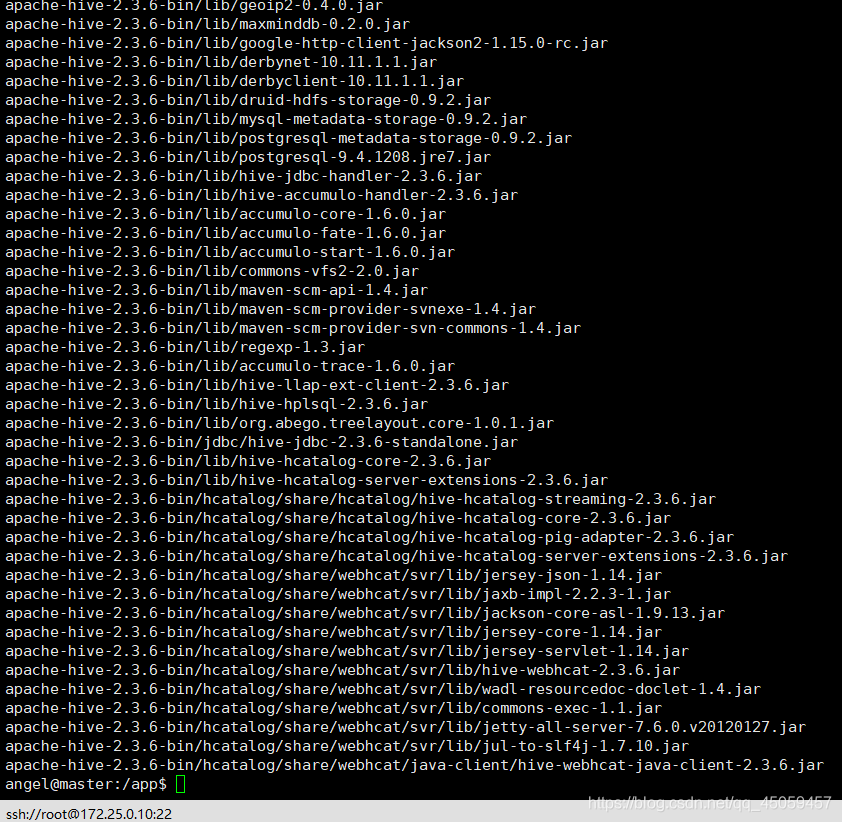

sudo tar xzvf /home/angel/apache-hive-2.3.6-bin.tar.gz

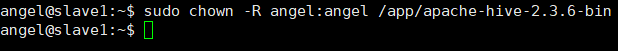

sudo chown -R angel:angel /app/apache-hive-2.3.6-bin

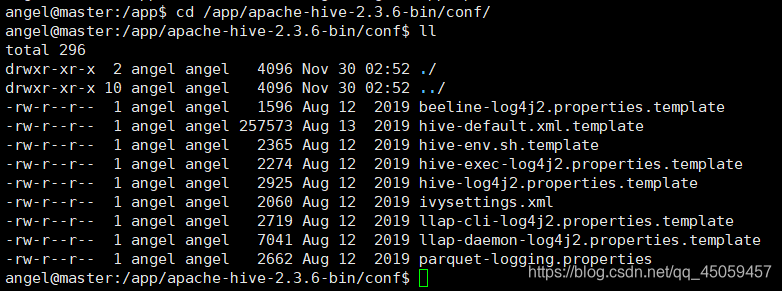

3 Master 节点设置 Hive 参数

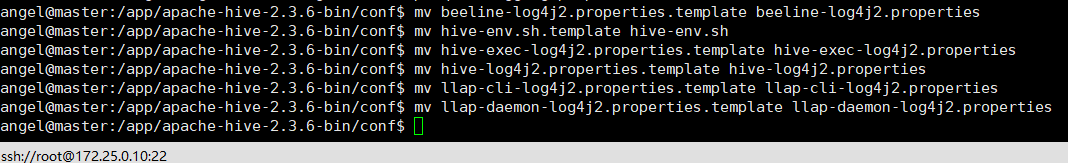

3.1 Hive 配置文件改名

cd /app/apache-hive-2.3.6-bin/conf

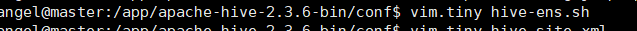

3.2 修改 hive-env.sh 文件

vim.tiny hive-ens.sh

添加:

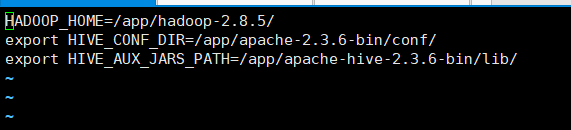

HADOOP_HOME=/app/hadoop-2.8.5/

export HIVE_CONF_DIR=/app/apache-2.3.6-bin/conf/

export HIVE_AUX_JARS_PATH=/app/apache-hive-2.3.6-bin/lib/

3.3 新建 hbase-site.xml 文件

添加内容:

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<property>

<name>hive.metastore.warehouse.dir</name>

<value>/hive/warehouse</value>

<description>location of default database for the warehouse</description>

</property>

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://master:3306/hive?createDatabaseIfNotExist=true&useSSL=false&allowPublicKeyRetrieval=true</value>

<description>JDBC connect string for a JDBC metastore.</description>

</property>

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

<description>Driver class name for a JDBC metastore</description>

</property>

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>hive</value>

<description>Username to use against metastore database</description>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>Yun@123456</value>

<description>password to use against metastore database</description>

</property>

<property>

<name>hive.querylog.location</name>

<value>/app/apache-hive-2.3.6-bin/logs</value>

<description>Location of Hive run time structured log file</description>

</property>

<property>

<name>hive.metastore.uris</name>

<value>thrift://master:9083</value>

<description>Thrift URI for the remote metastore. Used by metastore client to connect to remote metastore.</description>

</property>

<property>

<name>hive.server2.webui.host</name>

<value>0.0.0.0</value>

</property>

<property>

<name>hive.server2.webui.port</name>

<value>10002</value>

</property>

<property>

<name>hive.metastore.schema.verification</name>

<value>false</value>

</property>

</configuration>

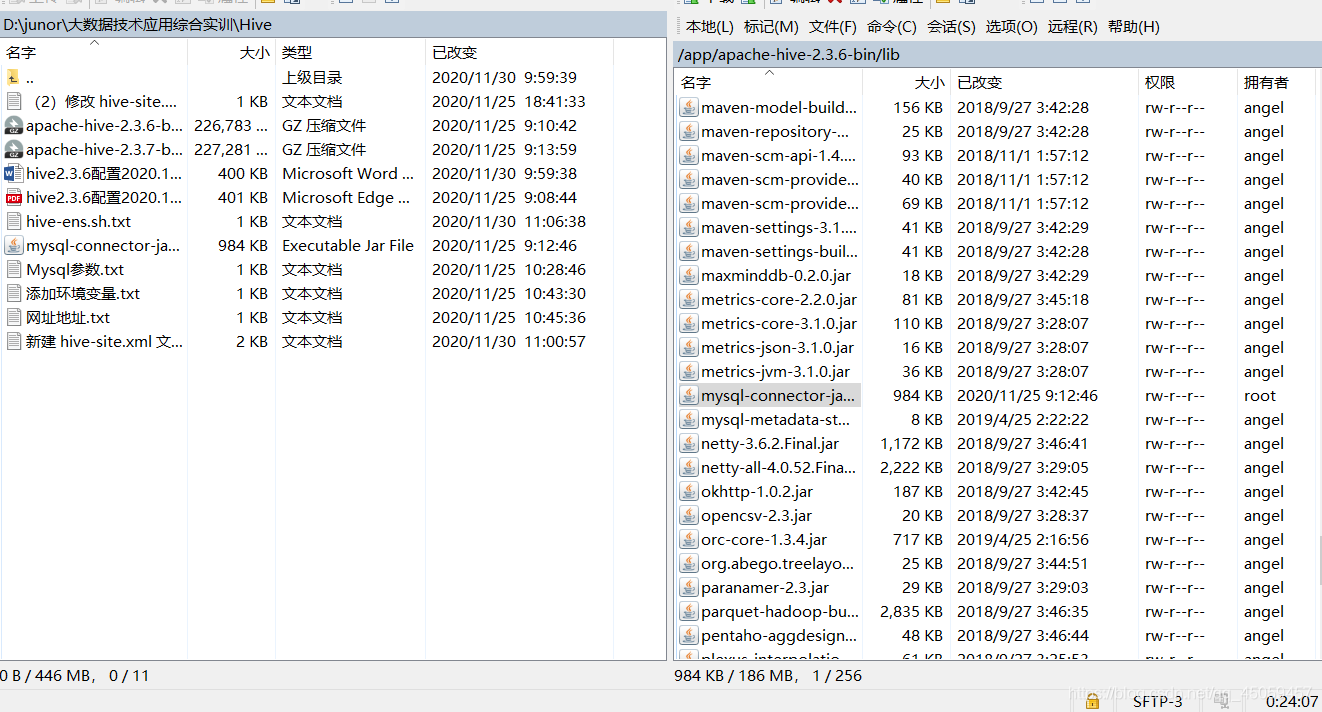

3.4 上传“mysql-connector-java-5.1.48.jar”连接包到/app/apache-hive-2.3.6-bin/lib 目录下

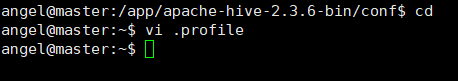

3.5 修改环境变量

3.6 环境变量生效

source .profile

4 Master 节点启动 Hive 服务

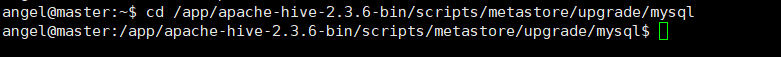

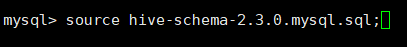

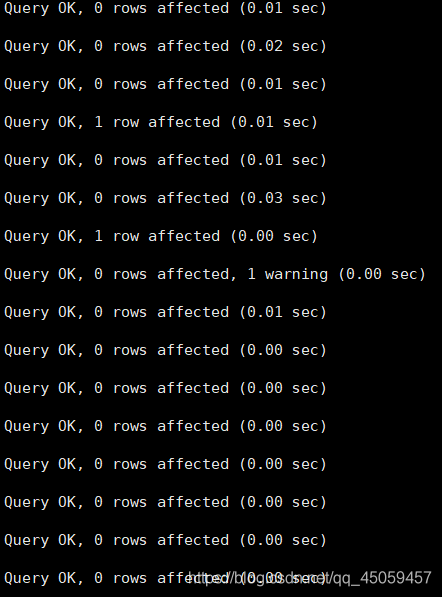

4.1 创建数据库 hive,导入 hive-schema

cd /app/apache-hive-2.3.6-bin/scripts/metastore/upgrade/mysql

mysql -hmaster -uhive -pYun@123456

source hive-schema-2.3.0.mysql.sql;

ctrl+D 退出。

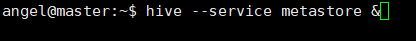

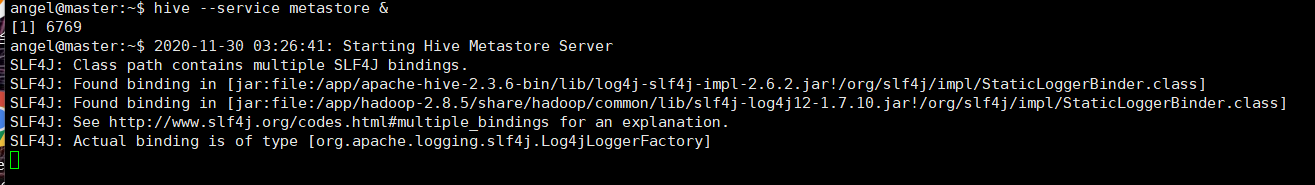

4.2 启动 hive metastore 服务

hive --service metastore &

按回车,再输入hive,就可以进入jice操作界面。

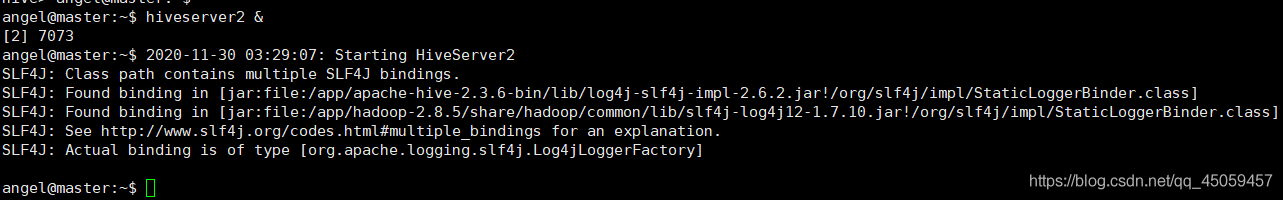

4.3 启动 hiveserver2 服务

hiveserver 2 &

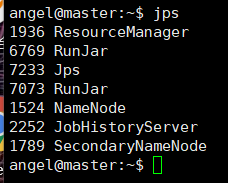

启动服务后,jps查看后台进程。

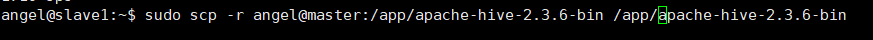

5 客户端主机安装 Hive 软件

5.1 以用户angel 登录客户端主机安装 Hive软件,客户端主机可以是任何一台Slave节点机或 desktop 主机

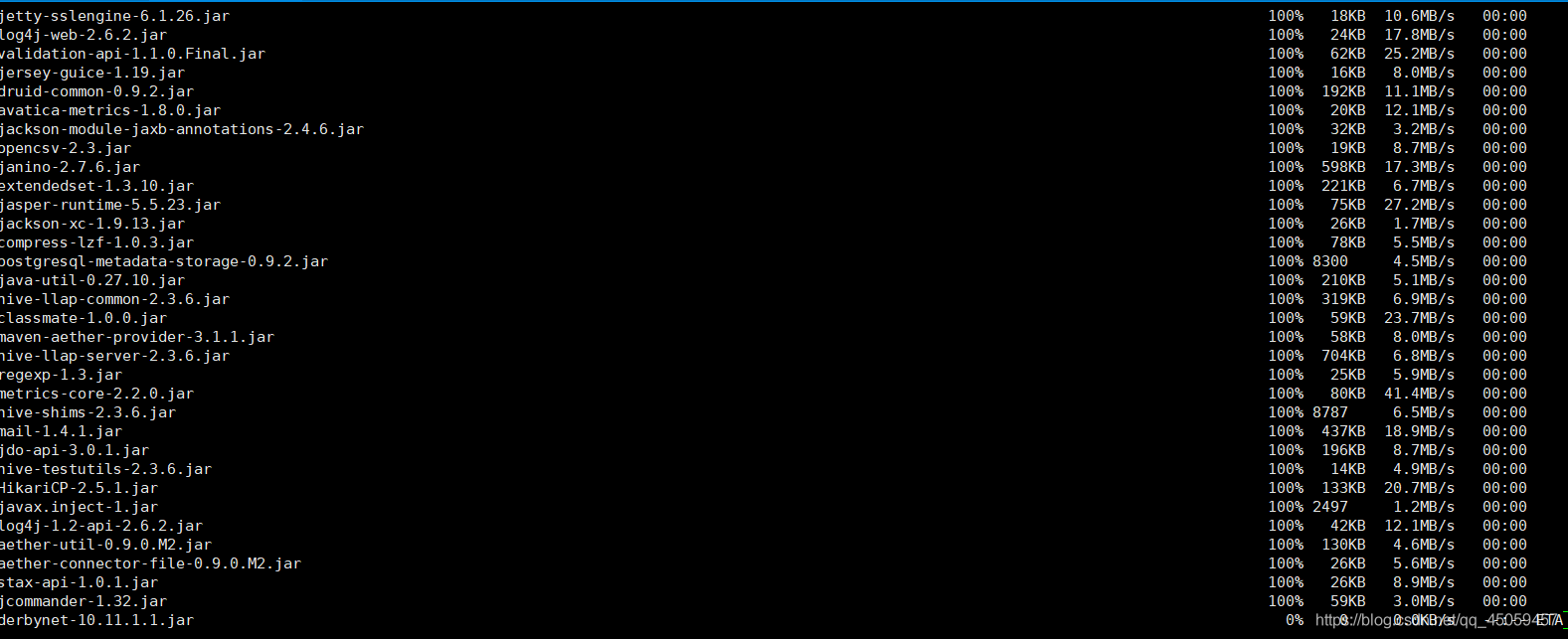

sudo scp -r angel@master:/app/apache-hive-2.3.6-bin /app/apache-hive-2.3.6-bin

输入angel用户密码

输入master的root密码

sudo chown -R angel:angel /app/apache-hive-2.3.6-bin

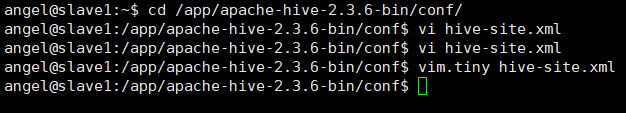

5.2 修改 hive-site.xml 文件

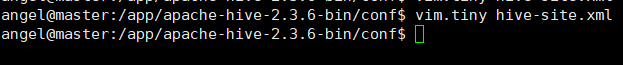

cd /app/apache-hive-2.3.6-bin/conf/

vim.tiny hive-site.xml

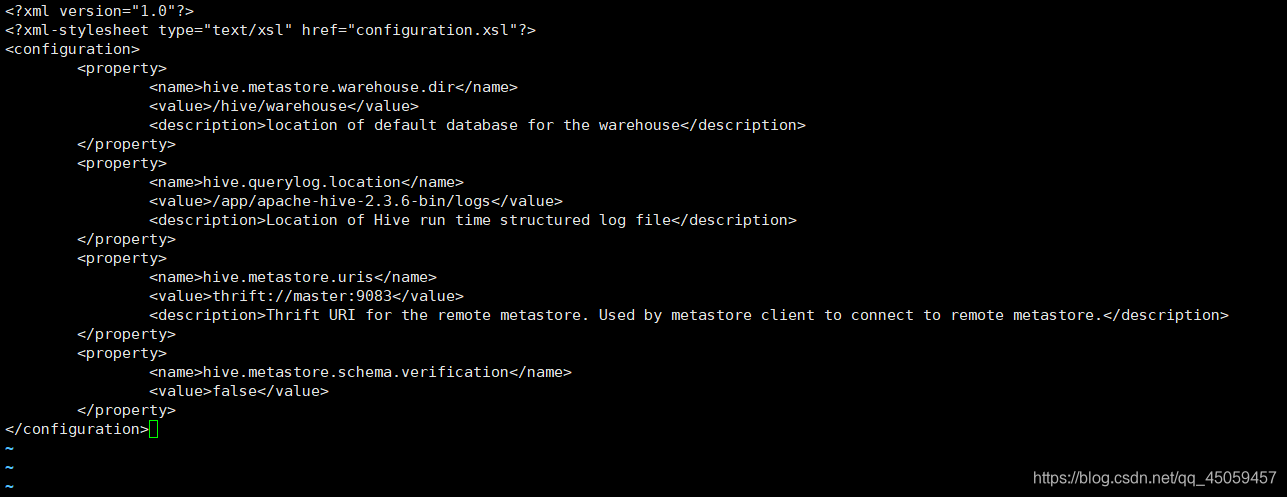

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<property>

<name>hive.metastore.warehouse.dir</name>

<value>/hive/warehouse</value>

<description>location of default database for the warehouse</description>

</property>

<property>

<name>hive.querylog.location</name>

<value>/app/apache-hive-2.3.6-bin/logs</value>

<description>Location of Hive run time structured log file</description>

</property>

<property>

<name>hive.metastore.uris</name>

<value>thrift://master:9083</value>

<description>Thrift URI for the remote metastore. Used by metastore client to connect to remote metastore.</description>

</property>

<property>

<name>hive.metastore.schema.verification</name>

<value>false</value>

</property>

</configuration>

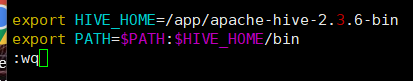

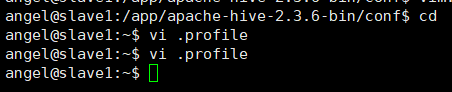

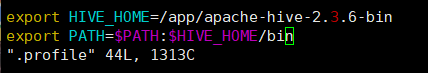

5.3 修改环境变量

添加内容:

export HIVE_HOME=/app/apache-hive-2.3.6-bin

export PATH=$PATH:$HIVE_HOME/bin

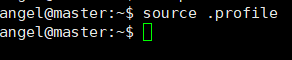

激活环境变量

source .profile

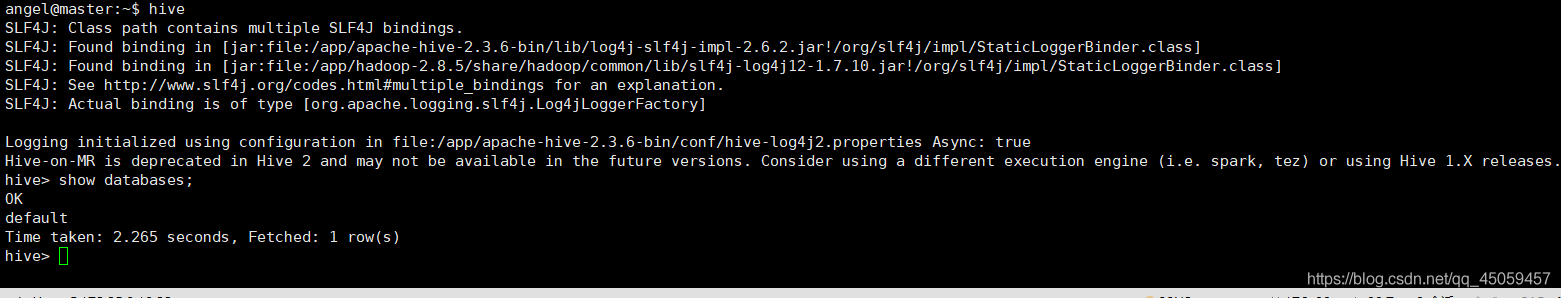

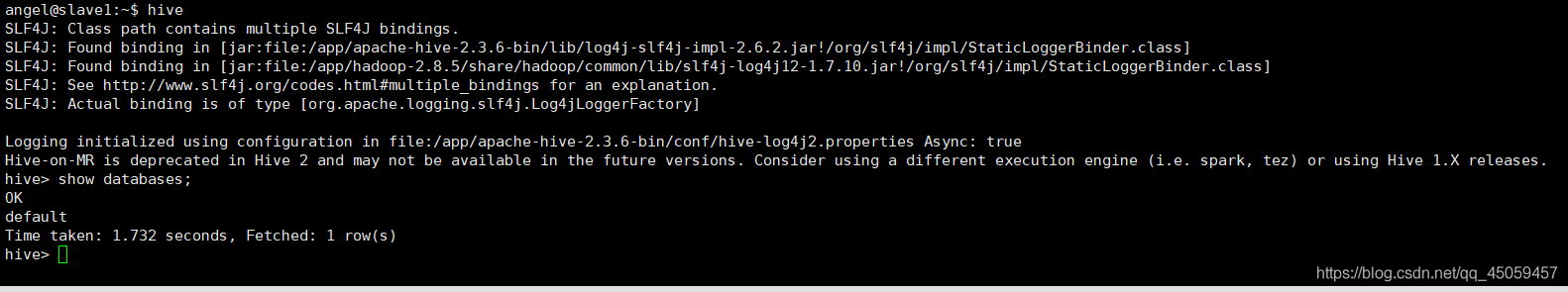

6 测试 Hive

6.1 客户端主机测试 Hive

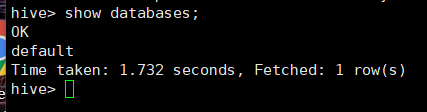

6.2 查看数据库

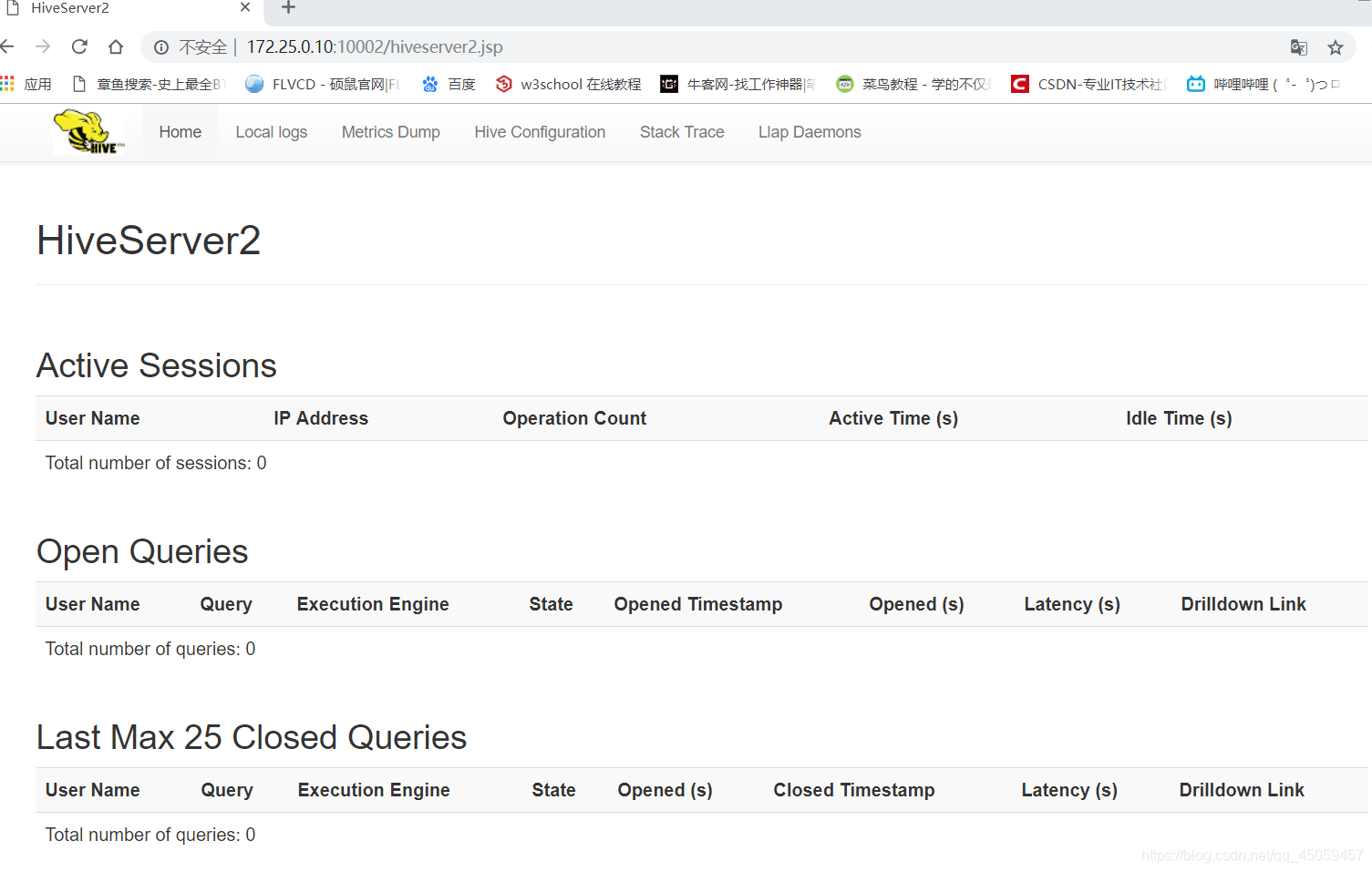

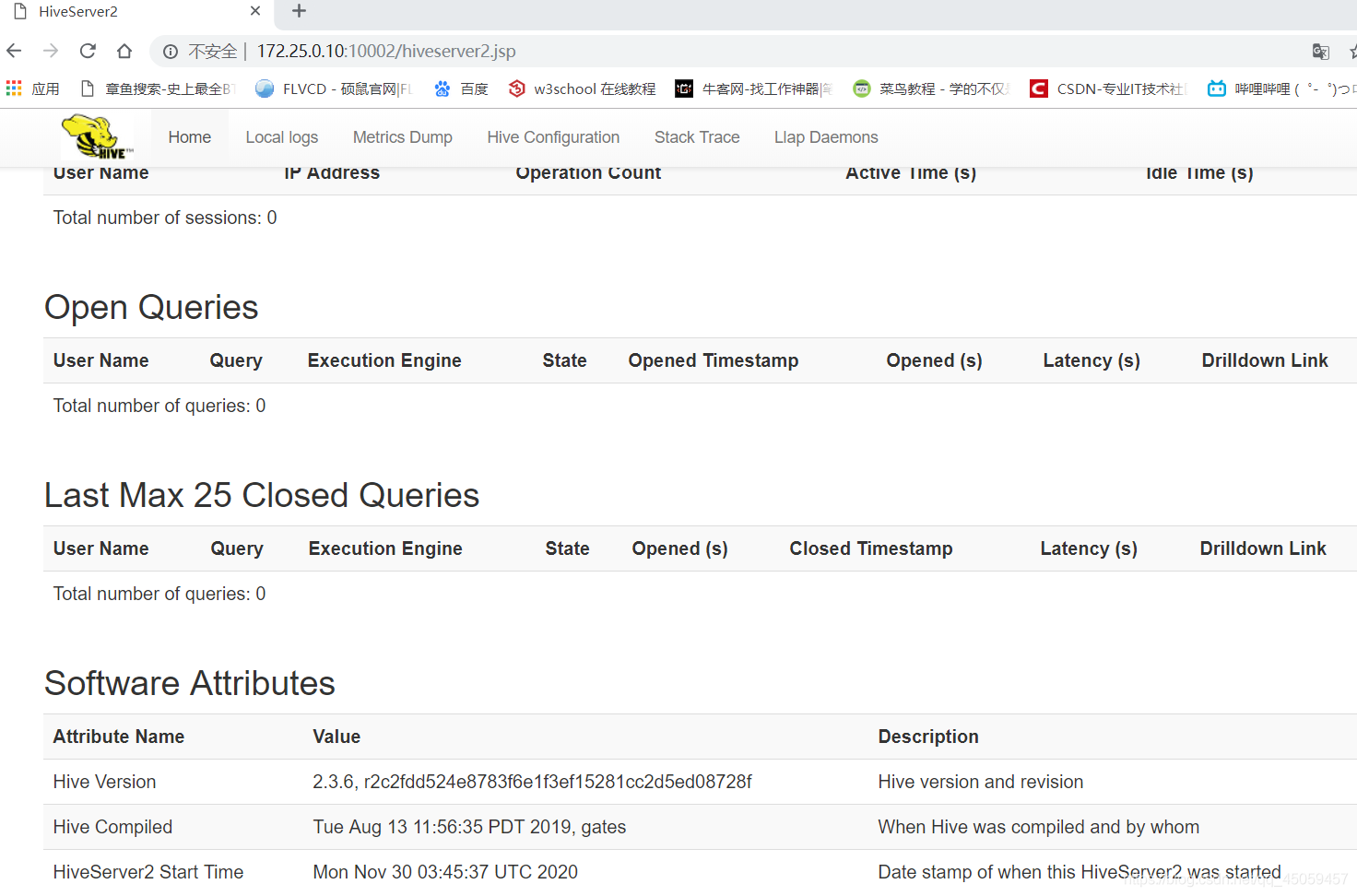

6.3 打开浏览器输入“http://172.25.0.10:10002/hiveserver2.jsp ”,查看 hiveserver2 服务

到此,hive数据仓库安装成功!