前言

在github可以看到Opencv的所有源代码

- openCV官网:https://opencv.org/

- openCV github:https://github.com/opencv/opencv

- Opencv-python 是接口(API)

- Opencv-python

一、实战演示

1.1 调用摄像头实时显示画面

示例代码:

# 以下代码基本是是所用以后调用摄像头的基础

# 调用摄像头,实时展示画面

# 2020-03-06

import cv2

# 获取摄像头

# 0是系统默认的摄像头 若电脑上有好几个摄像头 可以是0 1 2 3

cap = cv2.VideoCapture(0,cv2.CAP_DSHOW)

# 打开cap

cap.open(0) #摄像头会亮

# 循环

while cap.isOpened():

# 获取画面

# 从摄像头中获取一帧一帧的画面

# flag:true获取画面成功 flase:失败

# frame 获取到的画面本身 Numpy三维数组

flag,frame = cap.read()

# 窗口名字 my_window

cv2.imshow('my_window',frame)

# 获取键盘上按下哪个键

# 每60ms监听一次

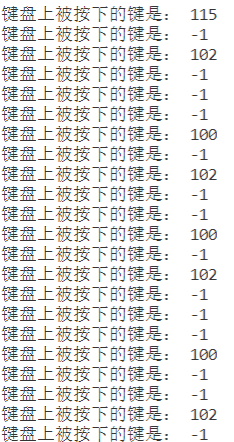

key_pressed= cv2.waitKey(60)

print('键盘上被按下的键是:',key_pressed)

# 如果按下esc键,则退出循环

# 键盘上每一个键都有它的编号

if key_pressed == 27:

break

# 关闭摄像头 摄像头不再捕获画面

cap.release()

# 关闭图像窗口 桌面不再显示获取到的图像

cv2.destoryAllwindows()

运行结果:

-

博主的运行展示

-

我的按键部分记录情况,摄像头画面不在此展示

1.2 实时边缘检测

边缘检测可以看我这篇文章:

Python之图像处理OpenCV 2.2 边缘检测

代码如下:

import cv2

import numpy as np

# 获取摄像头

# 0是系统默认的摄像头 若电脑上有好几个摄像头 可以是0 1 2 3

cap = cv2.VideoCapture(0,cv2.CAP_DSHOW)

# 打开cap

cap.open(0) #摄像头会亮

# 循环 如果按下esc键,则退出循环

while cap.isOpened():

# 获取画面

# 从摄像头中获取一帧一帧的画面

# flag:true获取画面成功 flase:失败

# frame 获取到的画面本身 Numpy三维数组

flag,frame = cap.read()

if not flag: #没有获取成功 退出

break

# 每60ms监听一次 获取键盘上按下哪个键

key_pressed= cv2.waitKey(60)

print('键盘上被按下的键是:',key_pressed)

# frame = cv2.resize(frame,(100,100))

# 进行Canny边缘检测 返回单通道图像

# 100,195可以进行修改 不同的阈值有不同的结果

frame = cv2.Canny(frame,100,200)

# 将单通道图复制三份,摞成三通道图像

frame = np.dstack((frame,frame,frame))

# 展示处理后的三通道图像e

cv2.imshow('my_window',frame)

# 如果按下esc键,则退出循环

# 键盘上每一个键都有它的编号

if key_pressed == 27:

break

# 关闭摄像头 摄像头不再捕获画面

cap.release()

# 关闭图像窗口 桌面不再显示获取到的图像

cv2.destoryAllwindows()

运行结果:

- 博主

- 我的

- 补充

1.3 实时人脸+眼睛+微笑识别

在运行该代码时,用作者的代码没有出现bug但是自己跟着敲的代码出现bug—头大

代码展示:

# 调用电脑摄像头实时人脸+眼睛+微笑识别 可直接复制粘贴运行

# 导入opencv-python

import cv2

# 载入人脸检测器、眼睛检测器、微笑检测器

face_cascade = cv2.CascadeClassifier(cv2.data.haarcascades+'haarcascade_frontalface_default.xml')

eye_cascade = cv2.CascadeClassifier(cv2.data.haarcascades+'haarcascade_eye.xml')

smile_cascade = cv2.CascadeClassifier(cv2.data.haarcascades+'haarcascade_smile.xml')

# 调用摄像头

cap = cv2.VideoCapture(0)

while(True):

# 获取摄像头拍摄到的画面

ret, frame = cap.read()

faces = face_cascade.detectMultiScale(frame, 1.3, 2)

img = frame

for (x,y,w,h) in faces:

# 画出人脸框,蓝色,画笔宽度微

img = cv2.rectangle(img,(x,y),(x+w,y+h),(255,0,0),2)

# 框选出人脸区域,在人脸区域而不是全图中进行人眼检测,节省计算资源

face_area = img[y:y+h, x:x+w]

## 人眼检测

# 用人眼级联分类器引擎在人脸区域进行人眼识别,返回的eyes为眼睛坐标列表

eyes = eye_cascade.detectMultiScale(face_area,1.3,10)

for (ex,ey,ew,eh) in eyes:

#画出人眼框,绿色,画笔宽度为1

cv2.rectangle(face_area,(ex,ey),(ex+ew,ey+eh),(0,255,0),1)

## 微笑检测

# 用微笑级联分类器引擎在人脸区域进行人眼识别,返回的eyes为眼睛坐标列表

smiles = smile_cascade.detectMultiScale(face_area,scaleFactor= 1.16,minNeighbors=65,minSize=(25, 25),flags=cv2.CASCADE_SCALE_IMAGE)

for (ex,ey,ew,eh) in smiles:

#画出微笑框,红色(BGR色彩体系),画笔宽度为1

cv2.rectangle(face_area,(ex,ey),(ex+ew,ey+eh),(0,0,255),1)

cv2.putText(img,'Smile',(x,y-7), 3, 1.2, (0, 0, 255), 2, cv2.LINE_AA)

# 实时展示效果画面

cv2.imshow('frame2',img)

# 每5毫秒监听一次键盘动作

if cv2.waitKey(5) & 0xFF == ord('q'):

break

# 最后,关闭所有窗口

cap.release()

cv2.destroyAllWindows()

- ord(‘q’):返回q对应的Unicode码对应的值,q对应的Unicode数值为113。

- cv2.waitKey(1):返回与按下键值对应的32位整数。

- 0xFF:0xFF是一个位掩码,它将左边的24位设置为0。因为ord()在0和255之间返回一个值,因为您的键盘只有一个有限的字符集。

运行结果:

- 博主

- 我的

总结

1.opencv打开摄像头与DShow相关:

opencv打开摄像头与DShow相关

(我也不是很理解这个参数什么意思,若是有新的理解会及时补充)