(1) 二者应用不同

一般Linear Regression是解决回归问题,而 Logistic Regression是应用于分类问题。

Logistic Regression除了可以解决二分类问题外,还可以解决多分类问题。

采用 Logistic Regression进行多分类的思路是:选取某个分类作为正样本,其他分类作为负样本建立一个二分类模型;以此类推建立多个(有几个分类就建几个)二分类模型;对多个二分类模型的输出值进行大小比较,把样例归为输出值最大的那类。

(2)二者的代价函数不同

Linear Regression的代价函数为:

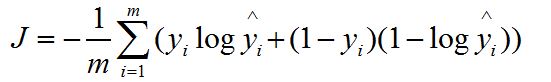

Logistic Regression的代价函数为:

二者的模型不同导致二者的代价函数不同:

这二者的代价函数不同,是因为定义的H假设不同,也就是模型不同(废话!一个是线性回归,一个是logistic回归,这就是两个模型怎么会相同)。接下来让我们来回顾一个各自的模型。

Linear Regression的模型为:

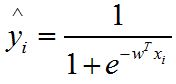

Logistic Regression的模型为:

备注:模型与代价函数之间的关系:例如 Linear Regression的模型

也就是说预测模型与损失函数之间并没有直接的推导关系或者叫做联系,它的损失函数是认为规定的(使用这个损失函数更有利于预测)

Logistic Regression与sigmode函数的关系:

Logistic Regression 从本质来说属于二分类问题,是基于Sigmoid函数(又叫“S型函数”)的有监督二类分类模型。

Sigmoid函数公式为:

Sigmoid函数其图像如下所示,其取值范围被压缩到0到1之间。

同理:Logistic Regression最大的特点就是将函数值收缩到[0,1]这个范围,但是这个特点也导致假如logistics regression使用线性回归的代价函数:

将会非凸(该代价函数有多个局部最优点),这就导致采用梯度下降法进行求解很可能陷入局部最优点。

因此,Logistic Regression需要重新定义一个合适的代价函数:

事实证明上面给出新的代价函数是凸函数。

[机器学习笔记] Logistic Regression与Linear Regression的区别_梅森上校的博客-CSDN博客