从文本描述生成图像的人工智能自 2021 年初以来一直在快速发展。从 OpenAI 的 DALL-E 1 和 CLIP ,到 2022 年发布的DALL-E 2,谷歌推出了 Imagen 和 Parti,而 Craiyon 的 AI 图像在社交媒体已然泛滥。

而近日,Stability AI 宣布发布 Stable Diffusion,Stability AI 成立于 2020 年,旨在培育开源 AI 研究社区。此次开源的 Stable Diffusion 是 Stability AI、RunwayML、LMU Munich、EleutherAI 和 LAION 等知名 AI 实验室的研究人员合作的结果。

Stable Diffusion 是一个类似 DALL-E 2 的系统,可以从文本描述生成对应的图像。目前相关代码和经过训练的模型都在 GitHub 上开源,还有一个带有 Web 界面的托管版本可供用户测试。

Stable Diffusion 在 LAION-5B 数据库子集的 512x512 图像上训练潜在扩散模型,并使用 CLIP ViT-L/14 文本编码器来根据文本提示调整训练模型。凭借其 860M UNet 和 123M 文本编码器,该模型相对轻量级,但硬件方面最低也要 10GB VRAM 的 GPU。

与 DALL-E 2 不同,Stable Diffusion 的限制更宽松,它可以生成 DALL-E 2 中禁止的名人图像和其他敏感主题的图像。当然,Midjourney 或 Pixelz.ai 等其他 AI 系统也可以做到这一点,但它们无法达到 Stable Diffusion 中的高度多样性。此外,其他系统都不是开源的。

(下图为网友使用 Stable Diffusion 训练的“DALL-E 2 禁止的名人图像”)

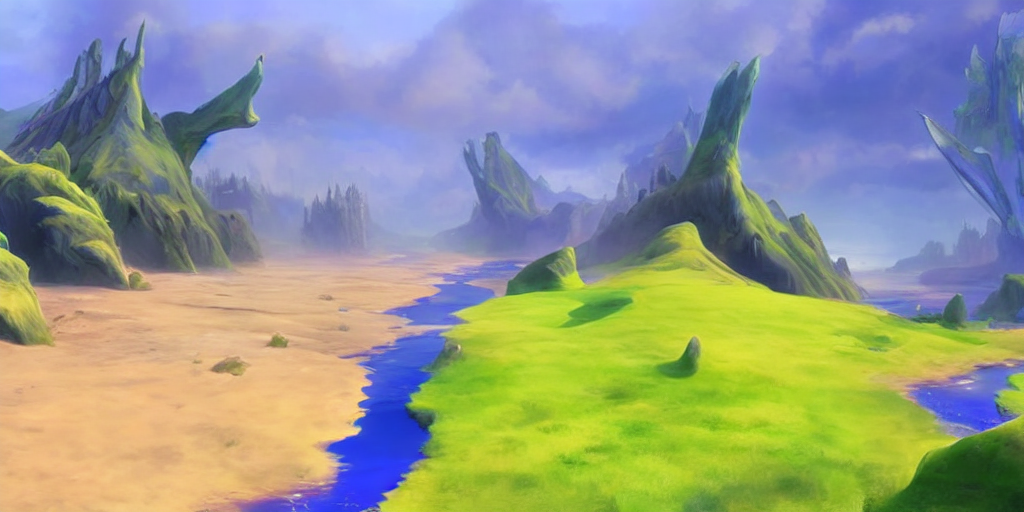

除了基于文本生成图像,Stable Diffusion 还能修复图像,比如小朋友随便画一张草图,能修复成大师级油画。

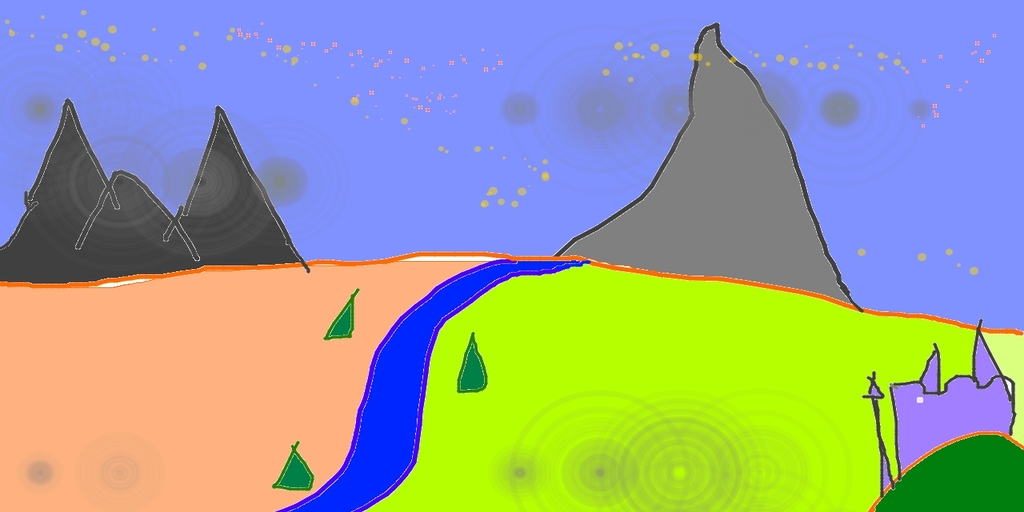

输入:

输出:

相关论文:High-Resolution Image Synthesis with Latent Diffusion Models(具有潜在扩散模型的高分辨率图像合成)