论文:Safe Reinforcement Learning with Linear Function Approximation

下载地址:http://proceedings.mlr.press/v139/amani21a/amani21a.pdf

会议/年份:PMLR / 2021

Word版本下载地址(辛辛苦苦打出来的):https://download.csdn.net/download/baishuiniyaonulia/85863332

本文翻译属于半人工,有错漏请谅解。

文章目录

摘要 Abstract

近年来,强化学习的安全性变得越来越重要。然而,现有的解决方案要么无法严格避免选择不安全的动作,这可能导致安全关键系统的灾难性结果,要么无法为需要学习安全约束的环境提供遗憾的保证。在本文中,我们通过首先将安全建模为状态和动作的未知线性成本函数来解决这两个问题,它必须始终低于某个阈值。然后,我们提出了算法,称为 SLUCB-QVI 和 RSLUCB-QVI,用于具有线性函数逼近的有限水平马尔可夫决策过程 (MDP)。我们证明了 SLUCB-QVI 和 RSLUCB-QVI 在没有违反安全性的情况下,实现了 O ~ ( κ d 3 H 3 T ) \widetilde{\mathcal{O}}\left( \kappa \sqrt{ { {d}^{3}}{ {H}^{3}}T} \right) O (κd3H3T) 遗憾,几乎与最先进的不安全算法相匹配,其中 H H H 是每回合的持续时间, d d d 是特征映射的维度, κ κ κ 是常数表征安全约束, T T T 是动作的总数。我们进一步提出了证实我们的理论发现的数值模拟。

1. 介绍 Introduction

强化学习(RL)是一种研究,即一个主体试图通过与未知环境的互动来最大化其预期的累积奖励。在大多数经典的RL算法中,智能体的目标是通过探索所有可能的行动来最大化长期增益。然而,在许多现实世界的系统中,自由探索所有行为甚至是不安全的游戏也可能是采取有害的行动可能会导致灾难性的结果。因此,RL算法的安全性已经成为一个严重的问题,限制了RL算法在许多现实系统中的适用性。例如,在自动驾驶汽车中,探索那些避免碰撞和损坏汽车、人和财产的政策是至关重要的。医疗应用中的转换成本限制和财务管理中的法律限制是安全关键型应用的其他例子。上述所有安全关键环境都引入了平衡奖励最大化目标和采取安全行动的限制的新挑战。

为了解决这个主要问题,学习算法需要保证它不违反一定的安全约束。从强盗优化的角度来看,研究了一个线性强盗问题,在每一轮中,都需要高概率满足线性代价约束。 对于这个问题,他们提出了高概率不违反约束条件的不后悔算法。当环境通过更具挑战性和更复杂的未知MDP设置进行建模时,旨在解决RL中安全探索问题的研究活动已经激增。许多现有的算法通过约束马尔可夫决策过程(CMDP)对RL的安全性建模,将经典MDP扩展到一个范围内对总期望成本有额外约束的设置。为了解决CMDPs中的安全要求,已经提出了不同的方法,如原始-双重策略优化、约束政策优化和奖励约束政策优化。这些算法在批量离线设置中要么没有理论保证,要么没有渐近收敛保证。在另一个研究在线设置中的CMDP的工作中提出了违反约束数量的次线性界限的算法。此外,上述论文中考虑的安全约束是由低于某一阈值的累积预期成本定义的。

在本文中,我们提出了一个上置信界(UCB)-基于算法-称为安全线性UCB Q/V迭代(SLUCB-QVI)-重点关注确定性策略选择,尊重更严格的安全要求概念,必须在每个时间步长满足一个动作以很高的概率执行。我们还提出了随机SLUCB-QVI(RSLUCB-QVI),这是一种安全的算法,专注于随机策略选择,而不违反任何约束条件。对于这两种算法,我们假设底层的MDP具有线性结构,并证明了一个遗憾界与不安全的部分相当。

我们的主要技术贡献使我们能够保证在不违反安全约束的情况下保证次线性遗憾约束,包括:1)保守地从正确定义的未知安全集子集中选择动作;2)利用仔细的算法设计来确保在面对安全约束时的乐观性,即我们提出的算法的值函数大于最优值函数。详见第2、3、4节。

符号 Notation

我们首先介绍一组在整个论文中使用的符号。我们使用小写字母表示标量,使用小写粗体字母表示向量,使用大写粗体字母表示矩阵。x的欧几里得范数记为 ∥ x ∥ 2 \Vert x \Vert_2 ∥x∥2。我们用 x ⊤ x^\top x⊤表示任何列向量 x x x的转置。对于任何向量 x x x和 y y y,我们用 < x , y > <x,y> <x,y>来表示它们的内积。设 x x x为正定 d × d d\times d d×d矩阵和 ν ∈ R d \mathcal{ν}∈\mathbb{R}^d ν∈Rd。 ν \mathcal{ν} ν相对于 A \mathbf{A} A的加权2-范数定义为 ∥ ν ∥ 2 = ν ⊤ A ν \Vert \mathcal{ν} \Vert_2=\sqrt{\mathcal{ν}^\top\mathbf{A} \mathcal{ν}} ∥ν∥2=ν⊤Aν。对于正整数 n n n, [ n ] [n] [n]表示 { 1 , 2 , . . . , n } \{1,2,...,n\} { 1,2,...,n}。我们用 e i e_i ei来表示第 i i i个标准基向量。最后,我们对忽略对数因子的大 O O O符号使用标准的 O ~ \tilde{\mathcal{O}} O~符号。

1.1. 问题公式化 Problem formulation

有限视界马尔可夫决策过程 Finite-horizon Markov decision process

我们考虑一个有限水平的马尔可夫决策过程(MDP),表示为我们考虑一个有限水平的马尔可夫决策过程(MDP),表示为 M = ( S , A , H , P , r , c ) M=(\mathcal{S},\mathcal{A}, H, \mathbb{P}, r,c) M=(S,A,H,P,r,c),其中, S \mathcal{S} S是状态集, A \mathcal{A} A是动作集, H H H是每一回合的长度(横向), P = { P h } h = 1 H \mathbb{P}=\{\mathbb{P_h}\}_{h=1}^H P={ Ph}h=1H是转移概率, r = { r h } h = 1 H r=\{r_h\}_{h=1}^H r={ rh}h=1H是奖励函数, c = { c h } c = 1 H c=\{c_h\}_{c=1}^H c={ ch}c=1H是安全量。对于每个时间步 h ∈ [ H ] h\in [H] h∈[H], P h ( s ′ ∣ s , a ) \mathbb{P}_h(s'|s,a) Ph(s′∣s,a)表示在状态 s s s处做出动作 a a a时转移到状态 s ′ s' s′的概率,并且 r h : S × A → [ 0 , 1 ] r_h:\mathcal{S}\times\mathcal{A}\to[0,1] rh:S×A→[0,1],并且 c h : S × A → [ 0 , 1 ] c_h:\mathcal{S}\times\mathcal{A}\to[0,1] ch:S×A→[0,1]是奖励和约束函数。我们考虑 S S S和 A A A已知的学习问题,而转移概率 P h \mathbb{P}_h Ph、奖励 r h r_h rh和安全量 c h c_h ch是未知的,必须在线学习。智能体与未知环境相互作用,该环境被描述为 M M M在每个回合中。实践中,在每个回合 k k k和时间步 h ∈ [ H ] h\in[H] h∈[H],智能体观测到状态 s h k s^k_h shk,做出动作 a h k ∈ A a^k_h\in A ahk∈A,然后观测到一个奖励 r h k : = r h ( s h k , a h k ) r^k_h:=r_h(s_h^k,a_h^k) rhk:=rh(shk,ahk),以及一种受噪声干扰的安全措施 z h k = c h ( s h k , a h k ) + ϵ h k z_h^k=c_h(s_h^k,a_h^k)+\epsilon_h^k zhk=ch(shk,ahk)+ϵhk,其中 ϵ h k \epsilon_h^k ϵhk是一个随机添加的噪声。

安全约束 Safety Constraint

们假设底层系统的安全性是至关重要的,学习环境受到限制行动选择的侧面约束,在每个回合 k k k和时间步 h ∈ [ H ] h\in[H] h∈[H],处于状态 s h k s^k_h shk时,智能体必须选择一个安全的操作程序,以便使:

c h ( s h k , a h k ) ≤ τ {

{c}_{h}}\left( s_{h}^{k},a_{h}^{k} \right)\le \tau ch(shk,ahk)≤τ

其中 τ \tau τ是一个已知的常数。因此,我们将未知的安全动作集定义为:

A h safe ( s ) : = { a ∈ A : c h ( s , a ) ≤ τ } , ∀ ( s , h ) ∈ S × [ H ] \mathcal{A}_{h}^{\text{safe}}(s):=\left\{ a\in \mathcal{A}:{

{c}_{h}}(s,a)\le \tau \right\},\quad \forall (s,h)\in \mathcal{S}\times [H] Ahsafe(s):={

a∈A:ch(s,a)≤τ},∀(s,h)∈S×[H]

因此,在观察了第 k k k回合的状态 s h k s^k_h shk和时间步长 h ∈ [ H ] h\in [H] h∈[H]后,智能体的动作选择必须大概率属于 A h s a f e ( s h k ) \mathcal{A}_h^{safe}(s^k_h) Ahsafe(shk)。作为一个启发式的例子,考虑一辆自动驾驶汽车。一方面,智能体(车)以最快的速度从第一点到第二点得到奖励。另一方面,驾驶行为必须受限于遵守交通安全标准。

目标 Goal

一个安全的确定性策略是一个函数 π : S × [ H ] → A \pi : \mathcal{S}\times[H]\to \mathcal{A} π:S×[H]→A。这样, π ( s , h ) ∈ A h s a f e ( s ) \pi(s,h)\in \mathcal{A}_h^{safe}(s) π(s,h)∈Ahsafe(s)是策略 π \pi π建议智能体在时间步长 h ∈ [ H ] h\in [H] h∈[H]和状态 s ∈ S s\in \mathcal{S} s∈S时采取的安全行动。因此,我们通过:

Π safe : = { π : π ( s , h ) ∈ A h safe ( s ) , ∀ ( s , h ) ∈ S × [ H ] } {

{\Pi }^{\text{safe}}}:=\left\{ \pi :\pi (s,h)\in \mathcal{A}_{h}^{\text{safe}}(s),\forall (s,h)\in \mathcal{S}\times [H] \right\} Πsafe:={

π:π(s,h)∈Ahsafe(s),∀(s,h)∈S×[H]}

对于每个 h ∈ [ H ] h\in [H] h∈[H],在一个安全策略 π ∈ ∏ s a f e \pi \in \prod^{safe} π∈∏safe下获得的累积预期奖励,称为值函数 V h π : S → R V^\pi_h:\mathcal{S}\to \mathbb{R} Vhπ:S→R,被定义为:

V h π ( s ) : = E [ ∑ h ′ = h H r h ′ ( s h ′ , π ( s h ′ , h ′ ) ) ∣ s h = s ] V_{h}^{\pi }(s):=\mathbb{E}\left[ \left. \sum\limits_{

{h}'=h}^{H}{

{

{r}_{

{

{h}'}}}}\left( {

{s}_{

{

{h}'}}},\pi \left( {

{s}_{

{

{h}'}}},{h}' \right) \right) \right|{

{s}_{h}}=s \right] Vhπ(s):=E[h′=h∑Hrh′(sh′,π(sh′,h′))∣∣∣∣∣sh=s]

期望超过环境的地方。我们还定义了状态-动作值动作 Q h π : S × A h s a f e ( . ) → R Q^\pi_h:\mathcal{S}\times\mathcal{A}_h^{safe}(.)\to \mathbb{R} Qhπ:S×Ahsafe(.)→R为一个安全策略 π ∈ ∏ s a f e \pi \in \prod^{safe} π∈∏safe在时间步 h ∈ [ H ] h\in [H] h∈[H]由:

Q h π ( s , a ) : = E [ ∑ h ′ = h + 1 H r h ′ ( s h ′ , π ( s h ′ , h ′ ) ) ∣ s h = s , a h = a ] Q_{h}^{\pi }(s,a):=\mathbb{E}\left[ \left. \sum\limits_{

{h}'=h+1}^{H}{

{

{r}_{

{

{h}'}}}}\left( {

{s}_{

{

{h}'}}},\pi \left( {

{s}_{

{

{h}'}}},{h}' \right) \right) \right|{

{s}_{h}}=s,{

{a}_{h}}=a \right] Qhπ(s,a):=E[h′=h+1∑Hrh′(sh′,π(sh′,h′))∣∣∣∣∣sh=s,ah=a]

为了简化符号,对于任何函数f,我们表示 [ P h f ] ( s , a ) : = E s ′ ∼ P h ( . ∣ s , a ) f ( s ′ ) [\mathbb{P}_hf](s,a):=\mathbb{E}_{s'\sim\mathbb{P_h}(.|s,a)}f(s') [Phf](s,a):=Es′∼Ph(.∣s,a)f(s′)。让 π ∗ \pi_* π∗是最优的安全策略,这样 V h π ∗ ( s ) = s u p π ∈ ∏ s a f e V h π ( s ) V^{\pi_*}_h(s)=sup_{\pi\in\prod^{safe}}V^\pi_h(s) Vhπ∗(s)=supπ∈∏safeVhπ(s)对于所有 ( s , h ) ∈ S × [ H ] (s,h)\in\mathcal{S}\times[H] (s,h)∈S×[H]。因此,对于所有 ( s , h ) ∈ S × [ H ] (s,h)\in\mathcal{S}\times[H] (s,h)∈S×[H]和 a ∈ A h s a f e ( s ) a\in\mathcal{A}_h^{safe}(s) a∈Ahsafe(s),任意安全策略 π ∈ ∏ s a f e \pi \in \prod^{safe} π∈∏safe和最优安全策略的Bellman方程为:

Q h π ( s , a ) = r h ( s , a ) + [ P h V h + 1 π ] ( s , a ) , V h π ( s ) = Q h π ( s , π ( s , h ) ) , \begin{aligned} & Q_{h}^{\pi }(s,a)={

{r}_{h}}(s,a)+\left[ {

{\mathbb{P}}_{h}}V_{h+1}^{\pi } \right](s,a), \\ & \quad V_{h}^{\pi }(s)=Q_{h}^{\pi }(s,\pi (s,h)), \\ \end{aligned} Qhπ(s,a)=rh(s,a)+[PhVh+1π](s,a),Vhπ(s)=Qhπ(s,π(s,h)), Q h ∗ ( s , a ) = r h ( s , a ) + [ P h V h + 1 ∗ ] ( s , a ) . V h ∗ ( s ) = max a ∈ A h safe ( s ) Q h ∗ ( s , a ) , \begin{aligned} & Q_{h}^{*}(s,a)={

{r}_{h}}(s,a)+\left[ {

{\mathbb{P}}_{h}}V_{h+1}^{*} \right](s,a). \\ & \quad V_{h}^{*}(s)=\underset{a\in \mathcal{A}_{h}^{\text{safe }}(s)}{\mathop{\max }}\,Q_{h}^{*}(s,a), \\ \end{aligned} Qh∗(s,a)=rh(s,a)+[PhVh+1∗](s,a).Vh∗(s)=a∈Ahsafe (s)maxQh∗(s,a),

其中 V H + 1 π ( s ) = V ∗ H + 1 ( s ) = 0 V^\pi_{H+1}(s)=V^*{H+1}(s)=0 VH+1π(s)=V∗H+1(s)=0。请注意,在没有安全约束的经典RL中,贝尔曼最优性方程意味着至少存在一个确定性的最优策略。当考虑求解最优策略的贝尔曼方程时,安全约束的存在等价于没有约束但具有不同约束的MDP的求解 ( s , h ) ∈ S × [ H ] (s,h)\in\mathcal{S}\times[H] (s,h)∈S×[H],即 A h s a f e ( s ) \mathcal{A}_h^{safe}(s) Ahsafe(s)

设 K K K为总事件数, s 1 k s^k_1 s1k为事件 k ∈ [ K ] k\in [K] k∈[K]开始时的初始状态, π k \pi_k πk为智能体在事件 k ∈ [ K ] k\in [K] k∈[K]期间选择的高概率安全策略。然后定义累积伪遗憾:

R K : = ∑ k = 1 K V 1 ∗ ( s 1 k ) − V 1 π k ( s 1 k ) {

{R}_{K}}:=\sum\limits_{k=1}^{K}{V_{1}^{*}}(s_{1}^{k})-V_{1}^{

{

{\pi }_{k}}}(s_{1}^{k}) RK:=k=1∑KV1∗(s1k)−V1πk(s1k)

智能体的目标是保持 R K R_K RK尽可能的小( R K / K → 0 R_K/K\to0 RK/K→0随着 K K K变大),而不是在过程中违反安全约束,即, π k ∈ ∏ s a f e \pi_k \in \prod^{safe} πk∈∏safe 对所有 k ∈ [ K ] k\in[K] k∈[K]有一个高概率。

线性函数近似 Linear Function Approximation

我们关注具有线性转移核、封装在以下假设中的奖励和成本函数的MDPs。

假设 1 (线性MDP) Assumption 1 (Linear MDP)

M = ( S , A , H , P , r , c ) M=(\mathcal{S},\mathcal{A},H,\mathbb{P},r,c) M=(S,A,H,P,r,c) 是具有特征映射 ϕ : S × 的 线 性 M D P A → R d \phi :\mathcal{S}\times \mathcal{ 的线性 MDP A}\to { {\mathbb{R}}^{d}} ϕ:S×的线性MDPA→Rd,如果对于任何 h ∈ [ H ] h\in [H] h∈[H],存在未知测度 μ h ∗ : = [ μ h ∗ ( 1 ) , … , μ h ∗ ( d ) ] ⊤ \mu _{h}^{*}:={ { \left[ \mu _{h}^{*(1)},\ldots ,\mu _{h}^{*(d)} \right]}^{\top }} μh∗:=[μh∗(1),…,μh∗(d)]⊤ 超过 S \mathcal{S } S 和未知向量 θ h ∗ \theta _{h}^{*} θh∗, γ h ∗ ∈ R d \gamma _{h}^{*}\in { {\mathbb{R}}^{d}} γh∗∈Rd 使得 P h ( . ∣ s , a ) = ⟨ μ h ∗ ( . ) , ϕ ( s , a ) ⟩ , r h ( s , a ) = ⟨ θ h ∗ , ϕ ( s , a ) ⟩ { {\mathbb{P}}_{h}}(.|s,a)=\left\langle \mu _{h}^{*}(.),\phi (s,a) \right\rangle , { {r}_{h}}(s,a)=\left\langle \theta_{h}^{*},\phi (s,a)\right\rangle Ph(.∣s,a)=⟨μh∗(.),ϕ(s,a)⟩,rh(s,a)=⟨θh∗,ϕ(s,a)⟩, 和 c h ( s , a ) = ⟨ γ h ∗ , ϕ ( s , a ) ⟩ { {c}_ {h}}(s,a)=\left\langle \gamma _{h}^{*},\phi (s,a)\right\rangle ch(s,a)=⟨γh∗,ϕ(s,a)⟩。

这一假设强调了线性MDP的定义,其中马尔可夫转移模型、奖励函数和代价函数在特征映射 ϕ \phi ϕ中是线性的。

1.2. 相关工作 Related works

安全强化学习与随机化策略 Safe RL with randomized policies

摘要研究了以未知动态和随机策略为重点的约束马尔可夫决策过程(CMDP)制定的安全RL问题。 (Efroni et al., 2020; Turchetta et al., 2020; Garcelon et al., 2020; Zheng and Ratliff, 2020; Ding et al., 2020a; Qiu et al., 2020; Ding et al., 2020b; Xu et al., 2020; Kalagarla et al., 2020).在上述论文中,目标是找到最优的随机策略,使奖励价值函数 V r π ( s ) V_r^\pi(s) Vrπ(s)(期望总奖励)最大化,同时确保成本价值函数 V c π ( s ) V_c^\pi(s) Vcπ(s)(期望总成本)不超过一定的阈值。这种安全要求是在一个范围内定义的,根据环境和政策的随机化,因此没有本文中考虑的安全要求严格,而安全要求必须得到满足在每个时间步长中,都会播放一个动作。除了不同的问题公式外,这些工作的理论保证与本文提供的理论保证有根本的不同。最近的密切相关的工作(Ding et al., 2020a)研究约束有限水平MDP线性结构在我们的论文通过原始型策略优化算法实现 O ~ ( d H 2.5 T ) \tilde{\mathcal{O}}\bigl( dH^{2.5}\sqrt{T}\bigr) O~(dH2.5T)遗憾和约束违反,只能应用于设置有限行动集 A \mathcal{A} A。(Efroni et al., 2020)的算法通过线性规划和原对偶策略优化,在情景有限水平表格设置中获得 O ~ ( ∣ S ∣ H 2 ∣ S ∣ ∣ A ∣ T ) \tilde{\mathcal{O}}\bigl( |\mathcal{S}|H^2\sqrt{|\mathcal{S}||\mathcal{A}|T}\bigr) O~(∣S∣H2∣S∣∣A∣T)遗憾和约束违反。在(Qiu et al., 2020)中,作者研究了一个在 O ~ ( ∣ S ∣ H ∣ A ∣ T ) \tilde{\mathcal{O}}\bigl( |\mathcal{S}|H\sqrt{|\mathcal{A}|T}\bigr) O~(∣S∣H∣A∣T)遗憾和约束违反约束下的对抗性随机最短路径问题。(Dingetal.,2020b)提出了一种求解无限视界贴现率的原对偶算法,该算法对最优性间隙和约束违反都实现了速率 O ~ ( 1 / T ) \tilde{\mathcal{O}}\bigl( 1/\sqrt{T}\bigr) O~(1/T)的全局收敛。上述只能保证违反约束的数量的界限的工作相比,我们的算法在学习过程中从未违反过安全约束。

除了原始对偶方法外,在(Chow et al., 2018)中,还利用李亚普诺夫函数来处理约束。(Yu et al., 2019)提出了一种具有收敛性保证的约束策略梯度算法。上述两项工作都侧重于用已知的过渡模型和约束函数求解CMDPs模型,而不提供遗憾保证。

安全强化学习与gp和确定性转移模型和策略 Safe RL with GPs and deterministic transition model and policies

在另一项工作中,(Turchetta et al., 2016; Berkenkamp et al., 2017; Wachi et al., 2018; Wachi and Sui, 2020)使用高斯过程用确定性转换和/或值函数建模动态,以便能够估计约束并保证安全学习。尽管其中一些算法是近似安全的,但分析其收敛性仍然具有挑战性,而且缺乏遗憾分析。

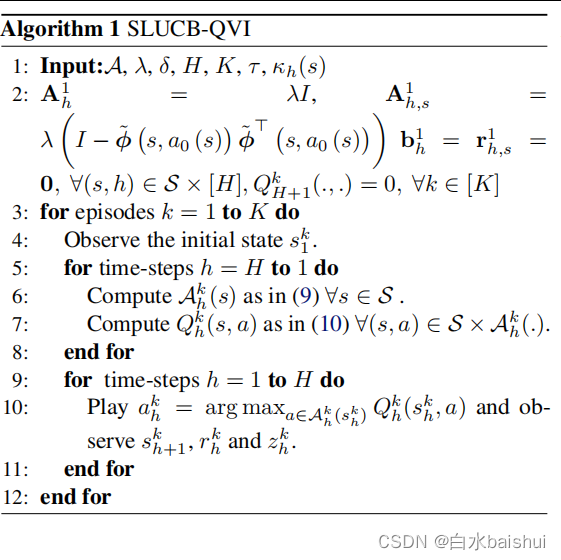

2. 安全线性UCB的Q、V价值迭代 Safe Linear UCB Q/V Iteration

在本节中,我们将介绍算法1中总结的安全线性上置信界Q/V迭代(SLUCB-QVI),然后在第2节中对其性能进行了高级描述。首先,我们将在接下来的章节中介绍在描述算法1及其分析时使用的以下必要的假设和符号集。

假设 2 (非空安全集) Assumption 2 (Non-empty safe sets)

对于所有 s ∈ S s\in \mathcal{S} s∈S,存在一个已知的安全动作 a 0 ( s ) { {a}_{0}}(s) a0(s) 使得 a 0 ( s ) ∈ A h safe ( s ) { {a}_{0}}(s)\in \mathcal{A}_{h}^{\text{safe}}(s) a0(s)∈Ahsafe(s) 已知安全措施 τ h ( s ) : = ⟨ ϕ ( s , a 0 ( s ) ) , γ h ∗ ⟩ < τ { {\tau }_{h}}(s):=\left\langle \phi \left( s,{ {a}_{0}}(s) \right),\gamma _{h}^{*} \right\rangle <\tau τh(s):=⟨ϕ(s,a0(s)),γh∗⟩<τ 对于所有 h ∈ [ H ] h\in [H] h∈[H]。

了解安全动作 a 0 ( s ) a_0(s) a0(s) 对于解决本文研究的安全线性 MDP 设置是必要的,这需要从第一轮开始就满足约束 (1)。 这一假设在许多实际示例中也是现实的,其中已知的安全行动可能是公司当前战略所建议的行动,或者是成本中立的行动,不一定有高回报,但其成本远未达到阈值。它可以放松了解安全行动 τ h ( s ) \tau_h(s) τh(s)成本的假设。在这种情况下,智能体首先在时间步长 h h h处进行一个 a 0 ( s ) a_0(s) a0(s)回合,以便构造间隙间隔时间间隔 τ − τ h ( s ) \tau-\tau_h(s) τ−τh(s)的保守估计器。 T h ( s ) T_h(s) Th(s)以自适应的方式选择,在附录A.4中我们展示了 16 log ( K ) ( τ − τ h ( s ) ) 2 ≤ T h ( s ) ≤ 64 log ( K ) ( τ − τ h ( s ) ) 2 \frac{16\log(K)}{(\tau-\tau_h(s))^2}\leq T_h(s)\leq \frac{64\log(K)}{(\tau-\tau_h(s))^2} (τ−τh(s))216log(K)≤Th(s)≤(τ−τh(s))264log(K),在 T h ( s ) T_h(s) Th(s)轮后,智能体在计算估计的安全策略集(稍后)时依赖于 τ h ( s ) \tau _h(s) τh(s)的估计(稍后讨论)。

符号 Notation

对于任何向量 x ∈ R d \mathbf{x}\in { {\mathbb{R}}^{d}} x∈Rd,定义归一化向量 x ~ : = x ∥ x ∥ 2 \mathbf{\tilde{x}}:=\frac{\mathbf{x} }{\|\mathbf{x}{ {\|}_{2}}} x~:=∥x∥2x。我们将安全特征 ϕ ( s , a 0 ( s ) ) \phi \left( s,{ {a}_{0}}(s) \right) ϕ(s,a0(s)) 的跨度定义为 V s = span ( ϕ ( s , a 0 ( s ) ) ) : = { α ϕ ( s , a 0 ( s ) ) : α ∈ R } { {\mathcal{V}}_{s}}=\operatorname {span}\left( \phi \left( s,{ {a}_{0}}(s) \right) \right):=\left\{ \alpha \phi \left( s,{ {a} _{0}}(s) \right):\alpha \in \mathbb{R} \right\} Vs=span(ϕ(s,a0(s))):={ αϕ(s,a0(s)):α∈R} 和 V s { {\mathcal{V}}_{s}} Vs 的正交补码为 V s ⊥ : = { y ∈ R d : ⟨ y , x ⟩ = 0 , ∀ x ∈ V s } \mathcal {V}_{s}^{\bot }:=\left\{ \mathbf{y}\in { {\mathbb{R}}^{d}}:\langle \mathbf{y},\mathbf{ x}\rangle =0,\forall \mathbf{x}\in { {\mathcal{V}}_{s}} \right\} Vs⊥:={ y∈Rd:⟨y,x⟩=0,∀x∈Vs}。对于任何 x ∈ R d \mathbf{x}\in { {\mathbb{R}}^{d}} x∈Rd,记为 Φ 0 ( s , x ) : = l e f t ⟨ x , ϕ ~ ( s , a 0 ( s ) ) ⟩ ϕ ~ ( s , a 0 ( s ) ) { {\Phi }_{0}}(s,\mathbf{x}):=\ left\langle \mathbf{x},\widetilde{\phi }\left( s,{ {a}_{0}}(s) \right) \rangle \widetilde{\phi }\left( s, { {a}_{0}}(s) \right) Φ0(s,x):= left⟨x,ϕ (s,a0(s))⟩ϕ (s,a0(s)) 它在 V s { {\mathcal{V}}_{s}} Vs 上的投影,并且通过 Φ 0 ⊥ ( s , x ) : = x − Φ 0 ( s , x ) \Phi _{0}^{\bot } (s,\mathbf{x}):=\mathbf{x}-{ {\Phi }_{0}}(s,\mathbf{x}) Φ0⊥(s,x):=x−Φ0(s,x) 它在正交子空间 V \mathcal{V} V上的投影 s ⊥ {s}^{\bot } s⊥。此外,为便于记号,令 ϕ h k : = ϕ ( s h k , a h k ) \phi _{h}^{k}:=\phi \left(s_{h}^{k},a_{h}^{k} \right) ϕhk:=ϕ(shk,ahk)。

2.1. 概览 Overview

从高层的角度来看,我们的算法是 (Jin et al., 2020) 提出的 LSVI-UCB 的安全版本。特别是,每一回合由所有时间步长上的两个循环组成。第一个循环(第 5-8 行)更新数量 A h k \mathcal{A}_{h}^{k} Ahk,估计的安全集和 Q h k Q_{h}^{k} Qhk,动作值函数,即用于执行置信上限策略 a h k = arg max a ∈ A h k ( s h k ) Q h k ( s h k , a ) a_{h}^{k}=\arg {

{\max }_{a\in \mathcal{A}_{h}^{k}(s_{h}^ {k})}}Q_{h}^{k}(s_{h}^{k},a) ahk=argmaxa∈Ahk(shk)Qhk(shk,a) 在第二个循环中(第 9-11 行)。 SLUCB-QVI 和 LSVI-UCB 之间的主要区别是要求选择的动作 a h k a_{h}^{k} ahk 必须始终属于未知安全集 A h safe ( s h k ) \mathcal{A}_{h}^{\text{safe }}(s_{h}^{k}) Ahsafe (shk)。为此,在每个情节 k ∈ [ K ] k\in [K] k∈[K] 中,在第一个循环(第 6 行)的额外步骤中,智能体计算一个集合 A h k ( s ) \mathcal{A}_{h}^{k}(s ) Ahk(s) 对于所有 s ∈ S s\in \mathcal{S} s∈S,我们将证明它是未知安全集 A h safe ( s ) \mathcal{A}_{h}^{\text{safe}}(s ) Ahsafe(s),因此,是从第二个循环(第 10 行)中选择动作 a h k a_{h}^{k} ahk 的良好候选者。 A h k ( s ) \mathcal{A}_{h}^{k}(s) Ahk(s) 的构造取决于安全约束定义中使用的未知参数 γ h ∗ \gamma_{h}^{*} γh∗ (见假设 1)。由于智能体知道 τ h ( s ) : = ⟨ ϕ ( s , a 0 ( s ) ) , g a m m a h ∗ ⟩ {

{\tau }_{h}}(s):=\left\langle \phi \left(s,{

{a}_{0}}(s) \right),\ gamma _{h}^{*} \right\rangle τh(s):=⟨ϕ(s,a0(s)), gammah∗⟩(见假设2),它可以计算 z h , s k : = ⟨ Φ 0 ⊥ ( s , ϕ h k ) , Φ 0 ⊥ ( s , γ h ∗ ) ⟩ + ϵ h k = z h k − ⟨ ϕ h k , ϕ ~ ( s , a 0 ( s ) ) ⟩ 1 ∥ ϕ ( s , a 0 ( s ) ) ∥ 2 τ h ( s ) z_{h,s}^{k}:=\left\langle \Phi _{0}^{\bot }\left( s,\phi _{h}^{k} \right),\Phi _{0}^{\bot }\left(s,\gamma _{h}^{*} \right) \right\rangle +\epsilon _{h}^{k}=z_{h}^{k}-\frac{

{

{\left\langle \phi _{h}^{k},\widetilde{\phi }\left( s,{

{a}_{0}}(s) \right) \right\rangle }_{1}}}{

{

{\left\| \phi \left( s,{

{a}_{0}}(s) \right) \right\|}_{2}}}{

{\tau }_{h}}(s) zh,sk:=⟨Φ0⊥(s,ϕhk),Φ0⊥(s,γh∗)⟩+ϵhk=zhk−∥ϕ(s,a0(s))∥2⟨ϕhk,ϕ

(s,a0(s))⟩1τh(s),即 a h k a_{h}^{k} ahk 沿子空间 V s ⊥ \mathcal{V}_{s}^{\bot } Vs⊥ 产生的成本,它与 ϕ ( s , a 0 ( s ) ) \phi \left( s,{

{a} _{0}}(s)\right) ϕ(s,a0(s)).因此,智能体不需要沿着归一化安全特征向量 ϕ ~ ( s , a 0 ( s ) ) \tilde{\phi }\left( s,{

{a}_{0 }}(s) \right) ϕ~(s,a0(s)).相反,它只在 Φ 0 ⊥ ( s , γ h ∗ ) \Phi _{0}^{\bot }\left( s,\gamma _{h}^{*} \right) Φ0⊥(s,γh∗) 周围建立以下置信度集,它沿着 的正交方向波浪号 ϕ ~ ( s , a 0 ( s ) ) \tilde{\phi }\left( s,{

{a}_{0}}(s) \right) ϕ~(s,a0(s)):

C h k ( s ) : = { ν ∈ R d : ∥ ν − γ h , s k ∥ A h , s k ≤ β } \mathcal{C}_{h}^{k}(s):=\left\{ \nu \in {

{\mathbb{R}}^{d}}:{

{\left\| \nu -\gamma _{h,s}^{k} \right\|}_{\mathbf{A}_{h,s}^{k}}}\le \beta \right\} Chk(s):={

ν∈Rd:∥∥ν−γh,sk∥∥Ah,sk≤β}

其中 γ h , s k : = ( A h , s k ) − 1 r h , s k \gamma _{h,s}^{k}:={ {\left( \mathbf{A}_{h,s}^{k} \right)}^{-1}}\mathbf{r }_{h,s}^{k} γh,sk:=(Ah,sk)−1rh,sk 是 Φ 0 ⊥ ( s , γ h ∗ ) \Phi_{0}^{\bot }\left( s,\gamma _{h}^{*} \right) Φ0⊥(s,γh∗) 的正则化最小二乘估计量由 Gram 矩阵的逆计算 A h , s k : = λ ( I − ϕ ~ ( s , a 0 ( s ) ) ϕ ~ ⊤ ( s , a 0 ( s ) ) ) + ∑ j = 1 k − 1 Φ 0 ⊥ ( s , ϕ h j ) Φ 0 ⊥ , ⊤ ( s , ϕ h j ) \mathbf{A}_{h,s}^{k}:=\lambda \left( I-\tilde{\phi }\left( s,{ {a}_{ 0}}(s) \right){ { {\tilde{\phi }}}^{\top }}\left(s,{ {a}_{0}}(s) \right) \right)+ \sum\limits_{j=1}^{k-1}{\Phi_{0}^{\bot }}\left(s,\phi_{h}^{j} \right)\Phi_{ 0}^{\bot ,\top }\left( s,\phi _{h}^{j} \right) Ah,sk:=λ(I−ϕ~(s,a0(s))ϕ~⊤(s,a0(s)))+j=1∑k−1Φ0⊥(s,ϕhj)Φ0⊥,⊤(s,ϕhj) 和 r h , s k : = ∑ j = 1 k − 1 z h , s j Φ 0 ⊥ ( s , ϕ h j ) r_{h,s}^{k}:=\sum\limits_{j= 1}^{k-1}{z_{h,s}^{j}}\Phi_{0}^{\bot }\left(s,\phi_{h}^{j}\right) rh,sk:=j=1∑k−1zh,sjΦ0⊥(s,ϕhj) . 探索因子 β 将很快在定理 1 中定义,以保证事件:

E 1 : = { Φ 0 ⊥ ( s , γ h ∗ ) ∈ C h k ( s ) , ∀ ( s , h , k ) ∈ S × [ H ] × [ K ] } { {\mathcal{E}}_{1}}:=\left\{ \Phi _{0}^{\bot }\left( s,\gamma _{h}^{*} \right)\in \mathcal{C}_{h}^{k}(s),\forall (s,h,k)\in \mathcal{S}\times [H]\times [K] \right\} E1:={ Φ0⊥(s,γh∗)∈Chk(s),∀(s,h,k)∈S×[H]×[K]}

即 Φ 0 ⊥ ( s , γ h ∗ ) \Phi _{0}^{\bot }\left( s,\gamma _{h}^{*} \right) Φ0⊥(s,γh∗) 属于置信集 C h k ( s ) \mathcal{C}_{h}^{ k}(s) Chk(s),很有可能成立。 在实现中,我们将 β 视为调整参数。 以事件 E 1 {

{\mathcal{E}}_{1}} E1 为条件,智能体已准备好计算真实未知安全集 A h safe \mathcal{A}_{h}^{\text{safe}} Ahsafe的以下内部近似值 所有 s ∈ S s\in \mathcal{S} s∈S 的安全:

A h k ( s ) = { a ∈ A : ⟨ Φ 0 ( s , ϕ ( s , a ) ) , ϕ ~ ( s , a 0 ( s ) ) ⟩ ∥ ϕ ( s , a 0 ( s ) ) ∥ 2 τ h ( s ) + ⟨ γ h , s k , Φ 0 ⊥ ( s , ϕ ( s , a ) ) ⟩ + β ∥ Φ 0 ⊥ ( s , ϕ ( s , a ) ) ∥ ( A h , s k ) − 1 ≤ τ } \begin{aligned} & \mathcal{A}_{h}^{k}(s)=\left\{ a\in \mathcal{A}:\frac{\left\langle {

{\Phi }_{0}}(s,\phi (s,a)),\widetilde{\phi }\left( s,{

{a}_{0}}(s) \right) \right\rangle }{

{

{\left\| \phi \left( s,{

{a}_{0}}(s) \right) \right\|}_{2}}}{

{\tau }_{h}}(s) \right. \\ & \left. +\left\langle \gamma _{h,s}^{k},\Phi _{0}^{\bot }(s,\phi (s,a)) \right\rangle +\beta {

{\left\| \Phi _{0}^{\bot }(s,\phi (s,a)) \right\|}_{

{

{\left( \mathbf{A}_{h,s}^{k} \right)}^{-1}}}}\le \tau \right\} \\ \end{aligned} Ahk(s)=⎩⎨⎧a∈A:∥ϕ(s,a0(s))∥2⟨Φ0(s,ϕ(s,a)),ϕ

(s,a0(s))⟩τh(s)+⟨γh,sk,Φ0⊥(s,ϕ(s,a))⟩+β∥∥Φ0⊥(s,ϕ(s,a))∥∥(Ah,sk)−1≤τ}

注意 ⟨ Φ 0 ( s , ϕ ( s , a ) ) , ϕ ~ ( s , a 0 ( s ) ) ⟩ ∥ ϕ ( s , a 0 ( s ) ) ∥ 2 τ h ( s ) \frac{\left\langle { {\Phi }_{0}}(s,\phi (s,a)),\widetilde{\phi }\left( s,{ {a}_{0 }}(s) \right) \right\rangle }{ { {\left\| \phi \left( s,{ {a}_{0}}(s) \right) \right\|}_{2}}}{ {\tau }_{h}}(s) ∥ϕ(s,a0(s))∥2⟨Φ0(s,ϕ(s,a)),ϕ (s,a0(s))⟩τh(s) 是已知的在状态 s 沿方向 ϕ ~ ( s , a 0 ( s ) ) \widetilde{\phi }\left( s,{ {a}_{0}}(s) \right) ϕ (s,a0(s)) 和 max ν ∈ C h k ( s ) ⟨ Φ 0 ⊥ ( s , ϕ ( s , a ) ) , ν ⟩ = ⟨ γ h , s k , Φ 0 ⊥ ( s , ϕ ( s , a ) ) ⟩ + β ∥ Φ 0 ⊥ ( s , ϕ ( s , a ) ) ∥ ( A h , s k ) − 1 \underset{\nu \in \mathcal{C}_{h}^{k}(s)}{\mathop{\max }}\,\left\langle \Phi _{0}^{\bot }(s,\phi (s,a)),\nu \right\rangle =\left\langle \gamma _{h,s}^{k},\Phi _{0}^{\bot }(s,\phi (s,a)) \right\rangle +\beta { {\left\| \Phi _{0}^{\bot }(s,\phi (s,a)) \right\|}_{ { {\left( \mathbf{A}_{h,s}^{k} \right)}^{-1}}}} ν∈Chk(s)max⟨Φ0⊥(s,ϕ(s,a)),ν⟩=⟨γh,sk,Φ0⊥(s,ϕ(s,a))⟩+β∥∥Φ0⊥(s,ϕ(s,a))∥∥(Ah,sk)−1 是它在正交空间 V s ⊥ \mathcal{V}_{s}^{\bot } Vs⊥ 中的最大可能成本。因此, ⟨ Φ 0 ( s , ϕ ( s , a ) ) , ϕ ~ ( s , a 0 ( s ) ) ⟩ ∥ ϕ ( s , a 0 ( s ) ) ∥ 2 τ h ( s ) + ⟨ γ h , s k , Φ 0 ⊥ ( s , ϕ ( s , a ) ) ⟩ + β ∥ Φ 0 ⊥ ( s , ϕ ( s , a ) ) ∥ ( A h , s k ) − 1 \frac{\left\langle { {\Phi }_{0}}(s,\phi (s,a)),\tilde{\phi }\left( s,{ {a}_{0}}(s) \right) \right\rangle }{ { {\left\| \phi \left( s,{ {a}_{0}}(s) \right) \right\|}_{2}}}{ {\tau }_{h}}(s)+\left\langle \gamma _{h,s}^{k},\Phi _{0}^{\bot }(s,\phi (s,a)) \right\rangle +\beta { {\left\| \Phi _{0}^{\bot }(s,\phi (s,a)) \right\|}_{ { {\left( \mathbf{A}_{h,s}^{k} \right)}^{-1}}}} ∥ϕ(s,a0(s))∥2⟨Φ0(s,ϕ(s,a)),ϕ~(s,a0(s))⟩τh(s)+⟨γh,sk,Φ0⊥(s,ϕ(s,a))⟩+β∥∥Φ0⊥(s,ϕ(s,a))∥∥(Ah,sk)−1 是真实未知成本 ⟨ ϕ ( s , a ) , γ h ∗ ⟩ 的 高 概 率 上 限 \left\langle \phi (s,a),\gamma _{h}^{*} \right\rangle 的高概率上限 ⟨ϕ(s,a),γh∗⟩的高概率上限,这意味着 A h k ( s ) ⊂ A h safe ( s ) \mathcal{A}_{h}^{k}(s)\subset \mathcal{A}_{h}^{\text{safe}}(s) Ahk(s)⊂Ahsafe(s)。

提议 1 Proposition 1

以 (8) 中的 E 1 { {\mathcal{E}}_{1}} E1 为条件,对于所有 ( s , h , k ) ∈ S × [ H ] × [ K ] (s,h,k)\in \mathcal{S}\times [H]\times [K] (s,h,k)∈S×[H]×[K] , 它认为 ⟨ ϕ ( s , a ) , γ h ∗ ⟩ ≤ τ , ∀ a ∈ A h k ( s ) \left\langle \phi (s,a),\mathbf{\gamma }_{h}^{*} \right\rangle \le \tau ,\forall a\in \mathcal{A} _{h}^{k}(s) ⟨ϕ(s,a),γh∗⟩≤τ,∀a∈Ahk(s)。

因此,以 E 1 { {\mathcal{E}}_{1}} E1 为条件,决策规则 a h k : = arg max a ∈ A h k ( s h k ) Q h k ( s h k , a ) a_{h}^{k}:=\arg { {\max }_{a\in \mathcal{A }_{h}^{k}\left(s_{h}^{k}\right)}}Q_{h}^{k}\left(s_{h}^{k},a \right) ahk:=argmaxa∈Ahk(shk)Qhk(shk,a) 算法 1 的第 10 行表明 a h k a_{h}^{k} ahk 不违反安全约束。 注意 A h k ( s ) \mathcal{A}_{h}^{k}(s) Ahk(s) 总是非空的,因为作为假设 2 的结果,安全动作 a 0 ( s ) { {a}_{0}}(s) a0(s) 总是在 . A h k ( s ) \mathcal{A}_{h}^{k}(s) Ahk(s) 中。

既然已经构造了估计的安全集 A h k ( s ) \mathcal{A}_{h}^{k}(s) Ahk(s),我们将描述如何计算要使用的动作值函数 Q h k Q_{h}^{k} Qhk 在 UCB 决策规则中,在算法的第二个循环中选择动作 a h k a_{h}^{k} ahk。 MDP 的线性结构允许我们通过线性形式 ⟨ w h ∗ , ϕ ( s , a ) ⟩ \left\langle \mathbf{w}_{h}^{*},\phi(s,a) \right\rangle ⟨wh∗,ϕ(s,a)⟩ 参数化 Q h ∗ ( s , a ) Q_{h}^{*}(s,a) Qh∗(s,a) ,其中 w h ∗ : = θ h ∗ + ∫ S V h + 1 ∗ ( s ′ ) d μ ( s ′ ) \mathbf{w}_{h}^{*}:=\theta _{h}^{*}+\int_{\mathcal{S}}{V_ {h+1}^{*}}({s}')d\mu ({s}') wh∗:=θh∗+∫SVh+1∗(s′)dμ(s′)。 因此,估计 Q h ∗ ( s , a ) Q_{h}^{*}(s,a) Qh∗(s,a) 的一个自然想法是解决 w h ∗ \mathbf{w}_{h}^{*} wh∗ 的最小二乘问题。 事实上,对于所有 ( s , a ) ∈ S × A h k ( . ) (s,a)\in \mathcal{S}\times \mathcal{A}_{h}^{k}(.) (s,a)∈S×Ahk(.),智能体计算 Q h k ( s , a ) Q_{h}^{k} (s,a) Qhk(s,a) 定义为

Q h k ( s , a ) = min { ⟨ w h k , ϕ ( s , a ) ⟩ + κ h ( s ) β ∥ ϕ ( s , a ) ∥ ( A h k ) − 1 , H } Q_{h}^{k}(s,a)=\min \left\{ \left\langle \mathbf{w}_{h}^{k},\phi (s,a) \right\rangle +{

{\kappa }_{h}}(s)\beta {

{\left\| \phi (s,a) \right\|}_{

{

{\left( \mathbf{A}_{h}^{k} \right)}^{-1}}}},H \right\} Qhk(s,a)=min{

⟨whk,ϕ(s,a)⟩+κh(s)β∥ϕ(s,a)∥(Ahk)−1,H}

其中 w h k : = ( A h k ) − 1 b h k \mathbf{w}_{h}^{k}:={ {\left( \mathbf{A}_{h}^{k} \right)}^{-1}}\mathbf{b} _{h}^{k} whk:=(Ahk)−1bhk 是 w h ∗ \mathbf{w}_{h}^{*} wh∗ 的正则化最小二乘估计量,由 Gram 矩阵 的逆计算 A h k : = λ I + ∑ j = 1 k − 1 ϕ h j ϕ h j ⊤ \mathbf{A}_{h}^{k}:=\lambda I+\sum\limits_{j=1}^{k-1}{\phi _{h}^{j}}\phi _{h}^{j\top } Ahk:=λI+j=1∑k−1ϕhjϕhj⊤ 和 b h k : = ∑ j = 1 k − 1 ϕ h j [ r h j + max a ∈ A h + 1 k ( s h + 1 j ) Q h + 1 k ( s h + 1 j , a ) ] \mathbf{b}_{h}^{k}:=\sum\limits_{j=1}^{k-1}{\phi _{h}^{j}}\left[ r_{h}^{j}+{ {\max }_{a\in \mathcal{A}_{h+1}^{k}\left( s_{h+1}^{j} \right)}}Q_{h+1}^{k}\left( s_{h+1}^{j},a \right) \right] bhk:=j=1∑k−1ϕhj[rhj+maxa∈Ah+1k(sh+1j)Qh+1k(sh+1j,a)]。这里, κ h ( s ) β ∥ ϕ ( s , a ) ∥ ( A h k ) − 1 { {\kappa }_{h}}(s)\beta { {\left\| \phi (s,a) \right\|}_{ { {\left( \mathbf{A}_{h}^{k} \right)}^{-1}}}} κh(s)β∥ϕ(s,a)∥(Ahk)−1 是探索奖励其特点是: 1) β 鼓励对 r 和 P \mathbb{P} P 的不确定性进行足够的探索; 2) κ h ( s ) > 1 { {\kappa }_{h}}(s)>1 κh(s)>1 鼓励对 c 的不确定性进行足够的探索。虽然我们利用不安全的 bandits 和 MDP (Abbasi-Yadkori et al., 2011) 和 (Jin et al., 2020) 的标准分析来定义 β,但适当量化 κ h ( s ) { {\kappa }_{h}}(s ) κh(s) 是与不安全的 LSVI-UCB 相比,安全约束的存在给 SLUCB-QVI 分析带来的主要挑战,这在引理 1 中有说明。

3. SLUCB-QVI的理论保证 Theoretical guarantees of SLUCB-QVI

在本节中,我们将讨论安全约束的存在给我们的分析带来的技术挑战,并为 SLUCB-QVI 提供一个遗憾界限。 在此之前,我们做出剩余的必要假设,我们提出的算法在这些假设下运行并实现良好的遗憾界限。

假设 3 (次高斯噪声) Assumption 3 (Subgaussian Noise)

对于所有 ( h , k ) ∈ [ H ] × [ K ] (h,k)\in [H]\times [K] (h,k)∈[H]×[K], ϵ h k \epsilon _{h}^{k} ϵhk 是一个零均值 σ-次高斯噪声 随机变量。

假设 4 (有界) Assumption 4 (Boundedness)

不失一般性, ∥ ϕ ( s , a ) ∥ 2 ≤ 1 { {\left\| \phi (s,a) \right\|}_{2}}\le 1 ∥ϕ(s,a)∥2≤1 对于所有 ( s , a ) ∈ S × A (s,a)\in \mathcal{S}\times \mathcal{A} (s,a)∈S×A 和 max ( ∥ μ h ∗ ( S ) ∥ 2 , ∥ θ h ∗ ∥ 2 , ∥ γ h ∗ ∥ 2 ) ≤ d \max \left( { {\left\| \mu _{h}^{*}(\mathcal{S}) \right\|}_{2}},{ {\left\| \theta _{h}^{*} \right\|}_{2}},{ {\left\| \gamma _{h}^{*} \right\|}_{2}} \right)\le \sqrt{d} max(∥μh∗(S)∥2,∥θh∗∥2,∥γh∗∥2)≤d 对于所有 h ∈ [ H ] h\in [H] h∈[H]。

假设 5 (星凸集) Assumption 5 (Star convex sets)

对于所有 s ∈ S s\in \mathcal{S} s∈S,集合 D ( s ) : = { ϕ ( s , a ) : a ∈ A } \mathcal{D}(s):=\{\phi (s,a):a\in \mathcal{A}\} D(s):={ ϕ(s,a):a∈A} 是星 围绕安全特征 ϕ ( s , a 0 ( s ) ) \phi \left( s,{ {a}_{0}}(s) \right) ϕ(s,a0(s)) 的凸集,即对于所有 x ∈ D ( s ) \mathbf{x}\in \mathcal{D}(s ) x∈D(s) 和 α ∈ [ 0 , 1 ] \alpha \in [0,1] α∈[0,1], α x + ( 1 − α ) ϕ ( s , a 0 ( s ) ) ∈ D ( s ) \alpha \mathbf{x}+(1-\alpha )\phi \left( s,{ {a}_{0}}(s) \right)\in \mathcal{D}(s) αx+(1−α)ϕ(s,a0(s))∈D(s)。

假设 3 和 4 是线性 MDP 和老虎机文献中的标准(Jin 等人,2020;Pacchiano 等人,2020;Amani 等人,2019)。假设 5 是必要的,以确保智能体有机会探索给定安全特征向量 ϕ ( s , a 0 ( s ) ) \phi\left(s,{ {a}_{0}}(s)\right) ϕ(s,a0(s)) 周围的特征空间。例如,考虑一个简单的设置,其中 S = { s 1 } , A = { a 1 , a 2 } , H = 1 , μ ∗ ( s 1 ) = ( 1 , 1 ) , θ ∗ = ( 0 , 1 ) \mathcal{S}=\{ { {s}_{1}}\},\mathcal{A}=\{ { {a}_{1}},{ {a }_{2}}\},H=1,{ {\mu }^{*}}({ {s}_{1}})=(1,1),{ {\theta }^{*} }=(0,1) S={ s1},A={ a1,a2},H=1,μ∗(s1)=(1,1),θ∗=(0,1), γ ∗ = ( 0 , 1 ) , τ = 2 , a 0 ( s 1 ) = a 2 { {\gamma }^{*}}=(0,1),\tau =2,{ {a}_{0}}({ {s}_{1} })={ {a}_{2}} γ∗=(0,1),τ=2,a0(s1)=a2, 和 D ( s 1 ) = { ϕ ( s 1 , a 1 ) , ϕ ( s 1 , a 2 ) } = { ( 0 , 1 ) , ( 1 , 0 ) } \mathcal{D}({ {s}_{1}})=\{\phi ({ {s}_{1}},{ {a}_{1}}),\phi ({ {s}_{1}},{ {a}_{2}})\}=\{(0,1),(1,0)\} D(s1)={ ϕ(s1,a1),ϕ(s1,a2)}={ (0,1),(1,0)},它不是星凸集。在这里, a 1 { {a}_{1}} a1 和 a 2 { {a}_{2}} a2 两个动作都是安全的。最优安全策略总是使用 a 1 { {a}_{1}} a1,它给出了最高的奖励。但是,如果 D ( s 1 ) \mathcal{D}({ {s}_{1}}) D(s1) 不包含连接 ( 1 , 0 ) (1,0) (1,0) 和 ( 0 , 1 ) (0,1) (0,1) 的整行,则智能体会继续播放 a 2 { {a}_{2}} a2 并且将无法探索其他安全操作并确定最优策略将始终选择 a1。此外,值得一提的是,集合 D ( s ) \mathcal{D}(s) D(s) 的星形凸性是比现有安全算法 (Amani et al., 2019; Moradipari et al., 2019) 中考虑的凸性假设更温和的假设)。

定理 1 (SLUCB-QVI的遗憾值) Theorem 1 (Regret of SLUCB-QVI)

在假设 1、2、3、4 和 5 下,存在一个绝对常数 c β > 0 { {c}_{\beta }}>0 cβ>0 使得对于任何固定的 δ ∈ ( 0 , 0 , 5 ) \delta \in (0,0,5) δ∈(0,0,5) , 如果我们设置 β : = max ( σ d log ( 2 + 2 T λ δ ) + λ d , c β d H log ( d T δ ) ) \beta :=\max \left( \sigma \sqrt{d\log \left( \frac{2+\frac{2T}{\lambda }}{\delta } \right)}+\sqrt{\lambda d},{ {c}_{\beta }}dH\sqrt{\log \left( \frac{dT}{\delta } \right)} \right) β:=max(σdlog(δ2+λ2T)+λd,cβdHlog(δdT)) 和 κ h ( s ) : = 2 H τ − τ h ( s ) + 1 { {\kappa }_{h}}(s):=\frac{2H}{\tau -{ {\tau }_{h}}(s)}+1 κh(s):=τ−τh(s)2H+1,那么概率至少为 1 − 2 δ 1-2\delta 1−2δ, 它认为 R K ≤ 2 H T log ( d T δ ) + ( 1 + κ ) β 2 d H T log ( 1 + K d λ ) { {R}_{K}}\le 2H\sqrt{T\log \left( \frac{dT}{\delta } \right)}+(1+\kappa )\beta \sqrt{ 2dHT\log \left( 1+\frac{K}{d\lambda } \right)} RK≤2HTlog(δdT)+(1+κ)β2dHTlog(1+dλK),其中 κ : = max ( s , h ) ∈ S × [ H ] κ h ( s ) \kappa :={ {\max }_{(s,h)\in \mathcal{S}\times [H]}}{ {\kappa }_{h}}(s) κ:=max(s,h)∈S×[H]κh(s)

这里, T = K H T=KH T=KH 是动作播放的总数。 我们观察到遗憾界与最先进的不安全算法的数量级相同,例如 LSVI-UCB (Jin et al., 2020),第二项中只有一个额外的因子 κ。 完整的证明在附录 A.3 中报告。 在下一节中,我们给出了证明的草图。

3.1. 定理1的证明概略

首先,我们陈述从 (Abbasi-Yadkori et al., 2011; Jin et al., 2020) 借来的以下定理。

定理 2 Theorem 2 (Thm. 2 in (Abbasi-Yadkori et al., 2011) and Lemma B.4 in (Jin et al., 2020)).

对于任何固定策略 π \pi π,定义 V h k ( s ) : = max a ∈ A h k ( s , a ) Q h k ( s , a ) V_{h}^{k}(s):={

{\max }_{a\in \mathcal{A}_{h}^{k}(s,a)} }Q_{h}^{k}(s,a) Vhk(s):=maxa∈Ahk(s,a)Qhk(s,a) 和事件

E 2 : = { ∣ ⟨ w h k , ϕ ( s , a ) ⟩ − Q h π ( s , a ) + [ P h ( V h + 1 π − V h + 1 k ) ] ( s , a ) ∣ ≤ β ∥ ϕ ( s , a ) ∥ ( A h k ) − 1 , ∀ ( a , s , h , k ) ∈ A × S × [ H ] × [ K ] } \begin{aligned} & {

{\mathcal{E}}_{2}}:=\left\{ \left| \left\langle \mathbf{w}_{h}^{k},\phi (s,a) \right\rangle -Q_{h}^{\pi }(s,a)+\left[ {

{\mathbb{P}}_{h}}\left( V_{h+1}^{\pi }-V_{h+1}^{k} \right) \right](s,a) \right| \right. \\ & \quad \ \left. \le \beta \|\phi (s,a){

{\|}_{

{

{\left( \mathbf{A}_{h}^{k} \right)}^{-1}}}},\forall (a,s,h,k)\in \mathcal{A}\times \mathcal{S}\times [H]\times [K] \right\} \\ \end{aligned} E2:={

∣∣⟨whk,ϕ(s,a)⟩−Qhπ(s,a)+[Ph(Vh+1π−Vh+1k)](s,a)∣∣ ≤β∥ϕ(s,a)∥(Ahk)−1,∀(a,s,h,k)∈A×S×[H]×[K]}

并回忆(8)中 E1 的定义。 那么,在假设 1、2、3、4 和定理 1 中 β 的定义下,存在一个绝对常数 c β > 0 {

{c}_{\beta }}>0 cβ>0,使得对于任何固定的 δ 在 ( 0 , 0 , 5 ) \delta \ 在 (0,0,5) δ 在(0,0,5) 中,概率至少为 1 − δ 1-\delta 1−δ,事件 E : = E 2 ⋂ E 1 \mathcal{E}:={

{\mathcal{E}}_{2}}\bigcap {

{\mathcal{ E}}_{1}} E:=E2⋂E1 保留。

作为我们的主要技术贡献,在引理 1 中,我们证明了当 κ h ( s ) : = 2 H τ − τ h ( s ) + 1 { {\kappa }_{h}}(s):=\frac{2H}{\tau -{ {\tau }_{h}}( s)}+1 κh(s):=τ−τh(s)2H+1,则在面对安全约束时保持乐观,即保证 Q h ∗ ( s , a ) ≤ Q h k ( s , a ) Q_{h}^{*}(s,a)\le Q_{h}^{k}(s,a) Qh∗(s,a)≤Qhk(s,a) . 直观地说,这是必需的,因为算法 1 第 10 行的最大化不在整个 A h safe ( s h k ) \mathcal{A}_{h}^{\text{safe}}\left( s_{h}^{k} \right ) Ahsafe(shk),但只是其中的一个子集。 因此,需要更大的 κ h ( s ) { {\kappa }_{h}}(s) κh(s) 值(与不安全算法 LSVI-UCB 中的 κ h ( s ) = 1 { {\kappa }_{h}}(s)=1 κh(s)=1 相比) 为算法提供足够的探索,以便 A h k ( s h k ) \mathcal{A}_{h}^{k}\left(s_{h}^{k}\right) Ahk(shk) 中的选定动作 - 通常足够 - 乐观,即, Q h ∗ ( s , a ) ≤ Q h k ( s , a ) Q_{h}^{*}(s,a)\le Q_{h}^{k}(s,a) Qh∗(s,a)≤Qhk(s,a)。

引理 1 (面对 SLUCB-QVI 安全约束的乐观态度) Lemma 1 (Optimism in the face of safety constraint in SLUCB-QVI)

令 κ h ( s ) : = 2 H τ − τ h ( s ) + 1 { {\kappa }_{h}}(s):=\frac{2H}{\tau -{ {\tau }_{h}}(s)}+1 κh(s):=τ−τh(s)2H+1 和假设 1,2,3 ,4,5 保持。 然后,以 E \mathcal{E} E 为条件,它认为 V h ∗ ( s ) ≤ V h k ( s ) , ∀ ( s , h , k ) ∈ S × [ H ] × [ K ] V_{h}^{*}(s)\le V_{h}^{k}(s),\forall (s,h,k) \in \mathcal{S}\times [H]\times [K] Vh∗(s)≤Vhk(s),∀(s,h,k)∈S×[H]×[K]。

我们在附录 A.2 中报告了证明。 作为引理 1 和定理 2 中定义的事件 E 2 { {\mathcal{E}}_{2}} E2 的直接结论,我们有:

Q h ∗ ( s , a ) ≤ ⟨ w h k , ϕ ( s , a ) ⟩ + β ∥ ϕ ( s , a ) ∥ ( A h k ) − 1 + [ P h V h + 1 ∗ − V h + 1 k ] ( s , a ) ≤ Q h k ( s , a ) Q_{h}^{*}(s,a)\le \left\langle \mathbf{w}_{h}^{k},\phi (s,a) \right\rangle +\beta { {\left\| \phi (s,a) \right\|}_{ { {\left( \mathbf{A}_{h}^{k} \right)}^{-1}}}}+\left[ { {\mathbb{P}}_{h}}V_{h+1}^{*}-V_{h+1}^{k} \right](s,a)\le Q_{h}^{k}(s,a) Qh∗(s,a)≤⟨whk,ϕ(s,a)⟩+β∥ϕ(s,a)∥(Ahk)−1+[PhVh+1∗−Vh+1k](s,a)≤Qhk(s,a)这被封装在以下推论中。

推论 1 (UCB) Corollary 1 (UCB)

让 κ h ( s ) : = 2 H τ − τ h ( s ) + 1 { {\kappa }_{h}}(s):=\frac{2H}{\tau -{ {\tau }_{h}}(s)}+1 κh(s):=τ−τh(s)2H+1 并让假设 1,2, 3,4,5 保持。 然后,以 E \mathcal{E} E 为条件,它认为 Q h ∗ ( s , a ) ≤ Q h k ( s , a ) , ∀ ( a , s , h , k ) ∈ A × S × [ H ] × [ K ] Q_{h}^{*}(s,a)\le Q_{h}^{k}(s,a),\forall (a, s,h,k)\in \mathcal{A}\times \mathcal{S}\times [H]\times [K] Qh∗(s,a)≤Qhk(s,a),∀(a,s,h,k)∈A×S×[H]×[K]。

在使用引理 1 证明了 SLUCB-QVI 的 UCB 性质后,我们准备利用经典不安全 LSVI-UCB (Jin et al., 2020) 的标准分析来完成分析并建立 SLUCB-QVI 的最终后悔界。

4、5、6

基于线性函数近似的安全强化学习 Safe RL with Linear Function Approximation 翻译 2 —— https://blog.csdn.net/baishuiniyaonulia/article/details/125572881