Title: 知乎热议:ai for science值得研究研究吗?

来源链接: https://www.zhihu.com/question/547902474

导读

ai for science比如跟大气气象有关的天气预报,物理分子有关的分子动力学,生物相关的多组学疾病分析,知友们觉得哪个更好?

回答一

作者:Hsuty https://www.zhihu.com/question/547902474/answer/2804556667

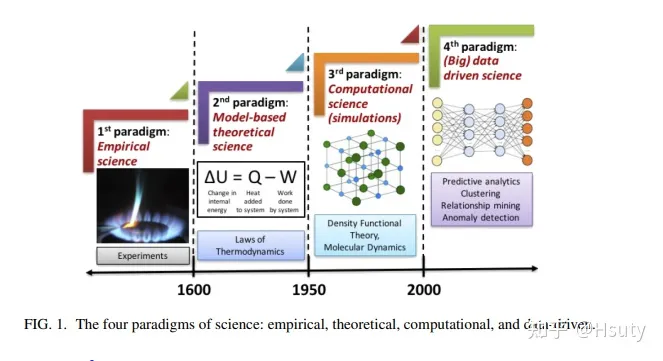

搬运汤超院士对于AI for science的想法,即从三个层面分析了“AI for Science”的内涵。

汤超院士是物理学界大佬,在自组织临界性领域做出过突出贡献。以下为汤超院士的致辞节选,与大家分享。

关于AI for Science,我有一些粗浅的想法,借此机会和大家交流一下。我觉得它包含三个方面,或三个层次的内容。第一个方面是目前这个领域大部分人在做的,就是把AI技术,更准确的说对大部分人来说是深度学习技术,用于各个不同的场景,用于各个学科中的科研、技术创新、成果转化等。这在目前是影响比较大,见效也比较快的。在这个方面,目标一般都是明确的、具体的:比如解量子力学方程、解复杂的流体力学方程、建议合成化学分子的路径、蛋白质折叠、针对靶点设计小分子药物、各种影像识别、等等。这方面的进步、产生的成果,确实在一些方面,大大加速了科学和技术的进步。但也应该认识到,在这方面,从1到10、10到100、甚至10到1000的例子不少,而从0到1的可能不多。当然有许多实际问题的解决并不一定需要0到1的创新。但我认为我们应该努力营造一个良好的创新生态,少做一些表面文章,多鼓励原始创新。只有这样,AI for Science才能健康、平衡、长远的发展。

我觉得AI for Science还应该有第二个层次的内容,就是利用AI来发现new science。举一个比较极端的例子,用大量的行星运动数据来训练AI,它应该很容易就能预测行星的轨道,以及将来任何时刻行星在轨道上的位置。进一步,很有可能它也能发现开普勒三定律。但至少现在来看,很难想象它能再进一步,发现牛顿定律。而牛顿定律的发现建立了一个全新的理论框架,在本质上改变了科学范式。2009年,Science杂志发表了一篇文章,题目是:“Distilling Free-Form Natural Laws from Experimental Data”。翻译成中文就是“从实验数据中提炼自由形式的自然规律”。作者用计算机来分析诸如简谐振动、双摆的运动轨迹(双摆的运动是混沌状态的),机器自动的发现了一些有意义的守恒量的解析表达式,比如哈密顿量、动量守恒等。猛一看,似乎机器可以发现新科学。但本质上,是人去让机器找运动的守恒量。而不是机器提出了守恒量的概念。果然,两个月之后,Phil Anderson(著名物理学家)在Science杂志上发表了对此项工作的评论,题目是:“Machines Fall Short of Revolutionary Science”,翻译成中文就是“机器离科学革命还有距离”,严厉反驳了上篇文章的观点,认为上篇文章曲解了科学的本质。Anderson的观点是,就像Thomas Khun说的,科学实践分为两类,一类是大部分科学家大部分时间都在做的所谓“normal science”,它只是在充实、完善已有的科学范式的结果。还有一类就是偶尔发生的科学革命,建立新的科学范式。Anderson说尽管机器也许可以对normal science有贡献,但他看不见有任何机制可以让机器来创造一个科学革命、发现新的物理定律。我并不完全同意Anderson的观点。且不说Thomas Khun的简单分类是否合理,我觉得没有理由来否认AI发现新的科学定律的可能性。当然就像Anderson说的,第一篇文章里的例子没有说服力,机器找到的都是我们已经知道的定律(比如守恒律),换句话说,是我们告诉机器要去找什么。AI是否能发现新的科学规律,引发科学革命,我认为是一个很有意思、很值得探索的问题。

AI for Science 还有第三层意思,简单说就是Science of AI。AI是一个强大的使能技术,但背后肯定有其科学原理,也就是说,会有相应的Science。计算机科学家、数学家、物理学家已经在这方面做了不少工作。去年的诺贝尔物理学奖的一半颁给了Giorgio Parisi,表彰他在自旋玻璃方面的工作,其中提到他通过自旋玻璃模型发展的统计物理理论在神经科学和机器学习领域中的影响。我觉得这方面应该还有更广泛、更深刻的科学内涵。不仅仅是已有的一些概念和理论的应用,更是新的概念和理论的出现。AI最早是想模拟人类的Intelligence,深度学习的网络架构也受启发于人类大脑的神经网络。从直觉上看,神经生物学的进步应该会进一步促进AI的进步,反过来,AI的进步也应该会启发帮助我们对大脑、对人类智能的理解。当然也有可能最后AI和NI(natural intelligence)没有太大关系。但无论如何,Science of AI 应该是有的,也是科学的前沿。

总之,我觉得AI for Science是一个非常有意思、非常有挑战的交叉学科领域,也是一个难得的机遇。它从基础研究到转化,再到企业都有很好的前景。它也必将在推动科学与技术的进步、促进经济发展、提高人们生活水平等方面发挥重要作用。

回答二

作者:匿名 https://www.zhihu.com/question/547902474/answer/2768102021

先说观点,ai for science是辅助工具的升级,但本身不会解决任何科学问题。

本科毕业那会儿做过两年AI+分子动力学,也分别混过AI、分子动力学、AI+分子动力学的文章。

AI for science一般都是用在模拟计算上,但模拟计算有个众所周知的问题,算出来的不一定对。计算出来的很多现象没有实验佐证,没有人能保证正确。很多情况下都是实验做完形成逻辑之后,对实验看不清楚,做不出来的东西,补充一下计算。一般计算结果符合逻辑,又不和实验冲突,就ok了。

但这些计算不一定对,例如分子动力学计算,原子间相互作用的描述全是经验参数,换一组参数就可以得到不同的结果。甚至可以想要什么结果,就可以找出对应的参数。往底层走,就算用量子力学算,用最少的经验参数,也不保证是准的。

很多研究都是ai学完之后,计算结果比传统模拟方法更准,效率更高,从此xx领域有了更多的想象力。但是这些只能看模拟方法的进步,就好比从计算员到计算机的升级,但是最终结果对不对,符不符合物理,还是需要实验说事。

当然你要跟我说实验也不准,那也行吧。但是在ai4science最火的环化生材,整体实验结果还是要比计算有说服力很多。我也希望有一天能够做实验的人,需要通过计算来佐证自己的实验观测是对的,但现在看着不太可能。

但ai4science确实有价值,他的打开方式应该是给人指方向。例如“炒菜法”做了一堆实验,把数据喂给ai,让他指一个大概方向,“精准炒菜”。或者大规模计算前,对很多参数都没概念的时候,先让ai模型xjb算一堆,然后从这个结果垃圾堆里面找参数。就和 @SoulframEE 对AI绘画的观点一样,正确打开方式是大量出廉价样章,然后画师找灵感改或者画。

[3]如果自己就是做ai的,那建议做点别的。如果自己是做science的,那就是普通做模拟的。

回答三

作者:媛儿 https://www.zhihu.com/question/547902474/answer/2785085289

这个问题很有趣,是个很有价值的问题,但这个问题太大了,是一个相当难回答好的问题,无论是人工智能还是科学都是相当大的领域范畴,应该这个世界上几乎不存在能把这两个领域的东西都搞得相当清楚的人出现来回答你的问题,其实很多答主都回答过了研究前景,但我思考的可能是其他方面,可能有点偏题,但我觉得可能是非常有意义的。

1.交叉科学

为什么有答主提醒你赶紧跑,因为其实ai for science是相当于在产生交叉学科,交叉学科是非常难学好做好的,我为什么这么说呢,因为有先例,材料就是非常非常典型的交叉学科就是物理和化学的杂糅体。但我可以非常自信的告诉你我觉得反倒是纯物理或者是纯化学出身的人做材料都比纯材料出身的人做的要好很多,所以我觉得未来的趋势还是会分成两拨人,一个是做人工智能的人来去做这项工作,再一个是做科学的人来做这个工作,但在早期我更看好后者主导来做,为什么呢,因为科学的底层原理没有相当的基础你后天学习是很难的,科学是相当相当专精的领域,而人工智能是相对更通用的领域,学计算机的人是根本不知道自然科学研究的难点和痛点的,而且你也看到了基本上都是各学科的人转去做计算机的比较多,而从计算机科学跑来学科学的相对较少。后者不是不可行,而是难度会更大,隔行如隔山这句话不是闹着玩的,所以这行就像物理一样适合有天赋的人来做。当然学计算机的人在这行有没有发展前景,有,做通用的人工智能框架。

2.ai for science 的概念

第二点我想谈的其实是ai for science 并不是新概念而是很早就有的,生物有生物信息学,化学有化学信息学,材料有材料基因组计划,基本上都是科学和人工智能的交叉应用,但为什么最近又突然涌现出来了呢?就是因为deepmind做出的alphafold,所以生物的研究一下子又变火爆了,全国都涌现了非常多生物制药的公司。这又让我想起来材料领域石墨烯的例子了,其实有关石墨烯的理论研究早在上世纪80、90年代都研究的非常透彻,但就是因为2004年实验上合成了单层石墨烯,2010年得了诺贝尔奖,然后石墨烯就又变成了爆点,你会发现科学的研究发展就是这样,就是螺旋上升的。所以我觉得我们应该思考的是这次的浪潮和之前的有什么区别,人工智能技术的发展是否为解决旧的科学问题带来了新的解决方案,如果有新的解决方案那么我觉得继续前进下去就是有研究前景的。困扰计算材料学无法继续进行下去最主要的原因,就是算不动和算不准,算不动主要是因为计算量会随着计算体系的大小斗升。算不准主要是采取的近似的方法,过于简化,难以求解。人工智能和分子动力学交叉能火爆起来就是因为其实解决了算不动的问题。然后这就又提到了一个答主说的问题,是不是算不准的科学研究就没有意义,我们先来讲讲算的准的,宏观仿真的领域有限元的方法用的很普遍也算的准,但基本上你在计算的时候你是没办法完全还原真实情况的所有条件的,所以就算是算的准的,计算结果和实验结果不一致是非常常见的事。所以计算一直不是为了跟实验保持一致而诞生的,也不是说谁准确就要以谁为依据,计算一直以来的意义就是简化研究对象,把研究问题研究现象的主要矛盾抓出来,把原理的问题搞清楚,量化可控的误差非常重要。

3.关于方向

我发现一个很普遍的现象就是我们国家跟风的趋向性太严重了,深度学习、自然语言处理、计算机视觉、自动驾驶、生物医药再到现在人工智能和科学的交叉,全都是有一个引爆点产生,然后就有一窝蜂的人都跑来做这个方向,但其实科学研究从来就不是爆发性发展的,包括谷歌做的生物计算的项目,其实都做了很多年的,只是近两三年达到的效果更好更明显一些。我们国家大众大概是从2016年开始因为alphago火爆而注意到人工智能的,但deepmind公司其实是在2010年成立的。也就是说你在研究一个新方向的时候,其实你是不知道哪些方向会产生爆点,而且当你选择去追随这个引爆点的时候其实已经不算是研究这个方向的最佳时机了。但你说普通人就是没办法预判,我是这么看待的只要是你的研究方向不是非常的边缘化,你目前可以想到一些办法去解决一直没有被很好解决的学术问题,就是有一定的研究前景的,因为热点太多了,根本追不过来的。

我每次看到知乎时间线上只要谷歌一做出来什么成果,然后就一窝蜂的人去分析研究复现,我就觉得这是一个特别可怕的现象,其实很多人在做这些行动的时候已经默认了谷歌是最好的公司,觉得谷歌可以引领创新和潮流,当然不是说关注新的研究进展不重要,我觉得我们在向外看的同时其实可以多关注一下我们国家自身的实际情况再去想想是不是这些先进的科学技术可以解决我们国家的一些产业问题。往小了说是不是能解决学术研究的问题。

人工智能是计算机技术,但自然科学其实并不完全是计算,还有一大部分是实验,我感觉很多人可能还忽视的方面是自然科学的基础和起源其实一直是实验,所以你人工智能技术再牛逼,涉及到科学你就不得不考虑实验,而且我发现很多人做人工智能过于偏重于使用深度学习了,当然不是说深度学习不重要。就好像人工智能是一颗大树,可能有一部分的果子是香甜的,其他的稍显一般,于是大家就拼命抢果子香甜的,结果最后就是有一部分完全秃了,抑或是你觉得看着颜色鲜艳,但其实吃下去很苦涩。我觉得总的大趋势是可以追的,但不要太趋向于特别细小的方向。

当然这里夸一下百度的深度学习平台,飞桨做的很厉害,百度是从2012年开始做深度学习的,我随意翻了一下飞桨的平台做的体系非常的庞大,基本上已经涵盖了很多产业。我也把几个大型的互联网公司做的智能制造的平台翻了一遍,但是信息量太少了,看不到有用的成果。

4.关于执行ai for science这个方向对于业界来说的困难点

第一由于业界上市公司商业秘密的限制和共识,建立大数据量级的公开的数据库是非常难的事,所以你会发现在工业界基本没有自行建立的公开的数据库,所以对于自然科学和工程学来说,我觉得需要借助学术界的力量和国家机关来完成。这也是为什么很多人说数据量不够的原因。所有有用有效的数据基本上都集中在大型的制造业企业的手里。是否有新的人工智能技术可以保护企业的商业秘密?

第二目前业界的研发处于两个极端,早期的研发是数据量小,研发机理缺失,非常成熟的生产是数据量大,研发机理大概率基本成熟,所以对于使用一些数据,使用一些物理机理的ai for science是巨大的挑战。

第三追求化学高精度、利用杂化泛函对于工业生产有多大的效果?花大价钱去算超大体系对于工业研发是否有意义和价值?我其实已经离开学术圈很久了,对于新方法、新进展的了解不多,也没有在实际工作中运用过,只是每次看到一些非常酷炫的学术研究烧钱烧的真的太多了,就非常心疼。

第四工业其实目前在我们国家仍然是很虚弱的产业,可能很多人没有在工厂呆过,你去工厂待三个月就知道制造业有多虚弱了。

人工智能和科学碰撞的过程中,你就会发现这两个行业有非常大的不同,在激烈的冲撞。在工业界承接人工智能研究的是互联网行业,承接科学研究的是工业。通用和专精的冲撞,开源与封闭的冲撞,轻资产与重资产的冲撞,短周期迭代与长周期更新的冲撞。

工业的细分子类特别庞大和繁杂,我讲一个材料领域和互联网领域对比的例子,人工智能在互联网企业完成初步扩展大概花了3-6个月的时间,花了大概5-10年的时间到现在已经完成了深度学习的第一波发展小高潮。而目前在材料领域可能涉及到计算的,只有新能源行业,花了大概2年的时间完成了初步的扩展。而新能源只是材料非常非常细小的一个分类。可能有人会说半导体,虽然我可以非常私心地把它归结于非金属材料,但严格意义上更多的是学微电子的人在做这些事,我学了这么多年的材料我都不敢说,我把材料很多细分子类都搞清楚了,我们现在只能优先选择发展国家重点关注的。

以上也只是我的浅见,欢迎评论区讨论。

回答四

作者:yqddddd https://www.zhihu.com/question/547902474/answer/2932122784

简单写一下这几年来对AI for Science的一点个人感受,先说结论,我认为AI for Science值得研究。

首先我觉得回答这个问题首先要考虑的audience是两个背景社区的人,一个是AI背景的人,一个是Science背景的人,这两个社区对这个领域的期待(或者至少最早进入领域的期待)可能有所不同:

AI背景:其实对于AI或者更广泛CS来说,我们本来就期望方法有普适性(既一个新方法可以解决一类问题),所以在这个角度上AI for Science和CV,NLP并没有太大的区别,我个人认为Science中有更广泛的,challenging的,impactful的问题。现在AI大背景下很多CV和NLP的任务大家逐渐认为比较saturated(再加大资源投入对效果提升不明显),所以很多AI背景的研究者都在寻求更广阔的问题。从这个角度来讲,我认为AI for Science很值得研究(当然我们需要更好的配套设施,良定义的问题,dataset, benchmark,etc)。

Science背景:对于Science背景的同学,(我认为)AI会成为一种常用的工具,就像传统的统计分析一样,比如在数学家的视角,AI可以拟合高维函数,在计算化学家的视角,AI可以通过数据驱动自动拟合参数(代替人工设计),还有一系列AI带来的本质提升(我的视角比较有限就不做展开了)。所以说,我认为目前带来最大机遇的一些问题是,传统上十分依赖操作者的经验,而我们大家都知道我们很难找到最优解,甚至很难接近最优解,所以从数据(结构)中学习的方式极大的提升了准确度和generalizability(当然不同的人对generalizability的定义不一样,我这里不做展开了,至少AI/DL能做的是能memorize structure prior然后generalize到相似的数据上)。

我看到下面很多大家的回答讲的很好,包括discover new science(通过打开AI的“黑盒”去更好的理解science),的确这是science发展必不可少的一步,AI可以像我们观测的实验现象一样,他提供了一个解决问题的方法,如果我们能“解码”这种方法就可以作为工具帮助我们更好的探索science。同时我也觉得这个是在任何时候我们都不能忘记的一点,我们还是作为人类,不能一味的使用“魔法”,要谨记去增加我们的认知和对事物的理解(build theory,simulation,etc)。

另外我个人认为,AI for Science带给我们最大的机遇(同时也是挑战)是他真正的促进了多学科融合,原因有很多,比如解决一个历史难题需要多个学科的领域协作;不同领域背景的人在去理解“黑盒”(一个方法为什么work)的时候会有不同的思考,一个比较有意思的例子是diffusion(Science for AI)。而在这之下更大更有意义的问题是,我们之前的知识体系是否还适用?

最后的最后,我十分激动我们生在了这个时代,有着非常多的机遇和挑战,可能到最后像大家所说的,gradient descent并不能解决np-hard问题,但是我能感受到很多的领域都可以极大的被AI增幅,并且通过我们对事物新的理解和认知,可以反哺AI,去构造一个良好的循环和更好的方法。

借此机会也宣传一下我们的一个initiative AI for Science101 (AI for Science 101),如果你是上述AI/Science背景的同学,非常感兴趣这个领域,但是时常苦恼于AI领域的(丰富到overwhelming和飞速发展的网课,开源资料 - fast thinking)或者Science领域的(深入领域的系列课程或者书籍 - slow thinking),非常欢迎关注我们这个initiative,我们(海内外兴趣/工作在AI for Science的各个领域的同学们/通常为PhD student和early-career researcher)旨在通过一系列简短的blog给大家带来对一个领域的深度广度的快速认知,我们只为大家提供兴趣和动力,后续推荐一部分学习资料给想深入学习的同学。

也欢迎大家关注我们在两年前发起的AI for Science workshop (AI for Science)每一届的talk都有recordings,有非常多不同学科的顶尖学者发表的对整个领域的思考和看法

回答五

作者:匿名用户 https://www.zhihu.com/question/547902474/answer/2768931510

如果你是研究生,我建议你赶紧跑。。。

千万别做!千万别做!千万别做!

首先你能在研究生阶段把AI技术吃透已经很不容易了,你有多少把握再吃透另外一个跟你过去四五年八竿子打不着的领域?

其次很多AI for Science场景下算法的创新性是次要的,数据集才是主要的。采集来的数据集质量够高可能用个全连接层就够了。结果就是你的算法技能基本没咋点,但点的全是工具人牛马的技能。

第三,你以为的AI for Science就是AlphaFold那种酷炫吊炸天的工作,但实际上更多时候是一帮不懂AI的生化环材甲方强迫你去实现他们不切实际的脑洞(不懂AI的甲方眼里AI类似于哆啦A梦的口袋,啥都能给你掏出来),而且做的东西除了赚个噱头本身没有任何价值。

最后,研究生毕业了,你发现你在AI方面的技术被做纯AI的人碾压,又没有生化环材的领域知识和专业技能,就几篇IF挺高但毫无卵用的论文,纯纯废物一个。

当然如果你是CS系的导师或企业研究人员,想分一杯羹体验发高分期刊的快感,那我不予置评。我唯一的建议就是收起你计算机人的傲慢,踏踏实实学习其他领域知识,交叉学科很考验人的眼界和知识水平,不是随随便便就可以降维打击的。

回答六

作者:蒸鱼 https://www.zhihu.com/question/547902474/answer/2945691264

作为这方向的博士生来聊聊,以下看法基于百来篇该方向论文的阅读量,不代表有头发的我最终毕业的立场。

首先表个态,我不认为学术界能基于最新的AI技术做出惊天动地的工作,最大的原因之一是学术界小作坊式的思维和客观条件无法催生出这样的成果。这点也是基础学科的通病:离现实太远,离职称太近,离工业太远,离文章太近。

前两天有篇nc将transformer引入单细胞生物注释中硬train一发的文章,得承认这个工作还是大胆的且够新的。但是,它是避开了该领域真正的关注的问题,这一点是AI4Science这个泛概念领域的最大诟病:到处挖坑,至今没有重量级工作成为领域标杆。

好了吐槽完了,讲点有希望的。虽然最新的技术可能不太work,但基于旧的技术还是可以做点东西的。

这里我认为有三种方向。

1.基于传统机器学习的优化方向。选择这方向是由学科特殊性引导的,且拥有足够现实意义,针对性强,能解决本领域和工业届的难题。待展开

2.基于高通量实验的AutoML,以堆砌足够的高质量数据集。待展开

3.由第二个方向引申的,对无法用第一性原理归纳的规律做出概率或数值上的推断,这方向能彻底改变科研范式,是人工智能时代真正的明珠。待展开

再来讲讲当前AI4Science的发展情况。欧洲研究所。国内情况。美国。待展开先占个坑,期末了还有两门考试,考完回来填。