超大规模视觉通用感知模型

通用感知模型简介与发展

通用感知模型是指一个模型解决不同的感知任务,应用于各种模态数据。

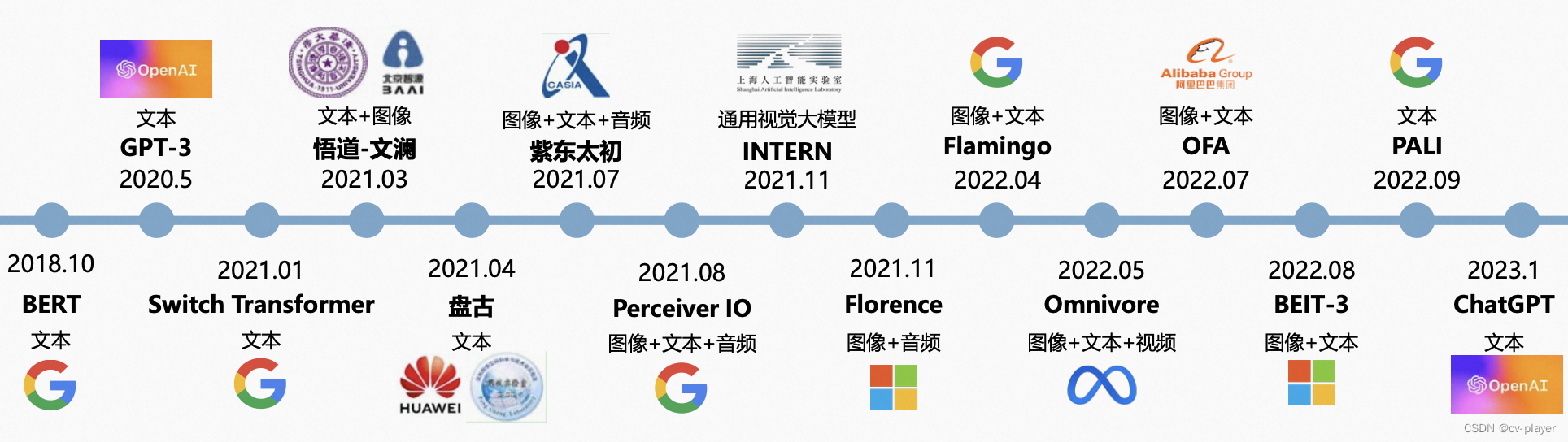

通用感知模型的发展脉络图如下,它由NLP发源,逐渐朝着多模态多任务的方向发展,共同引领着人工智能的进步。

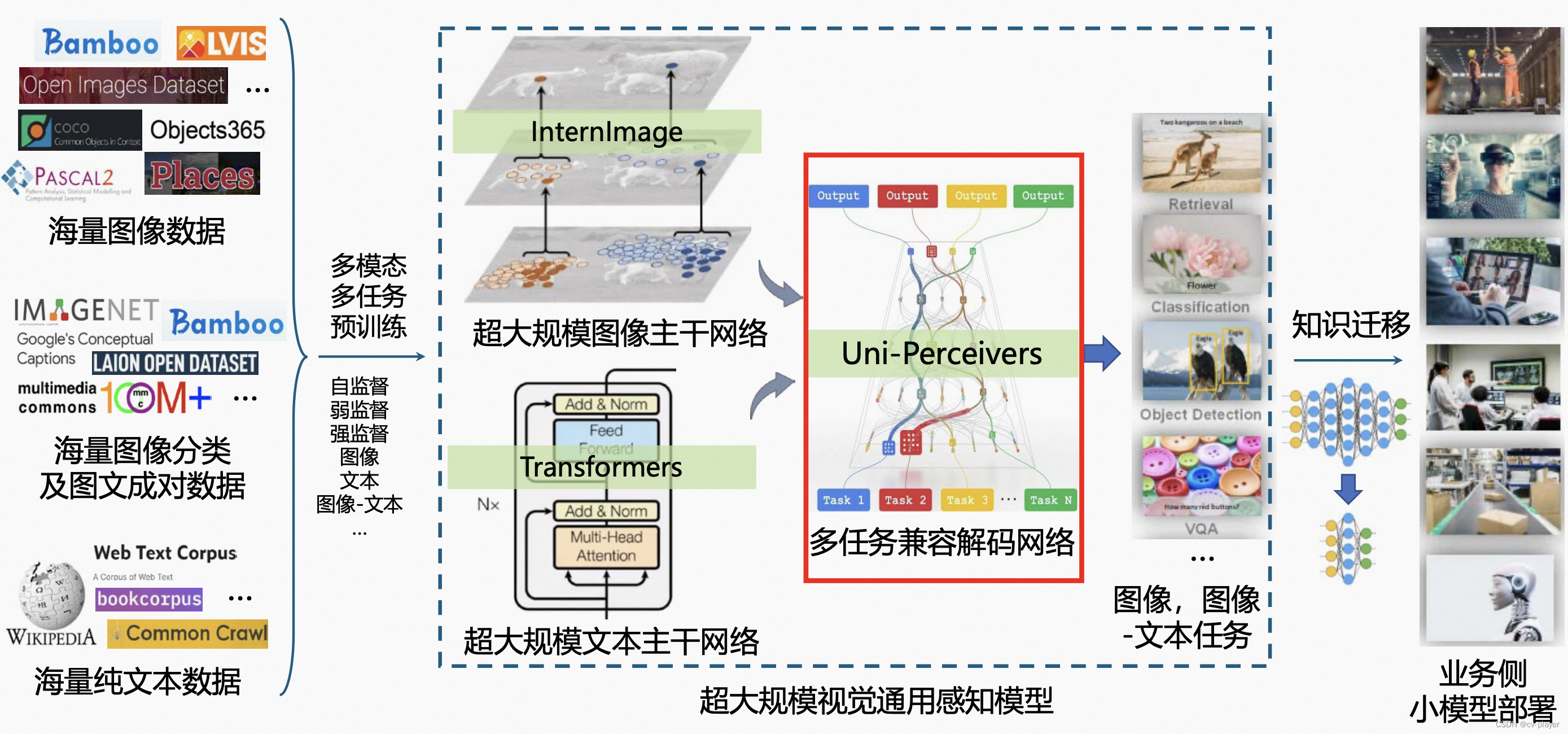

超大规模视觉通用感知模型全景图:

超大规模视觉通用感知模型由超大规模图像、文本主干网络以及多任务兼容解码网络组成,它基于海量的图像和文本数据构成的大规模数据集进行预训练,用于处理多个不同的图像、图像-文本任务。此外,借助知识迁移技术能够实现业务侧小模型部署。

超大规模视觉通用感知模型面临的挑战:

(1)网络参数量庞大,通常超十亿参数,训练稳定性、收敛性、过拟合等问题相较于小网络挑战大很多。

(2)原始数据集包含数十亿异质低质量图片与海量文本,多步训练以利用异质的多模态多任务数据,流程复杂,存在灾难性遗忘,难以定位精度等问题。

(3)实验成本高,通常需要上千块GPU并行训练数周,需要研究者有敏锐的分析能力和扎实的知识基础。

(4)工程挑战多,海量数据的吞吐,大型GPU集群上的并行算法,超大参数量模型的内存管理。

超大规模图像、文本主干网络

超大规模图像、文本主干网络的作用是对海量多模态数据进行学习,提取特征。

超大规模图像、文本主干网络面临的挑战:

- 大模型设计范式:考虑网络深度/宽度/分辨率/分组计算数量的scaling up策略、针对大网络收敛不稳定的特征及梯度调整策略、针对大模型收敛慢的初始化策略、针对大模型容易过拟合的训练策略等。

- 大规模加速训练框架:Pytorch DDP、FSDP、DeepSpeed ZeROs、混合精度计算、融合算子、kernel级别加速、梯度累加、梯度checkpointing、高效数据读取、数据切分、集群 文件和计算系统排疑、训练异常自动监控推送及重启、profiler等。

- 多任务模型训练框架:支持多网络/多任务/多数据集/多模态的联合训练(设计实现高自由 度模块化的Meta Dataloader & Sampler 和 Meta Training & inference Pipeline)、数十个任务-数据集对同时高效读取及预处理、多任务多数据集采样、基于代理任务的自动超 参搜索、多任务梯度/Loss/Acc等统计量对比监控等。

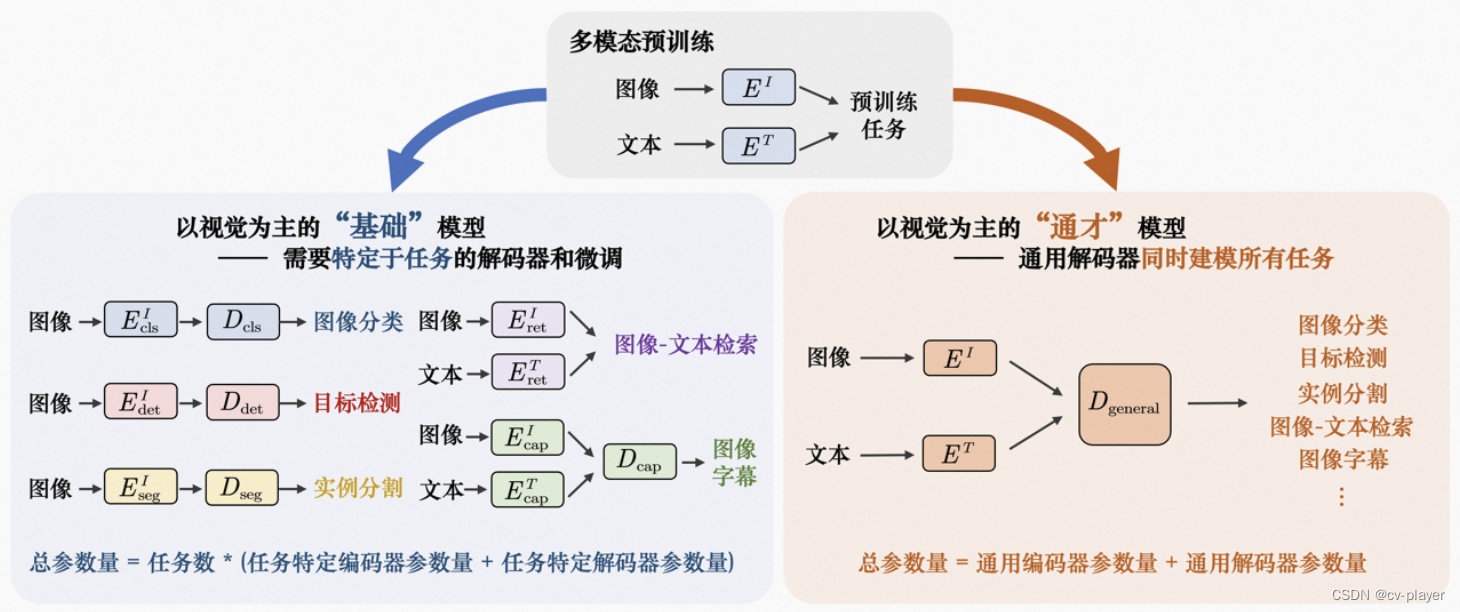

多任务兼容解码网络

多任务兼容解码网络的作用是构建视觉任务通用的解码器网络,实现任务级别的泛化。

多任务兼容解码网络面临的挑战:计算机视觉中,不同任务的表征差异巨大。

参考文献

[1] Su et. al., Towards All-in-one Pre-training via Maximizing Multi-modal Mutual Information. CVPR 2023.

[2] Wang et. al., InternImage: Exploring Large-Scale Vision Foundation Models with Deformable Convolutions. CVPR 2023.

[3] Zhu et. al., Uni-perceiver: Pre-training unified architecture for generic perception for zero-shot and few-shot tasks. CVPR 2022.

[4] Zhu et. al., Uni-Perceiver-MoE: Learning Sparse Generalist Models with Conditional MoEs. NeurIPS 2022.

[5] Li et. al., Uni-Perceiver v2: A Generalist Model for Large-Scale Vision and Vision-Language Tasks. CVPR 2023.