入门小菜鸟,希望像做笔记记录自己学的东西,也希望能帮助到同样入门的人,更希望大佬们帮忙纠错啦~侵权立删。

目录

一、常见方法与其核心

1、线性判别分析

以一种基于降维的方式将所有的样本映射到一维坐标轴上,然后设定一个阈值,将样本进行区分,映射依据为:类间间距大,类内间距小。

以二分类为例:

目标式:最大化——![]()

最终结果:![]()

详见线性判别分析(LDA)详解_tt丫的博客-CSDN博客_线性判别分析(lda)

2、逻辑回归

利用线性回归做分类任务,由Sigmoid函数将线性变化后的值限制在0,1之间作为判定其为1类的概率,以概率值的大小比较决断出其所属类别。(多分类将Sigmoid函数换成softmax)

以极大似然估计法求出最合适的W和b。

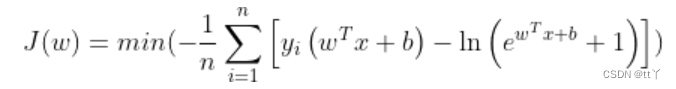

目标式(二分类):

详见逻辑回归(Logistic Regression)_tt丫的博客-CSDN博客_逻辑回归

3、贝叶斯分类器

对样本数据进行假设分布假设,利用贝叶斯决策论,极大似然估计和拉普拉斯平滑求出最合适的分布参数,得到最终的分类器(常用假设分布为高斯分布)

4、决策树

利用信息熵和信息增益等来决出决策节点,建立一棵决策树

5、SVM

以最大间隔找到划分的超平面(线性),以核函数作为变换实现对非线性数据的划分。

求解都与内积相关。

二、这几种常见方法的优缺点和适用情况

1、线性判别分析

(1)优点

速度快;

在降维过程中可以使用类别的先验知识经验;

(2)缺点

LDA不适合对非高斯分布的样本降维;

LDA降维最多降到类别数N-1的维数,如果我们降维的维度大于N-1,则不能使用LDA;

LDA可能会过度拟合数据;

2、逻辑回归

(1)优点

适合分类场景;

计算代价不高,容易理解实现;

不用事先假设数据分布,这样避免了假设分布不准确所带来的问题;

不仅预测出类别,还可以得到近似概率预测;

目标函数任意阶可导;

(2)缺点

容易欠拟合,分类精度不高;

数据特征有缺失或者特征空间很大时表现效果并不好;

3、贝叶斯分类器

(1)优点

简单,学习效率高;

分类过程中时空开销小;

可以使用先验条件;

(2)缺点

受假设变量间独立与假设分布情况的影响(受假设的影响大,如果假设不准确则分类结果也会有很大影响)

4、决策树

(1)优点

相对简单;

可以处理非线性的分类问题;

在应用于复杂的多阶段决策时,阶段明显,层次清楚;

(2)缺点

容易过拟合;

使用范围有限,无法适用于一些不能用数量表示的决策;

对各种方案的出现概率的确定有时主观性较大,可能导致决策失误;

5、SVM

(1)优点

使用核函数可以向高维空间进行映射,以解决非线性的分类;

分类思想很简单,就是将样本与决策面的间隔最大化;

分类效果较好;

(2)缺点

对大规模数据训练比较困难;

难以直接进行多分类,但可以使用间接的方法来做(一对一,一对多);

6、不同情况下适用的方法

(1)数据线性不可分时推荐使用

决策树,SVM(核函数),贝叶斯分类器

(2)具有先验概率分布信息时推荐使用

贝叶斯分类器,线性判别分析

(3)未知数据分布时推荐使用

逻辑回归,决策树,SVM

(4)特征属性很多很多的时候不建议使用

(推荐先删掉一些变化不大的影响不大的特征属性(相关性不大))

SVM(计算量很大)

三、朴素贝叶斯分类器和逻辑回归的互通

以二分类为例:

!!!各属性间互不相关!!!

在逻辑回归中,我们知道

而贝叶斯定理告诉我们:

那么两者相除有:

即有:

那么回到贝叶斯基础公式:

最后那个不就是我们的逻辑回归啦

四、二分类到多分类

五、类别不平衡问题

欢迎大家在评论区批评指正,谢谢~