内容简介

该论文主要讨论了在量子神经网络的不同编码结构和编码策略在解决监督学习任务时的区别。文章对幅度编码和块编码在量子神经网络处理二分类问题时的表现进行对比。通过使用Fashion MNIST、MNIST、对称性保护拓扑态作为识别训练任务,以精度为标准,对不同的拟设线路和编码策略进行基准测试。

相关论文

标题:Quantum Neural Network Classifiers: A Tutorial

作者:Weikang Li, Zhide Lu, Dong-Ling Deng

期刊: SciPost Physics Lecture Notes(2022年8月17日)

论文复现代码

代码链接:https://gitee.com/mindspore/mindquantum/tree/research/paper_recurrence/2023/21_yjshun

点击下方链接观看视频:

01

编码策略和拟设线路

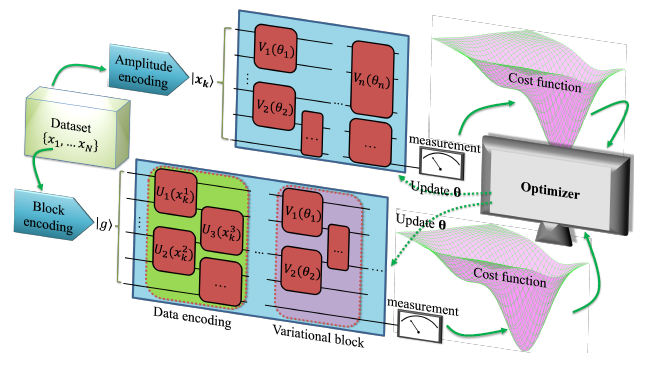

幅度编码(上)和块编码(下)示意图(来源:论文原文)

文章中讨论了幅度编码和块编码两种策略。幅度编码中,待训练数据进行归一化之后,以量子态幅度的形式输入到含参量子线路中,使用的比特数量与数据长度为对数关系。块编码中,训练数据作为参数,编码到ansatz的含参量子门中,需要的比特数与数据长度和线路深度相关。

ansatz线路中每一块中含有三层参数层和一纠缠层,见图(e)。不同的ansatz参数层一样,纠缠层分别取(a)、(b)、(c)、(d)。(来源:论文原文)

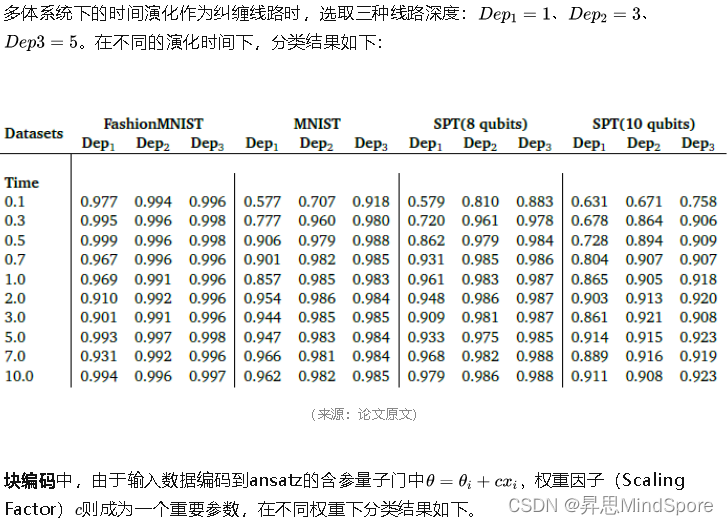

文章在相同的编码策略下,对四种不同的ansatz进行分类性能测试。ansatz中分为参数层和纠缠层两部分,四种ansatz参数层选取一致,纠缠层分别由CZ、CNOT、两层CNOT、多体系统下的时间演化构建。多体系统采用Aubry-André模型。

02

分类任务

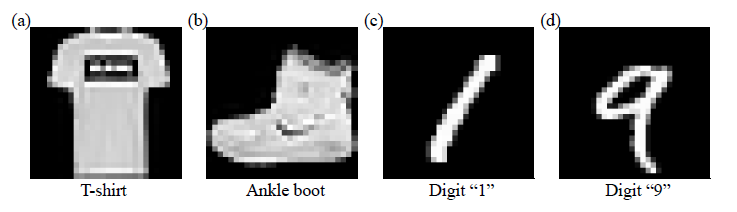

FashionMNIST和MNIST数据集(来源:论文原文)

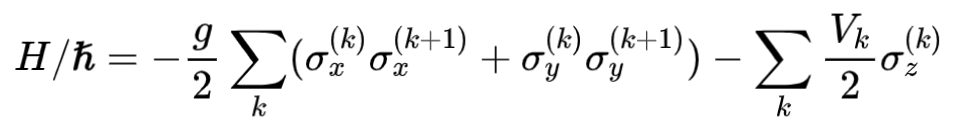

论文采用四种数据集作为分类任务进行基准测试:FashionMNIST、MNIST、8比特对称性保护拓扑(SPT)态、10比特对称性保护拓扑态。FashionMNIST中对T恤和短靴分类;MNIST对手写1、9分类。对称性保护拓扑态采用在周期边界条件下的一维Cluster-Ising模型的基态,模型哈密顿量为

03

分类结果

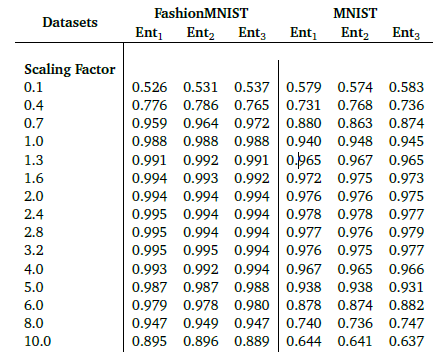

幅度编码下,不同的线路深度和ansatz对应的四种数据集的分类表现为下表,Ent1、Ent2、Ent3分别为前面提到三种纠缠线路(a)、(b)、(c)。

(来源:论文原文)

(来源:论文原文)

可见,不同ansatz对不同数据集的解析能力有所差异,但分类精度基本上和线路深度正相关。块编码存在最优权重因子,分类表现上略逊于幅度编码。

04

复现结果

我们可以在昇思MindSpore Quantum上将上述论文结果复现并做出以下改进:

1. 测量操作选择测量末位两量子比特计算与标签的交叉熵,避免增加对训练集与测试集额外预处理操作,减小误差引入,简化代码,增加可读性;

2. 通过继承训练网络封装类TrainOneStepCell实现模型搭建和训练,增加了代码扩展性并易于测试;

3. 对整个过程建立主类进行封装,易于移植;

4. 针对基于MNIST数据集的分类问题,对参数层和纠缠层进行改进,获得更高精度。

以幅度编码Block Depth=2识别Fashion MNIST及MNIST数据集为例,复现结果为:

| FashionMNIST Ent1 | FashionMNIST Ent2 | FashionMNIST Ent3 | MNIST Ent1 | MNIST Ent2 | MNIST Ent3 | |

|---|---|---|---|---|---|---|

| 原文结果 | 0.994 | 0.989 | 0.980 | 0.546 | 0.831 | 0.848 |

| 复现结果 | 0.996 | 0.990 | 0.982 | 0.677 | 0.844 | 0.868 |

分类精度规律基本与原文结论一致,改进后较原文结果有不同程度的提高。

扫码查看论文复现代码