学习资料:

- 论文题目:《IceNet for Interactive Contrast Enhancement》(用于交互式对比度增强的IceNet)

- 原文地址:export.arxiv.org/pdf/2109.05838v2.pdf

目录

A. INTERACTIVECONTRASTENHANCEMENT—交互式增强

3) Personalized initial η—个性化初始η

1) Interactive brightness control loss—交互式亮度控制损失

1) User studies for IceNet—IceNet用户研究

2) User studies for personalized initial η——个性化初始η的用户研究

3) Quantitative comparison—定量比较

1) Preferences for contrast— 对比度偏好

2) Impacts of parameter settings—参数设置的影响

ABSTRACT—摘要

翻译

摘要 本文提出了一种基于 CNN 的交互式对比度增强算法,称为 IceNet,该算法使用户能够根据自己的喜好轻松调整图像对比度。具体来说,用户提供用于控制全局亮度的参数和两种类型的涂鸦来使图像中的局部区域变暗或变亮。然后,根据这些注释,IceNet 估计用于逐像素伽玛校正的伽玛图。最后,通过色彩恢复,得到增强后的图像。用户可以迭代地提供注释以获得满意的图像。 IceNet还能够自动生成个性化的增强图像,如果需要的话可以作为进一步调整的基础。此外,为了有效、可靠地训练 IceNet,我们提出了三种可微损失。大量的实验表明,IceNet 可以为用户提供令人满意的增强图像。

精读

本文主要工作

本文提出了一种基于CNN的对比度增强算法IceNet,这种算法是交互式的,用户可以根据需要自己调整图像的对比度。

具体方法

- 首先,用户提供了一个参数来控制全局亮度和两种类型的scribble(本义是涂写,我也不知道该怎么翻译)以使图像局部区域变暗或变亮。

- 接着,根据这些注释,IceNet估计出一张伽马图,用于像素级伽马校正。

- 最后,通过颜色恢复,得到增强后的图像。

注意:用户可以反复提供注释,以获得满意的图像。

I. INTRODUCTION—简介

翻译

尽管成像技术最近取得了进步,但由于曝光不均匀、快门周期短和环境光弱等挑战因素,照片常常无法忠实地表现场景细节。此类照片表现出对比度失真、褪色和低强度;特别是,异常的光线条件会严重扭曲颜色、纹理和物体,从而降低视觉体验。对比度增强(CE)技术可以缓解这些问题。

为了开发有效的 CE 技术,人们进行了许多尝试 [1]-[6]。一种简单但有效的方法是使用参数曲线来实现从输入到输出像素值的转换函数[2]、[6]–[9]。例如,幂律是一种众所周知的伽马校正参数曲线[10]。这些参数曲线产生了有希望的结果,但找到对不同图像有效的可靠参数具有挑战性。最近,随着卷积神经网络(CNN)在低级视觉领域的成功[11]-[14],基于CNN的CE方法也被提出,并产生了出色的性能[15]。

已经进行了许多研究来自动执行CE。然而,CE 是一个主观过程,因为人们对对比度有不同的偏好。请注意,对比度在图像解释中扮演着不同的角色。例如,观看者使用对比来吸引注意力;艺术家通过对比来表达重点;平面设计师利用对比度来告诉眼睛该去哪里[16]。因此,没有单一确定的方法来增强对比度。图 1 说明可以通过多种方法来增强同一图像的对比度。专业软件,例如Photoshop,提供了很多可以根据个人喜好调整对比度的工具,但使用这些工具需要花费很大的精力。在本文中,我们提出了第一个基于 CNN 的交互式 CE 算法,使用户能够轻松、自适应地调整图像对比度。

对于交互式 CE,我们提出了 IceNet,它可以在接受用户的注释后增强图像曝光不足和曝光过度区域的对比度。具体地,用户提供用于控制全局亮度的参数和两种类型的涂鸦来使输入图像中的局部区域变暗或变亮。然后,我们将输入图像和注释提供给 IceNet,后者生成用于逐像素伽玛校正的伽玛图。更具体地说,我们将涂鸦以及输入图像提供给特征提取器,生成特征图。同时,我们根据全局亮度参数生成驱动向量。然后,使用特征图和驱动向量,我们获得伽玛图,该伽玛图是根据用户注释自适应生成的。最后,我们通过颜色恢复来恢复增强的图像,其中我们仅调整输入图像的亮度分量,同时保留色度分量。此外,为了方便用户,我们提供了初步增强的图像,并允许用户以交互方式进一步增强它。此外,为了有效、可靠地训练 IceNet,我们提出了三种可微损失。实验结果表明,IceNet 不仅为用户提供了满意的图像,而且在质量和数量上都优于最先进的算法。强烈建议观看补充视频以了解 IceNet 的实时演示。

总而言之,这项工作有以下主要贡献:

• 我们提出了第一个基于 CNN 的交互式 CE 算法,称为 IceNet,它能够根据用户偏好自适应地生成增强图像,或者无需交互即可自动生成增强图像。

• 我们使用所提出的三个可微损失函数来训练 IceNet,从而实现与用户的交互并产生令人愉悦的增强图像。

• 通过各种实验结果,我们证明了IceNet 可以为用户提供满意的结果,明显优于传统算法。

精读

背景

曝光不均、快门周期短、环境光弱等问题——照片会出现对比度失真、颜色褪色和低强度,甚至会使颜色、纹理和物体发生扭曲,从而降低视觉体验

对比增强(CE)的研究

- 传统: 使用参数曲线来转换从输入到输出像素值的函数。

- 本文: 基于cnn的交互式CE算法。

IceNet简介

IceNet:交互式CE,在接受用户的注释后,可以增强图像中曝光不足和过度区域的对比度。

本文主要贡献

- 本文提出了第一个基于cnn的交互式CE算法,称为IceNet,它可以根据用户的偏好,自适应地生成增强的图像,也可以自动生成无需交互的图像。

- 本文用提出的三个可微损失函数训练IceNet,从而实现与用户的交互,并产生效果不错的增强图像。

- 本文通过各种实验结果,证明IceNet可以为用户提供满意的结果,明显优于传统算法。

II. RELATED WORK—相关工作

翻译

CE[15]、[17]、色彩增强[18]、去雾[19]-[21]和细节增强[22]之间的增强目标密切相关但又有所不同。本节简要回顾 CE 技术。

A.传统方法传统

CE技术可分为三类:直方图方法、参数曲线方法和视网膜方法。首先,直方图均衡[10]试图使输出直方图尽可能均匀。它以较低的计算复杂度有效地增加了对比度,但它可能会过度增强图像,导致对比度过度拉伸、噪声放大和轮廓伪影。人们已经开发了各种直方图方法[1]、[3]、[4]、[23]、[24]来克服这些问题。其次,参数曲线方法,例如伽玛校正和对数映射,使用参数曲线作为输入和输出像素值之间的变换函数。许多参数曲线可用于 CE [2]、[6]–[9]。其中,伽玛校正不仅广泛用于CE,而且还用于匹配成像设备之间的不同动态范围。第三,假设图像可以分解为反射和照明,一些CE算法[5]、[25]-[27]基于视网膜理论[28]被开发出来。这些传统方法在某些情况下产生了有希望的结果。然而,它们的性能通常取决于仔细的参数调整;很难找到对不同输入图像有效的可靠参数。

B. 基于 CNN 的方法

最近,许多 CNN 是为 CE 设计的。大多数基于 CNN 的方法 [29]-[36] 都是在配对数据集上进行训练的,这些数据集由低对比度和高对比度图像对组成。每对图像都是从同一场景捕获的,或者从高对比度图像合成低对比度图像。然而,由于移动物体,很难两次捕捉同一场景。另一方面,合成的低对比度图像可能不真实。由于这些困难,一些方法[37]-[39]采用生成对抗网络[11]并使用不成对的数据集训练其网络,这些数据集由从不同场景捕获的低对比度和高对比度图像组成。然而,他们应该仔细选择未配对的图像。为了避免这个繁琐的过程,Guo 等人。 [40]提出了一种自监督学习方案,仅需要低对比度图像进行训练。然而,所有这些基于 CNN 的方法都不具有自适应性,无法满足不同的用户偏好。

C. 交互式方法

对于交互式CE,专业软件提供了工具,但使用这些工具需要大量的努力和培训。为了减少这种工作量,已经提出了简单的交互方法。斯托尔等人。 [41]提出了一种交互式直方图均衡方案来增强医学图像的细节。他们的方法允许用户指定感兴趣区域 (RoI) 并将均衡应用于该区域。 Grundland 和 Dodgson [16] 提出了一种交互式色调调整方法。当用户在图像上选择主色调时,它会保留这些色调,但会调整其他色调,同时保持整体色调平衡。利辛斯基等人。 [42] 和道奇森等人。 [43]还提出了交互方法,其中用户为本地CE指定RoI。这些交互方法[16]、[41]-[43]基于传统的图像处理。相比之下,据我们所知,所提出的 IceNet 是第一个基于 CNN 的交互式 CE 算法。

精读

A. TRADITIONAL METHODS—传统方法

- 直方图方法:【低照度图像增强系列(1)】传统方法(直方图、图像变换)算法详解与代码实现

- 参数曲线方法:如伽马校正和对数映射,使用参数曲线作为输入和输出像素值之间的转换函数。

- retinex方法:【低照度图像增强系列(2)】Retinex(SSR/MSR/MSRCR)算法详解与代码实现_基于retinex理论的低照度图像增强的代码

不足:它们的性能通常取决于仔细的参数调优,对于不同的输入图像,很难找到可靠有效的参数。

B. CNN-BASED METHODS—CNN

- 大多数基于cnn的方法是对由低对比度和高对比度图像组成的成对数据集进行训练的。

- 自监督学习方案,该方案只需要低对比度的图像进行训练。

不足:

- 由于物体的移动,很难两次捕捉到相同的场景。

- 合成的低对比度图像可能不具有真实感。

- 所有这些基于cnn的方法都是自适应的,不能满足不同的用户偏好。

C. INTERACTIVEMETHODS—交互式方法

- 允许用户指定感兴趣的区域(RoI),并对该区域应用均衡

- 交互式调音方法,当用户选择图像上的关键色调时,它会保留这些色调

- 用户为本地CE指定roi

本文提出的IceNet是第一个基于cnn的交互式CE算法

III. PROPOSED ALGORITHM—方法

A. INTERACTIVECONTRASTENHANCEMENT—交互式增强

翻译

A. 交互式对比度

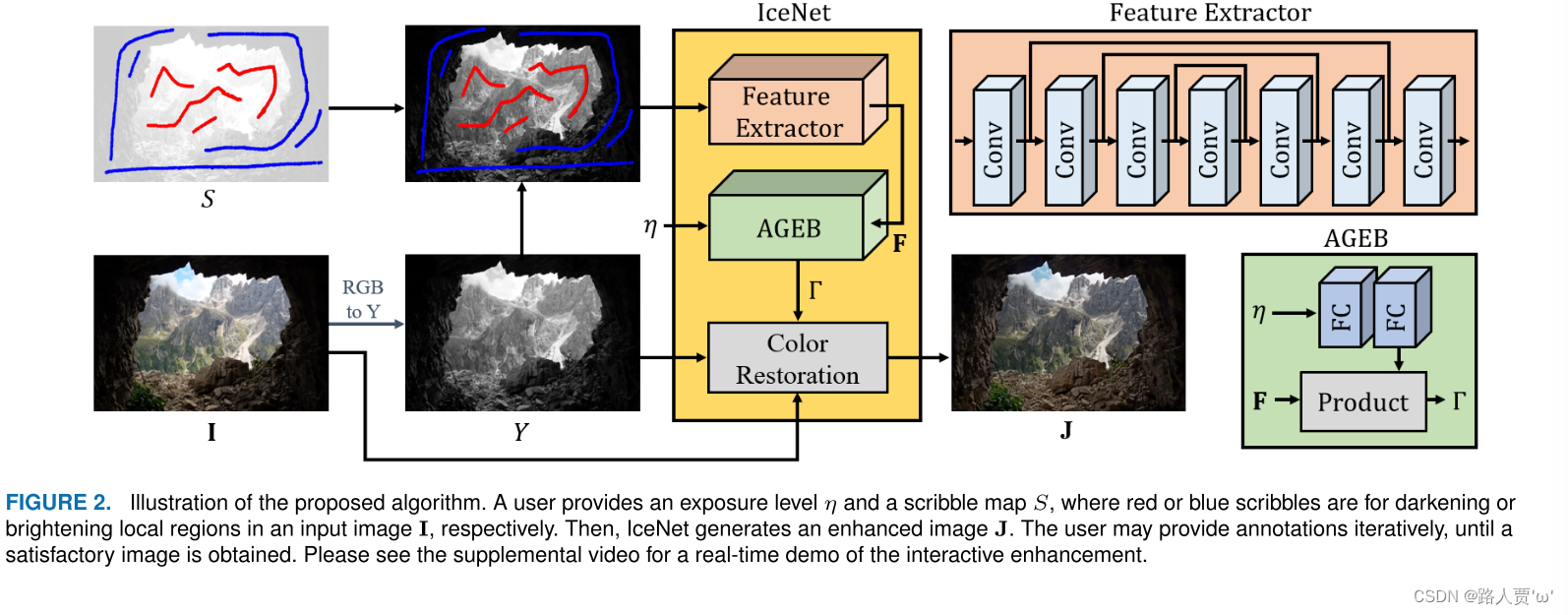

图 2 说明了所提出的算法。通过检查输入图像 I,用户提供曝光级别 η ε [0, 1] 用于控制全局亮度和两种类型的涂鸦。红色和蓝色的涂鸦分别表示用户想要使相应的局部区域变暗和变亮。它们在涂鸦图S中分别记录为-1和1,而其他像素被分配为0。我们将RGB彩色图像I转换到YCbCr空间并仅调整亮度分量Y,同时保留色度分量[4 ]。然后,我们估计用于 Y 的像素级伽玛校正的伽玛图 Γ。最后,通过颜色恢复,我们得到增强图像J。

1)Gamma估计

Gamma校正广泛用于CE[10]。选择合适的伽玛值非常重要:小于 1 的小伽玛会使曝光不足的区域变亮,而大于 1 的大伽玛会使曝光过度的区域变暗。伽玛值的选择也应考虑个人喜好。

我们根据用户偏好,通过图 2 中的特征提取器和自适应伽玛估计块 (AGEB) 确定图像中每个像素的伽玛值。特征提取器由七个具有级联跳跃连接的卷积层组成,这提高了层与层之间的信息流。我们连接 Y 和 S 以形成特征提取器的输入,从而生成特征图 F。然后,给定曝光级别 η 和特征图 F,AGEB 生成伽玛图 Γ。更具体地说,AGEB 通过两个全连接层从 η 产生驱动向量 w。然后,对于每个像素 x,它通过公式(1) 预测像素级伽玛值 Γ(x) (1),其中 ·,· 是内积,而 phi( ·) 是 sigmoid 函数。因此,我们有 0 < Γ(x) < 10。这对所有像素重复。

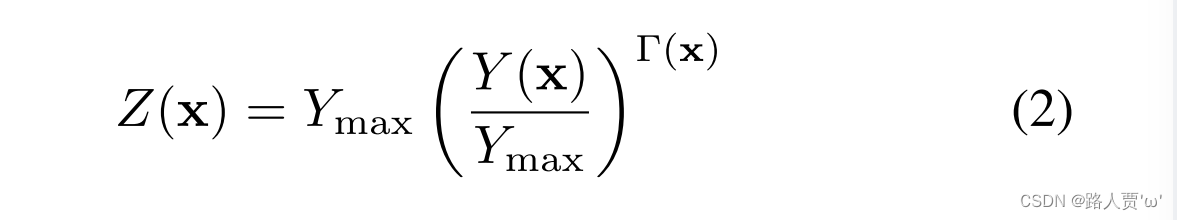

2) 颜色恢复

对于颜色恢复,我们首先通过使用其伽马值变换 Y 中的每个像素来获得伽马校正亮度图像 Z,由下式给出:公式(2)其中 Ymax 是最大亮度值(通常为 255)。然后,为了生成增强的 RGB 彩色图像 J,我们采用简单的颜色恢复方法 [44]公式(3) 保留了颜色比率。

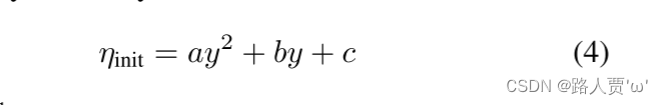

3) 个性化初始

η 为了方便用户,我们提供了初始增强的图像,并允许用户以交互方式进一步增强它。为此,我们使用二次多项式估计初始曝光水平 ηinit :公式 (4) 其中 y = 1 N x Y(x) 是输入图像的平均亮度,N 是数字像素。系数 a、b 和 c 是使用最小二乘法从观测值 {(yi, etai)}M i=1 中获得的,其中 eta 是用户选择的曝光级别,用于使用平均值增强第 i 个输入图像亮度yi。当 M > 3 时,我们执行这种个性化。

精读

整体算法流程

通过检查输入图像I,用户提供一个曝光等级η∈[0,1]来控制全局亮度和两种涂鸦类型(红色和蓝色的涂鸦分别表示用户想要使相应的局部区域变暗或变亮。步骤如下:

- 首先,在涂鸦图S中分别记为−1和1,其余像素赋值为0。

- 接着,将RGB彩色图像I转换到YCbCr空间,只调整亮度分量Y,同时保留色度分量。

- 然后,我们估计了一张伽马图Γ,用于y的像素级伽马校正。

- 最后,通过颜色恢复,得到增强后的图像J。

1) Gamma estimation—伽玛估计

伽玛值的选择

- 小于1的小伽玛会使曝光不足的区域变亮

- 大于1的大伽玛会使过度曝光的区域变暗

通过特征提取器和自适应伽马估计块(AGEB)来确定图像中每个像素的伽马值

特征提取器

- 组成: 7个卷积层

- 输入: 涂鸦图S和亮度分量Y连接起来,得到一个特征图F

- 用户提供: 曝光等级η∈[0,1]

- 输出: AGEB生成一个伽马图Γ

公式

2) Color restoration—颜色恢复

首先通过使用Y中的伽玛值对每个像素进行变换,得到伽玛校正后的亮度图像Z

然后,为了生成增强的RGB彩色图像J,采用简单的颜色恢复方法

3) Personalized initial η—个性化初始η

目的: 为了方便用户,允许用户进一步进行增强操作。

B. LOSS FUNCTION—损失函数

翻译

为了训练 IceNet,我们使用三种可微损失:交互式亮度控制损失 Libc、熵损失 Lent 和平滑度损失 Lsmo。让我们随后描述这些损失。

1) 交互式亮度控制损失

给定曝光级别 η 和涂鸦图 S,我们构建目标亮度图 T 并将交互式亮度控制损失 Libc 定义为公式(5) 使得增强后的图像亮度Z在式(5)中。 (2)适合用户的喜好。为了获得目标亮度T,我们首先将涂鸦S添加到输入亮度Y中,公式(6) 其中λ是控制涂鸦影响的参数,固定为5。通过添加S,我们控制局部亮度级别。接下来,我们将 ~Y 归一化到 [0, 1] 的范围,产生 Y´ 。

然后,我们使用双边伽马调整方案[45]来提高暗区和亮区细节的可见度,其执行公式(7)~(9) 其中 γ = 5。请注意,暗区和亮区主要通过等式 2 得到增强。分别为(7)和(8)。为了保留黑暗和明亮区域的细节,等式: (9) 合并两个结果。用户可以通过曝光级别η来控制G的整体亮度。

图 3 说明了 η 的影响。图 3(a) 显示了当 α = 0.2、0.4、0.6 和 0.8 时从 Y(x) 到 G(x) 的变换函数。所提出的变换函数在最小和最大水平附近具有陡峭的斜率,因此它们使 IceNet 能够有效地增强曝光不足和过度曝光的区域。图3(b)~(e)是增强图像的例子。我们看到,随着 η 变大,增强图像 J 变得更亮。接下来,对于每个像素 x,我们计算局部最大值并将其缩放为 T(x) = Ymax × max y∈Ω(x) G(y) (10),其中 Ω(x) 是周围的 15 × 15 窗口X。在等式中。 (5),我们使用T代替Ymax×G来抑制相邻像素之间目标值差异太大,并实现更可靠的增强。

2)熵损失

当图像的像素值分布更广泛时,图像具有更大的熵并传达更多信息[46]。特别地,最大熵是通过均匀分布实现的。因此,我们采用熵损失通过均衡输出图像的直方图来增加全局对比度。然而,直方图不能直接使用,因为其不可微性。为了克服这个问题,我们设计了一个软直方图。虽然一个像素仅对普通直方图的单个箱有贡献,但它以可微分的方式对软直方图中的多个箱有贡献。

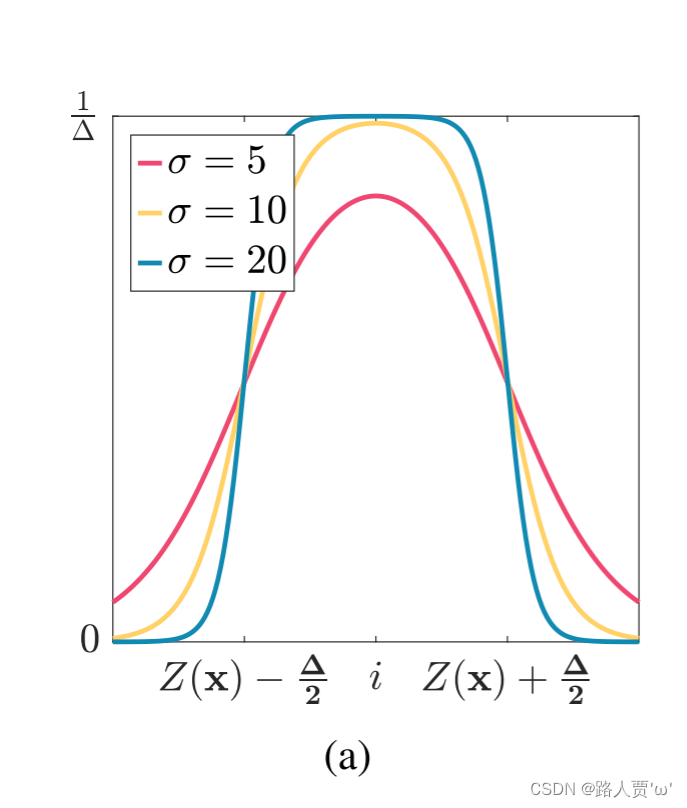

对于软直方图,我们使用[47]中的映射函数表示像素 x 对第 i 个 bin 的贡献,由下式给出:公式(11) 其中 (·) 是 sigmoid 函数,Δ = 1 是 bin 宽度,σ 是坡。图 4(a) 显示了 σ = 5、10 或 20 时的软映射函数。请注意,σ 控制映射函数的宽度和高度之间的权衡。随着 σ 的增加,映射函数变得更窄但更高。在这项工作中,我们设置 σ = 10。接下来,我们通过对所有像素的贡献求和来制作软直方图 h,公式(12) 然后,我们将 Lent 定义为由 公式(13)

3) 平滑度损失

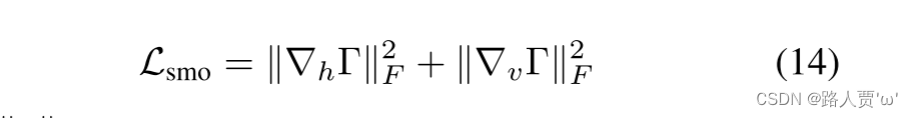

为了鼓励等式中伽玛图 Γ 中相邻值之间的平滑变化。 (1) 引入平滑度损失公式 (14) 其中 ·F 表示 Frobenius 范数,∇h 和 ∇v 是水平和垂直差分算子。

4) 总损失

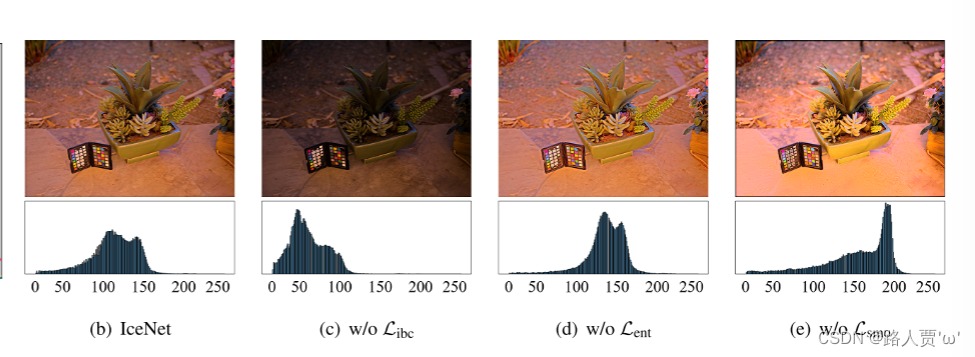

总损失被定义为三个损失的加权和,由 公式 (15) 给出,其中 gone 和 wsmo 是权重。因此,所提出的 IceNet 经过训练以最小化三个损失函数。首先,Libc 使 IceNet 能够控制全局和局部亮度。其次,四旬斋鼓励平坦的直方图,这可以增加全局对比度。第三,Lsmo 平滑伽玛图。图 4(b)∼(e) 说明了每种损失的功效,这将在第 IV-B4 节中讨论。

精读

1) Interactive brightness control loss—交互式亮度控制损失

交互亮度控制损失

目的: 使式(2)中的增强亮度图像Z符合用户偏好。

- 首先,在输入亮度Y上加上scribble的S

- 接着,将Y归一化到[0,1]的范围,得到

- 最后,使用双边伽玛调整方案来提高细节在暗和亮区域的可见性

- 式(7):暗区增强

- 式(8):亮区增强

- 式(9):将这两种结果结合起来,同时保留暗区和亮区细节

图3.曝光水平η的影响:(a)变换函数和(b) ~ (e)增强图像J。

- 图3(a)显示了α = 0.2, 0.4, 0.6, 0.8时

(x)到G(x)的变换函数。

- 图3(b) ~ (e)为增强图像。

- 随着η变大,增强后的图像J变得更亮。

对于每个像素x,我们计算一个局部最大值,并将其缩放为T(x)

2) Entropy loss—熵损失

设计目的

- 最大熵是通过均匀分布实现的,因此通过均衡输出图像的直方图,采用熵损失来增加全局对比度。

- 直方图由于其不可微性,不能直接使用。所以本文设计了一个软直方图。

- σ控制映射函数的宽度和高度之间的权衡。随着σ的增大,映射函数变窄变高。

- 在本文中,设定σ = 10。

通过对所有像素的贡献求和,得到软直方图

定义为熵的倒数

3) Smoothness loss—平滑损失

引入目的: 为了促进式(1)中伽马图Γ中相邻值之间的平滑变化

4) Total loss—总损失

总损失定义为三种损失的加权和

- 首先,

使IceNet能够控制全局和局部亮度。

- 其次,

促进一个平滑的直方图的形成,这可以增加整体对比度。

- 第三,平滑伽马图。

图4(b) ~ (e)说明了每一次损失的效果

C. IMPLEMENTATIONDETAILS—操作细节

翻译

每个卷积层或全连接层的输出通道数为32。在每个卷积层中,执行零填充和ReLU激活。未应用批量归一化,因为使用了 8 的小批量。我们用高斯随机数初始化 IceNet 中的所有参数。然后,我们通过 Adam 优化器 [48] 更新参数,初始学习率为 10−3。我们使用与[40]相同的 2,002 个训练图像。训练图像是在 SICE [49] 的 Part1 子集中随机选择的,包括曝光不足、正常和过度曝光的图像。使用 RTX 2080Ti GPU 迭代训练 50 个 epoch,仅需约 30 分钟。所有训练图像的大小都调整为 512 × 512。为了模拟用户注释,从 [0.2, 0.8] 中随机选择曝光级别 η,并在随机位置分别生成红色和蓝色涂鸦 0∼5 次。对于此仿真,每个涂鸦都是一个半径为 10 像素的圆。在等式中。 (15),went = 10,wsmo = 20。

精读

- 输出通道数:32

- 小批量:8

- 学习率:10的-3次方

- 数据集:SICE

- 训练过程:在RTX 2080Ti GPU上迭代50个epoch,大约30分钟。所有训练图像的大小调整为512 × 512。

- 模拟注释:从[0.2,0.8]中随机选取暴露等级η,并在随机位置分别生成0 ~ 5次红色和蓝色涂鸦。

- went = 10, wsmo = 20。

IV. EXPERIMENTS—实验

A. COMPARATIVEASSESSMENT—比较评估

翻译

我们将所提出的算法与交互式增强算法(CB [43])和七种传统算法(LDR [4]、SRIE [26]、LIME [5]、Li et al. [27]、RetinexNet [32]、Zero -DCE [40],EnlightenGAN [39])。接下来,我们进行对比偏好分析。所有实验均使用 RTX 2080Ti GPU 和 Ryzen 9 3900X CPU 在 Python 中进行。

A.比较评估

在本节中,除非另有说明,我们使用作者提供的源代码和参数来获得传统算法的增强图像。

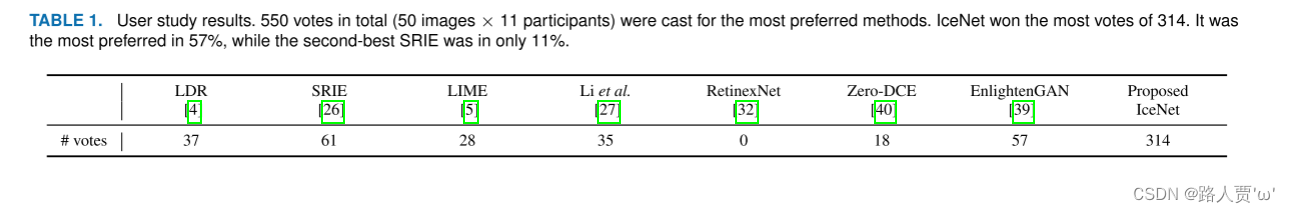

1) User studies for IceNet—IceNet用户研究

交互方法[16]、[42]、[43]的源代码不可用。因此,我们自己实现了 CB,并在 MEF [50] 的测试集上与提出的 IceNet 进行比较。我们要求 11 名参与者为这两种交互方法提供注释,并投票选出更好的结果。共有 187 票(17 张图片 × 11 名参与者)投票选出首选互动方式。提议的 IceNet 赢得了更多的选票:IceNet 在 80.2% 的测试中受到青睐,而 CB 仅占 19.8%。图 5 比较了定性结果,其中结果是由同一参与者获得的。虽然 CB 没有充分改善对比度,但 IceNet 成功地做到了这一点。

为了进行更主观的评估,我们通过从 NPE [25](85 张图像)、LIME [5](10 张图像)、MEF [50](17 张图像)的每个测试集中选择前 10 张索引图像来收集 50 张图像。 DICM [4]、[23](69 个图像)和 VV [51](23 个图像)。然后,我们对 11 名参与者进行了另一项用户研究。它的设计如下:

1)参与者向 IceNet 提供注释,然后生成增强的图像。

2)将IceNet和七种常规算法获得的八张增强图像以随机顺序呈现给参与者。

3) 参与者投票选出最满意的结果。

建议观看本用户研究演示的补充视频。

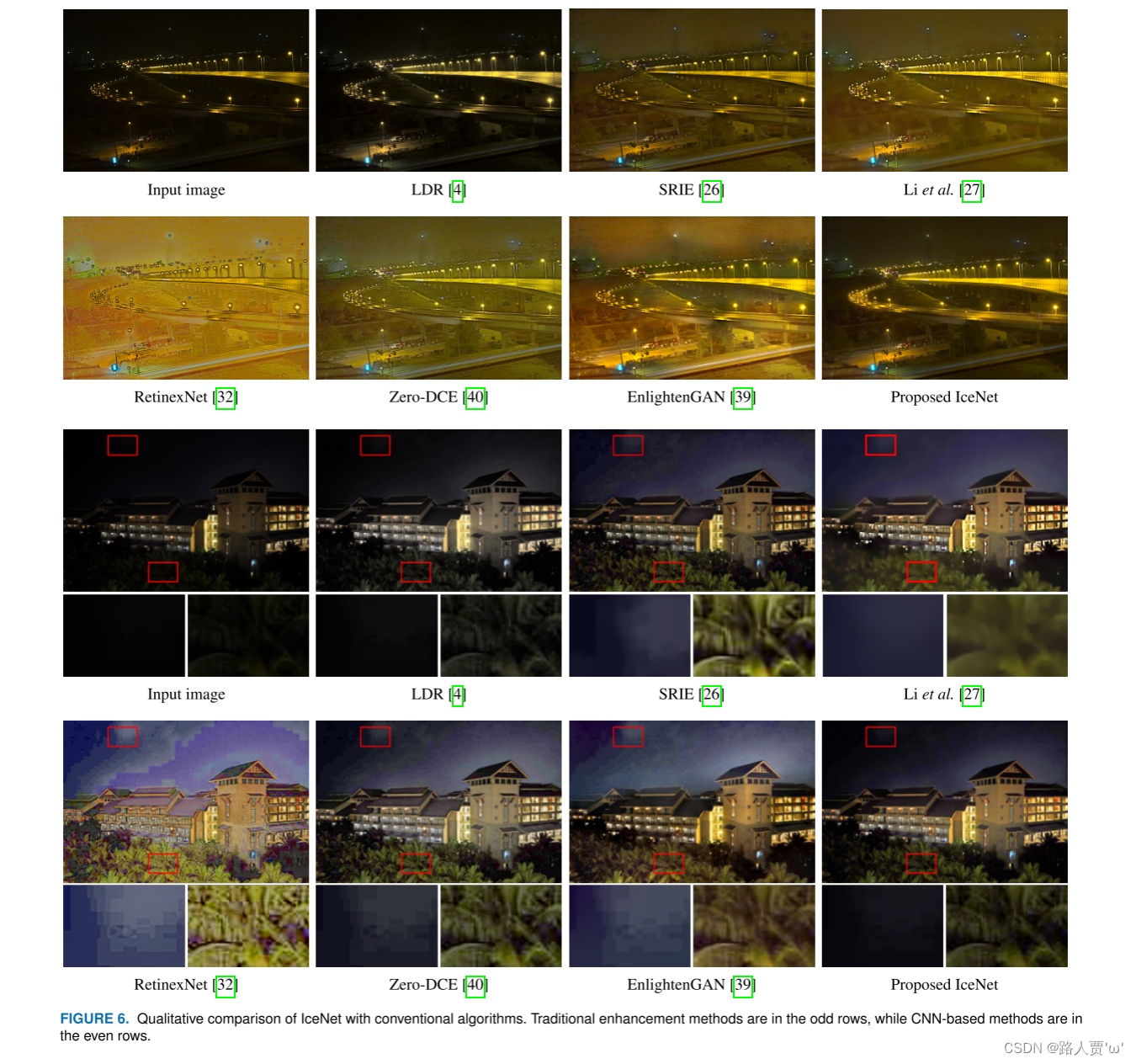

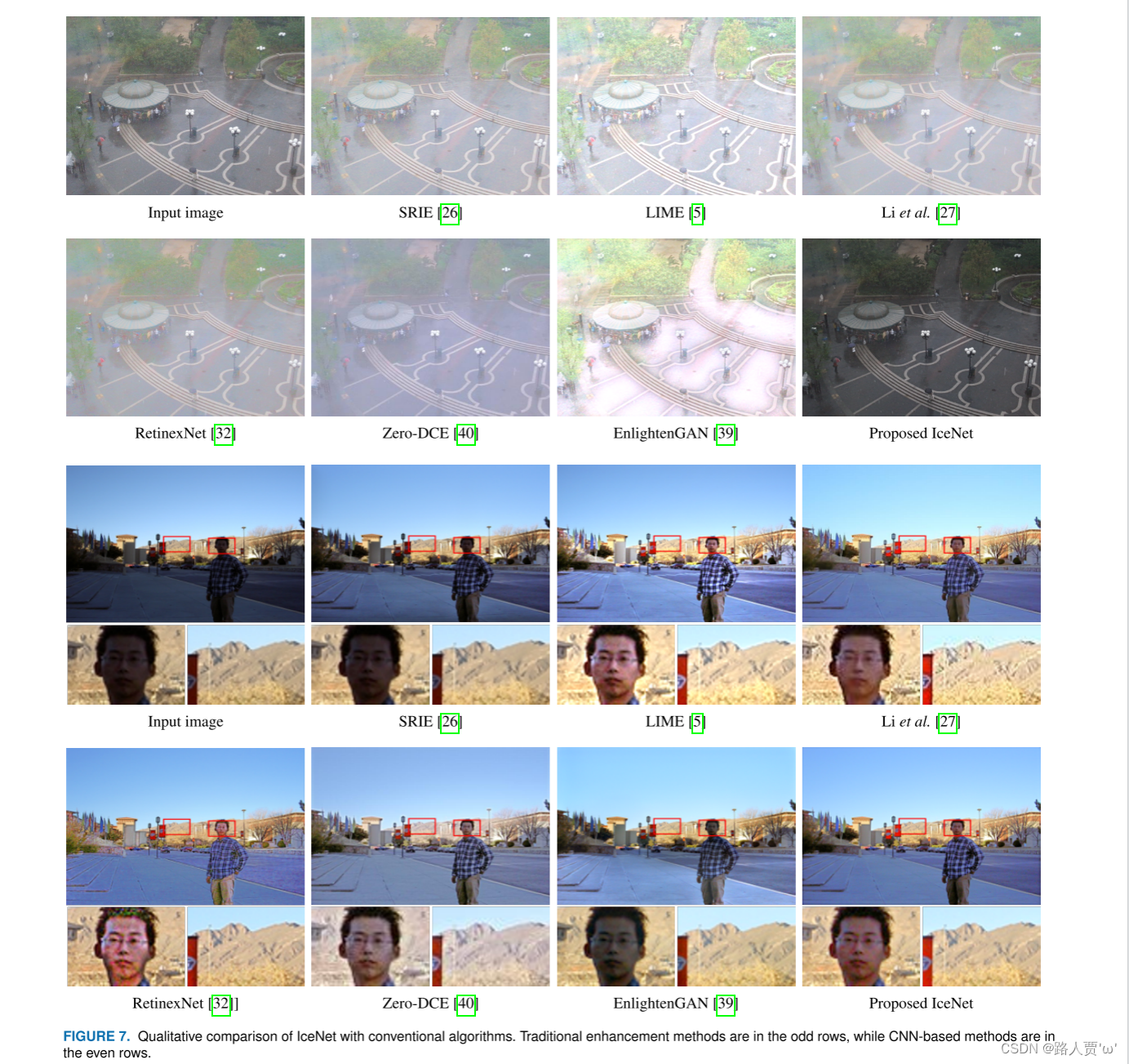

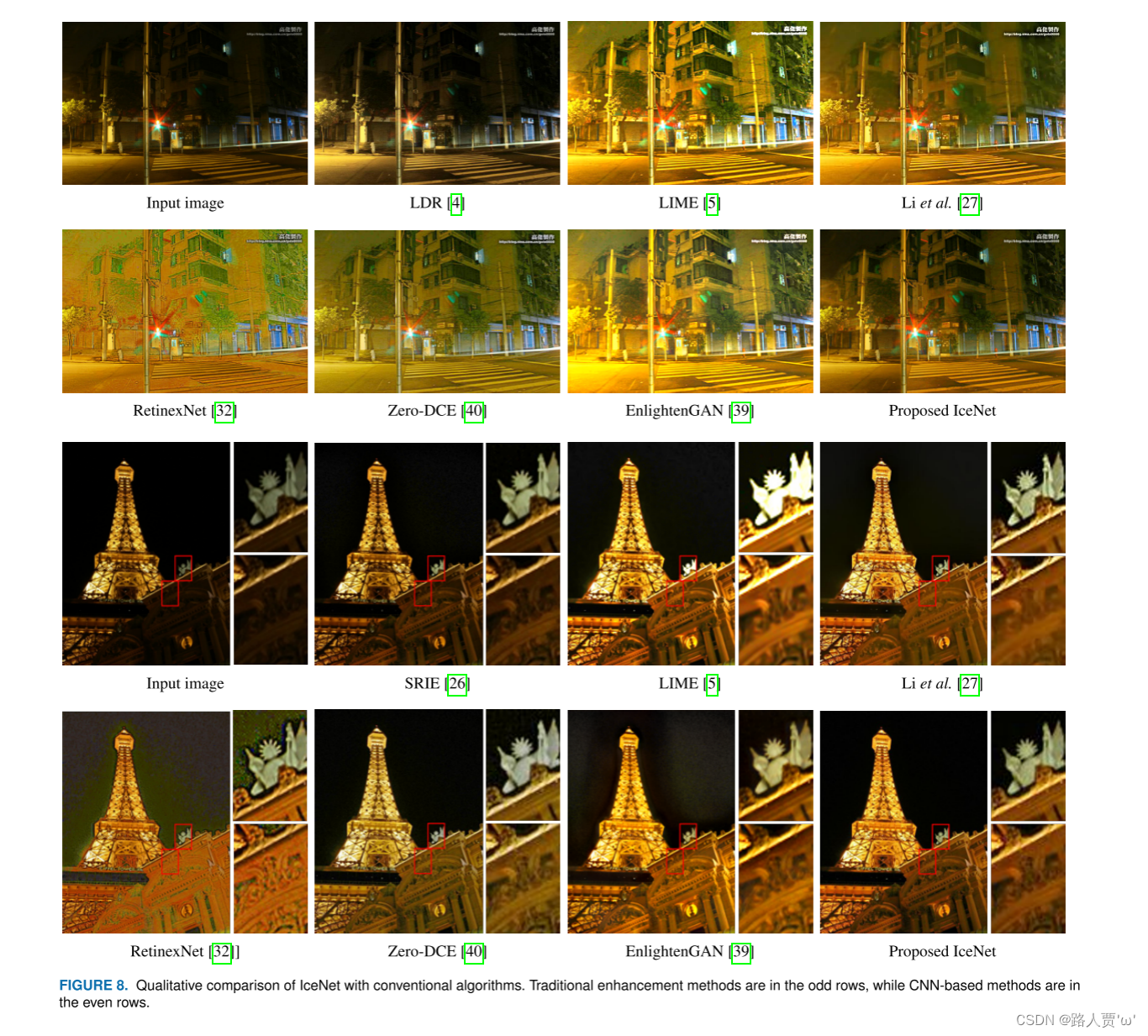

请注意,与 IceNet 的结果相比,参与者可能更喜欢传统算法的自动增强图像。这项研究的目的是检查参与者是否对使用 IceNet 的交互增强结果感到足够满意。表 1 总结了结果。提议的 IceNet 赢得了最多票数;它在 57% 的测试中是最受欢迎的,而第二好的 SRIE 只有 11%。图 6、图 7 和图 8 比较了定性结果,其中 IceNet 的结果是由参与者获得的。与传统算法相比,IceNet 以更少的伪影提供了更令人满意的结果。请注意,LDR 和 SRIE 并未充分改善对比度,Li 等人。产生模糊的图像。其他传统算法往往会产生噪声或过度增强轮廓伪影。

精读

方法1

- 要求11名参与者对这两种交互方式进行注解,并投票选出更好的结果。

- IceNet占80.2%,而CB只占19.8%

方法2

- 从NPE、LIME、MEF、DICM等的每个测试集中选择前10张索引的图片,收集了50张图片。

- 然后,对11名参与者进行了另一项用户研究。

图6,7,8.IceNet与传统算法的定性比较。传统的增强方法在奇数行,而基于cnn的增强方法在偶数行。

2) User studies for personalized initial η——个性化初始η的用户研究

翻译

我们询问了 11 名参与者他们对最初增强图像的满意度。对于这个测试,方程中的系数。 (4) 由 (yi, ηi) 对进行个性化,这是每个参与者在之前的用户研究中选择的。然后,我们从 NPE、MEF、DICM 和 VV 中各选择 5 张低对比度图像,收集了 20 张新的测试图像。这些新图像与表 1 中用于测试的图像没有重叠。平均而言,每个用户对这 20 个案例中的 16.5 个初始图像感到满意。换句话说,82.5%的初始增强图像让用户满意。

此外,个性化初始 η 与微调后的平均绝对误差 (MAE) 仅 0.068。表2(a)显示了该测试的结果。这些结果证实最初增强的图像在大多数情况下是令人满意的。为了进行更主观的评估,我们要求 11 名参与者在最初增强的图像和 SRIE [26] 和 EnlightenGAN [39] 获得的自动增强图像之间选择首选图像。

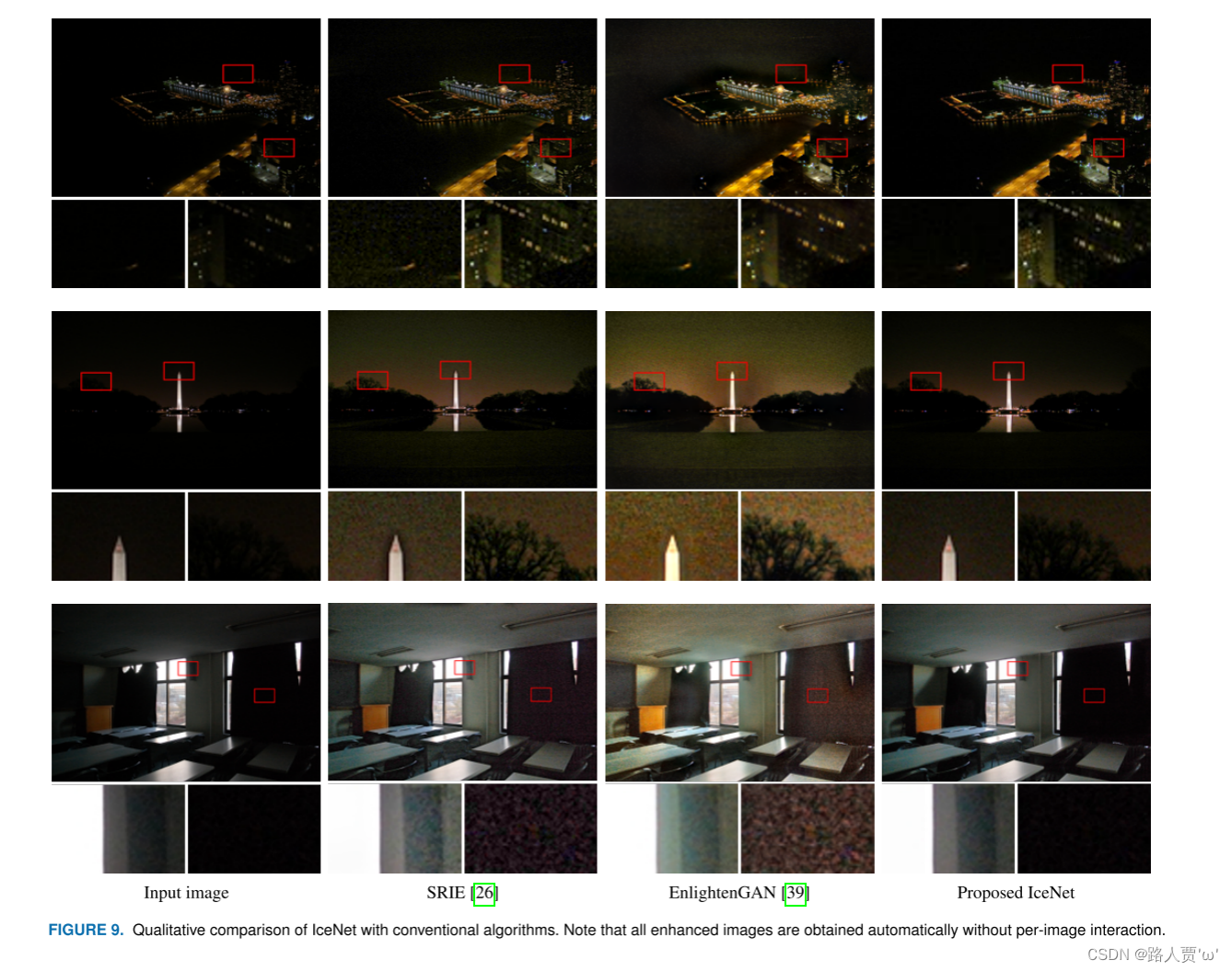

请注意,在之前的用户研究中,SRIE 和 EnlightenGAN 是传统方法中最受欢迎的两种算法。表 2(b) 总结了投票结果。所提出的算法赢得了最多的选票。图 9 比较了定性结果,其中 IceNet 的结果是使用参与者的个性化暴露水平获得的。所提出的 IceNet 提供了更令人满意的结果,而无需每个图像交互。

精读

方法

从NPE、MEF、DICM和VV各选取5张低对比度图像,收集20张新的测试图像。

3) Quantitative comparison—定量比较

翻译

表2(a)显示了该测试的结果。这些结果证实最初增强的图像在大多数情况下是令人满意的。为了进行更主观的评估,我们要求 11 名参与者在最初增强的图像和 SRIE [26] 和 EnlightenGAN [39] 获得的自动增强图像之间选择首选图像。

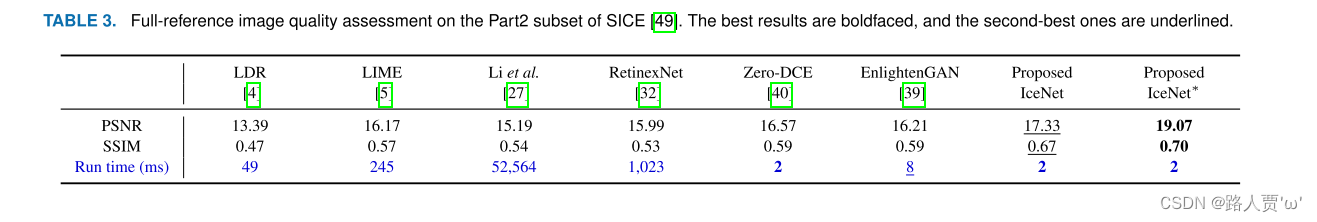

请注意,在之前的用户研究中,SRIE 和 EnlightenGAN 是传统方法中最受欢迎的两种算法。表 2(b) 总结了投票结果。所提出的算法赢得了最多的选票。图 9 比较了定性结果,其中 IceNet 的结果是使用参与者的个性化暴露水平获得的。所提出的 IceNet 提供了更令人满意的结果,而无需每个图像交互。IceNet* 测试过程中采样了 70 对 (yi, ηi)。在表3中,我们看到所提出的算法明显优于传统算法。此外,即使没有perimage交互,IceNet也能提供出色的性能。

精读

方法

在SICE数据集的Part2子集中使用了767对曝光不足和正常的图像。

B. ABLATIONAND ANALYSIS—消融和分析

翻译

1)对比度偏好

在图10中,奇数行显示了三个参与者如何在用户研究期间以不同方式增强相同的输入图像,偶数行显示参与者提供了各种注释以获得满意的图像。通过增强图像我们看到人们对对比度有不同的偏好。所提出的交互算法可用于自适应地满足这些偏好。

2)参数设置的影响

图11比较了所提出的IceNet与不同参数设置的结果。在这个测试中,我们改变了卷积层和输出通道的数量。请注意,所提出的 IceNet 的默认设置采用 7 个卷积层和 32 个输出通道。如图11所示,当参数量小于默认设置时,输出图像会过度增强。另一方面,当参数量大于默认设置时,输出图像与默认设置的图像相似。这表明默认设置既有效又高效。

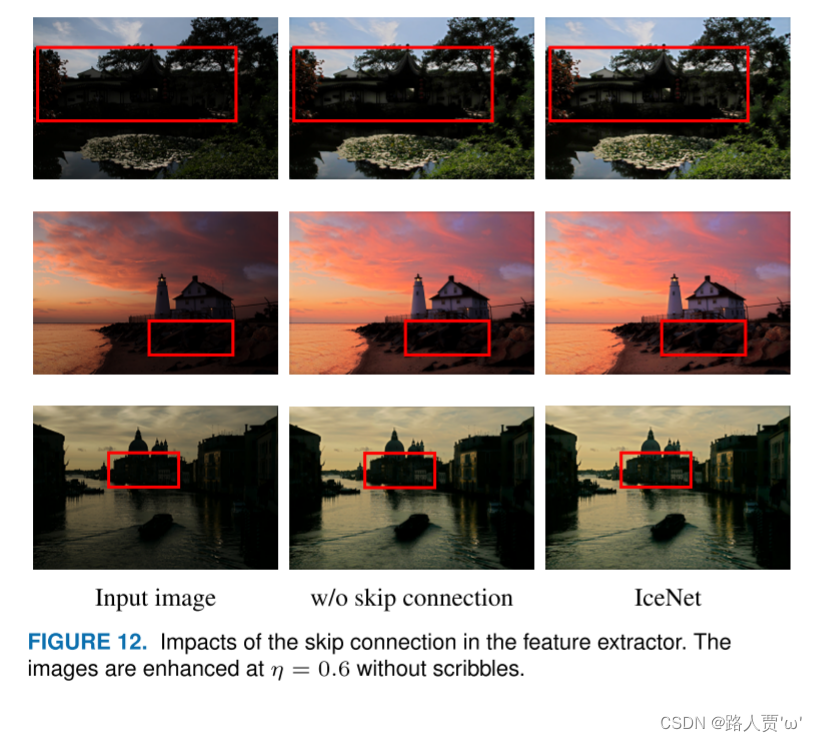

3) 跳跃连接

图 12 比较了使用和不使用跳跃连接的 IceNet 的结果。在此测试中,输出图像在 η = 0.6 时生成,没有涂鸦。据观察,没有跳跃连接的 IceNet 无法显示隐藏的细节。

4)损失函数

最后,我们分析式(1)中每个损失项的功效。 (15)。图 4(b)∼(e) 显示了使用三种损失的各种组合训练的 IceNet 的结果。在此测试中,IceNet 在 η = 0.65 时生成无涂鸦的输出图像。首先,我们在没有图 4(c) 中的交互式亮度控制损失 Libc 的情况下训练 IceNet。通过与图 4(b) 进行比较,我们发现删除 Libc 并不能增强曝光不足的区域。其次,我们在没有熵损失 Lent 的情况下训练 IceNet,如图 4(d) 所示。与图4(b)相比,直方图更加集中,这表明对比度没有得到充分改善。最后,图 4(e) 显示了没有平滑度损失 Lsmo 的 IceNet 训练结果。删除 Lsmo 会导致图像过度增强。

精读

1) Preferences for contrast— 对比度偏好

2) Impacts of parameter settings—参数设置的影响

3) Skip connection—跳跃连接

4) Loss function—损失函数

- 图4(b) ~ (e)显示了三种损失的各种组合训练IceNet的结果。

- 图4(c)与图4(b)的对比:去除Libc并不能增强暴露不足的区域。

- 图4(d)与图4(b)相比:直方图更加集中,说明对比度提高不够。

- 图4(e):移除Lsmo会导致图像过度增强。

V. CONCLUSIONS—结论

翻译

我们提出了用于交互式 CE 的 IceNet,它由多个卷积层和全连接层组成。 IceNet 使用户能够轻松调整图像对比度。具体来说,用户提供用于控制全局亮度的曝光级别和用于使局部区域变暗或变亮的涂鸦图。然后,IceNet 生成增强图像。用户可以迭代地提供注释,直到获得满意的图像。此外,IceNet还自动生成了个性化的增强图像,可以作为进一步调整的基础。此外,为了有效、可靠地训练 IceNet,我们开发了三个可微损失函数。对各种数据集的大量实验证明了 IceNet 出色的 CE 性能。尽管IceNet能够为用户提供满意的结果,但用户应该提供详细的涂鸦。未来,我们将设计一种更加人性化的交互式CE方法,使用户能够通过更简单的涂鸦更轻松地控制所需区域的局部亮度。

精读

本文提出了交互式CE的IceNet,它由多个卷积层和全连接层组成。

IceNet使用户可以轻松调整图像对比度。用户可以反复地提供注释,直到获得满意的图像。IceNet还自动生成了个性化的增强图像,可以作为进一步调整的基础。

此外,本文开发了三个可微损耗函数。

在未来,将设计一种更加友好的交互CE方法,使用户能够通过更简单的涂鸦更容易地控制想要区域的局部亮度。