依赖环境

1. jdk 1.8

2. scala 2.11

3. spark 2.2.0

idea创建Scala项目

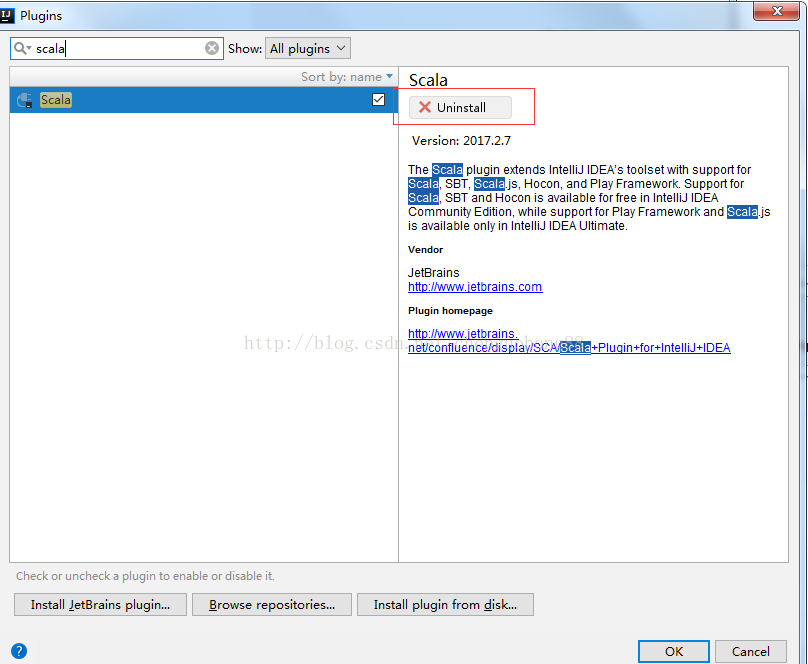

idea配置Scala环境

搜索Scala

点击右侧安装按钮,等待安装完成,然后点OK(此处因为我已经安装过了,所以显示卸载按钮)。

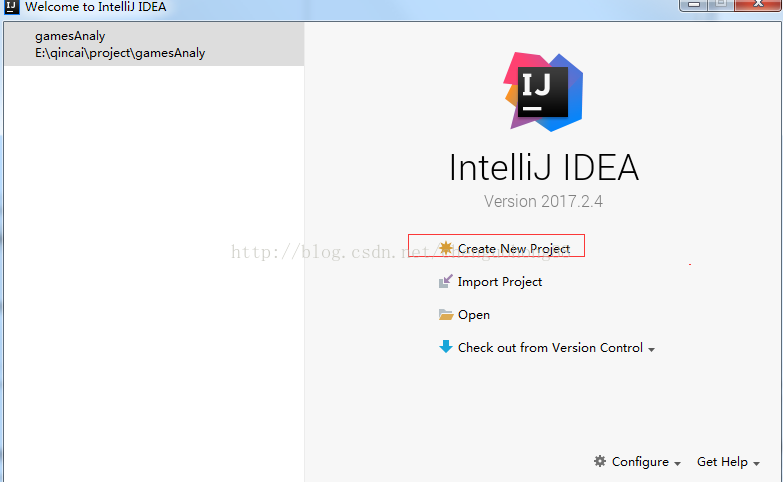

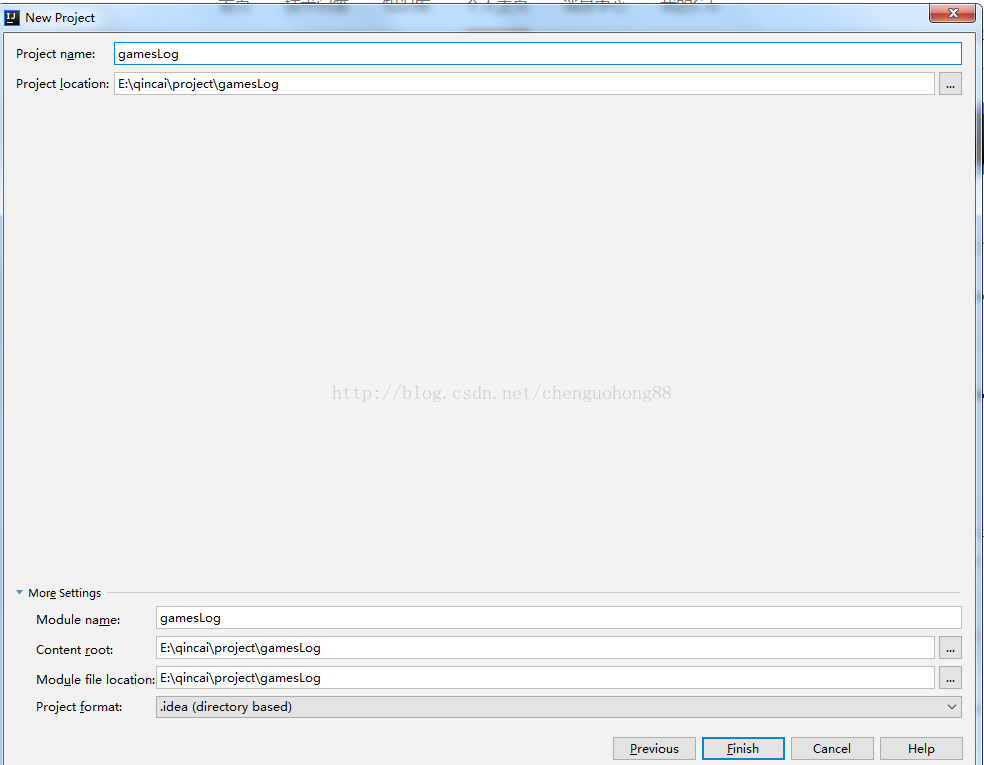

创建新项目

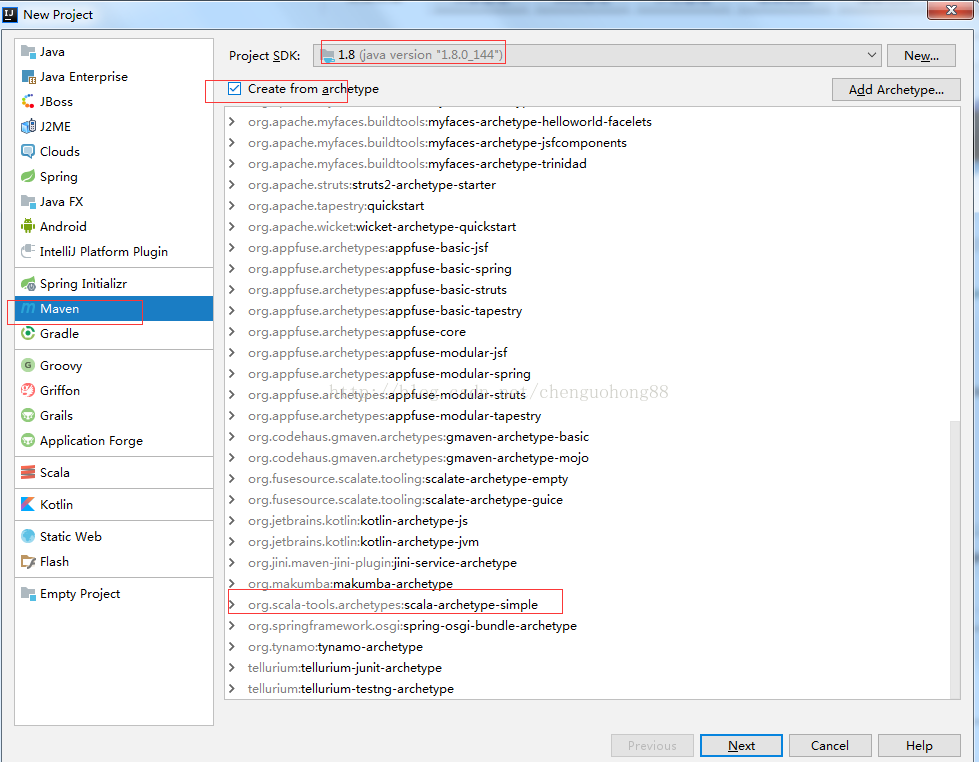

如下图操作, 然后下一步。

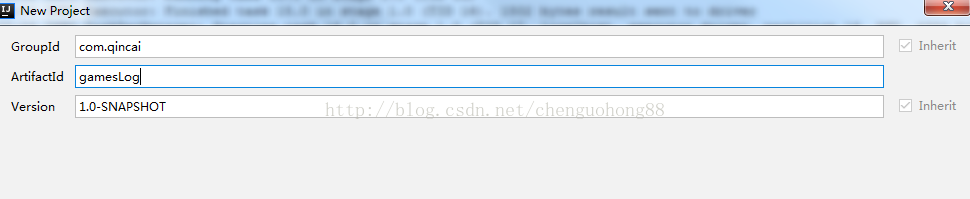

输入包名,项目名。下一步。

完成。

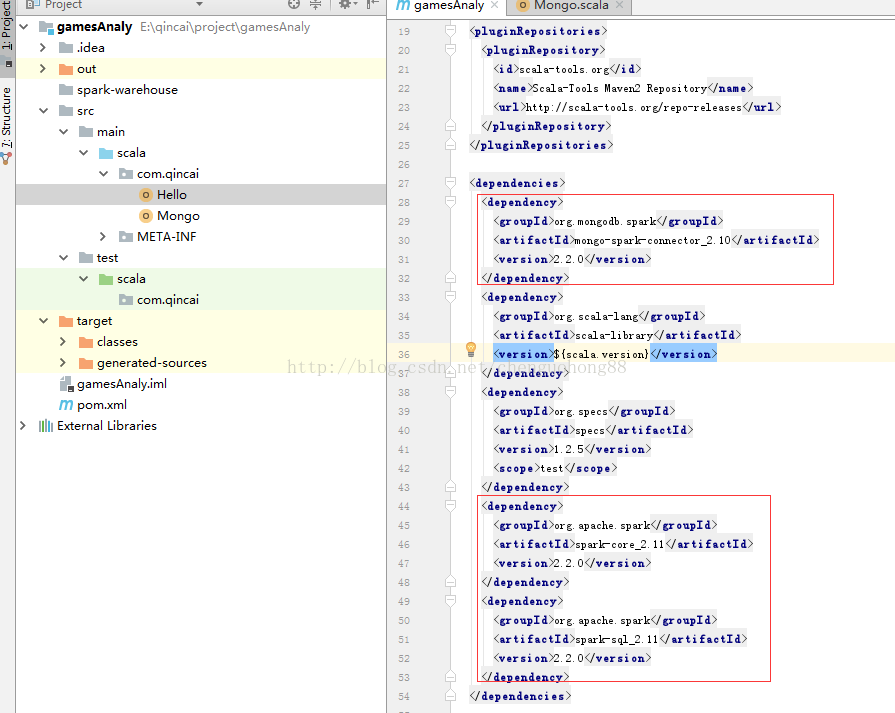

项目目录结构如下。编辑maven配置文件,配置spark依赖,mongo-spark依赖。

好了,开发环境到此搭建完成。

Scala编写spark应用

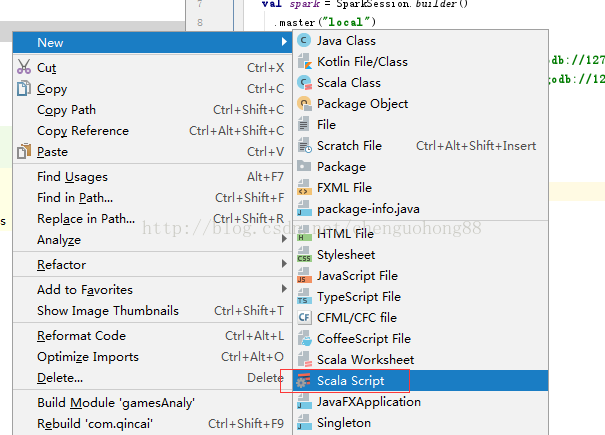

创建Scala文件。

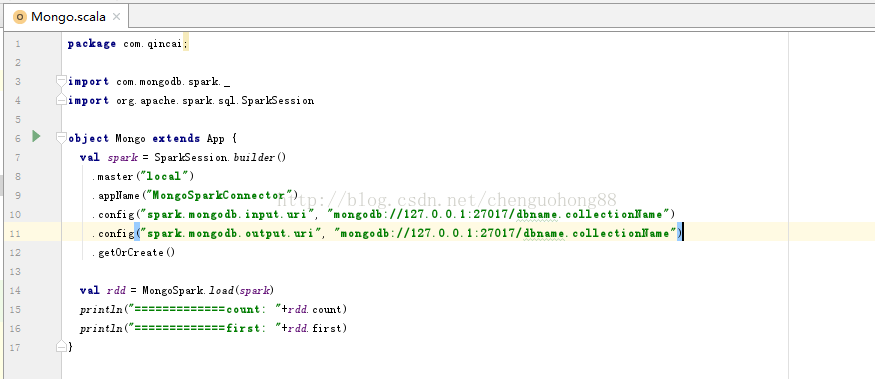

编写代码,从mongodb数据库中读取数据。

说明:

master: 集群管理器,spark://host:port, mesos://host:port, yarn, or local.

appName: 应用名。

spark.mongodb.input.uri: mongodb 输入地址。

spark.mongodb.output.uri: mongodb 输出地址。

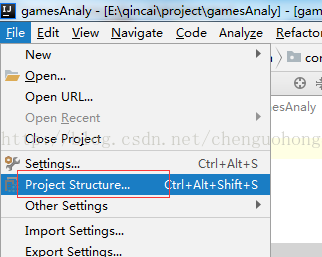

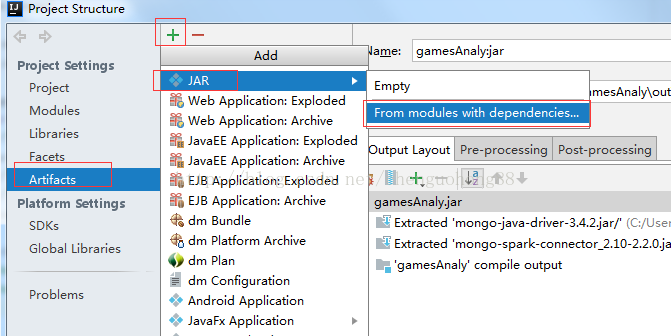

打包项目。

按下图操作:

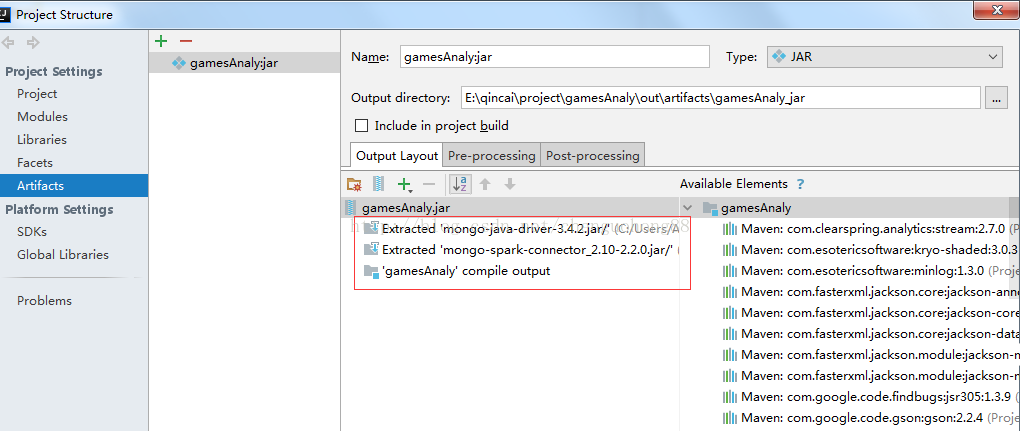

spark-submit是会自动包含依赖的包,因此只需要保留mongo-spark包和compile output,如下所示:

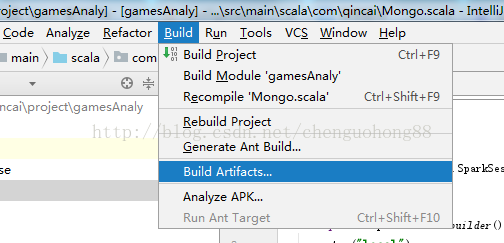

打包

提交spark应用

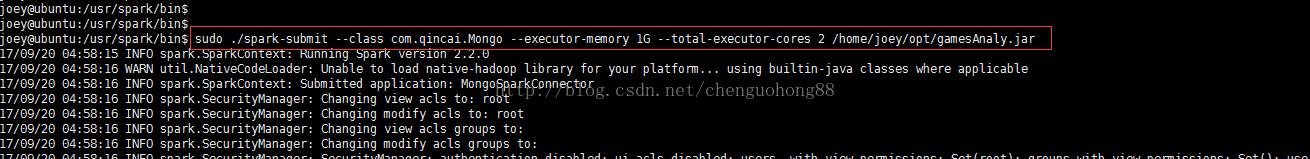

进入spark安装目录bin, 输入命令:

sudo ./spark-submit --class com.qincai.Mongo --executor-memory 1G --total-executor-cores 2 /home/joey/opt/gamesAnaly.jar

说明:

executor-memory: 执行器内存大小。

total-executor-cores: 执行器cup核心数。

class: spark应用主类。

jar: spark应用jar包。

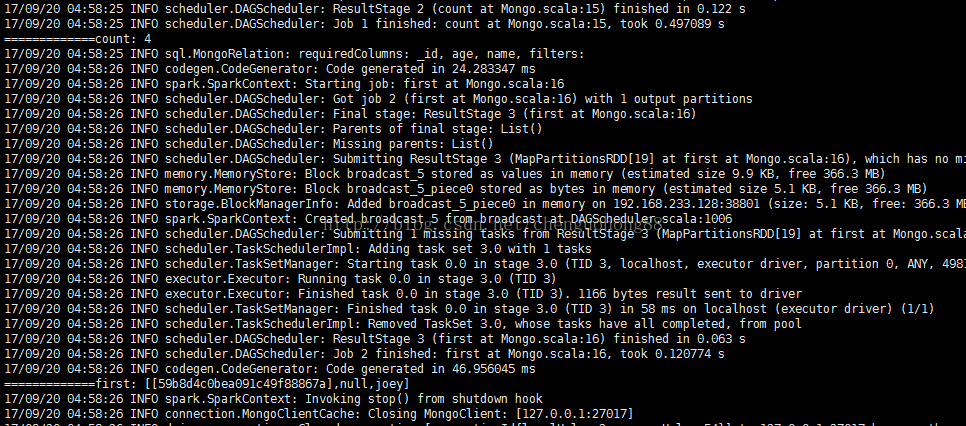

输出如下:

本文到此结束。本人将继续研究mongo-spark数据分析、读写和spark定时任务。