1.安装JDK

yum -y install java-1.8.0-openjdk*

2.在相应目录下安装hadoop

wget http://mirrors.tuna.tsinghua.edu.cn/apache/hadoop/common/hadoop-2.9.1/hadoop-2.9.1.tar.gz

解压并且配置HADOOPHOME

3.修改$HADOOPHOME/etc/hadoop/hadoop-env.sh

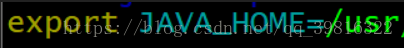

将JAVA_HOME改成对应的路径这里我使用yum下载的JDK所以这样配置就可以了。

改成对应的java_home路径

4. 修改hadoop中/etc/hadoop/core-site.xml文件。在configuration标签中添加如下代码:

(1)添加指定的默认文件系统名称的配置

<property>

<name>fs.defaultFS</name>

<value>hdfs://本地iP:9000</value>

</property>(2)添加指定中间数据文件存放目录的配置

<property>

<name>hadoop.tmp.dir</name>

<value>/home/a/tmp</value>

</property>- 修改hadoop中etc/hadoop/hdfs-site.xml。将默认的副本数3改成1。因为我们现在用的是伪分布式。在标签中添加如下代码:

<property>

<name>dfs.replication</name>

<value>1</value>

</property>- 格式化文件系统。执行hadoop中bin目录下的hdfs namenode –foramt指令即可。

- 启动。执行hadoop中的sbin目录中的start-dfs.sh。

启动。执行hadoop中的sbin目录中的start-dfs.sh。如果不出意外,会要你输入三次密码。完成后输入jps,看到如下进程,说明hdfs配置成功完成。

设置为无密码登录

首先切换到普通用户。然后执行ssh-keygen –t rsa(使用rsa加密,另外一种常用的是dsa)命令生成密钥。cd ~/.ssh 执行后会在用户目生成ssh目录和id_rsa、id_rsa.pub个文件。

将生成的公钥加入到许可文件中,即将公钥复制到 .ssh、authorized_keys中。这样登录就不需要再输入密码了。执行的命令。 cp id_rsa.pub authorized_keys。