关于梯度上升法和梯度下降法的原理,大多数都是纯理论的解释和公式的推导,没有一种直观的表达方式。

在这我分别举出两个简单而又直观的例子,大家就明白了,为什么梯度下降法是减梯度,而梯度上升法是加梯度。

对于梯度下降法来说,在神经网络中用到,最小化误差的一种优化方法。

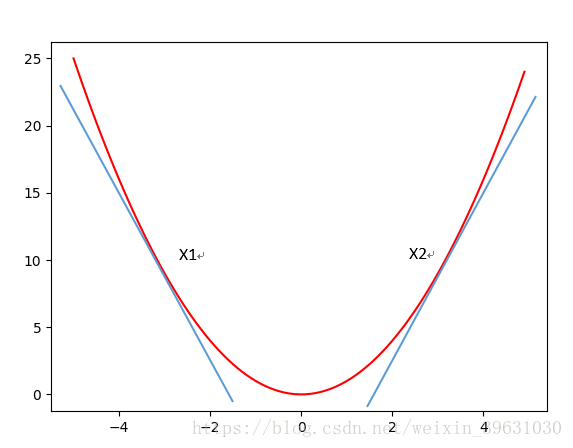

如用梯度下降法求

在x1,x2点分别可导,

在x1处导数为负数,在此函数中,(-∞,0)区间,对任意一点xi,导数都为负数;

在x2处导数为正数,在此函数中,(0,+∞)区间,对任意一点xi,导数都为正数;

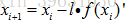

这样,在梯度下降中,公式

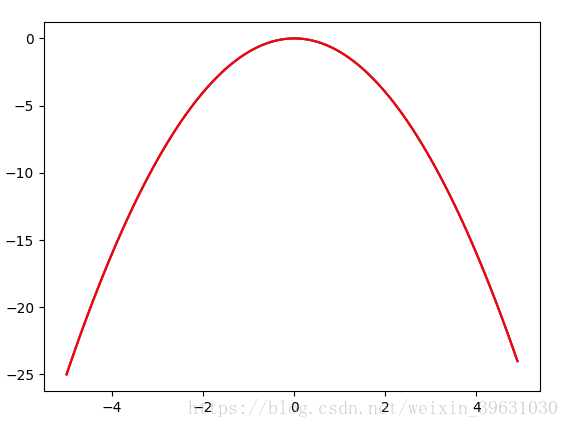

在梯度上升法是在逻辑回归中求概率最大值,即求最大似然函数的最大值用到的方法,

求

在此函数中,(-∞,0)区间,对任意一点xi,导数都为正数;

(0,+∞)区间,对任意一点xi,导数都为负数;

在梯度上升中,公式

反向推理,就能明白梯度上升为什么是加梯度,而梯度下降是减梯度。