版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/CSDN_fzs/article/details/78985586

Hadoop是大数据的核心武器,下面来介绍在Windows环境下Hadoop的安装和配置

1.下载Hadoop

2.解压

hadoop-2.7.3.tar.gz 点右键“解压到hadoop-2.7.3”

文件夹路径 xxx/xxxx/hadoop-2.7.3

复制hadoop-2.7.3文件夹到 d盘 或者 e盘 的根目录 (在这里我安装到了E盘)

3.原版的Hadoop不支持Windows系统,我们需要修改一些配置方便在Windows上运行

所需文件hadooponwindows-master.zip 解压

复制解压开的bin文件和etc文件到hadoop-2.7.3文件中,并替换原有的bin和etc文件

4.配置Hadoop的环境变量

配置Java环境变量

新建变量名:JAVA_HOME

输入路径:D:\Softwares\jdk1.8 (这里是以我的jdk地址为例,请根据自己的jdk地址来设置)

在path中最前面加上:%JAVA_HOME%\bin;

配置Hadoop环境变量

新建变量名:HADOOP_HOME

输入路径:E:\hadoop-2.7.3

在path中最前面加上:%HADOOP_HOME%\bin;

5.确认hadoop配置的jdk的路径

在hadoop-2.7.3\etc\hadoop找到hadoop-env.cmd

右键用一个文本编辑器打开

找到

set JAVA_HOME=C:\PROGRA~1\Java\jdk1.7.0_67

将C:\PROGRA~1\Java\jdk1.7.0_67 改为 D:\Softwares\jdk1.8(在环境变量设置中JAVA_HOME的值)

(如果路径中有“Program Files”,则将Program Files改为 PROGRA~1

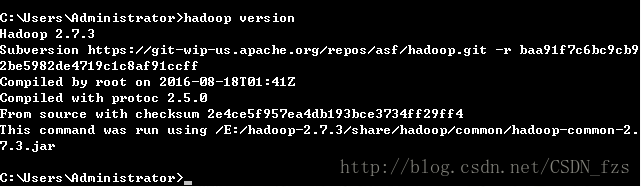

6.配置好上面所有操作后,win+R 输入cmd打开命令提示符,然后输入hadoop version,按回车,如果出现如图所示结果,则说明安装成功

7.hadoop核心配置文件

在hadoop-2.7.3\etc\hadoop中找到以下几个文件

打开

hadoop-2.7.3/etc/hadoop/core-site.xml

,

复制下面内容粘贴到最后并保存

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

打开

hadoop-2.7.3/etc/hadoop/mapred-site.xml

,

复制下面内容粘贴到最后并保存

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

打开

hadoop-2.7.3/etc/hadoop/hdfs-site.xml

,

复制下面内容粘贴到最后并保存

,

请注意需要建立

data

文件夹和两个子文件夹,本例子是建立在

HADOOP_HOME

的目录里

(注意每个人的hadoop的路径不一样,这里要做修改)

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>

/E:/hadoop-2.7.3/namenode

</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>

/E:/hadoop-2.7.3/datanode

</value>

</property>

</configuration>

打开

hadoop-2.7.3/etc/hadoop/yarn-site.xml

,

复制下面内容粘贴到最后并保存

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name>

<value>org.apache.hadoop.mapred.ShuffleHandler</value>

</property>

</configuration>

8.启动Hadoop服务

创建三个文件夹

E:/hadoop-2.7.3/tmp

E:/hadoop-2.7.3/namenode

E:/hadoop-2.7.3/datanode

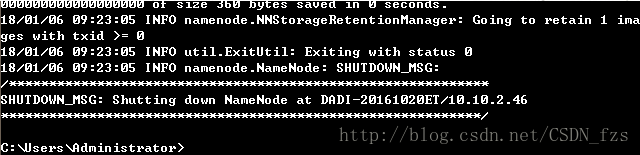

格式化 HDFS

以管理员身份打开命令提示符

输入hdfs namenode -format

执行到如下图所示

格式化之后,namenode文件里会自动生成一个current文件,则格式化成功。

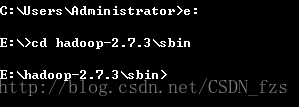

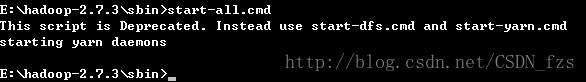

然后转到Hadoop-2.7.3\sbin文件下

输入start-all.cmd,启动hadoop服务

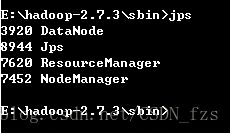

输入

JPS –

可以查看运行的所有服务

(

前提是

java

路径设置正确

)