在衡量模型性能好坏时,我们经常用到精确度、召回率和F1评分。再此做记录,写下自己的理解,以防遗忘。如有错误,欢迎指正。

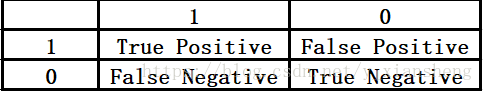

如上表格所示,模型的最终预测结果可分为上述四类情况,假设我们现在是要预测队伍里的男生女生人数,男生为正例,女生为负例,则:

1、True Positive:正确的正例,即男生被正确分为男生

2、False Positive:错误的正例,即女生被错误分为男生

3、False Negative:错误的负例,即男生被错误分为女生

4、True Negative:正确的负例,即女生被正确分为女生

我们可以这样记忆,前面为True的就代表分类正确,False的就代表分类错误;后边是Positive的就是正例,后边是Negative的就是负例。

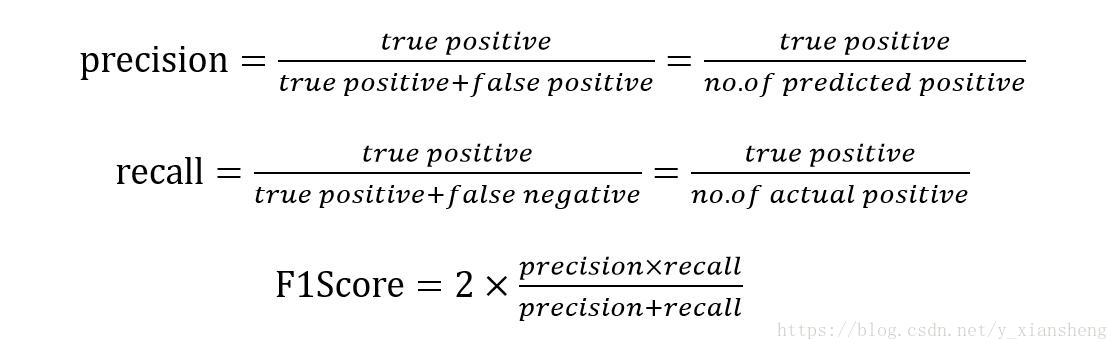

下面是精确度(Precision)、召回率(Recall)和F1_Score的公式:

由此我们可以得到以下规律:

假设模型分类取得了正例和负例的分类结果,那么Precision就是模型所得分类结果中,真正的正例与分类所得正例的比值,也可叫作查准率;Recall就是模型所得分类结果中,真正的正例与数据中实际真正正例的比值,也可叫做查全率;

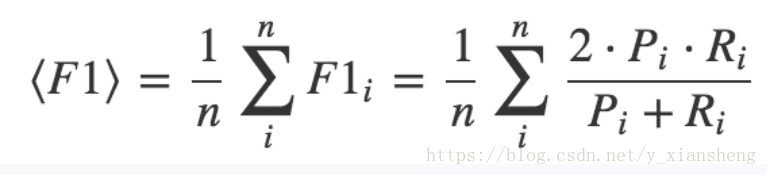

在对模型进行评估的过程中,仅用精确度或者召回率去评估模型是无法全面评估模型优劣的,所以人们将精确度和召回率结合起来,得到了F1评分作为模型的实际评分准则,在多分类问题中,F1是精确度和召回率的调和平均:

最后提一下所谓的准确率(Accuracy),准确率就是分类任务中全部分类正确(不论正例负例)的总数与全体总数的比值,Accuracy = (TP + TN )/( TP + FP + TN + FN)。