毕业论文方向可能和神经网络挂钩,神经网络也是机器学习的一部分。从这周开始决定跟着Andrew Ng公开课系统地学习机器学习,4/4日开课,第一周为试听,今天先看了。以后每周更新一下。的确感觉讲的不错,形式平易近人。

//分割线----------------------------------------------------------------------------------------------

机器学习概念:

the field of study thatgives computers the ability to learn without being explicitly programmed

监督学习

Supervised Learning:

Right answers given(训练集)

回归:Regression (continuous 预测输出无限集)

分类:Classification (discrete 预测输出有限集)

无监督学习

Unsupervised Learning:

只给出数据集——need to be cluster and discovered

单变量线性回归

预测房价的例子,肿瘤的例子。

一些常用符号约定

h(x) = theta0 + theta1*x

线性回归:linear regression

代价函数:Cost Function

以单变量线性回归为例,让代价函数最小化,即minimized每个点的误差平方和,再取平均再乘二分之一(只是为了数学上方便)。——squared error function 平方误差代价函数,最常用。

结合图形理解参数对代价函数取值的理解,如线性回归两个参数,代价函数为三维图像(相当于两个字自变量,一个因变量,比如碗形)。 为方便,轮廓图描述(像等高线)。

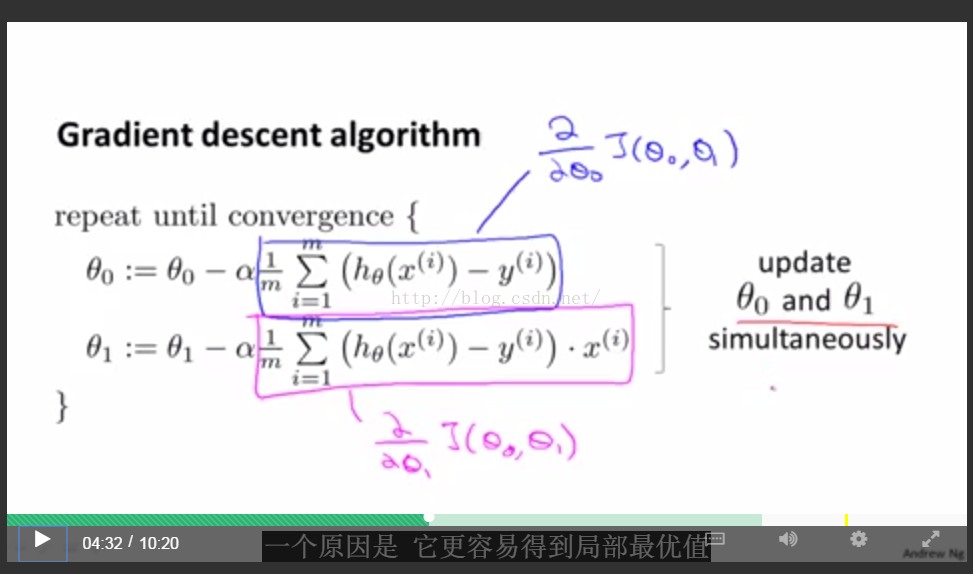

梯度下降法:Gradient descent最小化代价函数

公式如上。算法很常用,不仅在线性回归上,

注意一点就是多参数必须做到同时更新(非常适合并行)。如果非同时更新,可能结果也对所以不会注意到,但是会有微小的不同。

如果学习率太小,下降的慢,迭代次数多。

如果太大,可能无法收敛甚至发散(一步太大)。

容易达到局部最低点(和初始值有关),此时导数为0,会停止下降。当接近最低点时,步长会自动变小,因此没有必要减少学习率,固定即可。

梯度下降法结合线性回归:把求导式子结合代价函数展开

由于线性回归的代价函数都是凸函数(碗形),因此用梯度下降法都能得到全局最优。

批量梯度下降:batch 需要对所有样本的误差求和然后平均。