已正确安装jdk环境

JDK测试安装成功:

>java -version

解压Hadoop,建议解压目录:/usr/local下

免密登陆设置(如果不加免密操作,每次启动和关闭会有多次输入密码过程):

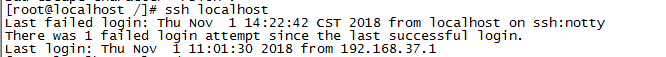

>ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsa

>cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys

>ssh localhost

//修改主机名

>vim /etc/hostname

Master

//修改host

>vim /etc/host

加入虚拟机ip

创建三个文件夹

>mkdir /usr/local/hadoop/tmp

>mkdir -p /usr/local/hadoop/hdfs/name

>mkdir -p /usr/local/hadoop/hdfs/data

配置Hadoop环境变量

>vim ~/.bash_profile

HADOOP_HOME=/hadoop解压路径

PATH=$PATH:$HADOOP_HOME/bin

>source ~/.bash_profile

进入到Hadoop解压路径进行配置参数修改

1.配置hadoop-env.sh //此处要注意是否存在多个文件情况

>vim hadoop-env.sh

export JAVA_HOME=JDK路径

2.配置yarn_env.sh

>vim yarn_env.sh

export JAVA_HOME=jdk路径

3.配置核心配置文件:core-site.xml

>vim core-site.xml

<property>

<name>fs.defaultFS</name>

<value>hdfs://Master:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>tem文件夹路径</value>

</property>

4.配置底层存储:hdfs-site.xml

>vim hdfs-site.xml

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/hdfs/name文件夹绝对路径</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/hdfs/data文件夹绝对路径</value>

</property>

//副本个数

<property>

<name>dfs.replication</name>

<value>1</value> //默认是3,伪分布式设置1即可

</property>

5.mapred中配置yarn框架(确认文件格式)

>mv mapred-site.xml.template mapred-size.xml

>vim mapred-site.xml

<property>

<name>mapreduce.framwork.name</name>

<value>yarn</value>

</property>

6.yarn配置mapred框架shuffle

>vim yarn-site.xml

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

进行格式化(如果修改配置文件则需要重新格式化)

>hadoop namenode -format

启动hadoop

>cd sbin

>./start-all.sh

查看进程

>jps

访问:

ip:8088

查看防火墙:

>firewall -cmd --state

关闭防火墙:

>stop firewalld.service