版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/a909301740/article/details/84112599

搭建 Hadoop 的环境

-

安装 JDK,关闭防火墙。

JKD 的安装请自行百度。

查看防火墙状态:

systemctl status firewalld.service关闭防火墙:

systemctl stop firewalld.service(如果重启,则会重启防火墙)禁用防火墙:

systemctl disable firewalld.service(永久关闭防火墙) -

使用 WinSCP 上传 hadoop-2.7.3.tar.gz 到 Linux。

-

解压 hadoop-2.7.3.tar.gz 到指定目录(这里以

/root/training目录为例)。解压命令:

tar -zxvf hadoop-2.7.3.tar.gz -C ~/training/ -

将 Hadoop 的 bin 目录和 sbin 目录添加到环境变量。

vi ~/.bash_profile文件中追加的内容如下:

HADOOP_HOME=/root/training/hadoop-2.7.3 export HADOOP_HOME PATH=$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH export PATH -

让环境变量生效。

source ~/.bash_profile

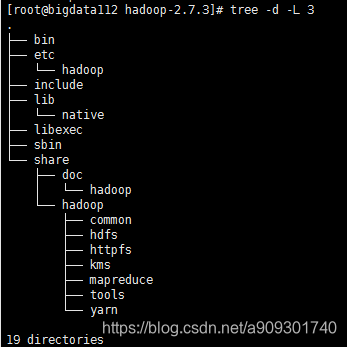

Hadoop 的目录结构

-

bin 目录下存储的是可执行文件。

-

etc 目录下存储的是 hadoop 所有的配置文件。

-

include,lib,libexec 目录下存储的是本地库,暂时用不到。

-

sbin 目录下存储的 hadoop 的集群命令,比如:启动,停止。

-

share/doc 目录下存储的是 hadoop 的官方文档。

-

share/hadoop 目录下存储的是 hadoop 所有的依赖 jar 包。