作者:jliang

1.重点归纳

1)支持向量机(SVM)是一种二分类模型

(1)它的基本模型定义在特征空间上的间隔最大化的线性分类器,间隔最大使它有别于感知机(感知机的损失函数只判断是否正确分类)。

(2)SVM还包含核技巧,使它称为实质上的非线性分类器。

(3)学习策略:间隔最大化,最终可转化为一个凸二次规划问题进行求解。

2)分类

- 硬间隔支持向量机:数据是线性可分

- 软间隔支持向量机:数据近似线性可分

- 非线性支持向量机:数据线性不可分,使用核技巧及软间隔最大化

3)核函数表示将输入从输入空间映射到特征空间得到特征向量之间的内积。通过使用核函数可以学习非线性支持向量机。

4)线性支持向量机原始问题目标函数

目标函数:![]()

约束条件:![]()

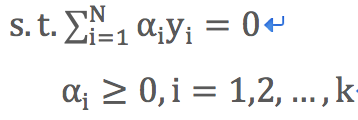

5)线性支持向量机使用拉格朗日对偶转换的目标函数

目标函数:![]()

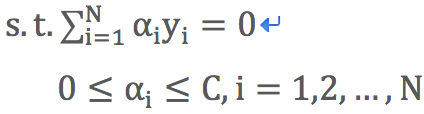

约束条件:

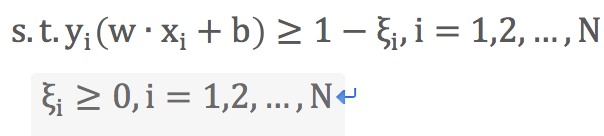

6)软间隔线性支持向量机原始目标函数

目标函数:![]()

约束条件:

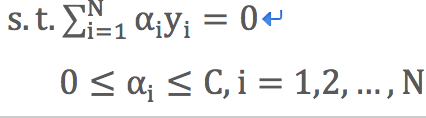

7)软间隔线性支持向量机使用拉格朗日对偶转换的目标函数

目标函数:![]()

约束条件:

8)软间隔线性支持向量机合页损失函数

![]()

取正值函数:![]()

9)非线性支持向量机损失函数

目标函数:![]()

约束条件:

10)决策函数

![]()

线性支持向量机时![]()

2.线性可分支持向量机与硬间隔最大化

1)当训练数据集线性可分时,存在无穷个分离超平面可将两类数据正确分开。

(1)感知机利用误分类最小的策略求得分离超平面,此时有无穷多个解。

(2)SVM利用间隔最大化求得最优分离超平面,这是的解是唯一的。

(3)分类超平面:w*∙x+b*=0

(4)分类决策函数:![]()

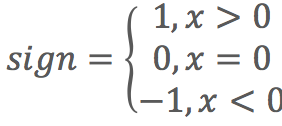

符号函数:

2)函数间隔:![]()

(1)![]() 表示点x距离超平面的远近,可以表示分类预测的确信程度;

表示点x距离超平面的远近,可以表示分类预测的确信程度;![]() 与类标y符号是否一致能够表达分类是否正确。所以

与类标y符号是否一致能够表达分类是否正确。所以![]() 表示分类的正确性及确信度。

表示分类的正确性及确信度。

(2)当成倍地改变w和b值时(例如改为2w和2b),超平面没有变化,但是函数间隔却也成倍地改变了(上面例子变为2倍)。

3)几何间隔:![]()

(1)在函数间隔的基础上,对分离超平面的法向量w加约束,规范化w=1使得间隔不变化。

(2)w为w的L2范数。

(3)函数间隔与几何间隔的关系:![]()

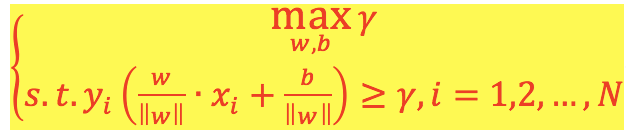

4)线性可分支持向量机目标函数:

(1)最大化几何间隔γ,约束条件为超平面(w,b)对每个训练样本点的几何间隔至少为γ。

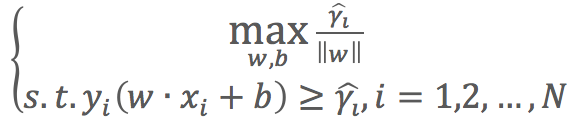

(2)使用![]() 代入函数得:

代入函数得: ,

,![]() 的取值并不影响最优化问题的解。

的取值并不影响最优化问题的解。

(3)最大化![]() 和最小化

和最小化![]() 是等价的,

是等价的,![]() 是凸函数,可以求最小值。

是凸函数,可以求最小值。

(4)简化后的目标函数(原始目标函数):

目标函数:![]()

约束条件:![]()

(5)求解目标函数可得分离超平面w*∙x+b*=0和分类决策函数w*∙x+b*=0

5)凸二次规划问题

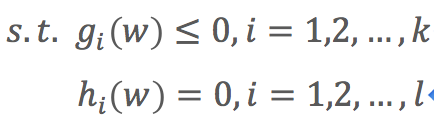

(1)凸优化问题:是指约束最优化问题

目标函数:![]()

约束条件:

(2)目标函数f(w)和约束函数![]() 都是

都是![]() 上的连续可微的凸函数,约束函数

上的连续可微的凸函数,约束函数![]() 是

是![]() 上的仿射函数。

上的仿射函数。

(3)当目标函数f(w)是二次函数且约束函数![]() 是仿射函数时,上述凸最优化问题成为凸二次规划问题。

是仿射函数时,上述凸最优化问题成为凸二次规划问题。

6)支持向量和间隔边界

(1)训练样本中与分离超平面距离最近的样本点称为支持向量,支持向量使公式![]() 成立。

成立。

(2)由正负样本支持向量组成的距离称为间隔,间隔的两个边界称为间隔边界,即:

(3)只有支持向量了对决定分离超平面起作用,其他实例点不起作用。支持向量的个数一般很少,所以SVM由很少的“重要”训练样本确定。

7)对偶算法

(1)通过拉格朗日对偶性变换到对偶变量的优化问题,即通过求解与原问题等价的对偶问题得到原始问题的最优解,这就是线性可分条件下支持向量机的对偶算法。

(2)优点

- 对偶问题往往更容易求解

- 可以自然引入核函数,进而推广到非线性分类问题

(3)拉格朗日对偶性求解过程

目标函数:![]()

约束条件: