逻辑回归( Logistic regression)

http://www.mamicode.com/info-detail-501714.html

https://baike.baidu.com/item/logistic%E5%9B%9E%E5%BD%92/2981575

http://blog.csdn.net/han_xiaoyang/article/details/49123419

http://blog.csdn.net/u010692239/article/details/52345754

一、介绍

Logistic回归:分类问题的首选算法。

回归与分类的区别:回归所预测的目标量的取值是连续的(例如房屋的价格);而分类所预测的目标变量的取值是离散的(例如判断邮件是否为垃圾邮件)。

为便于理解,从二值分类(Binary Classification)开始,在此分类问题中,Y只能取0或1。例如:我们要制作一个垃圾邮件过滤系统,如果一封邮件是垃圾邮件,Y=1,否则Y=0。给定样本集,它们的特征Xi和标签Yj都已知,训练一个分类器将它们分开。

Logistic回归的因变量可以是二分类的,也可以是多分类的,但是二分类的更为常用,也更加容易解释,多类可以使用Softmax方法进行处理。实际中最为常用的就是二分类的Logistic回归。

二、核心思想

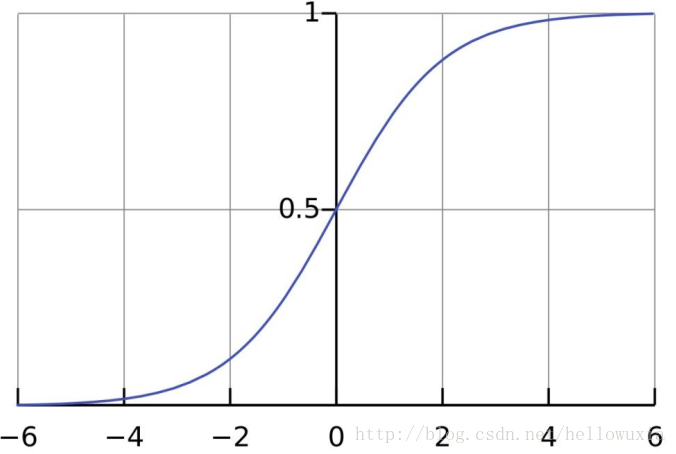

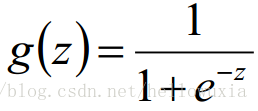

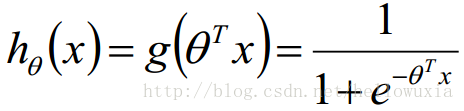

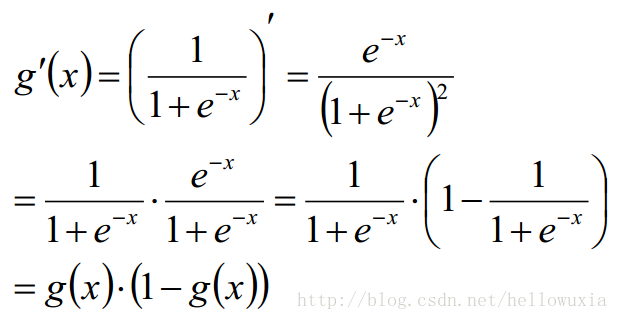

核心思想:线性回归的结果输出是一个连续值,值的范围无法限定,有没有办法把这个结果值映射为可以帮助我们决策的结果? 如果输出结果是 (0,1) 的一个概率值,这个问题就清楚了。在数学上找了一圈,找着这样一个简单的函数,Logistic|Sigmoid函数(S型函数):

Logistic Regression是一个被logistic方程归一化后的线性回归。

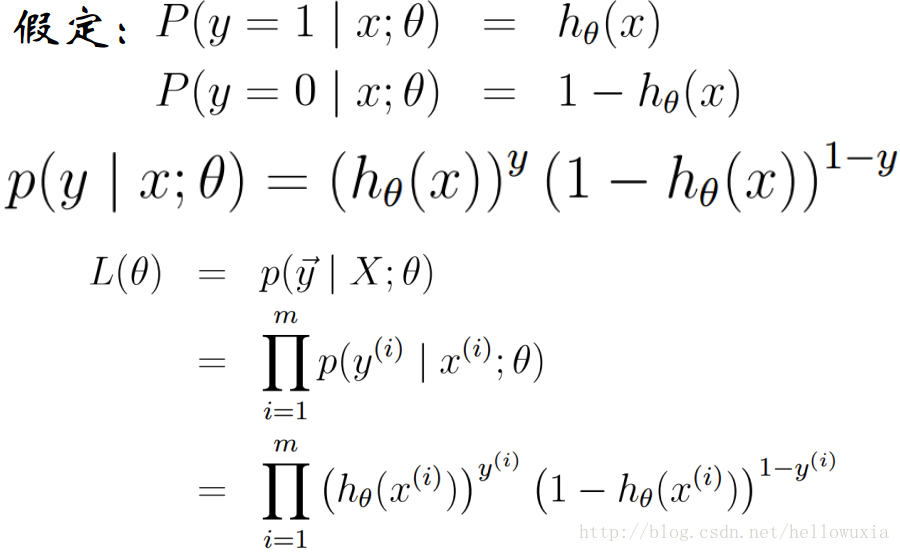

三、Logistic回归参数估计

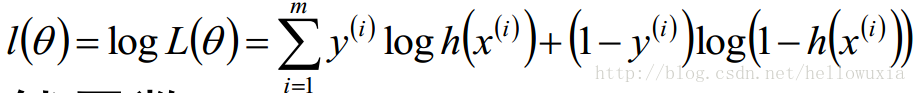

对数似然函数:

然后令该导数为0,会很失望的发现,它无法解析求解,参数迭代求解。

四、参数的迭代

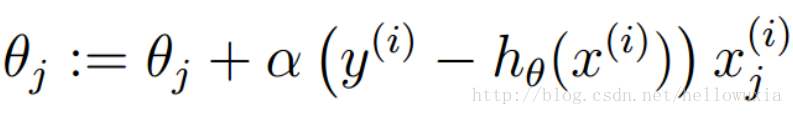

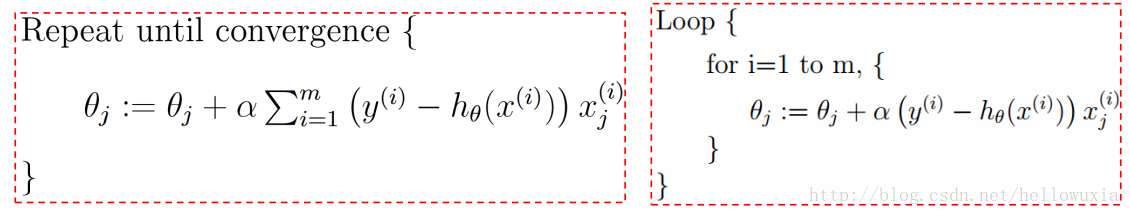

Logistic回归参数的学习规则(梯度下降):

对比其与线性回归结果,具有相同的形式:

五、对数线性模型

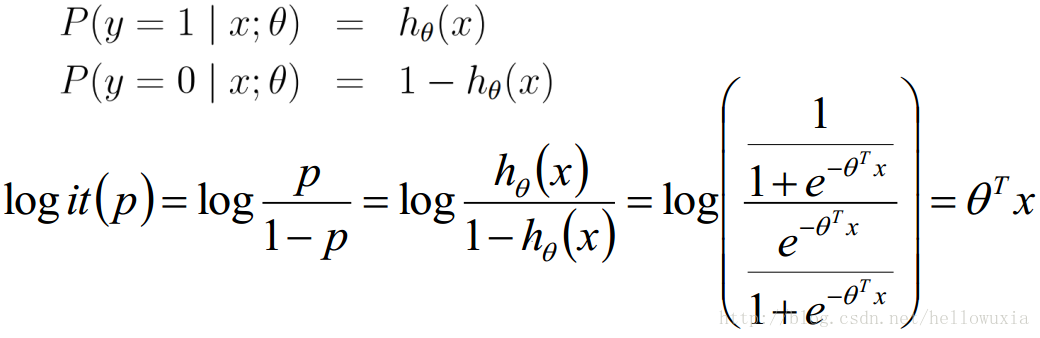

一个事件的几率odds,是指该事件发生的概率与该事件不发生的概率的比值。

Logistic回归实质:发生概率除以没有发生概率再取对数。

对数几率:Logit函数

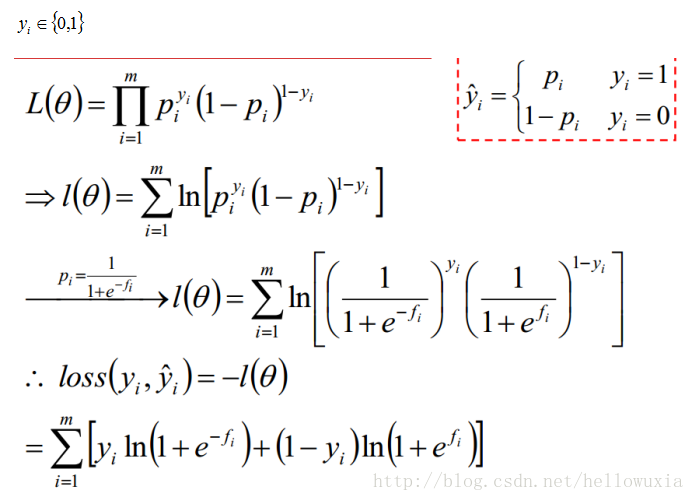

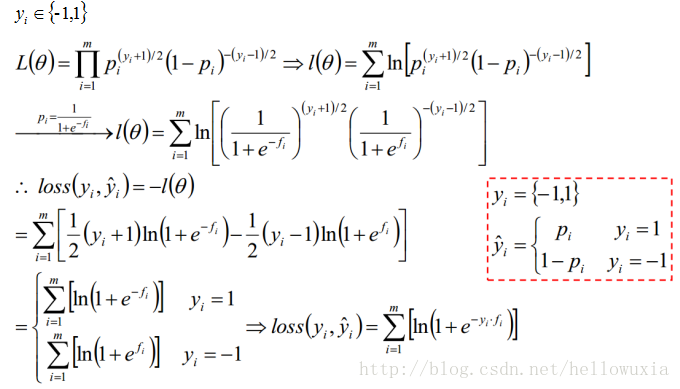

六、Logistic回归的损失函数

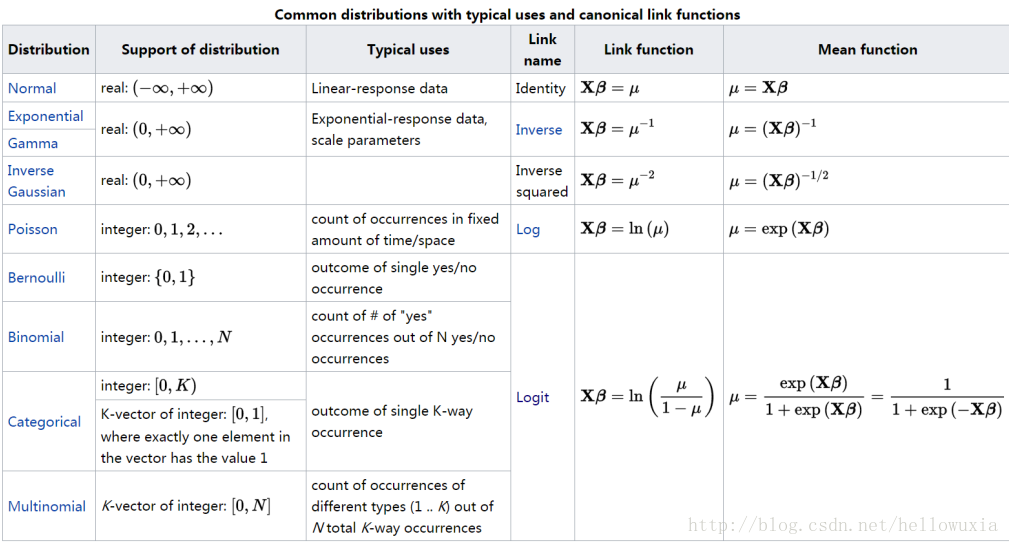

七、广义线性模型(Generalized Linear Model)

Y不再只是正态分布,而是扩大为指数族中的任一分布;

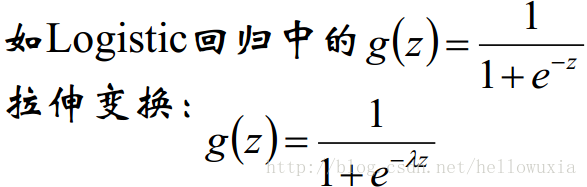

变量x→g(x)→y,连接函数g

连接函数g单调可导:

八、广义线性模型

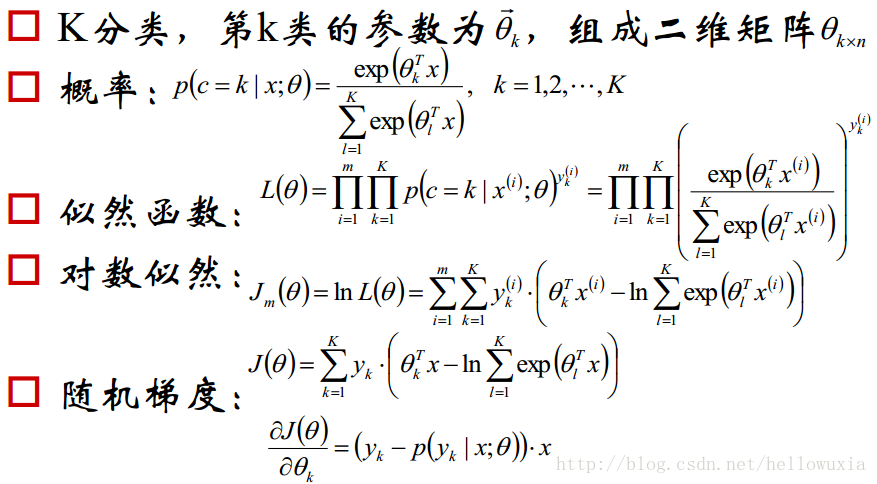

九、Softmax回归

十、Logistic回归模型的适用条件

因变量为二分类的分类变量或某事件的发生率,并且是数值型变量。但是需要注意,重复计数现象指标不适用于Logistic回归;

残差和因变量都要服从二项分布。二项分布对应的是分类变量,所以不是正态分布,进而不是用最小二乘法,而是最大似然法来解决方程估计和检验问题;

自变量和Logistic概率是线性关系;

各观测对象间相互独立。