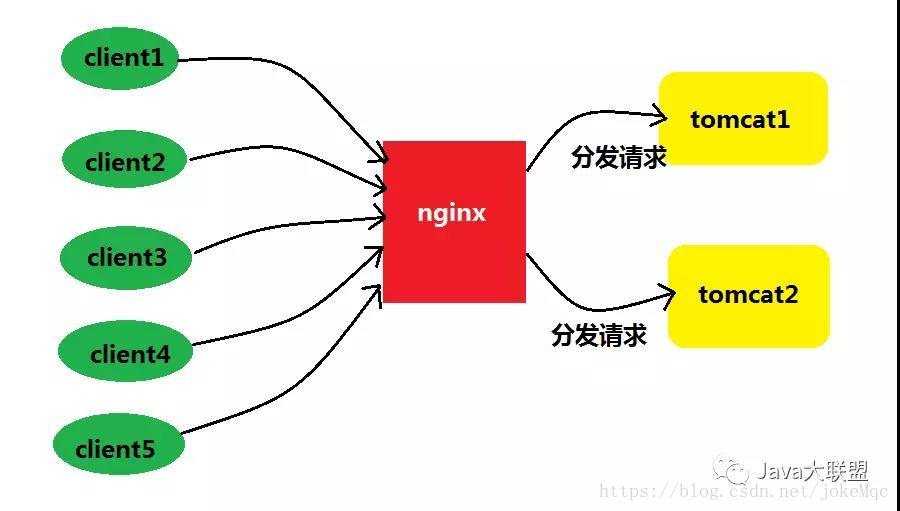

一、什么是tomcat集群?

利用nginx对请求进行分流,将请求分配给不同的tomcat去处理,减少每个tomcat的负载量,提高服务器的响应速度。

二、目标

实现高性能负载均衡的tomcat集群。

三、工具

1.nginx-1.13.10

2.apache-tomcat-7.0.81

四、实现步骤

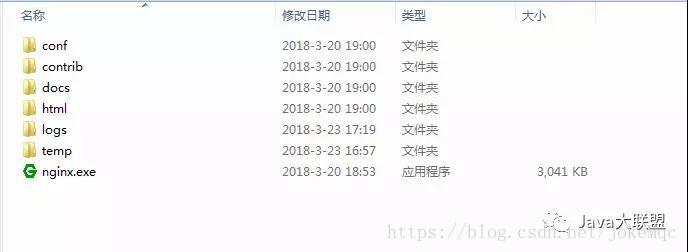

1、下载nginx,目录如下。

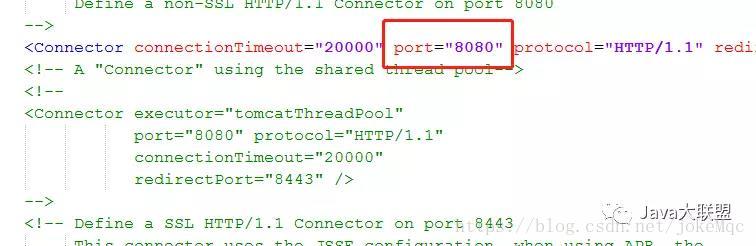

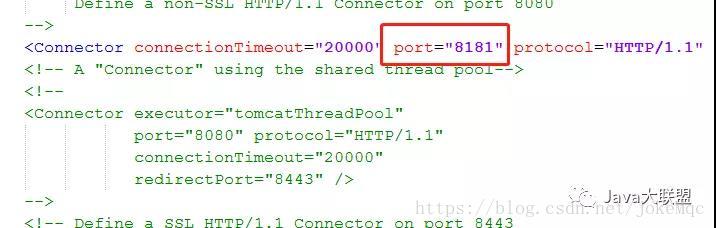

2、解压两个tomcat,分别命名为apache-tomcat-7.0.81-1和apache-tomcat-7.0.81-2。

3、修改两个tomcat的启动端口,分别为8080和8181。

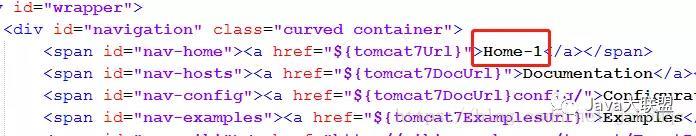

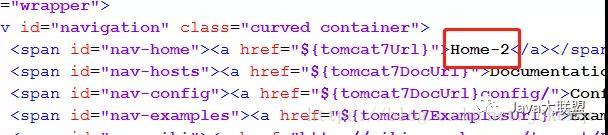

4.修改两个tomcat默认的index.jsp页面,用以区分不同的tomcat。

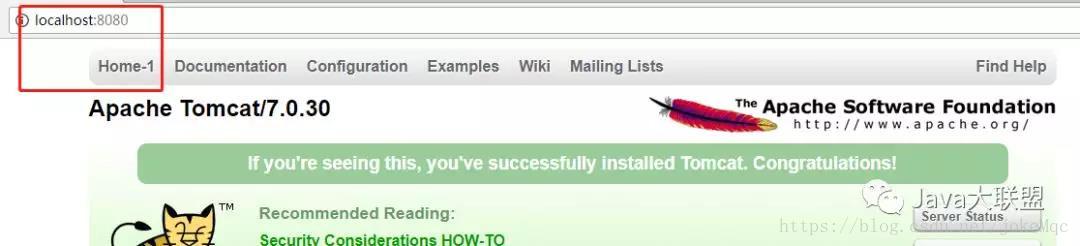

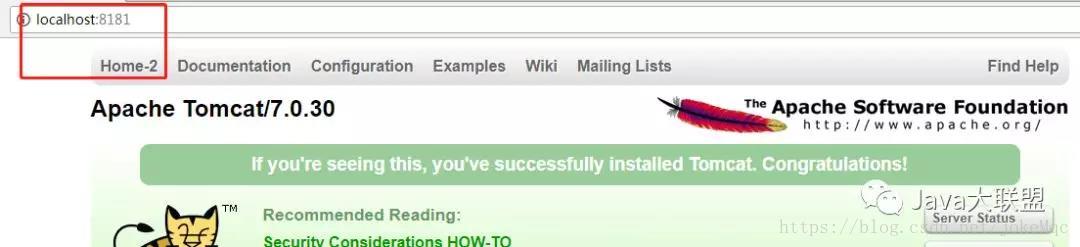

4.同时启动两个tomcat,访问测试。

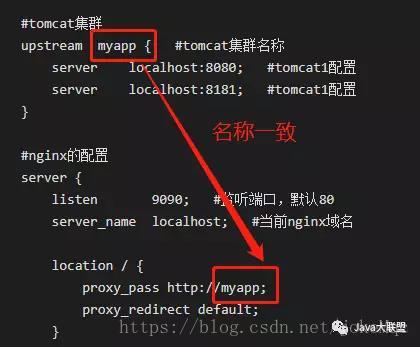

5.配置nginx,打开nginx-1.13.10/conf/nginx.conf。

进行如下配置:

worker_processes 1; #工作进程的个数,一般与计算机的cpu核数一致

events {

worker_connections 1024; #单个进程最大连接数(最大连接数=连接数*进程数)

}

http {

include mime.types; #文件扩展名与文件类型映射表

default_type application/octet-stream; #默认文件类型

sendfile on; #开启高效文件传输模式,普通应用设为 on,如果用来进行下载等应用磁盘IO重负载应用,可设置为off。

keepalive_timeout 65; #长连接超时时间,单位是秒

gzip on; #启用Gizp压缩

#tomcat集群

upstream myapp { #tomcat集群名称

server localhost:8080; #tomcat1配置

server localhost:8181; #tomcat2配置

}

#nginx的配置

server {

listen 9090; #监听端口,默认80

server_name localhost; #当前nginx域名

location / {

proxy_pass http://myapp;

proxy_redirect default;

}

error_page 500 502 503 504 /50x.html;

location = /50x.html {

root html;

}

}

}

核心配置:

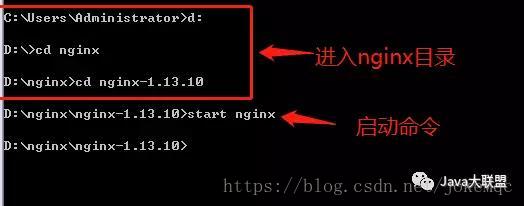

6.dos命令启动nginx。

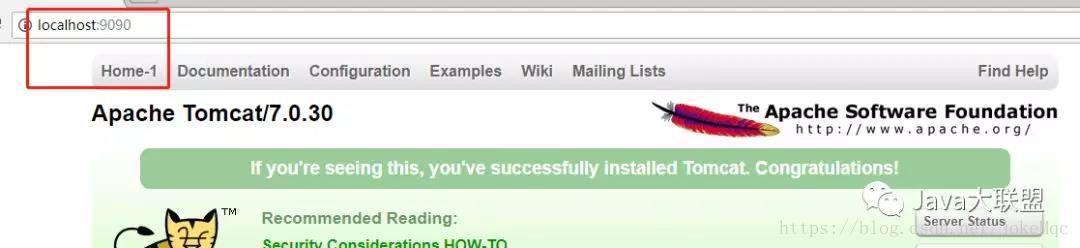

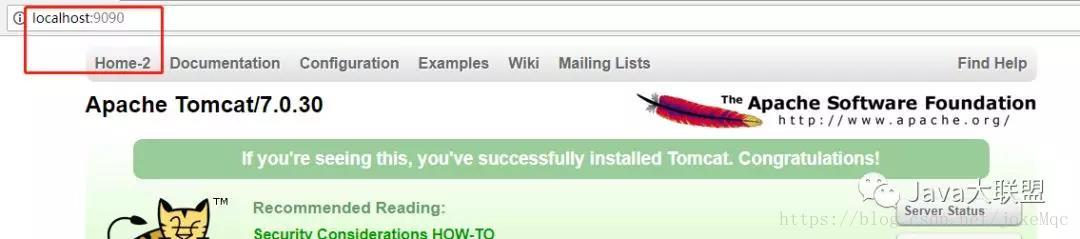

7.测试,访问http://localhost:9090。

第一次看到,运行tomcat1中的程序。

刷新,第二次看到运行tomcat2中的程序。

至此,我们利用nginx已经实现了负载均衡的tomcat集群。下面说一下简单的常用的nginx负载均衡轮询策略,前面我的博客有写到负载均衡的轮询策略,有需要的可以查看。

五、nginx负载均衡策略:

1、轮询(默认)

每个请求按时间顺序逐一分配到不同的后端服务器,如果后端服务器down掉,能自动剔除。

upstream backserver {

server 192.168.0.14;

server 192.168.0.15;

} 2、指定权重

指定轮询几率,weight和访问比率成正比,用于后端服务器性能不均的情况。

upstream backserver {

server 192.168.0.14 weight=10;

server 192.168.0.15 weight=10;

} 3、IP绑定 ip_hash

每个请求按访问ip的hash结果分配,这样每个访客固定访问一个后端服务器,可以解决session的问题。

upstream backserver {

ip_hash;

server 192.168.0.14:88;

server 192.168.0.15:80;

} 4、fair(第三方)

按后端服务器的响应时间来分配请求,响应时间短的优先分配。

upstream backserver {

server server1;

server server2;

fair;

} 5、url_hash(第三方)

按访问url的hash结果来分配请求,使每个url定向到同一个后端服务器,后端服务器为缓存时比较有效。

upstream backserver {

server squid1:3128;

server squid2:3128;

hash $request_uri;

hash_method crc32;

}