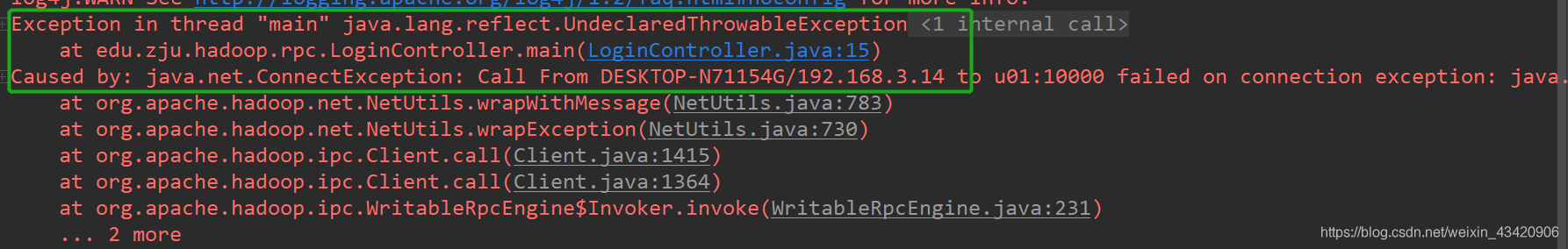

1. 使用RPC时,用win10上的主机连接虚拟机上的ubantu时,出现java.net.ConnectException问题。

错误截图:

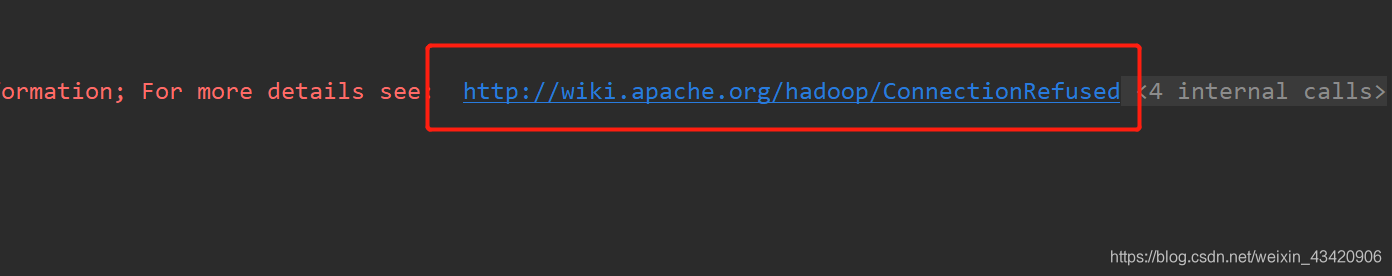

在后面的建议链接中可以得到答案:

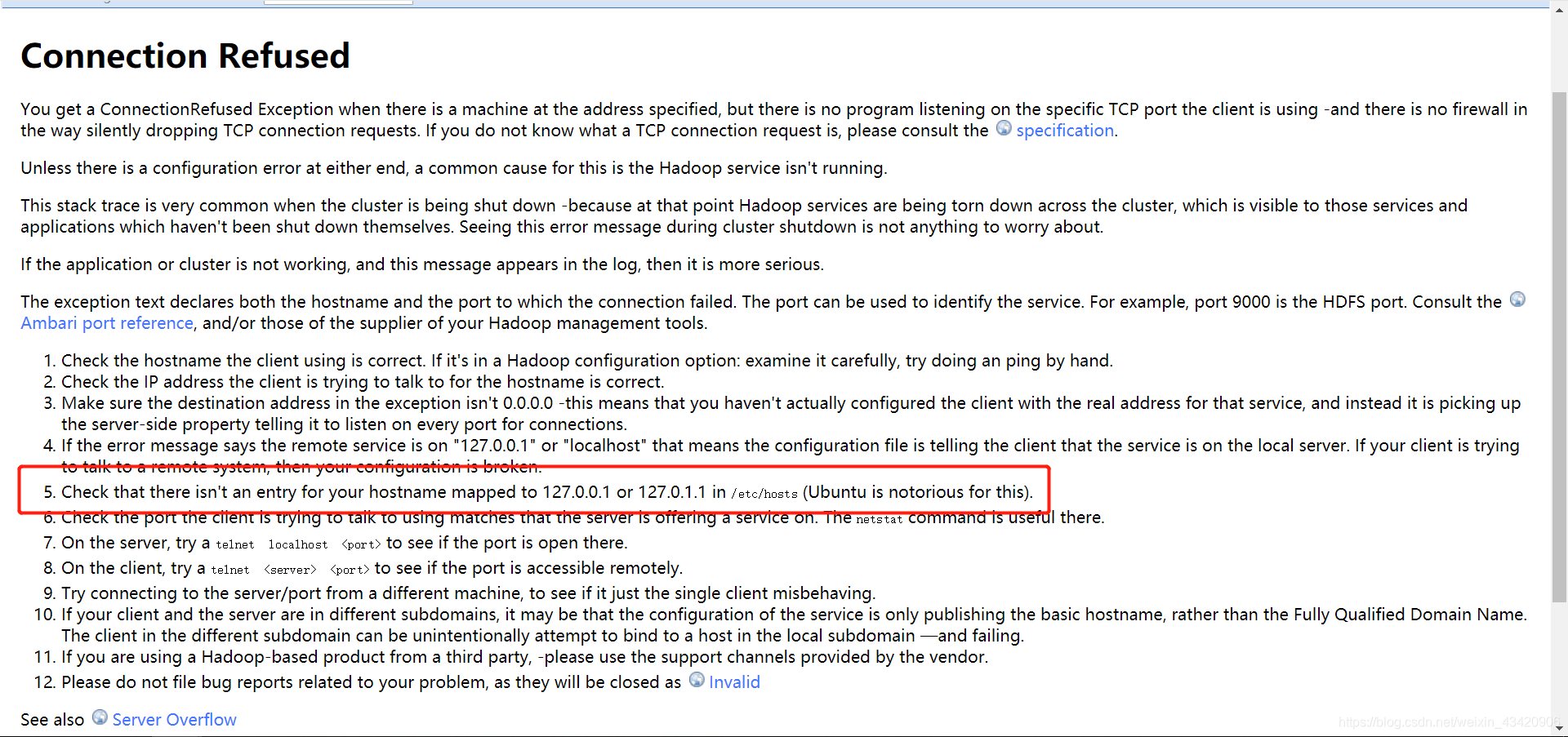

根据Hadoop给出的建议,可以发现是ubantu中/etc/hosts的问题:

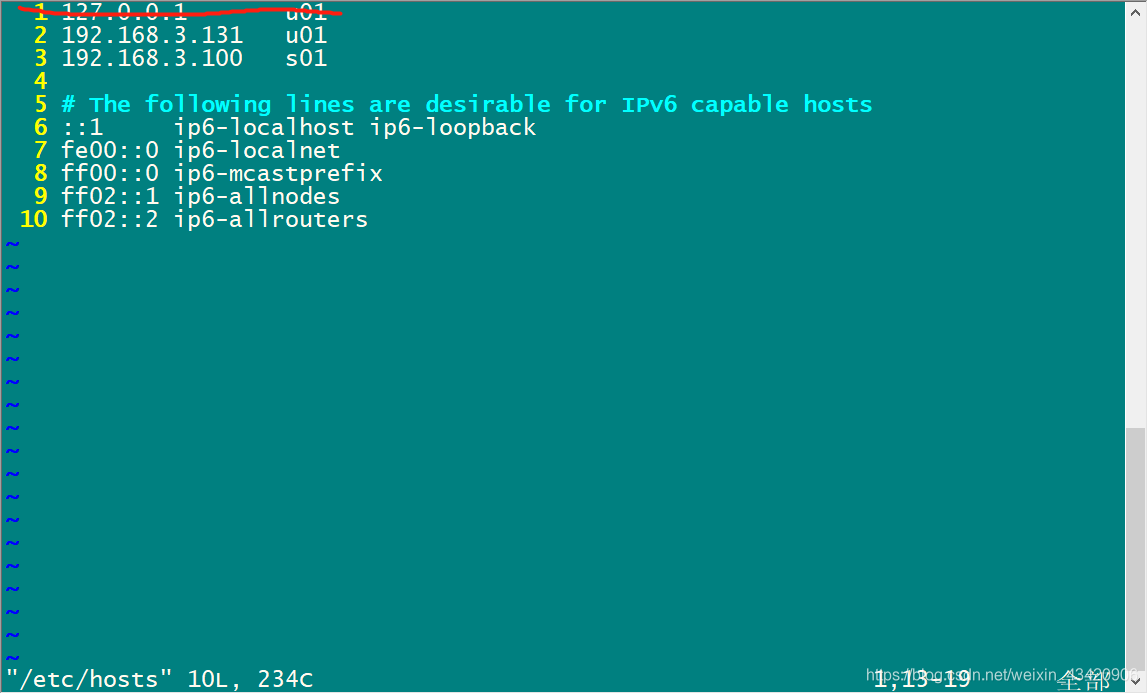

原来是ubantu中的/etc/hosts默认设置的原因,对其进行修改,删除默认的主机名匹配:

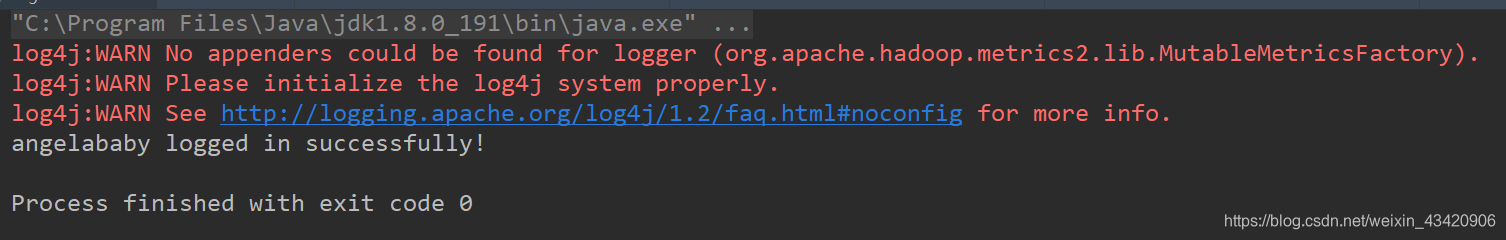

再次运行原来的程序,就正常了。

注:这里还有一个坑,因为之前上传到hdfs中的文件已经是设定好namenode所关联的ip了,也就是主机名所对应的ip,所以如果只修改了hosts文件,就会发生很奇怪的事。

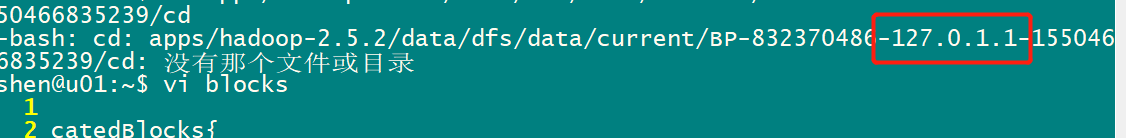

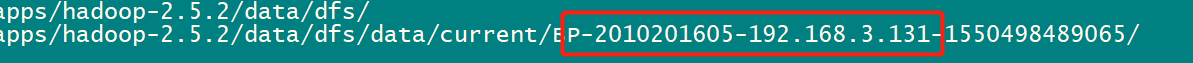

如下图所示,可以在定义的存放block的地方看到上传到hdfs中的block中记录了namenode的IP地址

可以看到,文件的ip地址已经改成上面这样了,这就是为啥改完hosts后会出现奇怪的连接失败的原因。

可以将定义的hdfs中的临时文件删除,再运行hadoop namenode -format进行重置,就一切正常了。

2. 在linux中使用mapreduce的本地模式运行时,文件路径名为file:///home/****