1.为什么使用卷积:

两个优势:参数共享和稀疏连接

参数共享:特征检测如垂直边缘检测如果适用于图片的某个区域,那么它也可能适用于图片的其他区域

稀疏连接:

2.实例探究:

(1)LeNet-5网络:针对灰度图片:

激活函数: Sigmod

(2)AlexNet网络:

激活函数:ReLu

(3)VGG16:

随着网络的加深,图像的高度和宽度都在以一定的规律不断缩小,每次池化后刚好缩小一半,而通道数量在不断增加,而且刚好也是在每组卷积操作后增加一倍。也就是说,图像缩小的比例和通道数增加的比例是有规律的。

(4)残差网络(ResNets):

残差块:

ResNet 网络就是通过将很多这样的残差块堆积在一起,形成一个很深神经网络

残差网络起作用的主要原因就是这些残差块学习恒等函数非常容易,能确定网络性能不会受到影响,很多时候甚至可以提高效率,或者说至少不会降低网络的效率,因此创建类似残差网络可以提升网络性能。

目前不是很清楚,只知道可以提升网络性能,解决很深的网络梯度消失和梯度爆炸问题(下面会讲),以后理解了再补充

(5)1x1卷积:

示例图:

根本上:对这 32 个不同的位置都应用一个全连接层

作用:

- 可以压缩通道数,池化层只是压缩了这些层的高度和宽度

- 给神经网络添加了一个非线性函数,从而减少或保持输入层中的通道数量不变,当然如果你愿意,也可以增加通道数量

(6)Inception网络:

基本思想是 Inception 网络不需要人为决定使用哪个过滤器或者是否需要池化,而是由网络自行确定这些参数,你可以给网络添加这些参数的所有可能值,然后把这些输出连接起来,让网络自己学习它需要什么样的参数,采用哪些过滤器组合。

合理构建瓶颈层,既可以显著缩小表示层规模,又不会降低网络性能,从而节省了计算

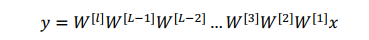

3.梯度消失和梯度爆炸:

权重w只比1略大一点,或者说只是比单位矩阵大一点,深度神经网络的激活函数将爆炸式增长,如果w比 1 略小一点,深度神经网络中,激活函数将以指数级递减,虽然只是讨论了激活函数与L相关的指数级数增长或下降,它也适用于与层数L相关的导数或梯度函数,也是呈指数级增长或呈指数递减。