Rotational region cnn

我们的目标是检测任意方向的场景文本,与RRPN类似,我们的网络也基于FasterR-CNN ,但我们采用不同的策略,而不是产生倾斜角度建议。

我们认为RPN有资格生成文本候选,并根据RPN提出的候选文本预测方向信息

检测步骤:

如图所示:a.原图片

b.通过rpn得到的text regions

c.预测轴对齐框和倾斜框

d.对倾斜框进行非极大值抑制得到预测结果

整个检测网络的结构如图:

提取特征的步骤跟之前的RCNN系列一样,基础CNN网络提取出特征,

然后由RPN提取出文本区域(RPN生成包围任意方向文本的轴对齐边界框),这里已经生成轴对齐框,送入ROI POOLING层进行多个尺度的池化操作(7*7,3*11,11*3)原先的Faster rcnn只有7*7,这三种是专门用来检测常见的文本框。并将pooled特征串联;

通过两个全连接层之后,进行

1.文本/非文本的分类

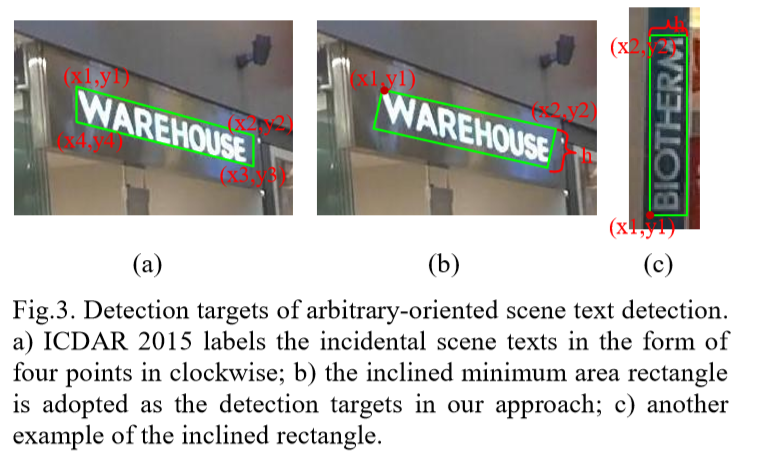

2.轴对齐框包围的倾斜框的预测,倾斜框的预测(x1,y1,x2,y2,h)这里解释下,倾斜框的坐标表示,通过矩形框顺时针的前两个点的坐标来确定一条线,然后通过h来确定宽度。

3.倾斜框的非极大值抑制,得到结果

倾斜框的坐标表示如图:

对于RPN做出的改动:

更多的小场景检测。通过在RPN中利用较小的anchor比例来解决这一问题。

在Faster R-CNN中的原始anchor 缩放是(8,16,32)

我们研究了两种策略:

a)将anchor比例缩放更改为较小的尺寸,并使用(4,8,16);

b)增加一个新的anchor缩放并利用(4,8,16,32)

对roi pooling做出的改动:

加入11*3和3*11,使用不同的roi pooling大小获取更多特征, pooled 特征被连接在一起以便进一步检测;

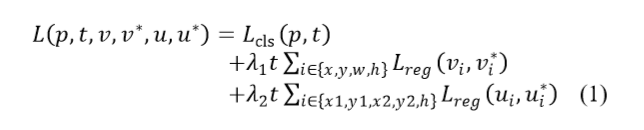

R2CNN的loss函数:

分为两部分,Lcls是分类的loss,下面分别是轴对齐框的Loss和倾斜框的Loss