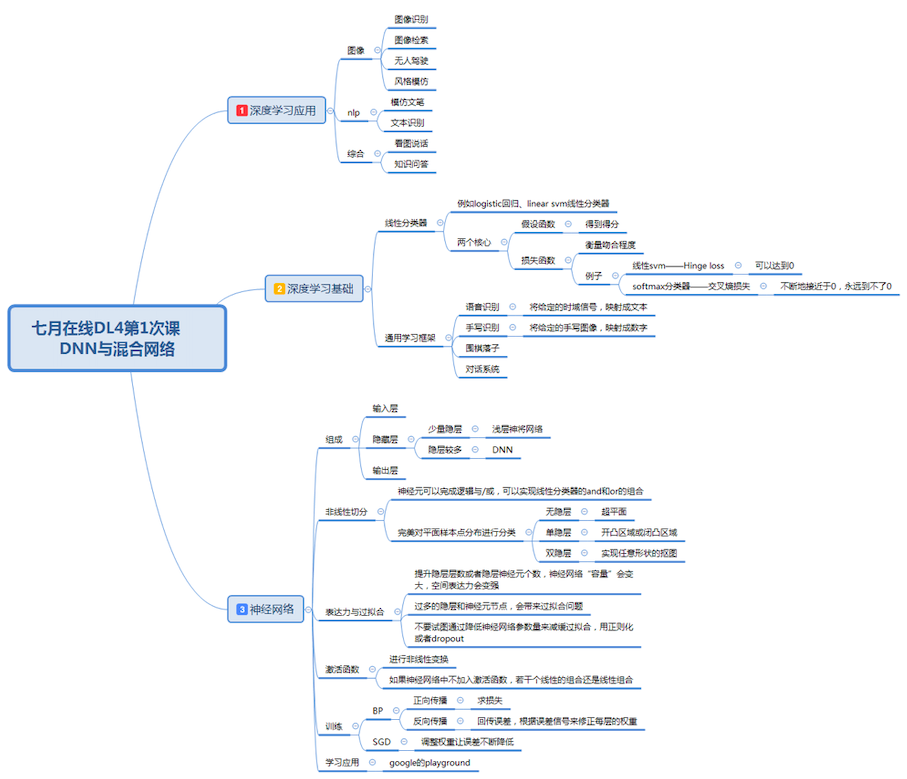

深度学习-线性代数分类器

深度学习的理论不难, 主要是对感知机(线性感知机的多层叠加, 使其可以拟合比较复杂的数据 这样就对复杂空间进行更好的切割,和拟合)

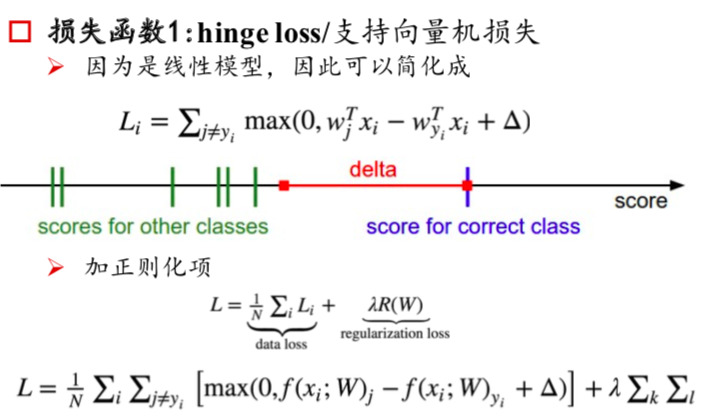

损失函数- 支持向量机损失

损失函数就是用来调节参数, 判断模型是否是优劣的, 如果模式选择的不对, 那么损失函数会有比较大的损失, 因此我们可以通过损失函数判断模型是否优劣.

第一个是支持向量机损失, hinge loss , 做了一个事情就是对正确划分的项进行一个标杆, 其他如果在 delta内部, 那很好, 所有在损失函数中就是 0, 如果离得比较近就需要进行一定的惩罚, 因此我们可以通过这样就可以判断模型的优劣.

交叉熵损失(softmax 分类器)

交叉熵损失就是通过 softmax进行正则化(化为概率), 然后通过交叉熵来判断, 通过-log(x),如果离得比较近, 那么效果比较好

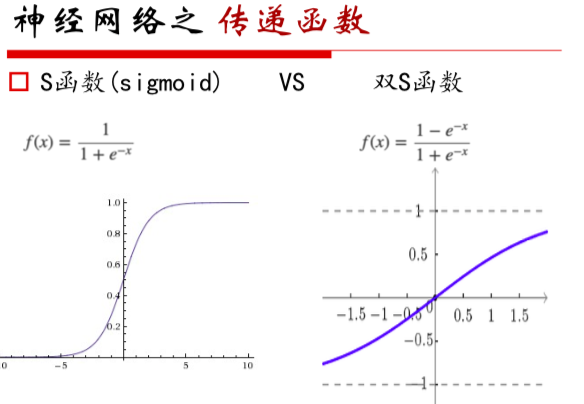

- 通过激活函数将神经网络进行非线性空间的拟合, 比如 sigmoid 函数,可以将线性回归变成非线性回归

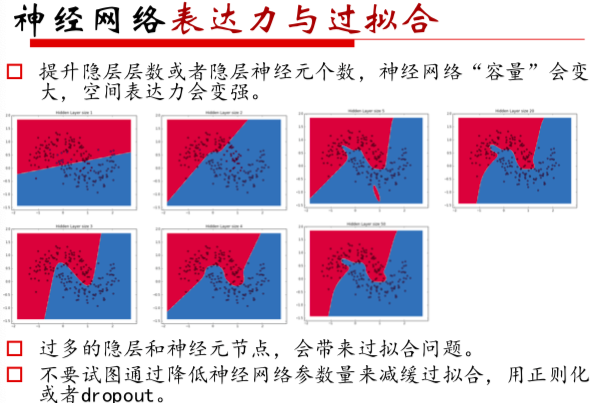

- 神经网络的表达力和过拟合

- 神经网络的过拟合用正则化和 dropout 进行减缓

- 激活函数用来将线性变成非线性

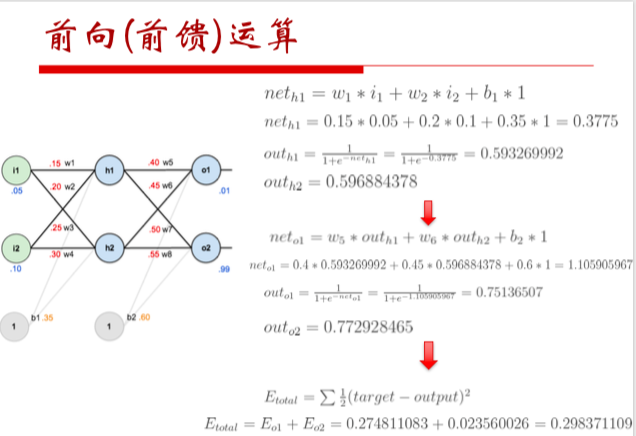

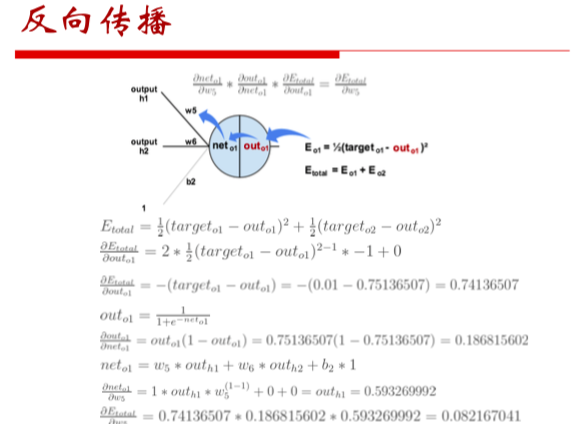

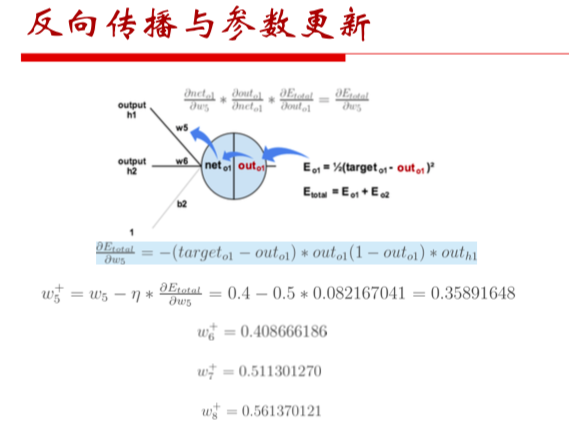

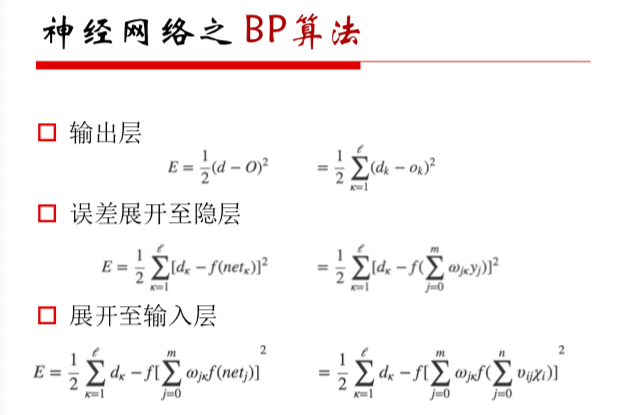

- BP算法用来优化参数, 通过正向传播求解误差, 然后通过反向传播进行参数调节, 就是多函数进行求导

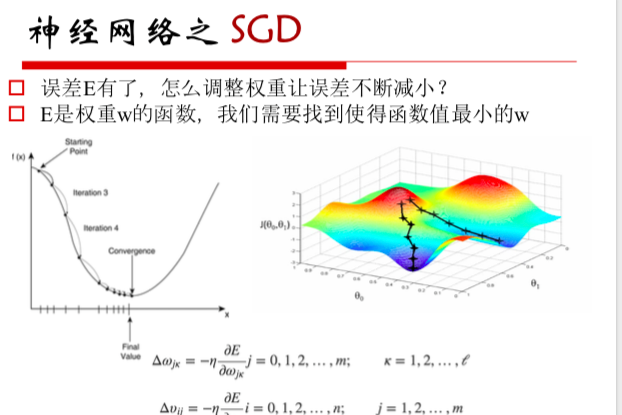

- 如何更新参数, 用 SGD 随机梯度下降

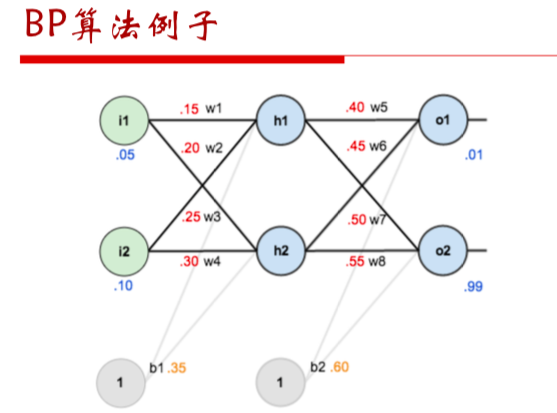

- BP算法的例子