因为项目的原因,需要使用到NLP的相关技术。当时是先使用过nltk,但是因为nltk主要是外国的语种支持的比较丰富,而且又是python要与项目集成也不太方便,后来找到OpenNLP,发现它相对来说,对于亚洲的语言有一些支持。因此使用上了,最近有空,就想细致的学习下OpenNLP的训练相关的东西,因为在项目里遇到了中文与日文中的汉字交叉的情况,且如果检测对象过短,对于检测结果也容易出现偏差的情况。好了,废话不多说,直接主题。

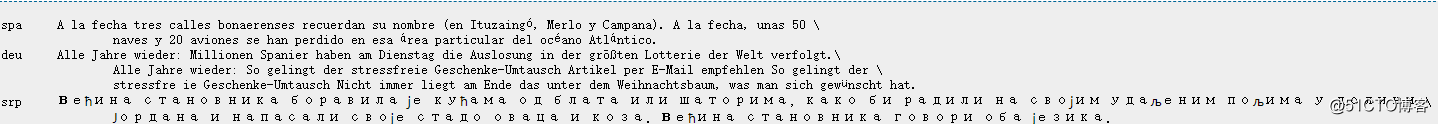

我们先从文档入手,在官网上的文档是很规范的,先找到Language Detector这个title,然后往下看到training,我们根据文档提示,发现其实我们的语料按照如下规范就可以了:

注意几点:

1.文本文件中的一行就是一条语料,第一列是语种对应的ISO-639-3码,第二列是tab缩进,第三列就是语料文本

2.对于长文本,不要人为的去加换行

3.训练语料必须要有多个不同的语料信息,否则在训练时会报错

有了以上的语料文件,就可以通过几行简单的代码就能将其训练成我们需要的语言检测了

InputStreamFactory inputStreamFactory = new MarkableFileInputStreamFactory(new File("corpus.txt"));

ObjectStream<String> lineStream = new PlainTextByLineStream(inputStreamFactory, StandardCharsets.UTF_8);

ObjectStream<LanguageSample> sampleStream = new LanguageDetectorSampleStream(lineStream);

TrainingParameters params = ModelUtil.createDefaultTrainingParameters();

params.put(TrainingParameters.ALGORITHM_PARAM, PerceptronTrainer.PERCEPTRON_VALUE);

params.put(TrainingParameters.CUTOFF_PARAM, 0);

LanguageDetectorFactory factory = new LanguageDetectorFactory();

LanguageDetectorModel model = LanguageDetectorME.train(sampleStream, params, factory);

model.serialize(new File("langdetect.bin"));

}最后运行一下,就能在你的本地生成一个langdetect.bin的语料文件了,以后就在程序里用上就好了。