如何拟合逻辑回归模型的θ值

这便是监督学习问题中的逻辑回归模型的拟合问题。我们有一个训练集,m训练样本,对每一个训练样本都用n+1维的特征向量表示,x0=1, y∈{0,1}。hθ(x)是假设的函数,θ是假设的参数。

我们要解决的问题就是,对于给定的训练集,我们如何拟合参数θ?

Cost函数

分类问题的代价函数表达式

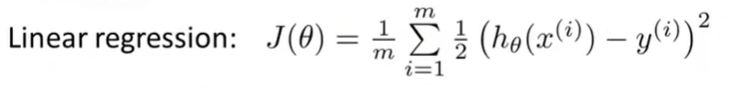

在之前的线性回归方程中我们使用了这个代价函数:

我们对这个代价函数进行如下更改得到:

由此,我们新定义的代价函数是这个Cost函数,在训练集范围上的求和后的1/m倍。

对代价函数的理解

我们所期望的学习算法,如果想要达到这个值,也就是这个假设h(x)所需要复出的代价。这个所希望的预测值是h(x) 。而实际值则是y。 所有代价函数会被定义为上面的形式:

这个代价值可以很好的用在线性回归方程里,但是我们现在要用在逻辑回归里。如果我们可以最小化代价函数J里面的这个带价值,这样就可以工作得很好。

但事实是,如果我们使用这个代价值,代价函数就会变成参数θ的非凸函数。

非凸函数 有很多局部最优值。显然如果把梯度下降法用在这样的函数上,并不能保证收敛时得到的全局最小值。

我们希望我们的代价函数是单项调整型函数。

我们所希望的代价函数是一个凸函数,可以保证梯度下降法找到全局最优值。

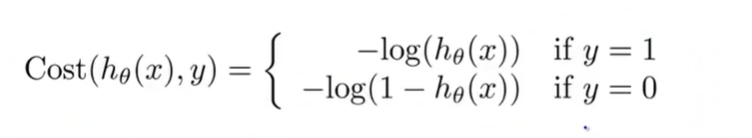

下面这个代价函数是我们要用在逻辑回归上的.

如果预测值hθ(x)是一个数,比如0.7,而实际上真实的值是y。那么代价函数的值将等于-log(hθ(x)),当y=1时。当y=0时,代价函数的值将等于-log(1-hθ(x))。

如果假设函数的预测值hθ(x)=1,而且实际值y也等于1,即假设函数预测值与实际值完全相符,则代价函数为0,函数需要付出的代价为0;

如果假设函数的预测值hθ(x)=0,如果是肿瘤预测的例子,就是肿瘤完全不可能是恶性的。但是实际值y=1,也就是肿瘤事实上确定为恶性的,即预测值与实际值完全不符,则代价函数Cost = ∞,即让代价函数付出沉重的代价。

所有在实际值y=1的情况下,当hθ(x)趋向于0时,代价函数Cost趋向于无穷大。

y=0时的代价函数图像如下:

当hθ(x)等于0 时,Cost代价函数才为0,当hθ(x)趋近于1时,代价函数的值趋向于∞

——————————————