Hadoop-3.1.2 安装步骤

第一步 准备 服务器配置

1. 在VMware中安装把Centos7安装成功后,需要把界面设置为命令行启动,因为默认的启动方式是图形界面启动

systemctl set-default multi-user.target

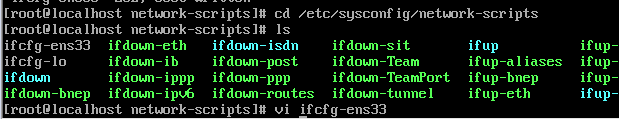

2. 修改IP 地址,网络连接的配置

cd /etc/sysconfig/network-scripts/ 进入目录

ls 查看目录下的所有文件

vi ifcfg-ens33 修改此文件

修改内容如下

3 重启网络配置,使网络配置生效

service network restart 重启网络设置

4. 停止防火墙

systemctl disable firewalld.service

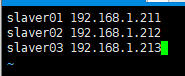

5.修改hosts文件

vi /etc/hosts

6. 设置hostname

hostnamectl set-hostanme master

7 安装jdk

通过xftp把jdk安装包复制到虚拟机的/root/apps下,并安装当前目录中

tar -zxvf ./jdk-8u231-linux-x64.tar.gz -C ./

8 安装hadoop

通过xftp把hadoop安装包复制到虚拟机的/root/apps下,并安装在当前目录中

tar -zxvf ./hadoop-3.1.2.tar.gz -C ./

第二步 SSH免密登录配置

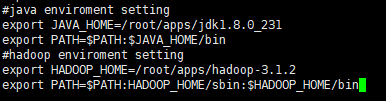

9 把java和hadoop配置为环境变量

vi /etc/profile

10 重启配置使配置生效

source /etc/profile

通过命令查看jdk或者hadoop是否安装成功

11. 设置hadoop中java环境

vi /root/apps/hadoop-3.1.2/etc/hadoop/hadoop-env.sh

12 配置文件的修改配置

(1)core-site.xml

<property>

<name>fs.defaultFS</name>

<value>hdfs://master:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/root/bigdata/hddata</value>

</property>

(2) hdfs-site.xml

<property>

<name>dfs.replication</name>

<value>2</value>

</property>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>slaver01:9001</value>

</property>

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

(3) mapred-site.xml

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

(4) yarn-site.xml

<property>

<name>yarn.resourcemanager.hostname</name>

<value>master</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

13 配置worker

vi /root/apps/hadoop-3.1.2/etc/hadoop/workers

14 修改 vi /root/apps/hadoop-3.1.2/etc/hadoop/yarn-env.sh

YARN_RESOURCEMANAGER_USER=root

HADOOP_SECURE_DN_USER=yarn

YARN_NODEMANAGER_USER=root

15 在 sbin,修改start-dfs.sh,stop-dfs.sh,都添加:

vi /root/apps/hadoop-3.1.2/sbin/start-dfs.sh

HDFS_DATANODE_USER=root

HDFS_DATANODE_SECURE_USER=hdfs

HDFS_NAMENODE_USER=root

HDFS_SECONDARYNAMENODE_USER=root