【中文】【吴恩达课后编程作业】Course 4 - 卷积神经网络 - 第三周作业 - 车辆识别

资料下载

- 本文所使用的资料已上传到百度网盘【点击下载(444.7MB)】,请在开始之前下载好所需资料,底部不提供代码。

【博主使用的python版本:3.6.2】

自动驾驶 - 汽车识别

本次我们将学习到使用YOLO算法进行对象识别,我们先导入包:

import argparse

import os

import matplotlib.pyplot as plt

from matplotlib.pyplot import imshow

import scipy.io

import scipy.misc

import numpy as np

import pandas as pd

import PIL

import tensorflow as tf

from keras import backend as K

from keras.layers import Input, Lambda, Conv2D

from keras.models import load_model, Model

from yad2k.models.keras_yolo import yolo_head, yolo_boxes_to_corners, preprocess_true_boxes, yolo_loss, yolo_body

import yolo_utils

%matplotlib inline请注意!正如你所看到的,我们导入了Keras的后台,命名为K,这意味着我们将使用Keras框架。

1 - 要解决的问题

假设你现在在做自动驾驶的汽车,你想着首先应该做一个汽车检测系统,为了搜集数据,你已经在你的汽车前引擎盖上安装了一个照相机,在你开车的时候它会每隔几秒拍摄一次前方的道路。

.

.

我们要特别感谢 drive.ai提供这个数据集!Drive.ai是一家自动驾驶汽车的公司。

假如你想让YOLO识别80个分类,你可以把分类标签 从1到80进行标记,或者把它变为80维的向量(80个数字),在对应位置填写上0或1。视频中我们使用的是后面的方案。因为YOLO的模型训练起来是比较久的,我们将使用预先训练好的权重来进行使用。

2 - YOLO

YOLO(”you only look once”)因为它的实时高准确率,这就使得它是目前比较流行的算法。在算法中“只看一次(only looks once)”的机制使得它在预测时只需要进行一次前向传播,在使用非最大值抑制后,它与边界框一起输出识别对象。

2.1 - 模型细节

第一个你需要知道的事情是:

- 输入的批量图片的维度为(m,608,608,3)

- 输出是一个识别分类与边界框的列表。每个边界框由6个数字组成:( )。如果你将 放到80维的向量中,那么每个边界框就由85个数字组成。

我们会使用5个锚框(anchor boxes),所以算法大致流程是这样的:图像输入(m,608,608,3) DEEP CNN 编码(m,19,19,5,85)。

我们来看看编码的情况:

如果对象的中心/中点在单元格内,那么该单元格就负责识别该对象

我们也使用了5个锚框,19x19的单元格,所以每个单元格内有5个锚框的编码信息,锚框的组成是

为了方便,我们将把最后的两个维度的数据进行展开,所以最后一步的编码由(m,19,19,5,85)变为了(m,19,19,425)。

对于每个单元格的每个锚框而言,我们将计算下列元素的乘积,并提取该框包含某一类的概率。

这里有张YOLO预测图的可视化预测:

- 对于每个19x19的单元格,找寻最大的可能性值,在5个锚框和不同的类之间取最大值

- 根据单元格预测的最可能的对象来使用添加颜色的方式来标记单元格。

需要注意的就是该可视化不是YOLO算法本身进行预测的核心部分,这只是一种可视化算法中间结果的比较d好的方法。另一种可视化YOLO输出的方法是绘制它输出的边界框,这样做会导致可视化是这样的:

在上图中们只绘制了模型所猜测的高概率的锚框,但锚框依旧是太多了。我们希望将算法的输出过滤为检测到的对象数量更少,要做到这一点,我们将使用非最大抑制。具体来说,我们将执行以下步骤:

- 舍弃掉低概率的锚框(意思是格子算出来的概率比较低我们就不要)

- 当几个锚框相互重叠并检测同一个物体时,只选择一个锚框。

2.2 - 分类阈值过滤

现在我们要为阈值进行过滤,我们要去掉一些预测值低于预设值的锚框。模型共计会有 个数字,每一个锚框由85个数字组成(80个分类+ ),将维度为(19,19,5,85)或者(19,19,425)转换为下面的维度将会有利于我们的下一步操作:

box_confidence:tensor类型,维度为(19x19,5,1),包含19x19单元格中每个单元格预测的5个锚框中的所有的锚框的 (一些对象的置信概率)。boxes:tensor类型,维度为(19x19,5,4),包含了所有的锚框的( )。box_class_probs:tensor类型,维度为(19x19,5,80),包含了所有单元格中所有锚框的所有对象( )检测的概率。

现在我们要实现函数yolo_filter_boxes(),步骤如下:

- 根据图4来计算对象的可能性:

a = np.random.randn(19x19,5,1) #p_c

b = np.random.randn(19x19,5,80) #c_1 ~ c_80

c = a * b #计算后的维度将会是(19x19,5,80)

对于每个锚框,需要找到:

根据阈值来创建掩码,比如执行下列操作:

[0.9, 0.3, 0.4, 0.5, 0.1] < 0.4,返回的是[False, True, False, False, True],对于我们要保留的锚框,对应的掩码应该为True或者1.使用TensorFlow来对

box_class_scores、boxes、box_classes进行掩码操作以过滤出我们想要的锚框。

如果你想要调用Keras的函数的话,请使用K.function(...)。

def yolo_filter_boxes(box_confidence , boxes, box_class_probs, threshold = 0.6):

"""

通过阈值来过滤对象和分类的置信度。

参数:

box_confidence - tensor类型,维度为(19,19,5,1),包含19x19单元格中每个单元格预测的5个锚框中的所有的锚框的pc (一些对象的置信概率)。

boxes - tensor类型,维度为(19,19,5,4),包含了所有的锚框的(px,py,ph,pw )。

box_class_probs - tensor类型,维度为(19,19,5,80),包含了所有单元格中所有锚框的所有对象( c1,c2,c3,···,c80 )检测的概率。

threshold - 实数,阈值,如果分类预测的概率高于它,那么这个分类预测的概率就会被保留。

返回:

scores - tensor 类型,维度为(None,),包含了保留了的锚框的分类概率。

boxes - tensor 类型,维度为(None,4),包含了保留了的锚框的(b_x, b_y, b_h, b_w)

classess - tensor 类型,维度为(None,),包含了保留了的锚框的索引

注意:"None"是因为你不知道所选框的确切数量,因为它取决于阈值。

比如:如果有10个锚框,scores的实际输出大小将是(10,)

"""

#第一步:计算锚框的得分

box_scores = box_confidence * box_class_probs

#第二步:找到最大值的锚框的索引以及对应的最大值的锚框的分数

box_classes = K.argmax(box_scores, axis=-1)

box_class_scores = K.max(box_scores, axis=-1)

#第三步:根据阈值创建掩码

filtering_mask = (box_class_scores >= threshold)

#对scores, boxes 以及 classes使用掩码

scores = tf.boolean_mask(box_class_scores,filtering_mask)

boxes = tf.boolean_mask(boxes,filtering_mask)

classes = tf.boolean_mask(box_classes,filtering_mask)

return scores , boxes , classes我们来测试一下:

with tf.Session() as test_a:

box_confidence = tf.random_normal([19,19,5,1], mean=1, stddev=4, seed=1)

boxes = tf.random_normal([19,19,5,4], mean=1, stddev=4, seed=1)

box_class_probs = tf.random_normal([19, 19, 5, 80], mean=1, stddev=4, seed = 1)

scores, boxes, classes = yolo_filter_boxes(box_confidence, boxes, box_class_probs, threshold = 0.5)

print("scores[2] = " + str(scores[2].eval()))

print("boxes[2] = " + str(boxes[2].eval()))

print("classes[2] = " + str(classes[2].eval()))

print("scores.shape = " + str(scores.shape))

print("boxes.shape = " + str(boxes.shape))

print("classes.shape = " + str(classes.shape))

test_a.close()测试结果:

scores[2] = 10.7506

boxes[2] = [ 8.42653275 3.27136683 -0.53134358 -4.94137335]

classes[2] = 7

scores.shape = (?,)

boxes.shape = (?, 4)

classes.shape = (?,)2.3 - 非最大值抑制

即使是我们通过阈值来过滤了一些得分较低的分类,但是我们依旧会有很多的锚框被留了下来,第二个过滤器就是让下图左边变为右边,我们叫它非最大值抑制( non-maximum suppression (NMS))

非最大值抑制使用了一个非常重要的功能,叫做交并比(Intersection over Union (IoU))

现在我们要实现交并比函数iou(),步骤如下:

在这里,我们要使用左上和右下角来定义方框( )而不是使用中点+宽高的方式定义。

要计算矩形的面积我们需要用高度( )乘以 ( )

我们还需要找到两个锚框的交点的坐标( )

- = 两个锚框的 坐标的最大值

- = 两个锚框的 坐标的最大值

- = 两个锚框的 坐标的最小值

- = 两个锚框的 坐标的最小值

为了计算相交的区域,我们需要确定相交的区域的宽、高均为正数,否则就为0,我们可以使用

max(height, 0)与max(width, 0)来完成。

在代码中,我们为了方便把图片的左上角定为(0,0),右上角为(1,0),左下角为(0,1),右下角为(1,1)。

def iou(box1, box2):

"""

实现两个锚框的交并比的计算

参数:

box1 - 第一个锚框,元组类型,(x1, y1, x2, y2)

box2 - 第二个锚框,元组类型,(x1, y1, x2, y2)

返回:

iou - 实数,交并比。

"""

#计算相交的区域的面积

xi1 = np.maximum(box1[0], box2[0])

yi1 = np.maximum(box1[1], box2[1])

xi2 = np.minimum(box1[2], box2[2])

yi2 = np.minimum(box1[3], box2[3])

inter_area = (xi1-xi2)*(yi1-yi2)

#计算并集,公式为:Union(A,B) = A + B - Inter(A,B)

box1_area = (box1[2]-box1[0])*(box1[3]-box1[1])

box2_area = (box2[2]-box2[0])*(box2[3]-box2[1])

union_area = box1_area + box2_area - inter_area

#计算交并比

iou = inter_area / union_area

return iou我们来测试一下:

box1 = (2,1,4,3)

box2 = (1,2,3,4)

print("iou = " + str(iou(box1, box2)))测试结果:

iou = 0.142857142857现在我们要实现非最大值抑制函数,关键步骤如下:

- 选择分值高的锚框

- 计算与其他框的重叠部分,并删除与iou_threshold相比重叠的框。

- 返回第一步,直到不再有比当前选中的框得分更低的框。

这将删除与选定框有较大重叠的其他所有锚框,只有得分最高的锚框仍然存在。

我们要实现的函数名为yolo_non_max_suppression(),使用TensorFlow实现,TensorFlow有两个内置函数用于实现非最大抑制(所以你实际上不需要使用你的iou()实现):

def yolo_non_max_suppression(scores, boxes, classes, max_boxes=10, iou_threshold=0.5):

"""

为锚框实现非最大值抑制( Non-max suppression (NMS))

参数:

scores - tensor类型,维度为(None,),yolo_filter_boxes()的输出

boxes - tensor类型,维度为(None,4),yolo_filter_boxes()的输出,已缩放到图像大小(见下文)

classes - tensor类型,维度为(None,),yolo_filter_boxes()的输出

max_boxes - 整数,预测的锚框数量的最大值

iou_threshold - 实数,交并比阈值。

返回:

scores - tensor类型,维度为(,None),每个锚框的预测的可能值

boxes - tensor类型,维度为(4,None),预测的锚框的坐标

classes - tensor类型,维度为(,None),每个锚框的预测的分类

注意:"None"是明显小于max_boxes的,这个函数也会改变scores、boxes、classes的维度,这会为下一步操作提供方便。

"""

max_boxes_tensor = K.variable(max_boxes,dtype="int32") #用于tf.image.non_max_suppression()

K.get_session().run(tf.variables_initializer([max_boxes_tensor])) #初始化变量max_boxes_tensor

#使用使用tf.image.non_max_suppression()来获取与我们保留的框相对应的索引列表

nms_indices = tf.image.non_max_suppression(boxes, scores,max_boxes,iou_threshold)

#使用K.gather()来选择保留的锚框

scores = K.gather(scores, nms_indices)

boxes = K.gather(boxes, nms_indices)

classes = K.gather(classes, nms_indices)

return scores, boxes, classes我们来测试一下:

with tf.Session() as test_b:

scores = tf.random_normal([54,], mean=1, stddev=4, seed = 1)

boxes = tf.random_normal([54, 4], mean=1, stddev=4, seed = 1)

classes = tf.random_normal([54,], mean=1, stddev=4, seed = 1)

scores, boxes, classes = yolo_non_max_suppression(scores, boxes, classes)

print("scores[2] = " + str(scores[2].eval()))

print("boxes[2] = " + str(boxes[2].eval()))

print("classes[2] = " + str(classes[2].eval()))

print("scores.shape = " + str(scores.eval().shape))

print("boxes.shape = " + str(boxes.eval().shape))

print("classes.shape = " + str(classes.eval().shape))

test_b.close()测试结果:

scores[2] = 6.9384

boxes[2] = [-5.299932 3.13798141 4.45036697 0.95942086]

classes[2] = -2.24527

scores.shape = (10,)

boxes.shape = (10, 4)

classes.shape = (10,)2.4 - 对所有框进行过滤

现在我们要实现一个CNN(19x19x5x85)输出的函数,并使用刚刚实现的函数对所有框进行过滤。

我们要实现的函数名为yolo_eval(),它采用YOLO编码的输出,并使用分数阈值和NMS来过滤这些框。你必须知道最后一个实现的细节。有几种表示锚框的方式,例如通过它们的角或通过它们的中点和高度/宽度。YOLO使用以下功能(我们提供)在不同时间在几种这样的格式之间进行转换:

boxes = yolo_boxes_to_corners(box_xy, box_wh)

它将yolo锚框坐标(x,y,w,h)转换为角的坐标(x1,y1,x2,y2)以适应yolo_filter_boxes()的输入。

boxes = yolo_utils.scale_boxes(boxes, image_shape)

YOLO的网络经过训练可以在608x608图像上运行。如果你要在不同大小的图像上测试此数据(例如,汽车检测数据集具有720x1280图像),则此步骤会重新缩放这些框,以便在原始的720x1280图像上绘制它们。

def yolo_eval(yolo_outputs, image_shape=(720.,1280.),

max_boxes=10, score_threshold=0.6,iou_threshold=0.5):

"""

将YOLO编码的输出(很多锚框)转换为预测框以及它们的分数,框坐标和类。

参数:

yolo_outputs - 编码模型的输出(对于维度为(608,608,3)的图片),包含4个tensors类型的变量:

box_confidence : tensor类型,维度为(None, 19, 19, 5, 1)

box_xy : tensor类型,维度为(None, 19, 19, 5, 2)

box_wh : tensor类型,维度为(None, 19, 19, 5, 2)

box_class_probs: tensor类型,维度为(None, 19, 19, 5, 80)

image_shape - tensor类型,维度为(2,),包含了输入的图像的维度,这里是(608.,608.)

max_boxes - 整数,预测的锚框数量的最大值

score_threshold - 实数,可能性阈值。

iou_threshold - 实数,交并比阈值。

返回:

scores - tensor类型,维度为(,None),每个锚框的预测的可能值

boxes - tensor类型,维度为(4,None),预测的锚框的坐标

classes - tensor类型,维度为(,None),每个锚框的预测的分类

"""

#获取YOLO模型的输出

box_confidence, box_xy, box_wh, box_class_probs = yolo_outputs

#中心点转换为边角

boxes = yolo_boxes_to_corners(box_xy,box_wh)

#可信度分值过滤

scores, boxes, classes = yolo_filter_boxes(box_confidence, boxes, box_class_probs, score_threshold)

#缩放锚框,以适应原始图像

boxes = yolo_utils.scale_boxes(boxes, image_shape)

#使用非最大值抑制

scores, boxes, classes = yolo_non_max_suppression(scores, boxes, classes, max_boxes, iou_threshold)

return scores, boxes, classes测试一下:

with tf.Session() as test_c:

yolo_outputs = (tf.random_normal([19, 19, 5, 1], mean=1, stddev=4, seed = 1),

tf.random_normal([19, 19, 5, 2], mean=1, stddev=4, seed = 1),

tf.random_normal([19, 19, 5, 2], mean=1, stddev=4, seed = 1),

tf.random_normal([19, 19, 5, 80], mean=1, stddev=4, seed = 1))

scores, boxes, classes = yolo_eval(yolo_outputs)

print("scores[2] = " + str(scores[2].eval()))

print("boxes[2] = " + str(boxes[2].eval()))

print("classes[2] = " + str(classes[2].eval()))

print("scores.shape = " + str(scores.eval().shape))

print("boxes.shape = " + str(boxes.eval().shape))

print("classes.shape = " + str(classes.eval().shape))

test_c.close()测试结果:

scores[2] = 138.791

boxes[2] = [ 1292.32971191 -278.52166748 3876.98925781 -835.56494141]

classes[2] = 54

scores.shape = (10,)

boxes.shape = (10, 4)

classes.shape = (10,)对YOLO的总结:

- 输入图像为(608,608,3)

- 输入的图像先要通过一个CNN模型,返回一个(19,19,5,85)的数据。

- 在对最后两维降维之后,输出的维度变为了(19,19,425):

- 每个19x19的单元格拥有425个数字。

- 425 = 5 x 85,即每个单元格拥有5个锚框,每个锚框由5个基本信息+80个分类预测构成,参见图4。

- 85 = 5 + 85,其中5个基本信息是( ),剩下80就是80个分类的预测。

然后我们会根据以下规则选择锚框:

- 预测分数阈值:丢弃分数低于阈值的分类的锚框。

- 非最大值抑制:计算交并比,并避免选择重叠框。

最后给出YOLO的最终输出。

3 - 测试已经训练好了的YOLO模型

在这部分,我们将使用一个预先训练好的模型并在汽车检测数据集上进行测试。像往常一样,首先创建一个会话来启动计算图:

sess = K.get_session()3.1 - 定义分类、锚框与图像维度

回想一下我们在试着分类80个类别,使用5个锚框。我们收集了两个文件“coco_classes.txt”和“yolo_anchors.txt”中关于80个类和5个锚框的信息。 我们将这些数据加载到模型中。

class_names = yolo_utils.read_classes("model_data/coco_classes.txt")

anchors = yolo_utils.read_anchors("model_data/yolo_anchors.txt")

image_shape = (720.,1280.)3.2 - 加载已经训练好了的模型

训练YOLO模型需要很长时间,并且需要一个相当大的标签边界框数据集,用于大范围的目标类。我们将加载存储在“yolov2.h5”中的现有预训练Keras YOLO模型。 (这些权值来自官方YOLO网站,并使用Allan Zelener编写的函数进行转换,从技术上讲,这些参数来自“YOLOv2”模型。

yolo_model = load_model("model_data/yolov2.h5")这会加载训练的YOLO模型的权重, 以下是模型包含的图层的摘要:

yolo_model.summary()执行结果:

__________________________________________________________________________________________________

Layer (type) Output Shape Param # Connected to

==================================================================================================

input_1 (InputLayer) (None, 608, 608, 3) 0

__________________________________________________________________________________________________

conv2d_1 (Conv2D) (None, 608, 608, 32) 864 input_1[0][0]

__________________________________________________________________________________________________

batch_normalization_1 (BatchNor (None, 608, 608, 32) 128 conv2d_1[0][0]

__________________________________________________________________________________________________

leaky_re_lu_1 (LeakyReLU) (None, 608, 608, 32) 0 batch_normalization_1[0][0]

__________________________________________________________________________________________________

max_pooling2d_1 (MaxPooling2D) (None, 304, 304, 32) 0 leaky_re_lu_1[0][0]

__________________________________________________________________________________________________

conv2d_2 (Conv2D) (None, 304, 304, 64) 18432 max_pooling2d_1[0][0]

__________________________________________________________________________________________________

batch_normalization_2 (BatchNor (None, 304, 304, 64) 256 conv2d_2[0][0]

__________________________________________________________________________________________________

leaky_re_lu_2 (LeakyReLU) (None, 304, 304, 64) 0 batch_normalization_2[0][0]

__________________________________________________________________________________________________

max_pooling2d_2 (MaxPooling2D) (None, 152, 152, 64) 0 leaky_re_lu_2[0][0]

__________________________________________________________________________________________________

conv2d_3 (Conv2D) (None, 152, 152, 128 73728 max_pooling2d_2[0][0]

__________________________________________________________________________________________________

batch_normalization_3 (BatchNor (None, 152, 152, 128 512 conv2d_3[0][0]

__________________________________________________________________________________________________

leaky_re_lu_3 (LeakyReLU) (None, 152, 152, 128 0 batch_normalization_3[0][0]

__________________________________________________________________________________________________

conv2d_4 (Conv2D) (None, 152, 152, 64) 8192 leaky_re_lu_3[0][0]

__________________________________________________________________________________________________

batch_normalization_4 (BatchNor (None, 152, 152, 64) 256 conv2d_4[0][0]

__________________________________________________________________________________________________

leaky_re_lu_4 (LeakyReLU) (None, 152, 152, 64) 0 batch_normalization_4[0][0]

__________________________________________________________________________________________________

conv2d_5 (Conv2D) (None, 152, 152, 128 73728 leaky_re_lu_4[0][0]

__________________________________________________________________________________________________

batch_normalization_5 (BatchNor (None, 152, 152, 128 512 conv2d_5[0][0]

__________________________________________________________________________________________________

leaky_re_lu_5 (LeakyReLU) (None, 152, 152, 128 0 batch_normalization_5[0][0]

__________________________________________________________________________________________________

max_pooling2d_3 (MaxPooling2D) (None, 76, 76, 128) 0 leaky_re_lu_5[0][0]

__________________________________________________________________________________________________

conv2d_6 (Conv2D) (None, 76, 76, 256) 294912 max_pooling2d_3[0][0]

__________________________________________________________________________________________________

batch_normalization_6 (BatchNor (None, 76, 76, 256) 1024 conv2d_6[0][0]

__________________________________________________________________________________________________

leaky_re_lu_6 (LeakyReLU) (None, 76, 76, 256) 0 batch_normalization_6[0][0]

__________________________________________________________________________________________________

conv2d_7 (Conv2D) (None, 76, 76, 128) 32768 leaky_re_lu_6[0][0]

__________________________________________________________________________________________________

batch_normalization_7 (BatchNor (None, 76, 76, 128) 512 conv2d_7[0][0]

__________________________________________________________________________________________________

leaky_re_lu_7 (LeakyReLU) (None, 76, 76, 128) 0 batch_normalization_7[0][0]

__________________________________________________________________________________________________

conv2d_8 (Conv2D) (None, 76, 76, 256) 294912 leaky_re_lu_7[0][0]

__________________________________________________________________________________________________

batch_normalization_8 (BatchNor (None, 76, 76, 256) 1024 conv2d_8[0][0]

__________________________________________________________________________________________________

leaky_re_lu_8 (LeakyReLU) (None, 76, 76, 256) 0 batch_normalization_8[0][0]

__________________________________________________________________________________________________

max_pooling2d_4 (MaxPooling2D) (None, 38, 38, 256) 0 leaky_re_lu_8[0][0]

__________________________________________________________________________________________________

conv2d_9 (Conv2D) (None, 38, 38, 512) 1179648 max_pooling2d_4[0][0]

__________________________________________________________________________________________________

batch_normalization_9 (BatchNor (None, 38, 38, 512) 2048 conv2d_9[0][0]

__________________________________________________________________________________________________

leaky_re_lu_9 (LeakyReLU) (None, 38, 38, 512) 0 batch_normalization_9[0][0]

__________________________________________________________________________________________________

conv2d_10 (Conv2D) (None, 38, 38, 256) 131072 leaky_re_lu_9[0][0]

__________________________________________________________________________________________________

batch_normalization_10 (BatchNo (None, 38, 38, 256) 1024 conv2d_10[0][0]

__________________________________________________________________________________________________

leaky_re_lu_10 (LeakyReLU) (None, 38, 38, 256) 0 batch_normalization_10[0][0]

__________________________________________________________________________________________________

conv2d_11 (Conv2D) (None, 38, 38, 512) 1179648 leaky_re_lu_10[0][0]

__________________________________________________________________________________________________

batch_normalization_11 (BatchNo (None, 38, 38, 512) 2048 conv2d_11[0][0]

__________________________________________________________________________________________________

leaky_re_lu_11 (LeakyReLU) (None, 38, 38, 512) 0 batch_normalization_11[0][0]

__________________________________________________________________________________________________

conv2d_12 (Conv2D) (None, 38, 38, 256) 131072 leaky_re_lu_11[0][0]

__________________________________________________________________________________________________

batch_normalization_12 (BatchNo (None, 38, 38, 256) 1024 conv2d_12[0][0]

__________________________________________________________________________________________________

leaky_re_lu_12 (LeakyReLU) (None, 38, 38, 256) 0 batch_normalization_12[0][0]

__________________________________________________________________________________________________

conv2d_13 (Conv2D) (None, 38, 38, 512) 1179648 leaky_re_lu_12[0][0]

__________________________________________________________________________________________________

batch_normalization_13 (BatchNo (None, 38, 38, 512) 2048 conv2d_13[0][0]

__________________________________________________________________________________________________

leaky_re_lu_13 (LeakyReLU) (None, 38, 38, 512) 0 batch_normalization_13[0][0]

__________________________________________________________________________________________________

max_pooling2d_5 (MaxPooling2D) (None, 19, 19, 512) 0 leaky_re_lu_13[0][0]

__________________________________________________________________________________________________

conv2d_14 (Conv2D) (None, 19, 19, 1024) 4718592 max_pooling2d_5[0][0]

__________________________________________________________________________________________________

batch_normalization_14 (BatchNo (None, 19, 19, 1024) 4096 conv2d_14[0][0]

__________________________________________________________________________________________________

leaky_re_lu_14 (LeakyReLU) (None, 19, 19, 1024) 0 batch_normalization_14[0][0]

__________________________________________________________________________________________________

conv2d_15 (Conv2D) (None, 19, 19, 512) 524288 leaky_re_lu_14[0][0]

__________________________________________________________________________________________________

batch_normalization_15 (BatchNo (None, 19, 19, 512) 2048 conv2d_15[0][0]

__________________________________________________________________________________________________

leaky_re_lu_15 (LeakyReLU) (None, 19, 19, 512) 0 batch_normalization_15[0][0]

__________________________________________________________________________________________________

conv2d_16 (Conv2D) (None, 19, 19, 1024) 4718592 leaky_re_lu_15[0][0]

__________________________________________________________________________________________________

batch_normalization_16 (BatchNo (None, 19, 19, 1024) 4096 conv2d_16[0][0]

__________________________________________________________________________________________________

leaky_re_lu_16 (LeakyReLU) (None, 19, 19, 1024) 0 batch_normalization_16[0][0]

__________________________________________________________________________________________________

conv2d_17 (Conv2D) (None, 19, 19, 512) 524288 leaky_re_lu_16[0][0]

__________________________________________________________________________________________________

batch_normalization_17 (BatchNo (None, 19, 19, 512) 2048 conv2d_17[0][0]

__________________________________________________________________________________________________

leaky_re_lu_17 (LeakyReLU) (None, 19, 19, 512) 0 batch_normalization_17[0][0]

__________________________________________________________________________________________________

conv2d_18 (Conv2D) (None, 19, 19, 1024) 4718592 leaky_re_lu_17[0][0]

__________________________________________________________________________________________________

batch_normalization_18 (BatchNo (None, 19, 19, 1024) 4096 conv2d_18[0][0]

__________________________________________________________________________________________________

leaky_re_lu_18 (LeakyReLU) (None, 19, 19, 1024) 0 batch_normalization_18[0][0]

__________________________________________________________________________________________________

conv2d_19 (Conv2D) (None, 19, 19, 1024) 9437184 leaky_re_lu_18[0][0]

__________________________________________________________________________________________________

batch_normalization_19 (BatchNo (None, 19, 19, 1024) 4096 conv2d_19[0][0]

__________________________________________________________________________________________________

conv2d_21 (Conv2D) (None, 38, 38, 64) 32768 leaky_re_lu_13[0][0]

__________________________________________________________________________________________________

leaky_re_lu_19 (LeakyReLU) (None, 19, 19, 1024) 0 batch_normalization_19[0][0]

__________________________________________________________________________________________________

batch_normalization_21 (BatchNo (None, 38, 38, 64) 256 conv2d_21[0][0]

__________________________________________________________________________________________________

conv2d_20 (Conv2D) (None, 19, 19, 1024) 9437184 leaky_re_lu_19[0][0]

__________________________________________________________________________________________________

leaky_re_lu_21 (LeakyReLU) (None, 38, 38, 64) 0 batch_normalization_21[0][0]

__________________________________________________________________________________________________

batch_normalization_20 (BatchNo (None, 19, 19, 1024) 4096 conv2d_20[0][0]

__________________________________________________________________________________________________

space_to_depth_x2 (Lambda) (None, 19, 19, 256) 0 leaky_re_lu_21[0][0]

__________________________________________________________________________________________________

leaky_re_lu_20 (LeakyReLU) (None, 19, 19, 1024) 0 batch_normalization_20[0][0]

__________________________________________________________________________________________________

concatenate_1 (Concatenate) (None, 19, 19, 1280) 0 space_to_depth_x2[0][0]

leaky_re_lu_20[0][0]

__________________________________________________________________________________________________

conv2d_22 (Conv2D) (None, 19, 19, 1024) 11796480 concatenate_1[0][0]

__________________________________________________________________________________________________

batch_normalization_22 (BatchNo (None, 19, 19, 1024) 4096 conv2d_22[0][0]

__________________________________________________________________________________________________

leaky_re_lu_22 (LeakyReLU) (None, 19, 19, 1024) 0 batch_normalization_22[0][0]

__________________________________________________________________________________________________

conv2d_23 (Conv2D) (None, 19, 19, 425) 435625 leaky_re_lu_22[0][0]

==================================================================================================

Total params: 50,983,561

Trainable params: 50,962,889

Non-trainable params: 20,672

__________________________________________________________________________________________________请注意:在某些电脑上,可能会看到来自Keras的警告消息,不要担心,这个没有什么问题的。

提示:如图2所示,该模型将预处理的一批输入图像(shape:(m,608,608,3))转换为tensor类型,维度为(m,19,19,5,85)。

3.3 - 将模型的输出转换为边界框

yolo_model的输出是一个(m,19,19,5,85)的tensor变量,它需要进行处理和转换。

yolo_outputs = yolo_head(yolo_model.output, anchors, len(class_names))现在你已经把yolo_outputs添加进了计算图中,这4个tensor变量已准备好用作yolo_eval函数的输入。

3.4 - 过滤锚框

yolo_outputs已经正确的格式为我们提供了yolo_model的所有预测框,我们现在已准备好执行过滤并仅选择最佳的锚框。现在让我们调用之前实现的yolo_eval()

scores, boxes, classes = yolo_eval(yolo_outputs, image_shape)3.5 - 在实际图像中运行计算图

我们之前已经创建了一个用于会话的sess,这里有一些回顾:

yolo_model.input是yolo_model的输入,yolo_model.output是yolo_model的输出。yolo_model.output会让yolo_head进行处理,这个函数最后输出yolo_outputsyolo_outputs会让一个过滤函数yolo_eval进行处理,然后输出预测:scores、 boxes、 classes

现在我们要实现predict()函数,使用它来对图像进行预测,我们需要运行TensorFlow的Session会话,然后在计算图上计算scores、 boxes、 classes,下面的代码可以帮你预处理图像:

`image, image_data = yolo_utils.preprocess_image("images/" + image_file, model_image_size = (608, 608))`

- image:用于绘制框的图像的Python(PIL)表示,这里你不需要使用它。

- image_data:图像的numpy数组,这将是CNN的输入。

请注意!当模型使用BatchNorm(比如YOLO中的情况)时,您需要在feed_dict {K.learning_phase():0}中传递一个额外的占位符。

def predict(sess, image_file, is_show_info=True, is_plot=True):

"""

运行存储在sess的计算图以预测image_file的边界框,打印出预测的图与信息。

参数:

sess - 包含了YOLO计算图的TensorFlow/Keras的会话。

image_file - 存储在images文件夹下的图片名称

返回:

out_scores - tensor类型,维度为(None,),锚框的预测的可能值。

out_boxes - tensor类型,维度为(None,4),包含了锚框位置信息。

out_classes - tensor类型,维度为(None,),锚框的预测的分类索引。

"""

#图像预处理

image, image_data = yolo_utils.preprocess_image("images/" + image_file, model_image_size = (608, 608))

#运行会话并在feed_dict中选择正确的占位符.

out_scores, out_boxes, out_classes = sess.run([scores, boxes, classes], feed_dict = {yolo_model.input:image_data, K.learning_phase(): 0})

#打印预测信息

if is_show_info:

print("在" + str(image_file) + "中找到了" + str(len(out_boxes)) + "个锚框。")

#指定要绘制的边界框的颜色

colors = yolo_utils.generate_colors(class_names)

#在图中绘制边界框

yolo_utils.draw_boxes(image, out_scores, out_boxes, out_classes, class_names, colors)

#保存已经绘制了边界框的图

image.save(os.path.join("out", image_file), quality=100)

#打印出已经绘制了边界框的图

if is_plot:

output_image = scipy.misc.imread(os.path.join("out", image_file))

plt.imshow(output_image)

return out_scores, out_boxes, out_classes我们来实际预测一下:

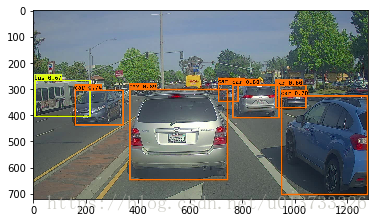

out_scores, out_boxes, out_classes = predict(sess, "test.jpg")执行结果:

在test.jpg中找到了7个锚框。

car 0.60 (925, 285) (1045, 374)

car 0.66 (706, 279) (786, 350)

bus 0.67 (5, 266) (220, 407)

car 0.70 (947, 324) (1280, 705)

car 0.74 (159, 303) (346, 440)

car 0.80 (761, 282) (942, 412)

car 0.89 (367, 300) (745, 648)3.6 - 批量绘制图

我们可以看到在images文件夹中有从”0001.jpg”到”0120.jpg”的图,我们现在就把它们全部绘制出来。

for i in range(1,121):

#计算需要在前面填充几个0

num_fill = int( len("0000") - len(str(1))) + 1

#对索引进行填充

filename = str(i).zfill(num_fill) + ".jpg"

print("当前文件:" + str(filename))

#开始绘制,不打印信息,不绘制图

out_scores, out_boxes, out_classes = predict(sess, filename,is_show_info=False,is_plot=False)

print("绘制完成!")执行结果:

当前文件:0001.jpg

当前文件:0002.jpg

当前文件:0003.jpg

car 0.69 (347, 289) (445, 321)

car 0.70 (230, 307) (317, 354)

car 0.73 (671, 284) (770, 315)

当前文件:0004.jpg

car 0.63 (400, 285) (515, 327)

car 0.66 (95, 297) (227, 342)

car 0.68 (1, 321) (121, 410)

car 0.72 (539, 277) (658, 318)

······我就不拷贝完啦~

当前文件:0116.jpg

traffic light 0.63 (522, 76) (543, 113)

car 0.80 (5, 271) (241, 672)

当前文件:0117.jpg

当前文件:0118.jpg

当前文件:0119.jpg

traffic light 0.61 (1056, 0) (1138, 131)

当前文件:0120.jpg

绘制完成!自己把这些图片合起来做GIF吧~