第一章 计算机系统漫游

计算机系统是由硬件和系统软件组成的, 它们共同工作来运行应用程序。 虽然系统的具体实现方式随着时间不断变化, 但是系统内在的概念却没有改变。 所有计算机系统都有相似的硬件和软件组件, 它们又执行着相似的功能。 一些程序员希望深人了解这些组件是如何工作的以及这些组件是如何影响程序的正确性和性能的, 以此来提高自身的技能。 本书便是为这些读者而写的。

现在就要开始一次有趣的漫游历程了。 如果你全力投身学习本书中的概念, 完全理解底层计算机系统以及它对应用程序的影响, 那么你会步上成为为数不多的 “大牛" 的道路。

你将会学习一些实践技巧, 比如如何避免由计算机表示数字的方式引起的奇怪的数字错误。 你将学会怎样通过一些小窍门来优化自己的C 代码, 以充分利用现代处理器和存储 器系统的设计。 你将了解编译器是如何实现过程调用的, 以及如何利用这些知识来避免缓冲区溢出错误带来的安全漏洞, 这些弱点给网络和因特网软件带来了巨大的麻烦。 你将学 会如何识别和避免链接时那些令人讨厌的错误, 它们困扰着普通的程序员。 你将学会如何编写自己的Unixshell、自己的动态存储分配包,甚至于自己的Web服务器。你会认识并发 带来的希望和陷阱,这个主题随着单个芯片上集成了多个处理器核变得越来越重要。

在Kernighan和Ritchie的关千C编程语言的经典教材[61]中,他们通过图1-1中所示的hello程序来向读者介绍C。尽管hello程序非常简单,但是为了让它实现运行,系 统的每个主要组成部分都需要协调工作。从某种意义上来说,本书的目的就是要帮助你了解当你在系统上执行 hello 程序时, 系统发生了什么以及为什么会这样。

#incude <stdio.h>

int main()

{

printf("hello,world\n");

return 0;

}

图1-1 hello程序

我们通过跟踪hello程序的生命周期来开始对系统的学习–从它被程序员创建开始,到在系统上运行,输出简单的信息,然后终止。我们将沿着这个程序的生命周期,简要地介绍一些逐步出现的关键概念、专业术语和组成部分。后面的章节将围绕这些内容展开。

1.1 信息就是位+上下文

hello程序的生命周期是从一个源程序(或者说源文件)开始的,即程序员通过编辑器创建并保存的文本文件,文件名是hello.c。源程序实际上就是一个由值0和1组成的(又称为比特)序列,8个位被组织成一组,成为字节。每个字节表示程序中的某些文本字符。

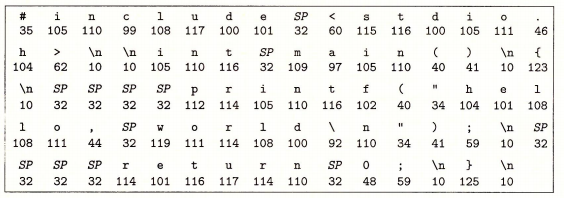

大部分的现代计算机系统都使用ASCII标准来表示文本字符,这种方式实际上就是用一个唯一的单字节大小的整数值气来表示每个字符。 比如, 图1-2中给出了hello.c程序的ASCII码表示。

图1-2 hello.c的ASCII文本表示

hello.c程序是以字节序列的方式储存在文件中的。每个字节都有一个整数值,对应千某些字符。例如, 第一个字节的整数值是 35, 它对应的就是字符 " # " 。 第二个字节的整数值为105, 它对应的字符是 ‘i’’ 依此类推。注意,每个文本行都是以一个看不见的换行符 ‘\n’ 来结束的, 它所对应的整数值为10。 像hello.c这样只由ASCII字符构成的文件称为文本文件, 所有其他文件都称为二进制文件 。

hello.c的表示方法说明了一个基本思想: 系统中所有的信息 包括磁盘文件、 内存中的程序、 内存中存放的用户数据以及网络上传送的数据,都是由一串比特表示的。区分不同数据对象的唯一方法是我们读到这些数据对象时的上下文。 比如,在不同的上下文 中,一个同样的字节序列可能表示一个整数、 浮点数、 字符串或者机器指令。

作为程序员, 我们需要了解数字的机器表示方式, 因为它们与实际的整数和实数是不同的。它们是对真值的有限近似值, 有时候会有意想不到的行为表现。 这方面的基本原理将在第2章中详细描述。

C编程语言的起源 C语言是贝尔实验室的DennisRitchie 于196 9年~1973年间创建的。美国国家标准学 会(American National Standards Institute, ANSI)在1989年颁布了ANSI C的标准,后来 C> 语言的标准化成了国际标准化组织(International Standards Organization, ISO)的责任。这 些标准定义了> C语言和一系列函数库,即所谓的C标准库。Kernighan和凡tchie在他们的 经典著作中描述了ANSI C,> 这本著作被人们满怀感情地称为"K&R" [61]。用凡tchie的话 来说[92], C语言是“古怪的、有缺陷的,但同时也是一个巨大的成功”。为什么会成功呢?

C语言与Unix操作系统关系密切。C从一开始就是作为一种用于Unix系统的程序 语言开发出来的。大部分Unix内核(操作系统的核心部分),以及所有支撑工具和

函数库都是用C语言编写的。20世纪70年代后期到80年代初期,Unix风行于高等院校,许多人开始接触C语言并喜欢上它。因为Unix几乎全部是用C编写的,

它可以很方便地移植到新的机器上,这种特点为C和Unix嬴得了更为广泛的支持。 C语言小而简单。 C语言的设计是由一个人而非一个协会掌控的,

因此这是一个 简洁明了、 没有什么冗赘的设计。 K&.R这本书用大量的例子和练习描述了完整 的C语言及其标准库, 而全书不过261页。

C语言的简单使它相对而言易于学习, 也易于移植到不同的计算机上。 C语言是为实践目的设计的。 C语言是设计用来实现Unix操作系统的。

后来, 其他人发现能够用这门语言无障碍地编写他们想要的程序。 C语言是系统级编 程的首选, 同时它也非常适用于应用级程序的编写。 然而,它也并非适用于所有的程序员和所有的情况。 C语言的指针是造成程序员困惑和程序错误的 一个常见原因。 同时, C语言还缺乏对非常有用的抽象的显式支持, 例如类、 对象和异常。 像C++和Java这样针对应用级程序的新程序语言解决了 这些问题。

1.2 程序被其他程序翻译成不同的格式

被人读懂。 然而, 为了在系统上运行hello.c程序, 每条 C语句都必须被其他程序转化 为一系列的低级机器语言指令。 然后这些指令按照 种称为可执行目标程序的格式打好包, 并以二进制磁盘文件的形式存放起来。 目标程序也称为可执行目标文件。

在Unix系统上, 从源 文件到目标文件的转化是由编译器驱动程序完成的:

linux> gee -o hello hello.e

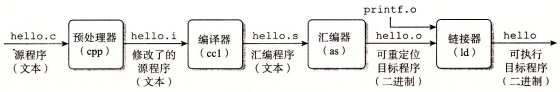

在这里, GCC编译器驱动程序读取源程序文件hello.c, 并把它翻译成 个可执行目标文件hello。 这个翻译过程可分为四个阶段完成, 如图1-3所示。 执行这四个阶段的程序(预处理器、 编译器、 汇编器和链接器)一起构成了编译 系统(compilationsystem)。

图1-3 编译系统

- 预处理阶段。 预处理器(cpp)根据以字符#开头的命令, 修改原始的C程序。 比如 hello.c 中第1行的五nclude <stdio. h>命令告诉预处理器 读取系统头文件是stdio.h的内容, 并把它直接插入程序文本中。 结果就得到了另一个C程序, 通常 是以.i作为文件扩展名。

- 编译阶段。 编译器(ccl)将文本文件hello.i 翻译成文本文件hello.s, 它包含一 个汇编语言程序。 该程序包含函数main的定义, 如下所示:

main:

subq$ 8,%rsp

movl$ LCO,%edi

call puts

movl $0,%eax

addq %8,%rsp

ret

定义中2~7行的每条语句都以一种文本格式描述了一条 低级机器语言 指令。汇编语言是非常有用的, 因为它为不同 高级语言的不同编译器提供了通用的输出语言。 例如,C编译器 和Fortran编译器产生 的输出文件用的都是一样的汇编语言。

- 汇编阶段。 接下来, 汇编器(as)将hello.s翻译成机器语言指令 , 把这些指令 打包成一种叫做可重定位目标程序(relocatable object program) 的格式,并将结果保存在 目标 文件hello.o中。 hello.o文件是一个二进制文件,它包含的 17个字节是函数main 的指令编码。 如果 我们在文本编辑器中打开hello.o文件,将看到一堆乱码。

- 链接阶段。 请注意,he荨o程序 调用了printf函数,它是每个 C编译器都提供的标准C库中的一个函数。 printf函数存在于一个名为printf.o 的单独的预编译好了的目标文件中,而这个文件必须以某种方式合并到我们 的he荨 o.o程序中。 链 接器(Id)就负责处理这种合并 。结果就 得到hello文件, 它是一个可执行目标文件(或者简称为可执行文件) ,可以被加载到内存中, 由系统执行。

GNU项目 GCC是GNU(GNU是GNU’sNot Unix的缩写)项目 开发出来的众多有用工具之 一。 GNU项目是1984年由RichardStallman发起的一个免税的慈善项目 。 该项目的目标非常宏大,就是开发出一个完整的类Unix的系统 ,其源代码能够不受限制地被修改 和传播。 GNU项目 已经 开发出了一个包含Unix操作系统的所有主要部件的环境,但内·核除外,内核是由Linux项目独立发展而来的。 GNU 环境包括EMACS编辑器、 GCC 编译器、 GDB调试器、 汇编器、 链接器、处理二进制文件的工具以及其他一些部件 。 GCC编译器已经发展到支持许多不同的语言 ,能够为许多不同的机器生成代码。 支持 的语言 包括C、C++ 、 Fortran 、Java、 Pascal、 面向对象C 语言(Objective-C )和Ada。

GNU项目取得了非凡的成绩,但是却常常被忽略。 现代开放源 码运动(通常和 Linux联系在一起)的思想起源是GNU项目中自由软件(free software)的概念。(此处的 free 为自由言论(free speech)中的 “自由” 之意,而非 免费啤酒(free beer)中的 “免费” 之意。)而且,Linux如此受欢迎在很大程度上还要归功于GNU 工具,它们给Linux内核提供了环境。

l. 3 了解编译系统如何工作是大有益处的

对千像hello.c 这样简单的程序 ,我们可以依靠编译系统生成正确有效 的机器代码。 但是,有一些 重要 的原因促使程序员必须知道编译系统是如何工作的。

- 优化程序性能。 现代编译器都是成熟的工具,通常可以生成很好的代码。 作为程序员, 我们无须为了写出高效代码而去了解编译器 的内部工作。 但是, 为了在 C程序中做出好的编码选择, 我们确实需要了解 一些机器代码以及编译器将不同的C语旬 转化 为机器代码的方式。 比如,一个swit ch语句是否总是比 一系列的辽-else语旬高效 得多?一个函数调用的开销有多大? while 循环比for循环更有效吗?指针引用比 数组索引更有效吗?为什么将循环求和的结果放到一个本 地变量中,会比将其放到一个 通过引用传递过来的参数中,运行起来快很多呢?为什么 我们只是简单地重新排列一下算术表达式中的括号就能让函数运行得 更快?

在第3章中, 我们将介绍x86-64, 最近几代Linux、Macin tosh和Win dows计算机的机器语言。 我们会讲述编译器 是怎样把不同的C语言结构翻译成这种机器语言的。 在第5章中,你将学习如何通过简单转换C语言代码,帮助编译器 更好地完成工作,从而调 整C程序的性能。已在第6章中,你将学习存储器系统的层次结构特性 ,C语言编译器 如何将数组存放在 内存中, 以及 C程序又是如何能够利用这些知识从而更高效 地运行。 - 理解链接时出现的错误。 根据我们的经验, 一些最令人困扰的程序错误往往都与链 接器操作有关, 尤其是当你试图构建大型的软件系统时。 比如, 链接器报告说它无法解析一个引用, 这是什么意思?静态变量和全局变撮的区别是什么?如果你在不 同的C文件中定义了名字相同的两个全局变量会发生什么?静态库和动态库的区别是什么?我们在命令行上排列库的顺序有什么影响?最严重的是, 为什么有些链接 错误直到运行时才会出现?在第7章中, 你将得到这些问题的答案。

- 避免安全扁洞。 多年来, 缓冲区溢出错误是造成大多数网络和Internet服务器上安 全漏洞的主要原因。 存在这些错误是因为很少有程序员能够理解需要限制从不受信任的源接收数据的数量和格式。 学习安全编程的第一步就是理解数据和控制信息存储在程序栈上的方式会引起的后果。 作为学习汇编语言的一部分, 我们将在第3章 中描述堆栈原理和缓冲区溢出错误。 我们还将学习程序员、 编译器和操作系统可以用来降低攻击威胁的方法。

1.4 处理器读并解释储存在内存中的指令

此刻, hello.c源程序已经被编译系统翻译成了可执行目标文件hello, 并被存放在磁盘上。 要想在Unix系统上运行该可执行文件, 我们将它的文件名输入到称为shell的应用程序中:

linux> ./hello hello,world linux>

shell是一个命令行解释器, 它输出一个提示符, 等待输入一个命令行, 然后执行这个命令。 如果该命令行的第一个单词不是一个内置的shell命令, 那么shell就会假设这是一个可执行文件的名字, 它将加载并运行这个文件。 所以在此例中, shell将加载并运行 hello程序, 然后等待程序终止。 hello程序在屏幕上输出它的消息, 然后终止。 shell 随后输出一个提示符, 等待下一个输入的命令行。

1.4.1 系统的硬件组成

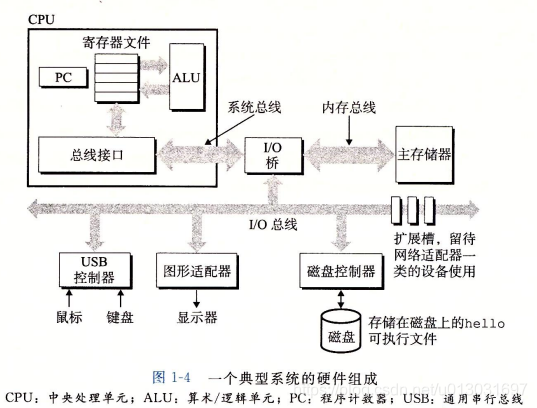

为了理解运行hello程序时发生了什么, 我们需要了解一个典型系统的硬件组织, 如图1-4所示。 这张图是近期Intel系统产品族的模型, 但是所有其他系统也有相同的外观和特性。 现在不要担心这张图很复杂 我们将在本书分阶段对其进行详尽的介绍。

1. 总线

贯穿整个系统的是一组电子管道, 称作总线, 它携带信息字节并负责在各个部件间传递。 通常总线被设计成传送定长的字节块, 也就是宇 (word)。字中的字节数(即字长)是一 个基本的系统参数, 各个系统中都不尽相同。 现在的大多数机器字长要么是 4 个字节(32位), 要么是 8 个字节(64 位)。 本书中, 我们不对字长做任何固定的假设。 相反, 我们将 在需要明确定义的上下文中具体说明一个 ”字” 是多大。

2. 1/0设备

I/0(输入/输出)设备是系统与外部世界的联系通道。 我们的示例系统包括四个 I/0 设备:作为用户输入的键盘和鼠标, 作为用户输出的显示器, 以及用千长期存储数据和程序的磁盘驱动器(简单地说就是磁盘)。 最开始, 可执行程序hello就存放在磁盘上。每个 I/0 设备都通过一个控制器或适配器与 I/0 总线相连。 控制器和适配器之间的区别主要在千它们的封装方式。 控制器是1/0设备本身或者系统的主印制电路板(通常称作 主板)上的芯片组。 而适配器则是一块插在主板插槽上的卡。 无论如何, 它们的功能都是在1/0总线和1/0设备之间传递信息。

第6章会更多地说明磁盘之类的1/0设备是如何工作的。 在第10章中, 你将学习如何在应用程序中利用Unix 1/0接口访问设备。 我们将特别关注网络类设备, 不过这些技术对于其他设备来说也是通用的。

3.主存

主存是一个临时存储设备, 在处理器执行程序时, 用来存放程序和程序处理的数据。 从物理上来说, 主存是由一组动态随机存取存储器(DRAM)芯片组成的。 从逻辑上来说, 存储器是一个线性的字节数组, 每个字节都有其唯一的地址(数组索引), 这些地址是从零开始的。 一般来说, 组成程序的每条机器指令都由不同数量的字节构成。 与 C 程序变量相对应的数据项的大小是根据类型变化的。 比如, 在运行Linux 的x86-64机器上, short类型的数据需要2个字节, int和float类型需要4个字节, 而long和double类型需要8个字节。

第6章将具体介绍存储器技术, 比如 DRAM 芯片是如何工作的, 它们又是如何组合起来构成主存的。

4.处理器

中央处理单元(CPU),简称处理器,是解释(或执行)存储在主存中指令的引擎。处理器的核心是一个大小为一个字的存储设备(或寄存器),称为程序计数器(PC)。在任何时刻,PC都指向主存中的某条机器语言指令(即含有该条指令的地址)。

从系统通电开始, 直到系统断电, 处理器一直在不断地执行程序计数器指向的指令,再更新程序计数器, 使其指向下一条指令。 处理器看上去是按照一个非常简单的指令执行模型来操作的, 这个模型是由指令集架构决定的。 在这个模型中, 指令按照严格的顺序执行, 而执行一条指令包含执行一系列的步骤。 处理器从程序计数器指向的内存处读取指令,解释指令中的位, 执行该指令指示的简单操作, 然后更新PC, 使其指向下一条指令,而这条指令并不一定和在内存中刚刚执行的指令相邻。

这样的简单操作并不多,它们围绕着主存、寄存器文件(registerfile)和算术/逻辑单元(ALU)进行。 寄存器文件是一个小的存储设备, 由一些单个字长的寄存器组成, 每个寄存器都有唯一的名字。 ALU计算新的数据和地址值。 下面是一些简单操作的例子,CPU在指令的要求下可能会执行这些操作。

·

- 加载:从主存复制一个字节或者一个字到寄存器, 以覆盖寄存器原来的内容。

- ·存储: 从寄存器复制一个字节或者一个字到主存的某个位置, 以覆盖这个位置上原来的内容。

- 操作: 把两个寄存器的内容复制到ALU, ALU对这两个字做算术运算, 并将结果 存放到一个寄存器中, 以覆盖该寄存器中原来的内容。

- 跳转: 从指令本身中抽取一个字, 并将这个字复制到程序计数器(PC)中, 以覆盖PC中原来的值。

处理器看上去是它的指令集架构的简单实现, 但是实际上现代处理器使用了非常复杂 的机制来加速程序的执行。 因此, 我们将处理器的指令集架构和处理器的微体系结构区分开来: 指令集架构描述的是每条机器代码指令的效果;而微体系结构描述的是处理器实际上是如何实现的。 在第3章研究机器代码时, 我们考虑的是机器的指令集架构所提供的抽象性。 第4章将更详细地介绍处理器实际上是如何实现的。 第5章用一个模型说明现代处理器是如何工作的, 从而能预测和优化机器语言程序的性能。

1.4. 2 运行hello程序

前面简单描述了系统的硬件组成和操作, 现在开始介绍当我们运行示例程序时到底发生了些什么。 在这里必须省略很多细节, 稍后会做补充, 但是现在我们将很满意于这种整 体上的描述。

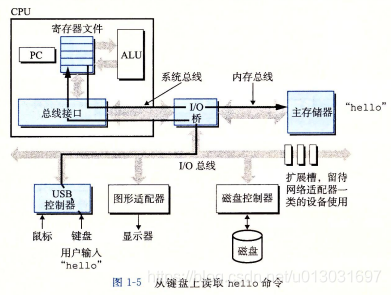

初始时, shell程序执行它的指令, 等待我们输入一个命令。 当我们在键盘上输入字符串 "./hello"后, shell程序将字符逐一读入寄存器, 再把它存放到内存中, 如图1-5所示。

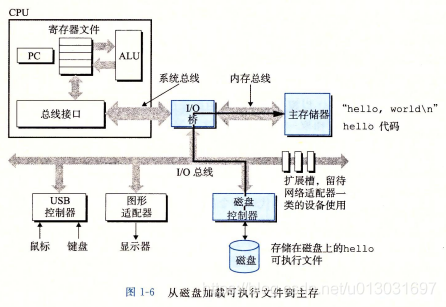

当我们在键盘上敲回车键时, shell程序就知道我们已经结束了命令的输入。 然后 shell执行一系列指令来加载可执行的hello文件, 这些指令将hello目标文件中的代码和数据从磁盘复制到主存。 数据包括最终会被输出的字符串 “hello, world\n”。

利用直接存储器存取CDMA, 将在第6章中讨论)技术, 数据可以不通过处理器而直 接从磁盘到达主存。 这个步骤如图1-6所示。

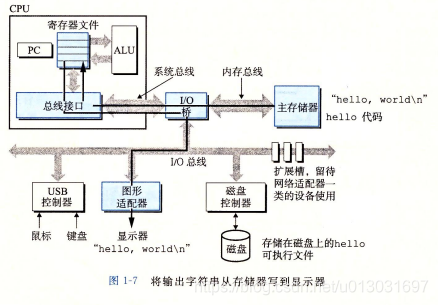

一旦目标文件hello中的代码和数据被加载到主存, 处理器就开始执行hello程序的main程序中的机器语言指令。 这些指令将 “hello, world\n” 字符串中的字节从主存复制到寄存器文件, 再从寄存器文件中复制到显示设备, 最终显示在屏幕上。 这个步骤如 图1-7所示。

1.5 高速缓存至关重要

这个简单的示例揭平了一个重要的问题, 即系统花费了大量的时间把信息从一个地方挪到另一个地方。 hello 程序的机器指令最初是存放在磁盘上, 当程序加载时, 它们被复制到主存;当处理器运行程序时, 指令又从主存复制到处理器。 相似地, 数据串 “hel?lo, world/n” 开始时在磁盘上, 然后被复制到主存, 最后从主存上复制到显示设备。 从 程序员的角度来看, 这些复制就是开销, 减慢了程序 “真正” 的工作。 因此, 系统设计者的一个主要目标就是使这些复制操作尽可能快地完成。

根据机械原理, 较大的存储设备要比较小的存储设备运行得慢, 而快速设备的造价远高于同类的低速设备。 比如说, 一个典型系统上的磁盘驱动器可能比主存大 1000 倍, 但是对处理器而言, 从磁盘驱动器上读取一个字的时间开销要比从主存中读取的开销大 1000 万倍。

类似地, 一个典型的寄存器文件只存储几百字节的信息, 而主存里可存放几十亿字 节。然而, 处理器从寄存器文件中读数据比从主存中读取几乎要快 100 倍。 更麻烦的是, 随着这些年半导体技术的进步, 这种处理器与主存之间的差距还在持续增大。加快处理器 的运行速度比加快主存的运行速度要容易和便宜得多。

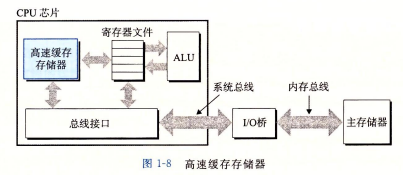

针对这种处理器与主存之间的差异, 系统设计者采用了更小更快的存储设备, 称为高 速缓存存储器(cache memory, 简称为 cache 或高速缓存), 作为暂时的集结区域, 存放处 理器近期可能会需要的信息。 图1-8展示了一个典型系统中的高速缓存存储器。 位千处理 器芯片上的Ll高速缓存的容量可以达到数万字节, 访问速度几乎和访问寄存器文件一样快。 一个容量为数十万到数百万字节的更大的L2高速缓存通过一条特殊的总线连接到处 理器。 进程访问L2高速缓存的时间要比访问Ll高速缓存的时间长5倍, 但是这仍然比访问主存的时间快 5~10 倍。Ll和L2高速缓存是用一种叫做静态随机访问存储器(SRAM)的硬件技术实现的。 比较新的 、处理能力更强大的系统甚至有三级高速缓存: Ll、L2和L3。系统可以获得一个很大的存储器, 同时访问速度也很快, 原因是利用了高速缓存的局部性原理, 即程序具有访问局部区域里的数据和代码的趋势。通过让高速缓存里存放可能经常访问的数据, 大部分的内存操作都能在快速的高速缓存中完成。

本书得出的重要结论之一就是, 意识到高速缓存存储器存在的应用程序员能够利用高速缓存将程序的性能提高一个数量级。 你将在第 6 章里学习这些重要的设备以及如何利用它们。

1.6 存储设备形成层次结构

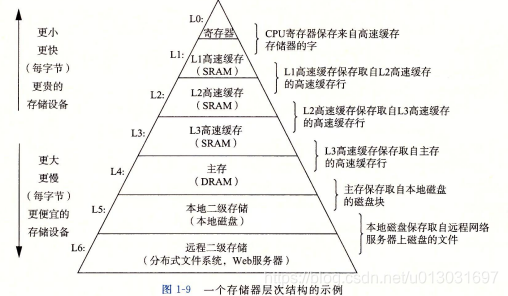

在处理器和一个较大较慢的设备(例如主存)之间插入一个更小更快的存储设备(例如高速缓存)的想法已经成为一个普遍的观念。 实际上, 每个计算机系统中的存储设备都被组织成了 个存储器层次结构,如图1-9所示。在这个层次结构中,从上至下, 设备的访问速度越来越慢、容最越来越大,并且每字节的造价也越来越便宜。寄存器文件在层次结 构中位于最顶部,也就是第0级或记为LO。这里我们展示的是三层高速缓存Ll到L3,占据存储器层次结构的第1层到第3层。主存在第4层,以此类推。

存储器层次结构的主要思想是上一层的存储器作为低一层存储器的高速缓存。因此,寄存器文件就是Ll的高速缓存,Ll是L2的高速缓存,L2是L3的高速缓存,L3是主存 的高速缓存,而主存又是磁盘的高速缓存。在某些具有分布式文件系统的网络系统中,本 地磁盘就是存储在其他系统中磁盘上的数据的高速缓存。

正如可以运用不同的高速缓存的知识来提高程序性能 样,程序员同样可以利用 对整个存储器层次结构的理解来提高程序性能。第6章将更详细地讨论这个问题。

1.7 操作系统管理硬件

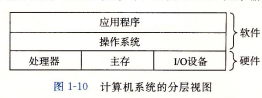

让我们回到hello程序的例子。当shell加载和运行hello程序时,以及hello程序输出自己的消息时,shell和hello程序都没有直接访问键盘、显示器、磁盘或者主存。取而 代之的是,它们依靠操作系统提供的服务。我们可以把操作系统看成是应用程序和硬件之间插入的一层软件,如图1-10所示。所有应用程序对硬件的操作尝试都必须通过操作系统。

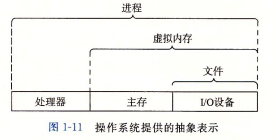

操作系统有两个基本功能: (1)防止硬件被失控的应用程序滥用; (2)向应用程序提供简单 致的机制来控制复杂而又通常大不相同的低级硬件设备。操作系统通过几个基本的抽象概念(进程、虚拟内存和文件)来实现这两个功能。如图1-11所示, 文件是对I/0 设备的抽象表示,虚拟内存是对主存和磁盘 I/0 设备的抽象表示, 进程则是对处理器、 主存和I/0 设备的抽象表示。 我们将依次讨论每种抽象表示。

Unix、 Posix和标准Unix规范 20世纪 60年代是大型、> 复杂操作系统盛行的年代,比如IBM的OS/360和Honey?well的Multics系统。 OS/360是历史上最成功的软件项目 之 一,而Multics虽然持续存 在了多 年,却从来没有被广泛应用过 。贝尔实验室曾经是Multics项目的最初参与者,但是因为考虑到该项目的复杂性和缺乏进展而于1969年退出。 鉴于Mutics项目不愉快的经历,一群贝尔实验室的研究人员 Ken Thompson 、 Dennis Ritch比、 Doug Mell?roy和Joe

Ossanna, 从1969年开始在DEC PDP-7计算机上完全用机器语言编写了一个简单得多的操作系统。这个新系统中的很多思想,比如层次文件系统、 作为用户级进程 的shell概念,都是来自于Multics, 只不过在一个更小、更简单的程序包里实现。 1970年,Brian Kernighan给新系统命名为 “Unix”, 这也 是一个双关语,暗指 "Multics"的 复杂性 。 1973年用C重新编写其内核,1974年,Unix 开始正式对外发布[93]。

贝尔实验室以慷慨的条件向学校提供源代码,所以Unix在大专院校里荻得了很多支持并得以持续发展 。 最有影响的工作发生在20世纪70年代晚期到80年代早期,在 美国加州大学伯克利分校,研究人员在一系列发布版本中增加了虚拟内存和 Internet协议,称为Unix 4.xBSD(Berkeley Software Distribution)。 与此同时,贝尔实验室也在 发布自己的版本,称为System V Unix 。 其他厂商的版本,比如Sun Microsystems的 Solaris系统,则是从这些原始的BSD和System V版本中衍生而来。

20世纪80年代中期,Unix厂商试图通过加入新的、往往不兼容的特性 来使它们的 程序 与众不同,麻烦也 就随之而来了。 为了阻止这种趋势,IEEE(电气和电子工程师协会)开始努力标准化Unix的开发,后来由Richard Stallman 命名为 “Posix”。 结果就得 到了一系列的标准,称 作 Posix 标准。 这套标准涵盖了很多方面,比如Unix系统调用 的C语言接口、 shell 程序和工具、 线程及网络编程。 最近,一个被称为 “ 标准Unix规范” 的独立标准化工作已经与Posix

一起创建了统一的Unix系统标准。 这些标准化工作的结果是Unix 版本之间的差异已经基本消失。

1.7.1 进程

像hello这样的程序在现代系统上运行时,操作系统会提供一种假象,就好像系统上只有这个程序在运行。 程序看上去是独占地使用处理器、 主存和I/0 设备。 处理器看上去就像 在不间断地一条接一条地执行程序中的指令,即该程序的代码和数据是系统内存中唯一 的对象。 这些假象是通过进程的概念来实现的,进程是计算机科学中最重要和最成功的概念之一 。

进程是操作系统对一 个正在运行的程序的一 种抽象。 在一 个系统上可以同时运行多个 进程,而每个进程都好像在独占地使用硬件。 而并发运行 ,则是说一 个进程的指令和另 一 个进程的指令是交错执行的。 在大多数系统中,需要运行的进程数是多千可以 运行它们的CPU 个数的。 传统系统在一 个时刻只能执行一 个程序,而先进的多核处理器同时能够执 行多个程序。 无论是在单核还是多核系统中,一 个CPU 看上去都像是在并发地执行多个 进程,这是通过处理器在进程间切换来实现的。 操作系统实现这种交错执行的机制称为上下文切换。 为了简化讨论,我们只考虑包含一 个CPU 的单处理器系统的情况。 我们会在 1. 9. 2节中讨论多处理器 系统。

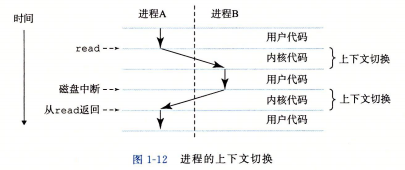

操作系统保持跟踪进程运行所需的所有状态信息。这种状态,也就是上下文,包括许多信息,比如PC和寄存器文件的当前值,以及主存的内容。在任何一个时刻,单处理器系统都只能执行 个进程的代码。当操作系统决定要把控制权从当前进程转移到某个新进程时,就会进行上下文切换,即保存当前进程的上下文、恢复新进程的上下文,然后将控制权传递到新进程。新进程就会从它上次停止的地方开始。图 1-12 展示了示例 hello 程序运行场景的基本理念。

示例场景中有两个并发的进程: shell 进程和 hello 进程。最开始,只有 shell 进程在运行,即等待命令行上的输入。当我们让它运行 hello 程序时,shell 通过调用 个专门的函数,即系统调用,来执行我们的请求,系统调用会将控制权传递给操作系统。操作系统保存 shell 进程的上下文,创建一个新的 he荨o 进程及其上下文,然后将控制权传给新的hello进程。hello进程终止后,操作系统恢复shell进程的上下文,并将控制权传回给它,shell进程会继续等待下一个命令输入。

如图 1-12 所示,从一个进程到另一个进程的转换是由操作系统内核 (kernel) 管理的。内核是操作系统代码常驻主存的部分。当应用程序需要操作系统的某些操作时,比如读写文件,它就执行一条特殊的系统调用 (system call) 指令,将控制权传递给内核。然后内核 执行被请求的操作并返回应用程序。注意,内核不是 个独立的进程。相反,它是系统管理全部进程所用代码和数据结构的集合。

实现进程这个抽象概念需要低级硬件和操作系统软件之间的紧密合作。我们将在第8 章中揭示这项工作的原理,以及应用程序是如何创建和控制它们的进程的。

1.7.2 线程

尽管通常我们认为一个进程只有单 的控制流,但是在现代系统中, 个进程实际上可以由多个称为线程的执行单元组成,每个线程都运行在进程的上下文中,并共享同样的代码和全局数据。由于网络服务器中对并行处理的需求,线程成为越来越重要的编程模型,因为多线程之间比多进程之间更容易共享数据,也因为线程一般来说都比进程更高效。当有多处理器可用的时候,多线程也是一种使得程序可以运行得更快的方法,我们将在1. 9. 2 节中讨论这个问题。在第 12 章中,你将学习并发的基本概念,包括如何写线程化的程序。

1.7.3虚拟内存

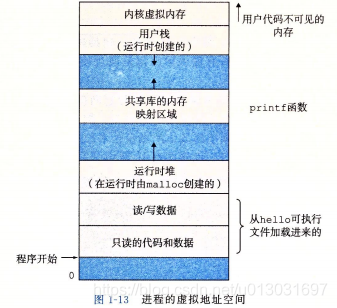

虚拟内存是一个抽象概念,他为每个进程提供了一个假象,即每个进程都在独占地使用主存。每个进程看到的内存都是一致的,称为虚拟地址空间。图1-13所示的是Linux进程的虚拟地址空间(其他 Unix 系统的设计也与此类似)。 在 Linux 中, 地址空间最上面的区域是保留给操作系统中的代码和数据的, 这对所有进程来说都是一样。 地址空间的底部区域存放 用户进程定义的代码和数据。 请注意, 图中的地址是从下往上增大的。

每个进程看到的虚拟地址空间由大量准确定义的区构成, 每个区都有专门的功能。 在本书的后续章节你将学到更多有关这些区的知识, 但是先简单了解每一个区是非常有益 的。 我们从最低的地址开始, 逐步向上介绍。

- 程序代码和数据。 对所有的进程来说, 代码是从同一 固定地址开始, 紧接着的是和C全局变量相对应的数据位置。 代码和数据区是直接按照可执行目标文件的内容初始化的, 在示例中就是可执行文件hello。 在第7章我们研究链接和加载时, 你会学习更多有关地址空间的内容。

- 堆。 代码和数据区后紧随着的是运行时堆。 代码和数据区在进程一开始运行时就被指定了大小, 与此不同, 当调用像malloc和free这样的C标准库函数时, 堆可 以在运行时动态地扩展和收缩。 在第9章学习管理虚拟内存时, 我们将更详细地研究堆。

- 共享库。 大约在地址空间的中间部分是一块用来存放像C标准库和数学库这样的共 享库的代码和数据的区域。 共享库的概念非常强大, 也相当难懂。 在第7章介绍动态链接时, 将学习共享库是如何工作的。

- 栈。 位于用户虚拟地址空间顶部的是用户栈, 编译器用它来实现函数调用。 和堆一样, 用户栈在程序执行期间可以动态地扩展和收缩。 特别地, 每次我们调用一个函 数时, 栈就会增长;从一个函数返回时, 栈就会收缩。 在第3章中将学习编译器是如何使用栈的。

- 内核虚拟内存。 地址空间顶部的区域是为内核保留的。 不允许应用程序读写这个区域的内容或者直接调用内核代码定义的函数。 相反, 它们必须调用内核来执行这些操作。

虚拟内存的运作需要硬件和操作系统软件之间精密复杂的交互, 包括对处理器生成的每一个地址的硬件翻译。 基本思想是把 个进程虚拟内存的内容存储在磁盘上, 然后用主存作为磁盘的高速缓存。 第9章将解释它如何工作, 以及为什么对现代系统的运行如此重要。

1.7.4 文件

文件就是字节序列, 仅此而已。 每个I/0设备, 包括磁盘、 键盘、 显示器, 甚至网络, 都可以看成是文件。 系统中的所有输入输出都是通过使用一小组称为UnixI/0 的系统函数调用读写文件来实现的。

文件这个简单而精致的概念是非常强大的, 因为它向应用程序提供了一个统一的视图, 来看待系统中可能含有的所有各式各样的I/0设备。 例如, 处理磁盘文件内容的应用程序员可以非常幸福, 因为他们无须了解具体的磁盘技术。 进一步说,同一份程序可以在使用不同磁盘技术的不同系统上运行。 你将在第10章中学习UnixI/0。

Linux项目 1991年8月, 芬兰研究生Linus Torvalds谨慎地发布了一 个新的类Unix的操作系统内核, 内容如下。

来自:torvalds@klaava. Helsinki. FI(Linus Benedict Torvalds) 新闻组: comp.

os. minix 主题:在minix中你最想看到什么?

摘要:关于我的新操作系统的小调查 时间:1991 年 8

月25日20:57:08GMT 每个使用minix的朋友, 你们好。

我正在做一个(免费的)用在386(486)AT上的操作系统(只是业余爱好, 它不会像GNU那样庞大和专业)。 这个想法自4 月份就开始酝酿, 现在快要完成了。 我希望得到各位对minix的任何反馈意见, 因为我的操作系统在某些方面与它相类似(其中包括相 同的文件系统的物理设计(因为某些实际的原因))。 我现在巳经移植了bash(l.08)和gcc(l.40), 并且看上去能运行。这意味着我需要 几个月的时间来让它变得更实用一些, 并且, 我想要知道大多数人想要什么特性。 欢迎任何建议, 但是我无法保证我能实现它们。:-)

Linus ([email protected])

就像Torvalds所说的,

他创建Linux的起点是Minix, 由Andrew S. Tanenbaum出于教育目的开发的一个操作系统[113] 。 接下未, 如他们所说, 这就成了历史。Linux逐渐发展成为一个技术和文化现象。 通过和GNU 项目的力量结合, Linux项目发展成了一个完整的、 符合Posix标准的 Unix操作系统的版本, 包括内核和所有支撑的基础设施。 从手持设备到大型计算机, Linux在范围如此广泛的计算机上得到了应用。 IBM 的一个工作组甚至把Linux移植到 了一块腕表中!

1.8 系统之间利用网络通信

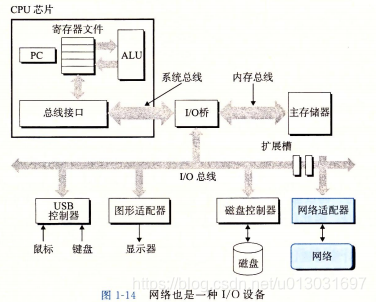

系统漫游至此, 我们一直是把系统视为一个孤立的硬件和软件的集合体。 实际上, 现代系统经常通过网络和其他系统连接到一起。 从一个单独的系统来看,网络可视为一个I/0 设备,如图 1-14 所示。当系统从主存复制一串字节到网络适配器时,数据流经过网络 到达另一台机器,而不是比如说到达本地磁盘驱动器。相似地, 系统可以读取从其他机器发送来的数据,并把数据复制到自己的主存。

随着Internet这样的全球网络的出现,从一台主机复制信息到另外一台主机已经成为计算机系统最重要的用途之一。比如,像电子邮件、即时通信、万维网、FTP和telnet这样的应用都是基于网络复制信息的功能。

回到hello示例,我们可以使用熟悉的telnet应用在一个远程主机上运行hello程序。.假设用本地主机上的telnet客户端连接远程主机上的telnet服务器。 在我们登录到远 程主机并运行shell 后,远端的shell 就在等待接收输入命令。此后在远端运行hello程序包括如图 1-15 所示的五个基本步骤。

当我们在telnet客户端键入"hello"字符串并敲下回车键后,客户端软件就会将这个字符串发送到telnet的服务器。telnet服务器从网络上接收到这个字符串后,会把它传递给远端shell 程序。 接下来,远端shell 运行hello程序,并将输出行返回给telnet服务 器。 最后,telnet服务器通过网络把输出串转发给telnet客户端,客户端就将输出串输出到我们的本地终端上。

这种客户端和服务器之间交互的类型在所有的网络应用中是非常典型的。在第11章 中,你将学会如何构造网络应用程序,并利用这些知识创建一个简单的Web服务器。

1.9 重要主题

在此,小结一下我们旋风式的系统漫游,这次讨论得出一个很重要的观点,那就是系统不仅仅只是硬件。系统是硬件和系统软件互相交织的集合体,它们必须共同协作以达到运行应用程序的最终目的。本书的余下部分会讲述硬件和软件的详细内容,通过了解这些详细内容,你可以写出更快速、更可靠和更安全的程序。

作为本章的结束,我们在此强调几个贯穿计算机系统所有方面的重要概念。我们会在本书中的多处讨论这些概念的重要性。

1. 9. 1 Amdahl定律

Gene Amdahl, 计算领域的早期先锋之一,对提升系统某一部分性能所带来的效果做出了简单却有见地的观察。这个观察被称为Amdahl定律(Amdahl’s law)。该定律的主要思想是,当我们对系统的某个部分加速时,其对系统整体性能的影响取决于该部分的重要性和加速程度。若系统执行某应用程序需要时间为Told。假设系统某部分所需执行时间与该时间的比例为a, 而该部分性能提升比例为K。即该部分初始所需时间为aTold, 现在所需时间为(aTold)/k。因此,总的执行时间为

由此,可以计算出加速比为S=Told/Tnew为

举个例子,考虑这样一种情况,系统某个部分初始耗时比例为60%(a=0.6), 其加速比例因子为3(k=3)。则我们可以获得的加速比为1/[0. 4+0. 6/3] =1. 67倍。虽然我们对系统的 一个主要部分做出了重大改进,但是获得的系统加速比却明显小千这部分的加速比。这就是Amdahl 定律的主要观点——要想显著加速整个系统,必须提升全系统中相当大的部分的速度。

表示相对性能

性能提升最好的表示方法就是用比例的形式Tld/T , 其中,Tld为原始系统所需时间,T为修改后的系统所需时间。如果有所改进,则比值应大于1。我们用后缀new"X"来表示比例,因此,"2. 2X"读作"2. 2倍。

表示相对变化更传统的方法是用百分比,这种方法适用于变化小的情况,但其定义 是模糊的。应该等于100? (T ld -T ) /T , 还是100? (T ld )/T ld, 还是其他的值?此外,它对较大的 变化也没有太大意义。与简单地说性能提升2. 2X相比,“性能 提升了120%"更难理解。

- 练习题1. 1 假设你是个卡车司机,要将土豆从爱达荷州的Boise运送到明尼苏达州 的Minneapolis,

全程2500公里。在限速范围内,你估计平均速度为100公里/小时,整个行程需要25个小时。

A. 你听到新闻说蒙大拿州刚刚取消了限速,这使得行程中有1500公里卡车的速度可 以为150公里/小时。那么这对整个行程的加速比是 多少?

B. 你可以在www. fasttrucks. com网站上为自己的卡车买个新的涡轮增压器。网站现

货供应各种型号,不过速度越快,价格越高。如果想要让整个行程的加速比为- 67 X, 那么你必须以多快的速度通过蒙大拿州?

练习题1. 2 公司的市场部向你的客户承诺, 下一个版本的软件性能将改进2X。 这项任务被分配给你。 你巳经确认只有80%的系统能够被改进, 那么, 这部分需要被改进多少(即k取何值)才能达到整体性能目标?

Amdahl 定律一个有趣的特殊情况是考虑 k 趋向千~时的效果。 这就意味着, 我们可以取系统的某一部分将其加速到一个点, 在这个点上, 这部分花费的时间可以忽略不计。 千是我们得到

举个例子, 如果60%的系统能够加速到不花时间的程度, 我们获得的净加速比将仍只有 1/0. 4=2. 5 X。

Amdahl 定律描述了改善任何过程的一般原则。 除了可以用在加速计算机系统方面之外, 它还可以用在公司试图降低刀片制造成本, 或学生想要提高自己的绩点平均值等方 面。 也许它在计算机世界里是最有意义的, 在这里我们常常把性能提升 2 倍或更高的比例因子。 这么高的比例因子只有通过优化系统的大部分组件才能获得。

1. 9. 2 井发和并行

数字计算机的整个历史中, 有两个需求是驱动进步的持续动力:一个是我们想要计算机做得更多, 另一个是我们想要计算机运行得更快。 当处理器能够同时做更多的事情时, 这两个因素都会改进。 我们用的术语并发(concurrency)是一个通用的概念, 指一个同时具 有多个活动的系统;而术语并行 (parallelism) 指的是用并发来使一个系统运行得更快。 并 行可以在计算机系统的多个抽象层次上运用。 在此, 我们按照系统层次结构中由高到低的 顺序重点强调三个层次。

1.线程级并发

构建在进程这个抽象之上, 我们能够设计出同时有多个程序执行的系统, 这就导致了 并发。 使用线程, 我们甚至能够在一个进程中执行多个控制流。 自 20 世纪 60 年代初期出现时间共享以来, 计算机系统中就开始有了对并发执行的支持。 传统意义上, 这种并发执 行只是模拟出来的, 是通过使一台计算机在它正在执行的进程间快速切换来实现的, 就好像一个杂耍艺人保持多个球在空中飞舞一样。 这种并发形式允许多个用户同时与系统交互, 例如, 当许多人想要从一个Web服务器获取页面时。 它还允许一个用户同时从事多 个任务, 例如, 在一个窗口中开启Web浏览器, 在另 一窗口中运行字处理器, 同时又播放音乐。 在以前, 即使处理器必须在多个任务间切换, 大多数实际的计算也都是由一个处理器来完成的。 这种配置称为单处理器系统。

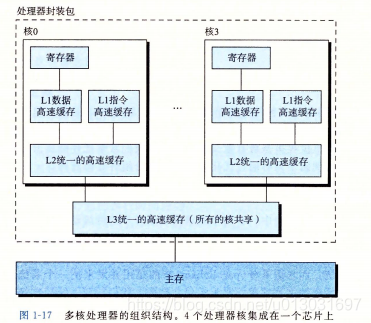

当构建一个由单操作系统内核控制的多处理多处理器器组成的系统时, 我们就得到了一个多处理器系统。 其实从 20 世纪 80 年代开始, 在大规模的计算中就有了这种系统, 但是直到最近, 随着多核 处理器和超线程 (hyperthreading) 的出现, 这种 系统才变得常见。 图 1-16 给出了这些不同处理器类型的分类。多核处理器是将多个CPU(称为 “核")集成到一个集成电路芯片上。 图 1-17 描述的是一个典型多核处理器的组织结构, 其中微处理器芯片有4个CPU核, 每个核都有自己的Ll和 LZ高速缓存, 其中的Ll高速缓存分为两个部分 一个保存最近取到的指令, 另 一个存放数据。 这些核共享更高层次的高速缓存, 以及到主存的接口。 工业界的专家预言他们能够将几十个、 最终会是上百个核做到一个芯片上。

超线程, 有时称为同时多线程(simultaneous multi-threading), 是一项允许 一执行多个控制流的技术。 它涉及CPU某些硬件有多个备份, 比如程序计数器和寄存器文件, 而其他的硬件部分只有 份, 比如执行浮点算术运算的单元。 常规的处理器需要大约20 000个时钟周期做不同线程间的转换, 而超线程的处理器可以在单个周期的基础上决定要执行哪一个线程。 这使得CPU能够更好地利用它的处理资源。 比如, 假设一个线程必须等到某些数据被装载到高速缓存中, 那CPU就可以继续去执行另一个线程。 举例来说,Intel Core i7处理器可以让每个核执行两个线程, 所以一个4核的系统实际上可以并行地执行 8个线程。

.多处理器的使用可以从两方面提高系统性能。 首先, 它减少了在执行多个任务时模拟 并发的需要。 正如前面提到的, 即使是只有一个用户使用的个人计算机也需要并发地执行多个活动。 其次, 它可以使应用程序运行得更快, 当然, 这必须要求程序是以多线程方式来书写的, 这些线程可以并行地高效执行。 因此, 虽然并发原理的形成和研究已经超过50年的时间了, 但是多核和超线程系统的出现才极大地激发了一种愿望, 即找到书写应用程序的方法利用硬件开发线程级并行性。 第12章会更深入地探讨并发, 以及使用并发来提供处理器资源的共享, 使程序的执行允许有更多的并行。

2. 指令级井行

在较低的抽象层次上, 现代处理器可以同时执行多条指令的属性称为指令级并行。 早期的微处理器, 如1978年的Intel 8086, 需要多个(通常是3~10个)时钟周期来执行一条期的微处理器, 如1978年的Intel 8086, 需要多个(通常是3~10个)时钟周期来执行从开始到结束需要长得多的时间, 大约 20 个或者更多周期, 但是处理器使用了非常多的聪明技巧来同时处理多达 100 条指令。 在第 4 章中, 我们会研究流水线 (pipelining)的使用。 在流水线中,将执行一步骤。这些阶段可并行地操作,用来处理不同指令的不同部分。我们会看到一个相当简单的硬件设计,它能够达到接近一个时钟周期一条指令的执行速率。

如果处理器可以达到比一个周期一条指令更快的执行速率, 就称之为超标量 (super?scalar)处理器。 大多数现代处理器都支持超标最操作。 第5章中, 我们将描述超标量处理 器的高级模型。 应用程序员可以用这个模型来理解程序的性能。 然后, 他们就能写出拥有 更高程度的指令级并行性的程序代码, 因而也运行得更快。

3. 单指令、 多数据并行

在最低层次上, 许多现代处理器拥有特殊的硬件, 允许一条指令产生多个可以并行执行的操作, 这种方式称为单指令、 多数据, 即SIMD并行。 例如, 较新几代的 Intel 和AMD处理器都具有并行地对8对单精度浮点数CC数据类型float)做加法的指令。

提供这些SIMD指令多是为了提高处理影像、 声音和视频数据应用的执行速度。 虽然 有些编译器会试图从C程序中自动抽取SIMD并行性, 但是更可靠的方法是用编译器支持的特殊的向量数据类型来写程序, 比如GCC就支持向量数据类型。 作为对第5章中比较通用的程序优化描述的补充, 我们在网络旁注OPT:SIMD中描述了这种编程方式。

1. 9. 3 计算机系统中抽象的重要性

抽象的使用是计算机科学中最为重要的概念之一。例如, 为一组函数规定一个简单的应用程序接口(API)就是 个很好的编程习惯, 程序员无须了解它内部的工作便可以使用这些代码。 不同的编程语言提供不同形式和等级的抽象支持, 例如 Java 类的声明和 C 语言的函数原型。

.我们已经介绍了计算机系统中使用的几个抽象, 如图 1-18 所示。 在处理器里, 指令集架构提供了对实际处理器硬件的抽象。 使用这个抽象, 机器代码程序表现得就好像运行在一 次只执行一条指令的处理器上。 底层的硬件远比抽象描述的要复杂精细, 它并行地执行多条指令, 但又总是与那个简单有序的模型保持一致。 只要执行模型一样, 不同的处理器实现也能执行同样的机器代码, 而又提供不同的开销和性能。

在学习操作系统时, 我们介绍了三个抽象: 文件是对I/0设备的抽象, 虚拟内存是对 程序存储器的抽象, 而进程是对一个正在运行的程序的抽象。 我们再增加一个新的抽象:虚拟机, 它提供对整个计算机的抽象, 包括操作系统、 处理器和程序。 虚拟机的思想是IBM 在 20 世纪 60 年代提出来的, 但是最近才显示出其管理计算机方式上的优势, 因为一些计算机必须能够运行为不同的操作系统(例如, Microsoft Windows、 MacOS和Linux) 或同一操作系统的不同版本设计的程序。

在本书后续的章节中, 我们会具体介绍这些抽象。

1.10 小结

计算机系统是由硬件和系统软件组成的, 它们共同协作以运行应用程序。计算机内部的信息被表示 为一组组的位, 它们依据上下文有不同的解释方式。程序被其他程序翻译成不同的形式, 开始时是 ASCII文本, 然后被编译器和链接器翻译成二进制可执行文件。

处理器读取并解释存放在主存里的二进制指令。因为计算机花费了大量的时间在内存、I/0 设备和 CPU寄存器之间复制数据 , 所以将系统中的存储设备划分成层次结构 CPU寄存器在顶部, 接着是多层的硬件高速缓存存储器、DRAM主存和磁盘存储器。在层次模型中, 位于更高层的存储设备比低层的 存储设备要更快, 单位比特造价也更高。层次结构中较高层次的存储设备可以作为较低层次设备的高速缓存。通过理解和运用这 种存储层次结构的知识, 程序员可以优化C程序的性能。

操作系统内核是应用程序和硬件之间的媒介。它提供三个基本的抽象: 1)文件是对 I/0 设备的抽象;2) 虚拟内存是对主存和磁盘的抽象; 3)进程是处理器、 主存和 I/0 设备的抽象。

最后, 网络提供了计算机系统之间通信的手段。从特殊系统的角度来看 , 网络就是一种 I/0 设备。

参考文献说明

Ri tchie写了关于早期C和Unix 的有趣的第一手资料[91, 92]。Ritchie和Thompson提供了最早出 版的Unix资料[93]。Si lberschatz、Galvin和 Gagne[l02]提供了关于Unix不同版本的详尽历史 。GNU (www. gnu. org)和Linux(www.linux.org)的网站上有大弑的当前信息和历史资料。Posix标准可以在线获得(www.unix.org)。

练习题答案

1.1 该问题说明Amdahl定律不仅仅适用千计算机系统。

A. 根据公式1.1, 有a= 0.6, k =l.5。更直接地说, 在蒙大拿行驶的1500公里需要10个小时, 而其他行程也需要10个小时。则加速比为25/00+10)1.25X。

B. 根据公式1.1, 有a= O.6, 要求S=l. 67, 则可算出k。更直接地说, 要使行程加速度达到1.67 X, 我们必须把全程时间减少到15个小时。蒙大拿以外仍要求为10小时, 因此, 通过蒙大拿的时间就为5个小时。这就要求行驶速度为300公里/小时,对卡车来说这个 速度太快了!

1.2 理解 Amdahl定律最好的方法就是 解决一些实例。本题要求你从特殊的角度来看公式1.1。

本题是公式的简单应用。已知5=2, a= O. 8, 则计算k:

0.4+1.6/k=1.0

k=2.67