今天学习了李宏毅老师的深度强化学习课程—策略梯度和近端策略优化,其中近端策略优化是策略梯度的升级版本,并且是openai的默认强化学习算法,可见其重要性。近端策略优化可以在策略梯度的基础上,将在策略变为离策略变,并添加一定的约束得到,因此本部分内容包括策略梯度、在策略变离策略和添加约束三部分内容。

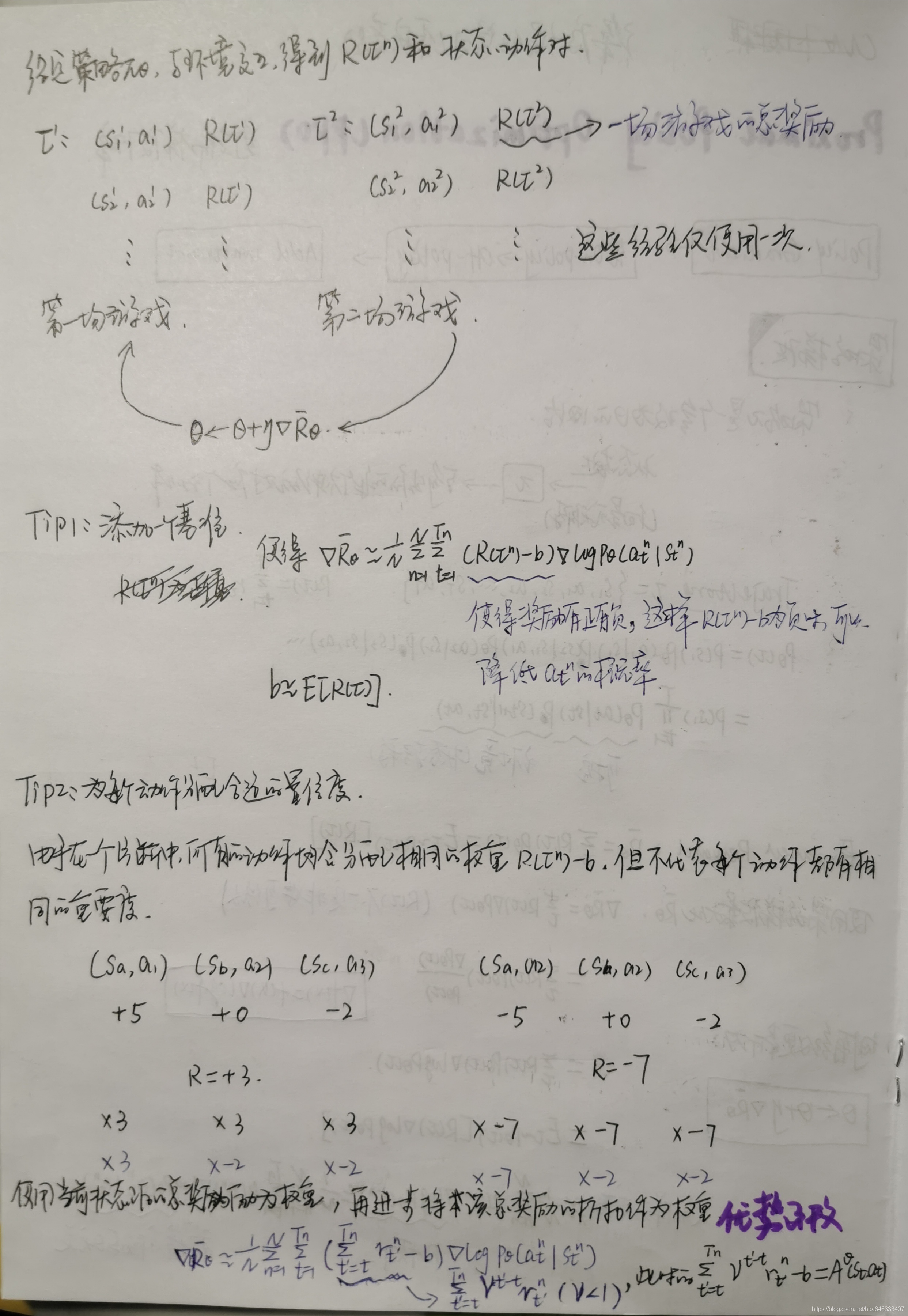

策略梯度方法是对策略参数化,然后通过梯度下降的方法对参数进行优化,从最大化期望累积奖励出发,推导得到参数的更新公式,针对公式中存在的不足,给出了两种改进方式:添加基准和为每个动作分配合适置信度,并定义了优势函数。

在策略变离策略

在策略:待学习的代理与和环境交互的代理是相同的。

离策略:两者是不同的。

在策略方式下,当策略参数得以更新时,需要重新采样训练数据,而将在策略变为离策略的好处在于,可以使用另一个策略的样本训练当前策略,而那个策略是固定的,因而可以重用这些样本数据。这里用到了重要度采样的概念,但重要度采样也可能存在问题,需要保证两个策略之间不能差别太大。最后给出了离策略下的目标函数。

为了满足上述的要求,需要在目标函数中额外添加约束,根据添加的约束方式不同,可以有两种算法:PPO(Proximal Policy Optimization)和TPRO(Trust Region Policy Optimization)。