一、模式概述

Local模式就是运行在一台计算机上的模式,通常就是用于在本机上练手和测试。它可以通过以下几种方式设置Master。

(1)local:所有计算都运行在一个线程当中,没有任何并行计算,通常我们在本机执行一些测试代码,或者练手,就用这种模式;

(2)local[K]:指定使用几个线程来运行计算,比如local[4]就是运行4个Worker线程。通常我们的Cpu有几个Core,就指定几个线程,最大化利用Cpu的计算能力;

(3)local[*]:这种模式直接帮你按照Cpu最多Cores来设置线程数了。

二、安装使用

(1)上传并解压 spark 安装包

[atguigu@hadoop102 sorfware]$ tar -zxvf spark-2.1.1-binhadoop2.7.tgz -C /opt/module/

[atguigu@hadoop102 module]$ mv spark-2.1.1-bin-hadoop2.7 spark(2)官方求 PI 案例

[atguigu@hadoop102 spark]$ bin/spark-submit \

--class org.apache.spark.examples.SparkPi \

--executor-memory 1G \

--total-executor-cores 2 \

./examples/jars/spark-examples_2.11-2.1.1.jar \

100基本语法:

bin/spark-submit \

--class <main-class>

--master <master-url>\

--deploy-mode <deploy-mode>\

--conf <key>=<value> \

... # other options

<application-jar>\

[application-arguments]参数说明:

–master 指定 Master 的地址,默认为 Local

–class: 你的应用的启动类 (如 org.apache.spark.examples.SparkPi)

–deploy-mode: 是否发布你的驱动到 worker 节点(cluster) 或者作为一个本地客户端(client) (default: client)*

–conf: 任意的 Spark 配置属性, 格式 key=value. 如果值包含空格,可以加引号“key=value”

application-jar: 打包好的应用 jar,包含依赖. 这个 URL 在集群中全局可见。 比如hdfs:// 共享存储系统, 如果是 file:// path, 那么所有的节点的 path 都包含同样的 jar

application-arguments: 传给 main()方法的参数

–executor-memory 1G 指定每个 executor 可用内存为 1G

–total-executor-cores 2 指定每个 executor 使用的 cup 核数为 2 个

(3)结果展示

该算法是利用蒙特·卡罗算法求 PI

(4)准备文件

[atguigu@hadoop102 spark]$ mkdir input在 input 下创建 3 个文件 1.txt 和 2.txt,并输入以下内容

hello atguigu

hello spark(5)启动 spark-shell

[atguigu@hadoop102 spark]$ bin/spark-shell

Using Spark's default log4j profile: org/apache/spark/log4jdefaults.properties

Setting default log level to "WARN".

To adjust logging level use sc.setLogLevel(newLevel). For SparkR,

use setLogLevel(newLevel).

18/09/29 08:50:52 WARN NativeCodeLoader: Unable to load nativehadoop library for your platform... using builtin-java classes

where applicable

18/09/29 08:50:58 WARN ObjectStore: Failed to get database

global_temp, returning NoSuchObjectException

Spark context Web UI available at http://192.168.9.102:4040

Spark context available as 'sc' (master = local[*], app id = local1538182253312).

Spark session available as 'spark'.

Welcome to

____ __

/ __/__ ___ _____/ /__

_\ \/ _ \/ _ `/ __/ '_/

/___/ .__/\_,_/_/ /_/\_\ version 2.1.1

/_/

Using Scala version 2.11.8 (Java HotSpot(TM) 64-Bit Server VM, Java

1.8.0_144)

Type in expressions to have them evaluated.

Type :help for more information.

scala>开启另一个 CRD 窗口

[atguigu@hadoop102 spark]$ jps

3627 SparkSubmit

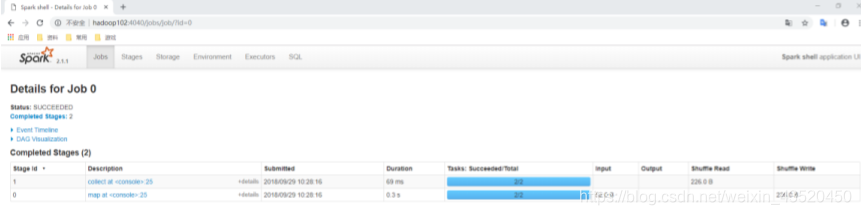

4047 Jps可以登录 hadoop102:4040 查看程序运行

(6)运行 WordCount 程序

scala>sc.textFile("input").flatMap(_.split("

")).map((_,1)).reduceByKey(_+_).collect

res0: Array[(String, Int)] = Array((hadoop,6), (oozie,3), (spark,3),

(hive,3), (atguigu,3), (hbase,6))

scala>可以登录 hadoop102:4040 查看程序运行

三、提交流程

其中的重要角色:

(1)Driver(驱动器)

Spark 的驱动器是执行开发程序中的 main 方法的进程。它负责开发人员编写的用来创建 SparkContext、创建 RDD,以及进行 RDD 的转化操作和行动操作代码的执行。如果你是用 spark shell,那么当你启动 Spark shell 的时候,系统后台自启了一个 Spark 驱动器程序,就是在 Spark shell 中预加载的一个叫作 sc 的 SparkContext 对象。如果驱动器程序终止,那么 Spark 应用也就结束了。主要负责:

1)把用户程序转为任务

2)跟踪 Executor 的运行状况

3)为执行器节点调度任务

4)UI 展示应用运行状况

(2)Executor(执行器)

Spark Executor 是一个工作进程,负责在 Spark 作业中运行任务,任务间相互独立。Spark 应用启动时,Executor 节点被同时启动,并且始终伴随着整个 Spark 应用的生命周期而存在。如果有 Executor 节点发生了故障或崩溃,Spark 应用也可以继续执行,会将出错节点上的任务调度到其他 Executor 节点上继续运行。主要负责:

1)负责运行组成 Spark 应用的任务,并将结果返回给驱动器进程;

2)通过自身的块管理器(Block Manager)为用户程序中要求缓存的 RDD 提供内存式存储。RDD 是直接缓存在 Executor进程内的,因此任务可以在运行时充分利用缓存数据加速运算。

四、数据流程

textFile("input"):读取本地文件 input 文件夹数据;

flatMap(_.split(" ")):压平操作,按照空格分割符将一行数据映射成一个个单词;

map((_,1)):对每一个元素操作,将单词映射为元组;

reduceByKey(_+_):按照 key 将值进行聚合,相加;

collect:将数据收集到 Driver 端展示。

WordCount案例分析: